Accélérateurs de solutions pour l'industrie manufacturière

Publié: 21 septembre 2023

par Will Block, Ramdas Murali, Nicole Lu et Bala Amavasai

Depuis la publication de l'article fondateur sur les transformeurs par Vaswani et. al. de Google, les grands modèles linguistiques (LLM) dominent le domaine de l'IA générative. Sans aucun doute, l'avènement de ChatGPT d'OpenAI a apporté une publicité indispensable et a suscité un regain d'intérêt pour l'utilisation des LLM, tant pour un usage personnel que pour répondre aux besoins des entreprises. Ces derniers mois, Google a lancé Bard et Meta ses modèles Llama 2, démontrant ainsi la concurrence intense que se livrent les grandes entreprises de Technologie.

Les Secteurs d'activité de la fabrication et de l'énergie sont mis au défi d'accroître leur productivité tout en faisant face à l'augmentation des coûts opérationnels. Les entreprises axées sur les données investissent dans l'IA et, plus récemment, dans les LLM. En substance, les entreprises axées sur les données tirent une valeur considérable de ces investissements.

Databricks croit en la démocratisation des technologies d'IA. Nous sommes convaincus que chaque entreprise devrait avoir la possibilité d'entraîner ses propres LLM et d'être propriétaire de ses données et de ses modèles. Dans les secteurs d'activité de la fabrication et de l'énergie, de nombreux processus sont propriétaires et ils sont essentiels pour conserver une longueur d'avance ou améliorer les marges d'exploitation face à une forte concurrence. Les recettes secrètes sont protégées en étant conservées comme des secrets commerciaux, plutôt que d'être rendues publiques par le biais de brevets ou de publications. De nombreux LLM accessibles au public ne respectent pas cette exigence fondamentale, qui requiert l'abandon des connaissances.

En termes de cas d'utilisation, la question qui se pose souvent dans ce secteur d'activité est de savoir comment augmenter les effectifs actuels sans les inonder d'applications et de données supplémentaires. C'est là que réside le défi de développer et de fournir davantage d'applications basées sur l'IA aux collaborateurs. Cependant, avec l'essor de l'IA générative et des LLM, nous pensons que ces applications basées sur les LLM peuvent réduire la dépendance vis-à-vis de multiples applications et consolider les capacités d'augmentation des connaissances dans un nombre plus restreint d'applications.

L'intelligence des données remodèle les Secteurs d'activité

Plusieurs cas d'usage dans les secteurs d'activité pourraient bénéficier des LLM. Ceux-ci incluent, sans s'y limiter :

- Augmentation des agents du support client. Les agents du support client veulent pouvoir query les problèmes ouverts/non résolus pour le client concerné et fournir un script guidé par l'IA pour l'assister.

- Capturer et diffuser les connaissances du domaine grâce à une formation interactive. Le secteur d'activité est dominé par un savoir-faire approfondi, souvent décrit comme une connaissance "tribale". Le vieillissement de la main-d'œuvre s'accompagne du défi de capturer durablement ces connaissances du domaine. Les LLM pourraient servir de réservoirs de connaissances qui peuvent ensuite être facilement diffusées pour la formation.

- Améliorer la capacité de diagnostic des ingénieurs de maintenance sur le terrain. Les ingénieurs de maintenance sur le terrain sont souvent confrontés à la difficulté d'accéder à une multitude de documents interconnectés. L'utilisation d'un LLM pour réduire le temps de diagnostic d'un problème augmentera de ce fait l'efficacité.

Dans cet accélérateur de solution, nous nous concentrons sur le point (3) ci-dessus, qui est le cas d'utilisation visant à renforcer les ingénieurs de service sur le terrain avec une base de connaissances sous la forme d'une session de questions-réponses interactive et contextuelle. Le défi auquel sont confrontés les fabricants est de savoir comment construire et incorporer des données issues de documents propriétaires dans les LLM. L'entraînement de LLM à partir de zéro est un exercice très coûteux, qui se chiffre en centaines de milliers, voire en millions de dollars.

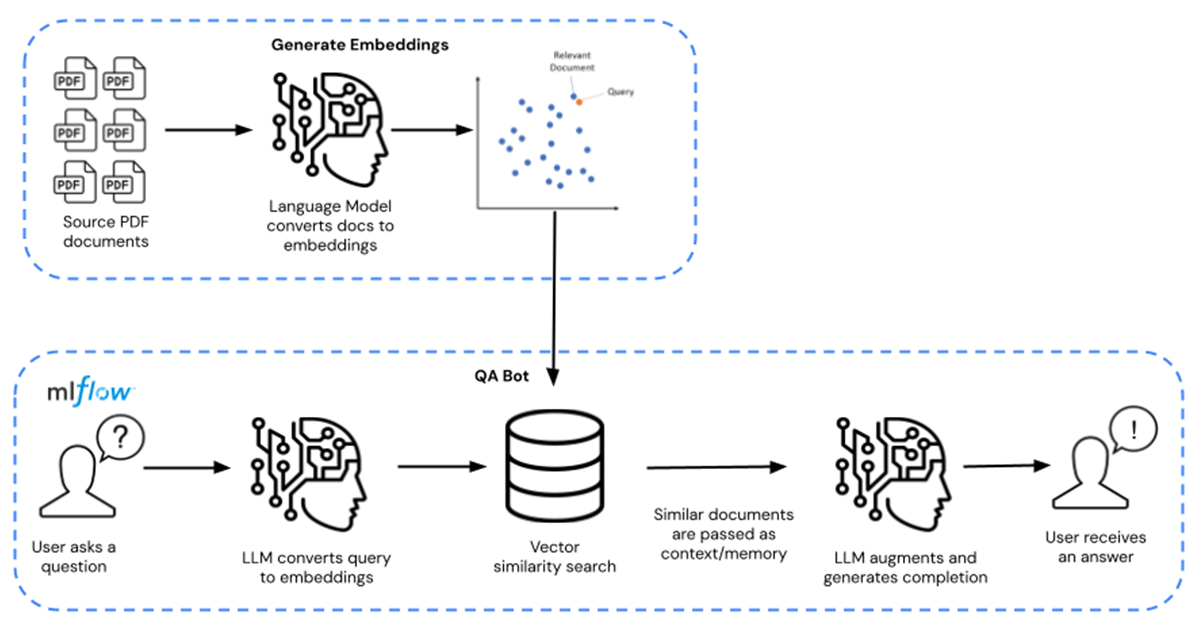

Les entreprises peuvent plutôt exploiter des modèles LLM de base pré-entraînés (comme MPT-7B et MPT-30B de MosaicML) et augmenter et affiner ces modèles avec leurs données propriétaires. Cela ramène les coûts à des dizaines, voire des centaines de dollars, ce qui représente une économie d'un facteur 10 000. Le parcours complet de l'affinement est illustré de gauche à droite, et le parcours des requêtes Q/R est illustré de droite à gauche dans la Figure 1 ci-dessous.

Dans cet accélérateur de solution, le LLM est enrichi à l'aide de fiches techniques de produits chimiques distribuées sous forme de documents PDF accessibles au public. Ceci peut être remplacé par les données propriétaires de votre choix. Les fiches d'information sont transformées en embeddings et utilisées comme retriever pour le modèle. Langchain a ensuite été utilisé pour compiler le modèle, qui est ensuite hébergé sur Databricks MLflow. Le déploiement prend la forme d'un Model Serving Databricks doté d'une capacité d'inférence GPU.

Développez votre entreprise dès aujourd'hui en téléchargeant ces ressources ici. Contactez votre représentant Databricks pour mieux comprendre pourquoi Databricks est la plateforme de choix pour créer et déployer des LLM.

Explorez l'accélérateur de solution ici.

Ne manquez jamais un article Databricks

Et ensuite ?

Produção industrial

30 octobre 2025/9 min de lecture

Como construir Gêmeos Digitais para eficiência operacional

Produção industrial

11 novembre 2025/9 min de lecture