È giunto il momento di rivalutare la storia con Hadoop

Con le aziende costrette ad adattarsi a una forza lavoro remota e distribuita nell'ultimo anno, l'adozione del cloud ha subito un'accelerazione senza precedenti del +14%, con un risultato superiore del 2% (13 miliardi di dollari) rispetto alle previsioni pre-pandemia per il 2020 e con possibili migrazioni da on-premise al cloud per oltre 600 miliardi di dollari nei prossimi anni. Questo passaggio al cloud conferisce un'importanza crescente a una nuova generazione di piattaforme di dati e analitiche per alimentare l'innovazione e realizzare le strategie di trasformazioni digitali aziendali. Tuttavia, molte organizzazioni faticano ancora a gestire la complessità, l'infrastruttura non scalabile e gli oneri di manutenzione elevati dei loro ambienti Hadoop legacy e finiscono per sacrificare il valore dei loro dati e, di conseguenza, rischiano di perdere il loro vantaggio competitivo. Per affrontare questa sfida e sbloccare più opportunità (a volte nascoste) nei loro dati, le organizzazioni si stanno rivolgendo a piattaforme di dati e analitiche basate sul cloud aperte, semplici e collaborative come la Databricks Lakehouse Platform. In questo blog scoprirai le sfide che spingono le organizzazioni a esplorare moderne soluzioni basate sul cloud e il ruolo che l'architettura lakehouse svolge nell'innescare la prossima ondata di innovazione basata sui dati.

Le mancate promesse di Hadoop

Il file system distribuito di Hadoop (HDFS) è stata una tecnologia rivoluzionaria al momento del suo lancio e rimarrà un'icona nella storia dei dati. Grazie al suo avvento, le organizzazioni non sono più state vincolate dai limiti dei database relazionali, e questo ha dato origine al moderno storage di big data e, infine, ai data lake sul cloud. Nonostante tutta la sua gloria e la sua fanfara che ha preceduto il 2015, Hadoop ha faticato a supportare il potenziale in evoluzione di tutti i tipi di dati, soprattutto su scala aziendale. In definitiva, con l'evolversi del panorama dei dati e delle relative esigenze aziendali, Hadoop ha faticato a mantenere le sue promesse. Di conseguenza, le aziende hanno iniziato a esplorare alternative basate sul cloud e il tasso di migrazione da Hadoop al cloud è in costante aumento.

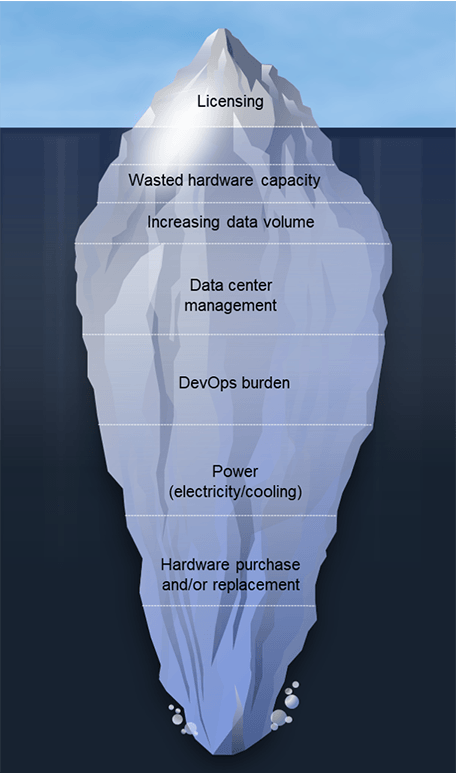

I team migrano da Hadoop per svariati motivi; spesso si tratta di una combinazione di fattori "push" e "pull". Le limitazioni dei sistemi Hadoop esistenti e i costi elevati di licenza e amministrazione stanno spingendo i team a esplorare delle alternative. Sono anche attratti dalle nuove possibilità offerte dalle moderne architetture di dati cloud. Sebbene i requisiti dell'architettura varino a seconda dell'organizzazione, osserviamo diversi fattori comuni che portano i clienti a capire che è ora di start a dire addio. Tra questi:

- Capacità hardware sprecata: la sovracapacità è un dato di fatto nelle implementazioni on-premise, che consente di scalare per soddisfare le esigenze nelle ore di punta, ma il risultato è che gran parte di tale capacità rimane inutilizzata, continuando ad aumentare i costi operativi e di manutenzione.

- I costi di scalabilità aumentano rapidamente: il disaccoppiamento di storage e compute non è possibile in un ambiente Hadoop on-premise, quindi i costi crescono con l'aumentare dei set di dati. A ciò si aggiungano la rapida digitalizzazione derivante dalla pandemia di COVID-19 e il tasso di crescita globale. Una ricerca indica che la quantità totale di dati creati, acquisiti, copiati e consumati nel mondo dovrebbe aumentare del 152,5% dal 2020 al 2024 fino a 149 Zettabyte. In un mondo di iper-crescita dei dati, i costi fuori controllo possono lievitare rapidamente.

- Onere DevOps: in base all'esperienza dei nostri clienti, si possono stimare da 4 a 8 dipendenti a tempo pieno per ogni 100 nodi.

- Aumento dei costi energetici: si prevede di pagare fino a 800 $ per server all'anno in base al consumo e al raffreddamento. Sono 80.000 $ all'anno per un cluster Hadoop da 100 nodi!

- Costi di hardware nuovo e di sostituzione: rappresentano circa il 20% del TCO, che equivale ai costi di amministrazione dei cluster Hadoop.

- Aggiornamenti delle versioni software: Questi aggiornamenti sono spesso obbligatori per garantire il mantenimento del contratto di assistenza, e tali progetti richiedono mesi, offrono poche nuove funzionalità e occupano le preziose risorse dei team di dati.

Oltre a tutta la gamma di sfide sopra menzionate, c'è una reale preoccupazione per la sostenibilità a lungo termine di Hadoop. Nel 2019, il mondo ha assistito a un enorme sfaldamento nell'ambito di Hadoop. Google, il cui articolo fondamentale del 2004 su MapReduce è stato alla base della creazione di Apache Hadoop, ha smesso completamente di utilizzare MapReduce, come twittato da Urs Hölzle, SVP of Technical Infrastructure di Google. Ci sono state anche alcune fusioni e acquisizioni di altissimo profilo nel mondo di Hadoop. Inoltre, nel 2020, un fornitore leader di Hadoop ha riorientato la sua gamma di prodotti non più incentrata su Hadoop, poiché Hadoop è ora considerato "più una filosofia che una tecnologia". Infine, nel 2021, l'Apache Software Foundation ha annunciato il ritiro di dieci progetti dall'ecosistema Hadoop. Questo insieme crescente di problematiche, unito alla necessità sempre più impellente di digitalizzare, ha spinto molte aziende a rivalutare il loro rapporto con Hadoop.

Gartner®: Databricks leader dei database cloud

Il passaggio verso l'architettura lakehouse

Un'architettura lakehouse è l'architettura dei dati ideale per le organizzazioni basate sui dati. Combina le migliori qualità dei data warehouse e dei data lake per fornire un'unica soluzione ad alte prestazioni per tutti i carichi di lavoro di dati. L'architettura Lakehouse supporta una varietà di casi d'uso, come le analitiche dei dati in streaming per la BI, la Data Science e l'IA. Perché i clienti amano la Databricks Lakehouse Platform?

- È semplice. Unifica tutti i dati, le analisi e l'AI su un'unica piattaforma

- È aperto. Unifica il tuo ecosistema di dati con standard e formati aperti.

- È collaborativo. Unifica i team di dati per collaborare lungo tutto il flusso di lavoro di gestione dei dati e AI

Un'architettura lakehouse può offrire vantaggi significativi rispetto agli ambienti Hadoop legacy, che "spingono" le aziende verso l'adozione del cloud. Ciò include anche i clienti che hanno provato a usare Hadoop in cloud ma non ottengono i risultati attesi o desiderati. Come spiega R. Tyler Croy, Director di ingegneria di Scribd, “Databricks ha dichiarato un'ottimizzazione del 30%-50% per la maggior parte dei carichi di lavoro Apache Spark™ tradizionali. Per curiosità, ho rielaborato il mio modello di costi per tenere conto del prezzo di Databricks e delle potenziali ottimizzazioni dei processi Spark. Dopo aver ritoccato i numeri, ho scoperto che con un tasso di ottimizzazione del 17%, Databricks avrebbe ridotto i costi della nostra infrastruttura Amazon Web Services (AWS) a tal punto da ripagare il costo della piattaforma Databricks stessa. Dopo la nostra valutazione iniziale, ero già convinto delle funzionalità e dei miglioramenti della velocità degli sviluppatori che Databricks avrebbe offerto. Quando ho elaborato i numeri nel mio modello, ho capito che non potevo permettermi di non adottare Databricks!”

Scribd non è l'unica; tra gli altri clienti migrati da Hadoop alla Databricks Lakehouse Platform figurano:

- H&M elabora ogni giorno enormi volumi di dati provenienti da oltre 5.000 negozi in oltre 70 mercati con milioni di clienti. La loro architettura basata su Hadoop ha creato problemi nella gestione dei dati. È diventato ad alto consumo di risorse e costoso da scalare, ha presentato problemi di sicurezza dei dati, ha avuto difficoltà a scalare le attività operative per supportare le attività di Data Science da varie sorgenti di dati isolate e ha rallentato il time-to-market a causa di notevoli ritardi di DevOps. Tempistiche di un anno per passare dall'idea alla produzione. Con Databricks, H&M beneficia di una maggiore efficienza operativa riducendo i costi operativi del 70%, migliorando la collaborazione tra i team e aumentando l'impatto sul business con un più rapido time-to-informazioni dettagliate.

- Viacom18 deve elaborare ogni giorno molti terabyte di dati dei telespettatori per ottimizzare la programmazione Il data lake di Hadoop on-premise non era in grado di elaborare 90 giorni di dati continui secondo le condizioni del contratto di servizio (SLA), limitando la capacità di soddisfare le esigenze operative Con Databricks, hanno ridotto notevolmente i costi grazie a tempi di query più rapidi e a un minore impegno DevOps, nonostante l'aumento dei volumi di dati. Produttività del team incrementata del 26% con una piattaforma pienamente gestita che supporta ETL, analisi e ML su larga scala

- Reckitt Benckiser Group (RB) ha faticato a gestire la complessità della previsione della domanda in 500.000 negozi. L'azienda elabora oltre 2TB di dati al giorno su 250 pipeline L'infrastruttura Hadoop legacy si è rivelata complessa, macchinosa, costosa da scalare e con scarse prestazioni. Con Databricks, RB ha ottenuto una capacità 10 volte maggiore per supportare il volume di business, una compressione dei dati del 98% da 80 TB a 2 TB, riducendo i costi operativi, e prestazioni della pipeline di dati 2 volte più veloci per i processi 24x7.

Hadoop non è mai stato progettato per funzionare in ambienti cloud. Sebbene i servizi Hadoop basati su cloud apportino miglioramenti incrementali rispetto alle loro controparti on-premise, entrambi sono ancora meno performanti rispetto all'architettura lakehouse. Entrambe le istanze Hadoop presentano prestazioni ridotte, bassa produttività, costi elevati e l'incapacità di gestire casi di utilizzo dei dati più sofisticati su vasta scala.

Garantire il futuro dei tuoi dati, delle analitiche e della crescita basata sull'IA

Le decisioni di migrazione al cloud sono decisioni aziendali. Costringono le aziende a esaminare attentamente le prestazioni effettive dei loro sistemi attuali e a valutare ciò che è necessario per raggiungere gli obiettivi a breve e a lungo termine. Mentre gli investimenti in IA continuano ad aumentare, i leader dei settori dati, analitiche e tecnologia devono svolgere un ruolo fondamentale pensando oltre l'architettura Hadoop esistente e chiedendosi: "Questo ci porterà dove dobbiamo andare?"

Una volta definiti chiaramente gli obiettivi, emergono dettagli tecnici critici, come la mappatura tecnologica, la valutazione dell'utilizzo delle risorse cloud e del rapporto costo/prestazioni, e la strutturazione di un progetto di migrazione che minimizzi errori e rischi. Ma soprattutto, è necessario avere la convinzione, basata su dati, che è il momento di rivalutare il proprio rapporto con Hadoop. Scopri di più su come la migrazione da Hadoop possa accelerare i risultati di business in tutti i tuoi casi di utilizzo dei dati.

1. Fonte: Gartner Market Databook, Goldman Sachs Global Investment Research

(Questo post sul blog è stato tradotto utilizzando strumenti basati sull'intelligenza artificiale) Post originale

Non perdere mai un post di Databricks

Cosa succederà adesso?

Líder de dados

4 dicembre 2025/3 min di lettura

Construindo a empresa pronta para AI: líderes compartilham soluções e práticas de AI do mundo real

Líder de dados

29 dicembre 2025/4 min di lettura