Best practice di governance dell'IA: come creare programmi di IA responsabili ed efficaci

Summary

- La governance dell'IA aziendale gestisce il rischio, la conformità e la fiducia man mano che i sistemi di IA passano a un uso in produzione ad alto rischio, basando le decisioni su principi come equità, trasparenza, responsabilità, privacy, sicurezza e garanzie integrate.

- I framework di governance efficaci allineano la supervisione al rischio aziendale, definiscono ruoli e policy interfunzionali chiari, integrano checkpoint lungo tutto il ciclo di vita dell'IA e si basano su valutazioni strutturate del rischio, monitoraggio, risposta agli incidenti e documentazione standardizzata.

- I programmi scalabili utilizzano standard centralizzati con esecuzione federata, l'intervento umano (human-in-the-loop) per le decisioni ad alto rischio, il monitoraggio proattivo delle normative in evoluzione e una forte sponsorizzazione da parte dei C-level, in modo che la governance diventi un fattore abilitante per l'innovazione responsabile nell'IA anziché un collo di bottiglia.

Perché la governance dell'IA aziendale è importante ora

L'adozione dell'IA aziendale sta accelerando rapidamente, guidata dai progressi nell'IA generativa. Questi modelli apprendono dai dati, cambiano al variare degli input e progrediscono con le tecniche di addestramento e i set di dati.

Ma anche se i modelli diventano più sofisticati e accurati, i progetti di AI e gli LLM all'avanguardia comportano ancora rischi per l'azienda, specialmente quando vengono distribuiti in produzione. L'impatto è che la governance dell'IA è più importante che mai e le aziende devono disporre di una strategia solida e sfaccettata.

I pilastri chiave della governance includono:

- Controlli di accesso ai dati e autorizzazioni

- Provenienza dei dati e osservabilità completa

- Misure di sicurezza AI integrate per proteggere le PII e bloccare i contenuti non sicuri

- Conformità e requisiti normativi

Quali sono gli obiettivi di un framework di governance dell'IA?

Le best practice di governance dell'IA forniscono un modo strutturato per garantire che i sistemi di IA siano sviluppati, distribuiti e gestiti in modo responsabile. Inoltre, queste pratiche si allineano con gli obiettivi aziendali, gestiscono il rischio durante tutto il ciclo di vita dell'IA e creano un rapporto di fiducia con utenti e stakeholder.

Anche la pressione normativa sull'uso dell'AI è in aumento. I governi e gli organismi di normazione stanno introducendo nuove discussioni su trasparenza, responsabilità e supervisione dei sistemi di IA, fornendo agli utenti una serie di quadri teorici e pratici su cui costruire la propria governance. Ad esempio, i Principi sull'AI dell'OCSE forniscono una base fondata su valori per un quadro di governance dell'AI, mentre la legge sull'AI (AI Act) dell'Unione Europea stabilisce un quadro basato sul rischio con requisiti più stringenti per i casi d'uso di AI ad alto rischio.

Oltre alla conformità, la governance dell'IA ha un valore commerciale diretto. Le organizzazioni con strutture di governance chiare sono in una posizione migliore per:

- Guadagnare la fiducia degli stakeholder nelle decisioni basate sull'AI

- Ridurre il rischio operativo e legale

- Scalare i sistemi di IA in modo più efficiente tra team e casi d'uso

- Dimostrare responsabilità e controllo man mano che i programmi di IA maturano

Sfide comuni che determinano la necessità di una governance

Molte aziende incontrano sfide simili con la crescita dell'adozione dell'AI:

- Proprietà non chiara: la responsabilità per i risultati dell'AI è spesso frammentata tra i team di dati, ingegneria, legali e aziendali. I team possono distribuire i modelli, ma nessun singolo team è responsabile dei risultati.

- Strumenti in rapida evoluzione: le nuove AI e GenAI stanno migliorando rapidamente e la velocità e la rapidità del loro sviluppo implicano che potrebbero non disporre di processi e controlli adeguati.

- Dati e processi frammentati: dati, addestramento, deployment e monitoraggio possono trovarsi in sistemi separati, rendendo difficili la supervisione e una documentazione coerente.

- Verificabilità limitata: dimostrare come un sistema di AI è stato addestrato, valutato e distribuito può richiedere molto tempo o essere impossibile senza artefatti di governance.

Queste sfide sottolineano perché la governance debba essere intenzionale e integrata nei processi principali fin dall'inizio, anziché essere aggiunta in un secondo momento dopo l'insorgere dei problemi.

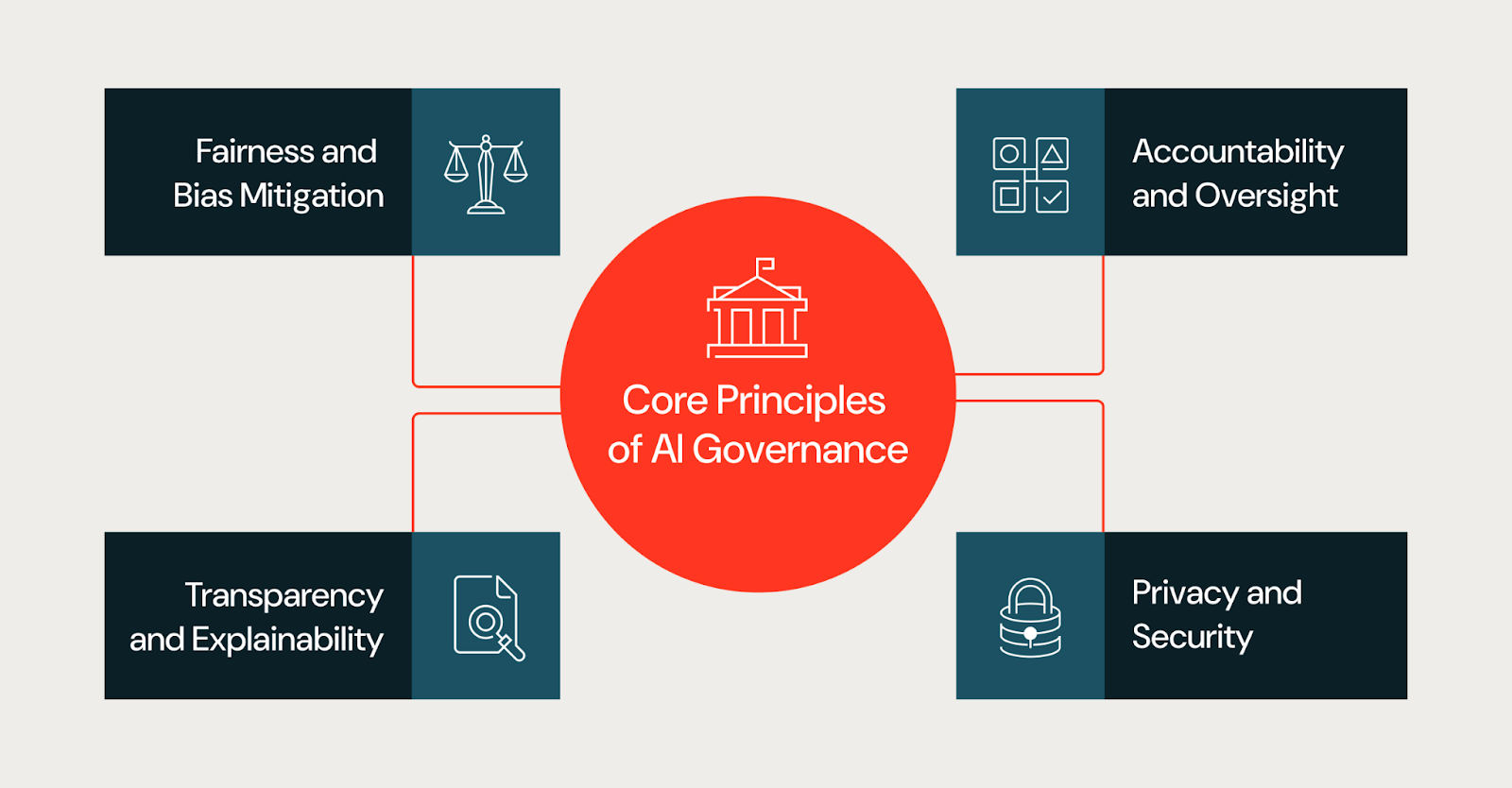

Principi fondamentali alla base di una governance efficace dell'IA

La governance si applica ai sistemi di IA nel loro complesso, compresi dati, prompt, flussi di lavoro, punti decisionali umani e applicazioni downstream, e non solo ai singoli modelli. Molti rischi aziendali emergono da come interagiscono questi componenti, piuttosto che dal modello stesso. Le best practice di governance dell'IA si basano su un insieme coerente di principi fondamentali. Questi principi guidano le decisioni durante tutto il ciclo di vita dell'IA e forniscono un framework condiviso per i team con responsabilità diverse.

Equità e mitigazione dei bias

Il bias può essere introdotto attraverso i dati di addestramento, la selezione delle feature o il contesto di deployment e portare a risultati diversi tra le popolazioni. I programmi di governance dovrebbero richiedere ai team di valutare tempestivamente i rischi per l'equità, documentare le limitazioni note e monitorare la presenza di bias non intenzionali man mano che i modelli si evolvono in produzione.

In pratica, i team valutano l'equità esaminando i dati di addestramento per individuare lacune di rappresentazione, testando gli output del modello su diversi gruppi demografici e definendo metriche di equità prima della distribuzione. Gli approcci comuni includono la valutazione disaggregata, gli audit dei bias durante lo sviluppo e il monitoraggio continuo del drift in produzione. I team dovrebbero anche documentare le limitazioni note e i casi limite in cui il modello potrebbe avere prestazioni inferiori.

Trasparenza e spiegabilità

La trasparenza aiuta gli stakeholder a capire come vengono creati i sistemi di AI e come influenzano i risultati. Questo non significa richiedere la piena visibilità sull'architettura del modello proprietario o sui dati di addestramento di un fornitore, poiché i fornitori di modelli chiusi in genere non divulgano tali dettagli. La trasparenza, invece, si concentra su ciò che un'organizzazione può controllare e documentare.

Ciò include chiarezza su quali modelli e versioni un team potrebbe utilizzare, quali dati sta passando loro, come li sta sottoponendo a prompting o a fine-tuning e quali criteri di valutazione un team potrebbe applicare prima della distribuzione. I team dovrebbero anche documentare la logica decisionale a livello di applicazione per spiegare come gli output del modello vengono utilizzati, filtrati o sovrascritti nei flussi di lavoro downstream. Per gli stakeholder che necessitano di spiegazioni, come autorità di regolamentazione, dirigenti o utenti interessati, l'obiettivo è fornire un contesto appropriato su come il sistema raggiunge i suoi output, anche quando il modello sottostante è una black box.

Responsabilità e supervisione

Una governance efficace definisce una proprietà chiara per i sistemi di IA. Ogni modello o applicazione di IA dovrebbe avere persone o team responsabili dei risultati, della gestione del rischio e della conformità alle policy interne. I meccanismi di supervisione garantiscono che la responsabilità persista dopo la distribuzione, invece di scomparire una volta distribuito il modello.

Privacy e sicurezza

I sistemi di IA spesso elaborano dati sensibili o regolamentati e la governance deve garantire che le protezioni della privacy e i controlli di sicurezza vengano applicati in modo coerente, inclusi la gestione degli accessi basata sui ruoli, i filtri PII e il filtraggio dei risultati non sicuri. Le considerazioni sulla privacy e la sicurezza dovrebbero essere integrate durante l'intero ciclo di vita dell'IA, non affrontate solo al momento della distribuzione.

Sicurezza integrata

I sistemi di IA necessitano di guardrail che impediscano output dannosi o non intenzionali. Le misure di sicurezza integrate includono la convalida degli input per intercettare query malformate o avversarie, filtri di output che bloccano contenuti non sicuri o inappropriati, il rilevamento di PII per prevenire l'esposizione dei dati e la moderazione dei contenuti per le applicazioni rivolte agli utenti. Questi controlli dovrebbero essere configurabili per livello di rischio; uno strumento interno a basso rischio potrebbe richiedere misure di sicurezza più leggere rispetto a un agente rivolto ai clienti.

Accesso unificato per modelli e progetti di AI

Man mano che le organizzazioni scalano l'adozione dell'AI, l'accesso ai modelli e ai progetti di AI dovrebbe essere governato tramite un framework centralizzato. I controlli di accesso unificati garantiscono autorizzazioni coerenti negli ambienti di sviluppo, staging e produzione. Ciò include l'accesso basato sui ruoli per stabilire chi può visualizzare, modificare o implementare i modelli, audit trail che tracciano le modifiche e l'utilizzo e l'integrazione con i sistemi di gestione delle identità. L'accesso centralizzato riduce il rischio di progetti di AI ombra e rende più facile dimostrare la conformità. Senza controlli di accesso unificati, le organizzazioni si trovano spesso a dover gestire la cosiddetta "IA ombra" (modelli e applicazioni implementati senza una supervisione formale), che diventa uno dei maggiori ostacoli a una governance coerente su Scale.

Costruire un framework pratico di governance dell'AI

Mentre i principi di governance possono definire l'aspetto di una buona governance, i framework definiscono come tali organizzazioni implementano i loro processi. In altre parole, un framework pratico di governance dell'IA traduce obiettivi di alto livello in ruoli, policy e controlli specifici che si adattano alla struttura complessiva e alla tolleranza al rischio di un'organizzazione.

Consulta il Databricks AI Governance Framework per un esempio di approccio strutturato alla definizione dei pilastri della governance e delle considerazioni chiave.

Allineare la governance con gli obiettivi aziendali

Le organizzazioni ottengono risultati migliori quando la governance si allinea con l'impatto e il rischio aziendale. Non tutti i sistemi di AI necessitano dello stesso livello di supervisione. Un chatbot che riassume documenti esterni comporta un rischio diverso rispetto a un modello che approva prestiti o dà priorità ai casi medici.

Stabilire ruoli e strutture di governance

Affinché la governance dell'IA sia massimamente efficace, deve essere interfunzionale. Ciò comporta una collaborazione continua e intenzionale tra i team di dati e AI, i team legali e di conformità, i team di privacy e sicurezza e gli stakeholder aziendali. Le strutture comuni includono:

- Comitati di governance interfunzionali

- Modelli RACI chiaramente definiti

- Requisiti con intervento umano per le decisioni ad alto rischio

- Controllo degli accessi per ruoli

Queste strutture chiariscono i diritti decisionali e riducono l'ambiguità man mano che i programmi di AI scalano.

Definire policy, standard e controlli per l'AI

Standard chiari riducono gli attriti. I framework di governance efficaci specificano:

- Documentazione e artefatti richiesti

- Criteri di classificazione del rischio dell'AI

- Soglie di approvazione per livello di rischio

- Monitoraggio, risposta agli incidenti e aspettative di audit

Quando gli standard rimangono vaghi, i team inventano interpretazioni locali. Quando gli standard sono concreti, i team agiscono più velocemente e con meno imprevisti.

Rendere operativa la governance dell'AI

La governance dell'IA deve essere integrata nella struttura stessa del flusso di lavoro, ad esempio nel modo in cui i team progettano, distribuiscono e gestiscono i sistemi di IA. Tuttavia, non deve essere solo una teoria; la governance operativa deve rispondere a domande pratiche, come chi prende le decisioni, quali prove devono produrre i team e come i sistemi rimangono conformi nel tempo. Il risultato è un processo esplicito che i team possono seguire per integrare la governance dell'IA nei loro flussi di lavoro.

Integrare la governance nel ciclo di vita dello sviluppo dell'AI

La maggior parte delle organizzazioni non costruisce modelli di base da zero. Combina modelli esistenti con dati proprietari per creare progetti, agenti e applicazioni di AI. La governance dovrebbe rispecchiare questa realtà integrando i checkpoint direttamente nel ciclo di vita dello sviluppo. Ad esempio, un assistente IA interno che riassume documenti esterni può essere inizialmente classificato come a basso rischio. Se lo stesso sistema viene successivamente esposto ai clienti o utilizzato per prendere decisioni regolamentate, il suo profilo di rischio cambia, richiedendo nuove approvazioni, tutele e monitoraggio.

- Definire l'ambito e l'intento. Prima di iniziare lo sviluppo, documentare l'uso previsto del sistema, gli usi vietati e il contesto decisionale. Ciò previene lo scope creep, per cui i sistemi vengono riutilizzati in scenari a più alto rischio senza essere sottoposti a revisione.

- Documentare le sorgenti di dati. Registrare la proprietà dei dati, i vincoli di consenso e le limitazioni note. Se i team non sanno spiegare da dove provengono i dati e perché sono appropriati, non dovrebbero usarli per creare o perfezionare un sistema.

- Stabilire i criteri di valutazione. Concordare metriche, soglie e compromessi accettabili prima di eseguire i test. I team dovrebbero documentare perché hanno scelto metriche specifiche e quali modalità di fallimento hanno osservato. Questo trasforma la valutazione in una registrazione delle decisioni per riferimenti futuri.

- Imponi i gate di rilascio. Richiedere responsabili designati, documentazione completa e approvazione in linea con il livello di rischio del sistema. Definire i criteri di rollback in modo che i team sappiano quando ritirare un sistema dalla produzione.

- Monitoraggio e revisione. Dopo la distribuzione, esaminare il comportamento in produzione, convalidando le ipotesi rispetto all'utilizzo reale e documentando le modifiche nel tempo.

Condurre valutazioni del rischio dell'AI

La valutazione del rischio è il cuore della governance pratica. Determina quanto controllo è necessario per un sistema e dove i team dovrebbero concentrare l'attenzione. Quando i team implementano valutazioni efficaci, dovrebbero concentrarsi su un piccolo insieme di domande:

- Su chi ha un impatto questo sistema?

- Quali decisioni influenza o automatizza?

- Cosa succede quando fallisce?

- Con quale facilità possono intervenire gli esseri umani?

- Quale sensibilità dei dati comporta?

Una volta che i team hanno raccolto le risposte a queste domande, possono assegnare un livello di rischio, che è un modo per tradurre la valutazione in azione. Ad esempio, uno strumento interno a basso rischio può richiedere una documentazione snella e una revisione periodica, mentre un sistema ad alto rischio può richiedere una supervisione umana frequente, un'approvazione formale e un monitoraggio continuo.

Le valutazioni del rischio dovrebbero avvenire in una fase iniziale ed essere soggette ad aggiornamenti continui nel tempo. Man mano che i sistemi si espandono a nuovi utenti o casi d'uso, il loro profilo di rischio spesso cambia. I processi di governance dovrebbero essere progettati per tenere conto di tale evoluzione.

Definire i percorsi di approvazione e di escalation

La governance operativa dipende da percorsi decisionali chiari. I team devono sapere chi può approvare un sistema, quando è necessaria un'escalation e come risolvere i disaccordi. Di conseguenza, le organizzazioni definiscono in genere i seguenti percorsi decisionali:

- autorità di approvazione per livello di rischio

- Trigger di escalation per problemi irrisolti

- Tempistiche per la revisione e la risposta

- criteri per l'arresto o il rollback dei sistemi

Senza percorsi definiti, la governance può creare confusione e i team possono subire una paralisi se le decisioni si bloccano, la responsabilità si diffonde e i controlli vengono aggirati per poter andare avanti. Stabilire percorsi chiari riduce l'ambiguit�à e aumenta la conformità, perché i team capiscono come procedere.

Implementare controlli di monitoraggio e conformità

Dato lo sviluppo rapido e continuo dei sistemi di AI, la governance dell'AI non può essere statica. Nel tempo, i dati cambiano, i modelli di utilizzo si modificano e le prestazioni si degradano. È fondamentale che i team monitorino il comportamento dell'IA in produzione concentrandosi su:

- prestazioni rispetto a metriche definite

- data drift e cambiamenti nella distribuzione

- input o output inattesi

- utilizzo del sistema al di fuori dell'ambito previsto

La governance definisce cosa devono monitorare i team, con quale frequenza esaminano i risultati e quali azioni intraprendono quando le soglie vengono superate. Queste azioni possono includere il riaddestramento, la limitazione dell'uso, l'escalation agli organi di revisione o l'arresto dei sistemi. Trasformando il monitoraggio in un ciclo di feedback, le organizzazioni possono garantire di massimizzare i vantaggi dei loro processi interni.

Stabilire processi di risposta agli incidenti e di correzione

Oltre a creare una cultura del feedback e della responsabilità, i framework di governance solidi devono tenere conto dei fallimenti. Anche i sistemi ben progettati si guastano o si degradano nel tempo.

Un altro passaggio nella governance consiste nel definire come un team risponde agli incidenti di IA, inclusi risultati distorti, comportamenti non sicuri, esposizione di dati o problemi normativi. I team necessitano di playbook predefiniti che specifichino:

- Come identificare e classificare gli incidenti

- Chi è responsabile della risposta e della comunicazione

- Come contenere i danni

- Come documentare le cause principali e la risoluzione

Le revisioni post-incidente possono aiutare a reintrodurre nuovi apprendimenti o aggiornamenti nella governance consolidata, contribuendo ad aggiornare le valutazioni dei rischi, a migliorare i controlli e a perfezionare le policy. Questo ciclo garantisce che la governance si evolva con l'esperienza del mondo reale.

Standardizzare gli artefatti di governance

Man mano che i team sviluppano la propria governance, la documentazione standardizzata è importante per le prove e la coerenza all'interno del sistema. Una documentazione coerente può anche essere d'aiuto per gli audit e ridurre la necessità di sforzi duplicati nella riproduzione dei documenti. Le organizzazioni danno priorità ai seguenti documenti standardizzati:

- Riepiloghi di sistema che definiscono lo scopo e l'ambito

- Documentazione dei dati che registra fonti e vincoli

- Riepiloghi di valutazione che riportano prestazioni e limitazioni

- Piani di monitoraggio che definiscono la supervisione continua

Scalare la governance tra team e domini

Con la continua crescita dell'adozione dell'IA, la governance di un'organizzazione deve scalare senza introdurre colli di bottiglia. Molti team utilizzano un modello centralizzato-federato, in cui un gruppo centrale definisce standard, framework di rischio e policy, mentre i team di dominio li applicano a livello locale e rimangono responsabili dei risultati. Questo modello aiuta a trovare un equilibrio tra coerenza e velocità.

Anche lo scaling richiede addestramento. Man mano che i sistemi di governance si evolvono e si sviluppano, i team devono capire cosa richiede la governance e come conformarsi al meglio ai requisiti.

Gartner®: Databricks leader dei database cloud

Garantire trasparenza, fiducia e spiegabilità

La fiducia è un risultato centrale di una governance dell'IA efficace. Gli stakeholder sono più propensi ad adottare e a fare affidamento sui sistemi di IA quando capiscono come vengono prese le decisioni e come vengono gestiti i rischi durante l'intero ciclo di vita dell'IA.

Supervisione Human-in-the-Loop

Per i casi d'uso ad alto rischio o sensibili, gli esseri umani dovrebbero mantenere l'autorità finale sulle decisioni basate sull'IA. I quadri di governance dovrebbero definire quando è richiesta la revisione umana, come avvengono gli interventi e come vengono documentate le decisioni.

Comunicare le decisioni dell'IA agli stakeholder

Stakeholder diversi richiedono diversi livelli di spiegazione. I team tecnici potrebbero aver bisogno di metriche di valutazione dettagliate, mentre i dirigenti e gli enti regolatori possono basarsi su riepiloghi, schede del modello o razionali decisionali. Una comunicazione chiara crea fiducia e supporta la responsabilità.

Tenere il passo con i cambiamenti normativi e del settore industriale

La governance dell'IA non finisce mai. Leggi e regolamenti si evolvono, gli standard maturano e le capacità dell'IA progrediscono più velocemente dei cicli politici.

Rimanere aggiornati su standard e aggiornamenti

Le organizzazioni si mantengono aggiornate assegnando una chiara responsabilità per il monitoraggio delle modifiche normative e degli standard. I programmi efficaci creano un piccolo gruppo interfunzionale che include professionisti del settore legale, della conformità, della privacy, della sicurezza e dell'IA, invece di affidarsi ad aggiornamenti ad hoc.

Il monitoraggio funziona meglio a una cadenza fissa, ad esempio trimestrale, invece di aggiornamenti reattivi. Per rimanere proattivi, i team dovrebbero valutare ogni modifica chiedendosi:

- Questo riguarda i sistemi di AI esistenti o solo quelli nuovi?

- Introduce nuova documentazione o nuove aspettative di supervisione?

- Si applica a livello globale o solo in regioni specifiche?

Queste verifiche di impatto aiutano i team a utilizzare e perfezionare i processi di governance esistenti invece di creare controlli paralleli.

Preparazione per i futuri requisiti di governance dell'IA

È probabile che i futuri requisiti per la governance dell'IA amplino le aspettative in materia di spiegabilità, verificabilità e documentazione. Le organizzazioni possono preparare i propri processi fin da ora, senza attendere disposizioni dettagliate.

Tracciabilità e spiegabilità: i team dovrebbero definire quali spiegazioni sono necessarie in base al livello di rischio e al pubblico di destinazione, dalle revisioni tecniche ai riepiloghi dirigenti e normativi.

Verificabilità: è importante conservare registri decisionali che mostrino per cosa è stato progettato un sistema, come è stato valutato, chi lo ha approvato e come è cambiato dopo il deployment.

Documentazione: la standardizzazione della documentazione è fondamentale. Assicurarsi che i team di governance documentino i riepiloghi dei sistemi, le valutazioni dei rischi, i registri di valutazione e i piani di monitoraggio, mantenendoli costantemente aggiornati.

Superare gli ostacoli comuni all'adozione della governance dell'AI

Nonostante i suoi vantaggi, la governance dell'IA presenta una serie di sfide proprie all'interno delle organizzazioni. Le barriere comuni includono:

Sostenibilità. Quando gli incentivi organizzativi premiano la distribuzione dei modelli il più rapidamente possibile, i team possono considerare la governance come un ostacolo. I team di dati e IA si concentrano sulla distribuzione rapida dei modelli, mentre i requisiti di governance compaiono in un secondo momento sotto forma di cicli di revisione imprevisti o di lavoro di documentazione.

Proprietà frammentata. Quando la responsabilità per i risultati dell'AI è distribuita tra più team, le responsabilità di governance possono essere poco chiare. Nessun singolo team è responsabile del risultato, quindi nessuno è responsabile dei controlli.

Debito tecnico legacy. Le pipeline e i modelli più vecchi spesso non dispongono di metadati, monitoraggio o documentazione previsti dalla governance. L'adeguamento di questi sistemi richiede uno sforzo che compete con le nuove priorità di sviluppo.

Strategie per aumentare l'adozione

I programmi di governance di successo si concentrano sulla proattività e non sulle riforme reattive. I vertici aziendali devono comunicare in modo coerente l'importanza della governance. Una comunicazione e un addestramento chiari aiutano gli operatori a capire come la governance si inserisce nei flussi di lavoro esistenti, invece di aggiungere processi paralleli. Nel frattempo, le iniziative pilota svolgono un ruolo fondamentale, dimostrando che la governance riduce le rilavorazioni, previene gli incidenti di produzione e accelera le approvazioni una volta che gli standard sono stati implementati. Insieme, queste strategie trasformano la governance da un ostacolo percepito a un fondamento pratico per scalare l'IA in modo responsabile.

Come iniziare a costruire una strategia di governance dell'IA

Una solida governance dell'IA aiuta le organizzazioni a scalare l'adozione dell'IA con fiducia. Attributi come una chiara titolarità (ownership), controlli basati sul rischio e una supervisione continua riducono le sorprese e mantengono i sistemi allineati alle aspettative aziendali e normative.

I team dovrebbero iniziare con una base pratica: inventariare i casi d'uso attuali dell'IA, classificarli in base al rischio e assegnare proprietari responsabili. Sperimentare i controlli di governance su un piccolo set di sistemi ad alto impatto per stabilire standard e perfezionare i processi. Man mano che i team acquisiscono esperienza, possono estendere la governance a ulteriori casi d'uso e domini, rafforzando la supervisione e preservando al contempo la velocità e la flessibilità necessarie per sostenere l'innovazione dell'IA.

(Questo post sul blog è stato tradotto utilizzando strumenti basati sull'intelligenza artificiale) Post originale

Non perdere mai un post di Databricks

Cosa succederà adesso?

IA

7 gennaio 2025/8 min di lettura