Monitoraggio della qualità dei dati su larga scala con IA agentiva

Basato su Unity Catalog per rilevare tempestivamente i problemi e risolverli rapidamente

Summary

• La qualità dei dati manuale e basata su regole non è scalabile con la crescita dei data estate per le analitiche e l'IA.

• Il monitoraggio della qualità dei dati agentivo apprende i modelli di dati previsti e rileva problemi nei set di dati critici.

• I segnali nativi della piattaforma come il lignaggio di Unity Catalog aiutano i team a risolvere i problemi più velocemente su scala aziendale.

La sfida della qualità dei dati su larga scala

Man mano che le organizzazioni creano più prodotti di dati e IA, mantenere la qualità dei dati diventa più difficile. I dati sono alla base di tutto: dalle dashboard per i dirigenti ai bot Q&A a livello aziendale. Una tabella non aggiornata porta a risposte obsolete o addirittura errate, con un impatto diretto sui risultati aziendali.

La maggior parte degli approcci alla qualità dei dati non si adatta a questa realtà. I team dei dati si affidano a regole definite manualmente e applicate a un piccolo set di tabelle. Con la crescita dei data estate, si creano punti ciechi e si limita la visibilità sullo stato di salute generale.

I team aggiungono continuamente nuove tabelle, ognuna con i propri pattern di dati. Mantenere controlli personalizzati per ogni set di dati non è sostenibile. In pratica, solo una manciata di tabelle critiche vengono monitorate, mentre la maggior parte del patrimonio di dati rimane incontrollata.

Il risultato è che le organizzazioni hanno più dati che mai, ma meno fiducia nel poterli utilizzare.

Presentazione del monitoraggio agentivo della qualità dei dati

Oggi Databricks annuncia la Public Preview del monitoraggio della qualità dei dati su AWS, Azure Databricks e GCP.

Il monitoraggio della qualità dei dati sostituisce i controlli manuali e frammentati con un approccio agentivo creato per la scalabilità. Invece di soglie statiche, gli agenti IA apprendono i normali pattern dei dati, si adattano ai cambiamenti e monitorano il patrimonio di dati in modo continuo.

L'integrazione profonda con la Databricks Platform consente più del semplice rilevamento.

- La causa principale viene individuata direttamente nei Lakeflow jobs e nelle pipeline a monte. I team possono passare dal monitoraggio della qualità dei dati al job interessato e sfruttare le funzionalità di osservabilità integrate di Lakeflow per ottenere un contesto più approfondito sugli errori e risolvere i problemi più rapidamente.

- Viene data priorità ai problemi utilizzando la lineage e i tag certificati di Unity Catalog, garantendo che i set di dati ad alto impatto vengano affrontati per primi.

Con il monitoraggio nativo della piattaforma, i team rilevano i problemi prima, si concentrano su ciò che conta di più e risolvono i problemi più velocemente su scala aziendale.

"Il nostro obiettivo è sempre stato che fossero i nostri dati a dirci quando c'è un problema. Il Data Quality monitoraggio di Databricks finalmente lo fa grazie al suo approccio basato sull'IA. È integrato perfettamente nell'interfaccia utente, monitorando tutte le nostre tabelle con un approccio che non richiede interventi manuali né configurazione, cosa che è sempre stata un fattore limitante con altri prodotti. Invece di essere gli utenti a segnalare i problemi, sono i nostri dati a segnalarli per primi, migliorando la qualità, l'affidabilità e l'integrità della nostra piattaforma." — Jake Roussis, Lead Data Engineer presso Alinta Energy

Come funziona il monitoraggio della qualità dei dati

Il monitoraggio della qualità dei dati fornisce informazioni dettagliate attraverso due metodi complementari.

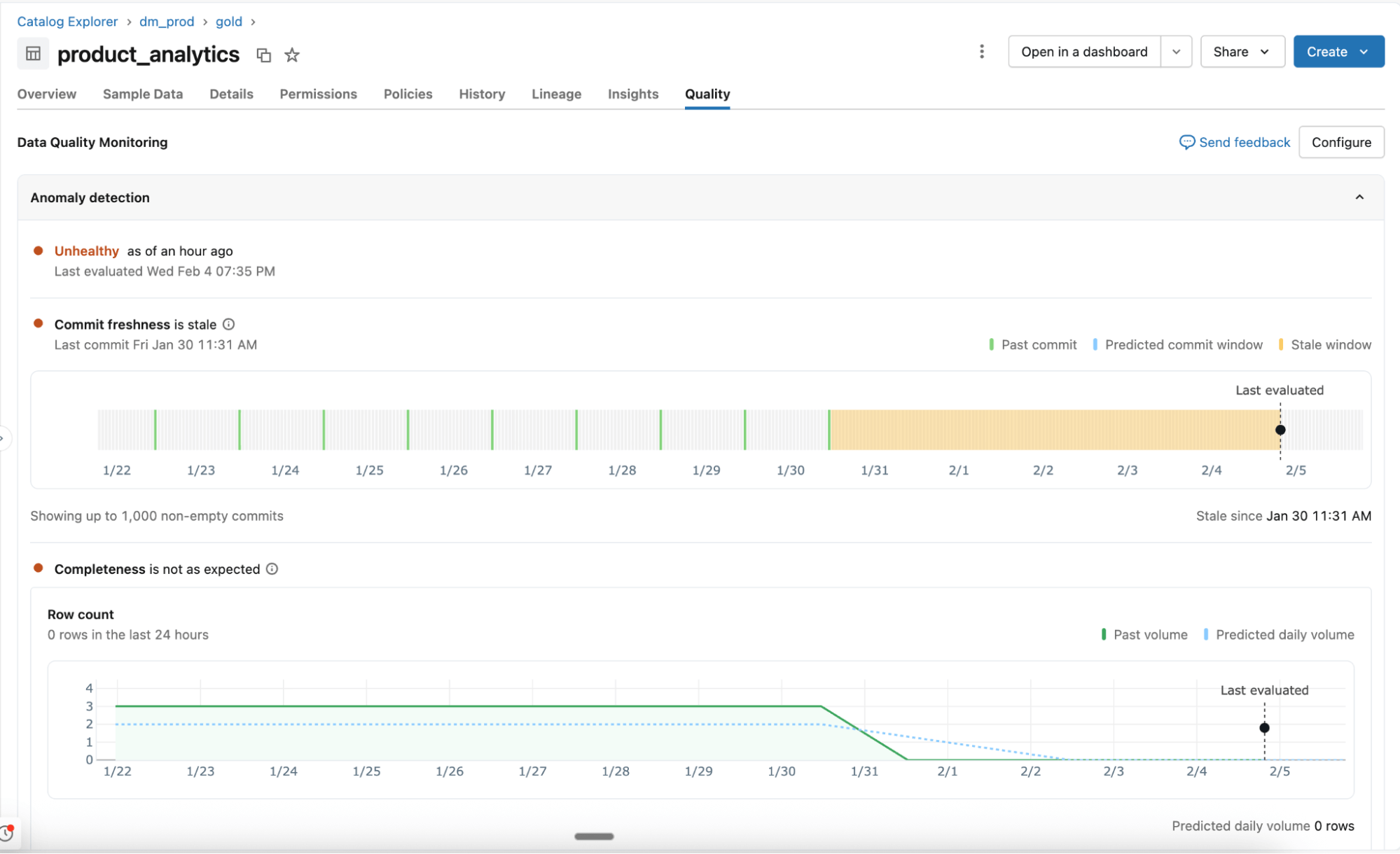

Rilevamento delle anomalie

Abilitato a livello di schema, il rilevamento di anomalie monitora tutte le tabelle critiche senza configurazione manuale. Gli agenti IA apprendono i modelli storici e il comportamento stagionale per identificare cambiamenti imprevisti.

- Comportamento appreso, non regole statiche: Gli agenti si adattano alla normale variazione e monitorano i segnali di qualità chiave come l'attualità e la completezza. A breve sarà disponibile il supporto per controlli aggiuntivi, tra cui la percentuale di valori nulli, l'unicità e la validità.

- Scansione intelligente per la scalabilità: Tutte le tabelle di uno schema vengono scansionate una volta, quindi riesaminate in base all'importanza della tabella e alla frequenza di aggiornamento. La lineage di Unity Catalog e la certificazione determinano quali tabelle sono più importanti. Le tabelle usate di frequente vengono scansionate più spesso, mentre quelle statiche o deprecate vengono saltate automaticamente.

- Tabelle di sistema per visibilità e reporting: Lo stato di integrità delle tabelle, le soglie apprese e i pattern osservati vengono registrati nelle tabelle di sistema. I team utilizzano questi dati per l'invio di avvisi, il reporting e analisi più approfondite.

Profilazione dei dati

Abilitata a livello di tabella, la profilazione dei dati acquisisce statistiche di riepilogo e ne monitora le variazioni nel tempo. Queste metriche forniscono un contesto storico e verranno fornite al rilevamento di anomalie per consentirti di individuare facilmente i problemi.

"In OnePay, la nostra missione è aiutare le persone a raggiungere il progresso finanziario, consentendo loro di risparmiare, spendere, prendere in prestito e far fruttare il proprio denaro. Dati di alta qualità in tutti i nostri set di dati sono fondamentali per portare a termine questa missione. Con il monitoraggio della qualità dei dati, possiamo individuare i problemi in anticipo e agire rapidamente. Siamo in grado di garantire l'accuratezza delle nostre analitiche, del reporting e dello sviluppo di modelli di ML robusti, il che contribuisce a servire meglio i nostri clienti." — Nameet Pai, Head of Platform & Data ingegneria presso OnePay

Gartner®: Databricks leader dei database cloud

Garantire la qualità di un patrimonio di dati in continua crescita

Grazie al monitoraggio automatizzato della qualità, i team della piattaforma dati possono tenere sotto controllo lo stato di salute generale dei dati e garantire la risoluzione tempestiva di eventuali problemi.

Monitoraggio agentivo con un clic: Monitora interi schemi senza la scrittura manuale di regole e la configurazione di soglie. Il monitoraggio della qualità dei dati apprende i pattern storici e i comportamenti stagionali (ad es. cali di volume nei fine settimana, periodo delle imposte, ecc.) per rilevare in modo intelligente le anomalie in tutte le tue tabelle.

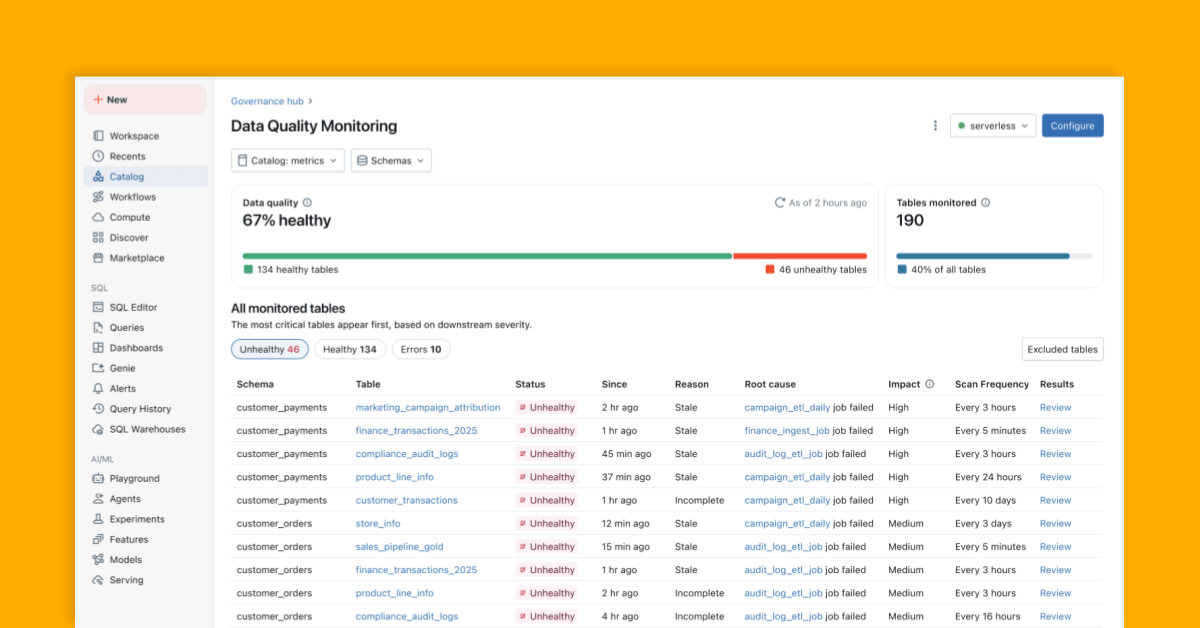

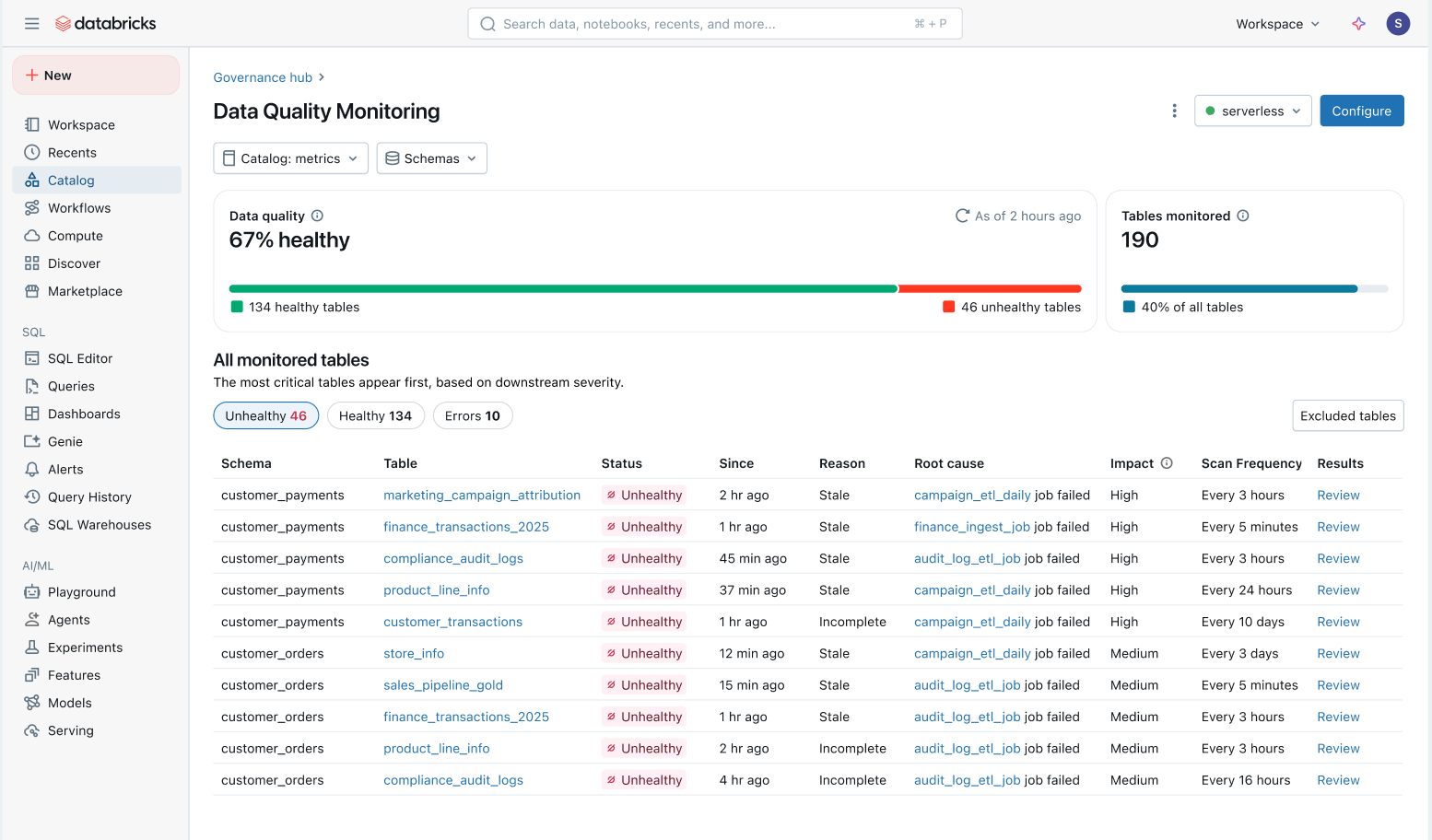

Visione olistica dell'integrità dei dati: Monitora facilmente l'integrità di tutte le tabelle in una vista consolidata e assicurati che i problemi vengano risolti.

- Problemi con priorità in base all'impatto a valle: a tutte le tabelle viene assegnata una priorità in base alla derivazione a valle e al volume di query. I problemi di qualità nelle tabelle più importanti vengono segnalati per primi.

- Tempi di risoluzione più rapidi: In Unity Catalog, il monitoraggio della qualità dei dati traccia i problemi direttamente fino ai Lakeflow Jobs e alle Spark Declarative Pipelines a monte. I team possono passare dal catalogo al job interessato per analizzare errori specifici, modifiche al codice e altre cause principali.

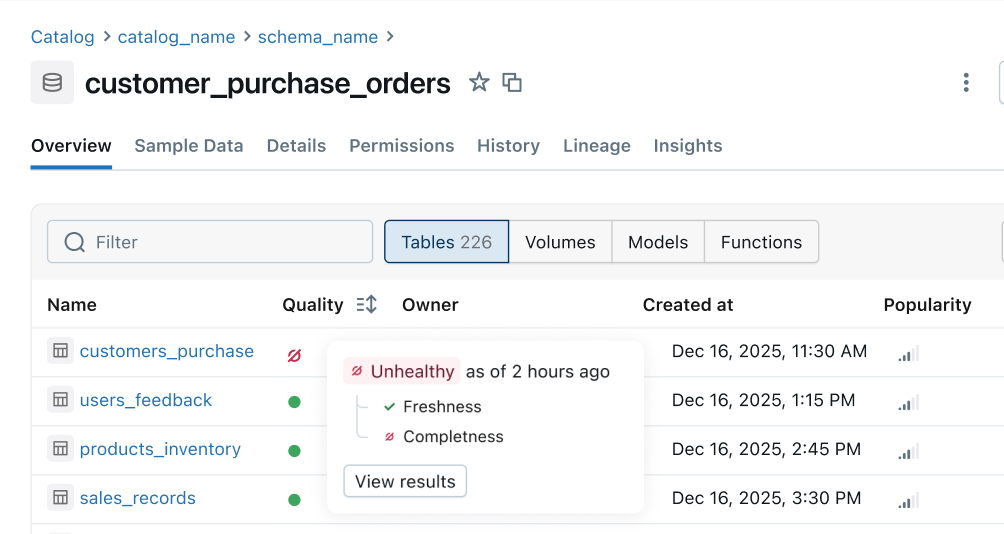

Indicatore di integrità: segnali di qualità coerenti vengono popolati da pipeline a monte a superfici aziendali a valle. I team di data engineering ricevono per primi la notifica dei problemi e i consumer possono capire immediatamente se i dati sono sicuri da usare.

Prossimi passi

Ecco la nostra roadmap per i prossimi mesi:

- Più regole di qualità: Supporto per più controlli come la percentuale di valori nulli, l'univocità e la validità.

- Avvisi automatici e analisi della causa radice: Ricevi automaticamente avvisi e risolvi rapidamente i problemi con puntatori intelligenti alla causa radice integrati direttamente nei tuoi Job e nelle tue pipeline.

- Indicatore di integrità in tutta la piattaforma: visualizza segnali di integrità coerenti in Unity Catalog, Lakeflow Observability, Lineage, Notebooks, Genie e così via.

- Filtra e metti in quarantena i dati errati: Identifica proattivamente i dati errati ed evita che raggiungano i consumatori.

Per iniziare: Anteprima pubblica

Sperimenta il monitoraggio intelligente su larga scala e crea una piattaforma dati affidabile e self-service. Prova l'Anteprima pubblica oggi:

- Abilita il monitoraggio della qualità dei dati dalla scheda Dettagli schema in Unity Catalog

- Ottieni una visione olistica di tutte le tabelle monitorate direttamente nel prodotto.

- Configura avvisi con questo template

(Questo post sul blog è stato tradotto utilizzando strumenti basati sull'intelligenza artificiale) Post originale

Non perdere mai un post di Databricks

Cosa succederà adesso?

Produto

12 giugno 2024/11 min di lettura