Vi presentiamo Predictive Optimization: query più veloci, storage più economico, senza fatica

Siamo entusiasti di annunciare la Public Preview di Databricks Predictive Optimization. Questa funzionalità ottimizza in modo intelligente i layout dei dati delle tabelle per migliorare le prestazioni e l'efficienza dei costi.

Predictive Optimization sfrutta Unity Catalog e Lakehouse AI per determinare le migliori ottimizzazioni da eseguire sui dati, quindi esegue tali operazioni su un'infrastruttura serverless creata appositamente. Ciò semplifica notevolmente il percorso del lakehouse, consentendo di dedicare più tempo a ottenere valore commerciale dai dati.

Questa funzionalità è l'ultima di una lunga serie di funzionalità di Databricks che sfruttano l'IA per eseguire azioni in modo predittivo in base ai dati e ai relativi modelli di accesso. In precedenza, abbiamo rilasciato Predictive I/O per le letture e gli aggiornamenti, che applicano queste tecniche durante l'esecuzione di query di lettura e aggiornamento.

Sfide

Le tabelle Lakehouse traggono grandi vantaggi dalle ottimizzazioni in background che ne migliorano i layout dei dati. Ciò include la compattazione dei file per garantire dimensioni adeguate o la pulizia (vacuum) per rimuovere i file di dati non necessari. Un'ottimizzazione corretta migliora notevolmente le prestazioni, riducendo al contempo i costi.

Tuttavia, questo crea una sfida continua per i team di ingegneria dei dati, che devono capire:

- Quali ottimizzazioni eseguire?

- Quali tabelle devono essere ottimizzate?

- Con quale frequenza eseguire queste ottimizzazioni?

Man mano che le piattaforme lakehouse aumentano di scala e diventano sempre più self-service, i team di piattaforma trovano praticamente impossibile rispondere a queste domande in modo efficace. Un commento ricorrente che abbiamo ricevuto dai nostri clienti è che non riescono a stare al passo con l'ottimizzazione del numero di tabelle create da tutti i nuovi casi d'uso aziendali.

Inoltre, anche una volta risposto a queste spinose domande, i team devono comunque affrontare l'onere operativo di pianificare ed eseguire queste ottimizzazioni, ad esempio pianificando i Job, diagnosticando i guasti e gestendo l'infrastruttura sottostante.

Come funziona Predictive Optimization

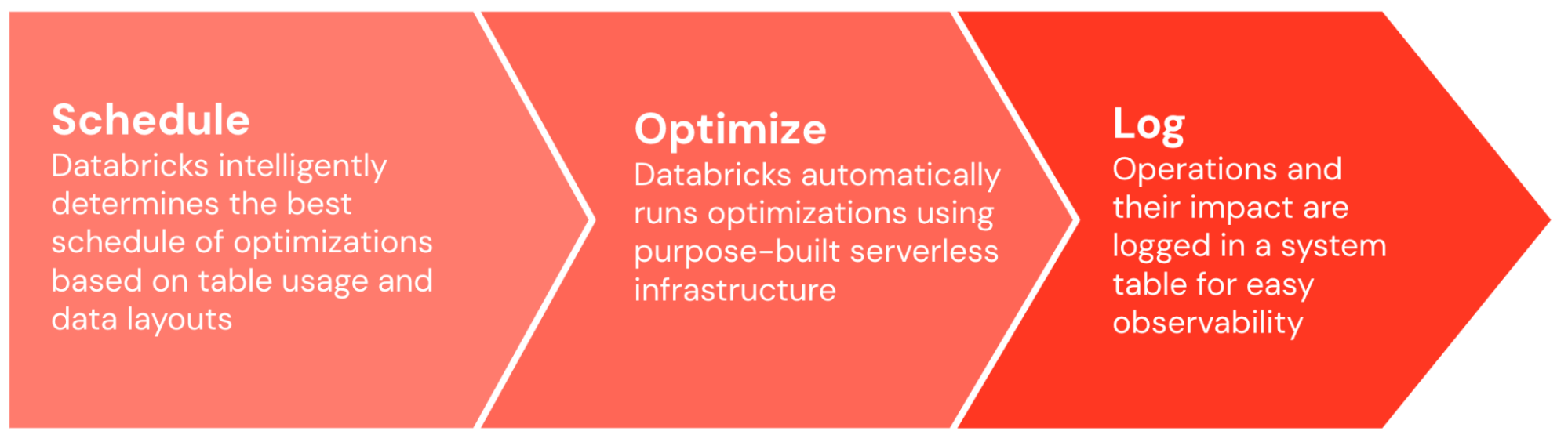

Con l'Ottimizzazione predittiva, Databricks affronta questi problemi spinosi per te, liberando il tuo tempo prezioso per concentrarti sulla creazione di valore di business con i tuoi dati. Predictive Optimization può essere abilitato con un solo clic. Da lì, si occupa di tutto il lavoro pesante.

Innanzitutto, Predictive Optimization determina in modo intelligente quali ottimizzazioni eseguire e con quale frequenza eseguirle. Il nostro modello di IA considera un'ampia gamma di input, inclusi i pattern di utilizzo delle tabelle, il loro layout dei dati esistente e le loro caratteristiche prestazionali. Produce quindi in output il programma di ottimizzazione ideale, bilanciando i benefici attesi dell'ottimizzazione con i costi compute attesi.

Una volta generata la pianificazione, Predictive Optimization esegue automaticamente queste ottimizzazioni sull'infrastruttura serverless appositamente creata. Gestisce automaticamente l'avvio del numero e delle dimensioni corrette delle macchine e garantisce che le attività di ottimizzazione siano correttamente sottoposte a bin-packing e pianificate per un'efficienza ottimale.

L'intero sistema viene eseguito end-to-end senza la necessità di modifiche e ottimizzazioni manuali e apprende nel tempo dall'utilizzo da parte dell'organizzazione, ottimizzando le tabelle più rilevanti per l'organizzazione e riducendo la priorità di quelle che non lo sono. Vengono addebitate solo le compute serverless necessarie per eseguire le ottimizzazioni. Di default, tutte le attività operative vengono registrate in una tabella di sistema, in modo da poter facilmente verificare e comprendere l'impatto e il costo delle attività operative.

Impatto

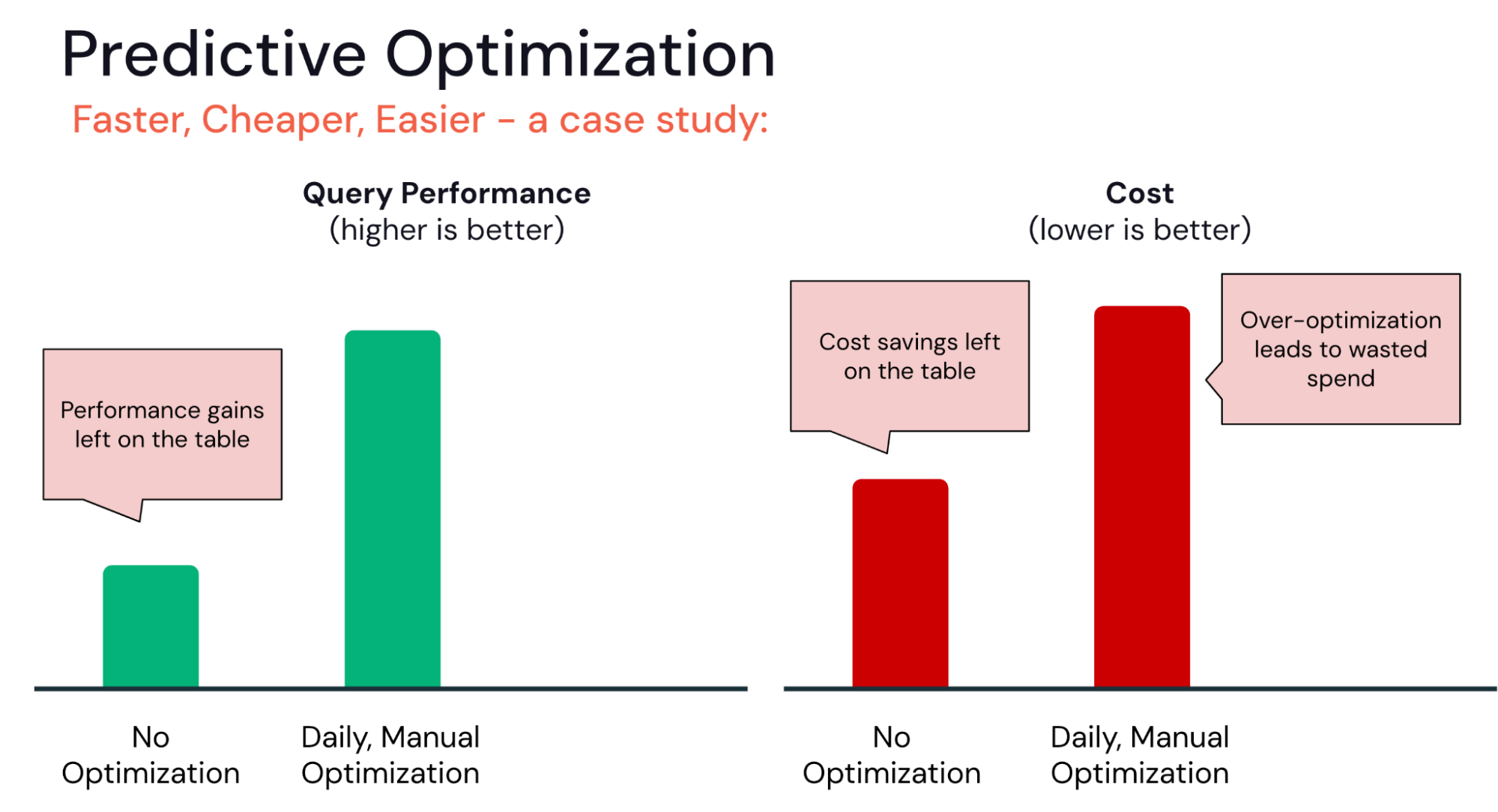

Negli ultimi mesi, abbiamo iscritto diversi clienti al programma di anteprima privata per Predictive Optimization. Molti hanno osservato che è in grado di trovare il giusto equilibrio tra due estremi comuni:

Da un lato, alcune organizzazioni non hanno ancora implementato pipeline sofisticate per l'ottimizzazione delle tabelle. Con l'Ottimizzazione predittiva, possono iniziare immediatamente a ottimizzare le loro tabelle senza dover individuare la migliore pianificazione per l'ottimizzazione o gestire l'infrastruttura.

Gartner®: Databricks leader dei database cloud

All'estremo opposto, alcune organizzazioni potrebbero investire eccessivamente nell'ottimizzazione. Ad esempio, per un team che automatizza le pipeline di ottimizzazione, è forte la tentazione di eseguire job OPTIMIZE o VACUUM con cadenza oraria o giornaliera. Tuttavia, queste corrono il rischio di rendimenti decrescenti. È possibile ottenere gli stessi miglioramenti delle prestazioni con un minor numero di attività operative di ottimizzazione?

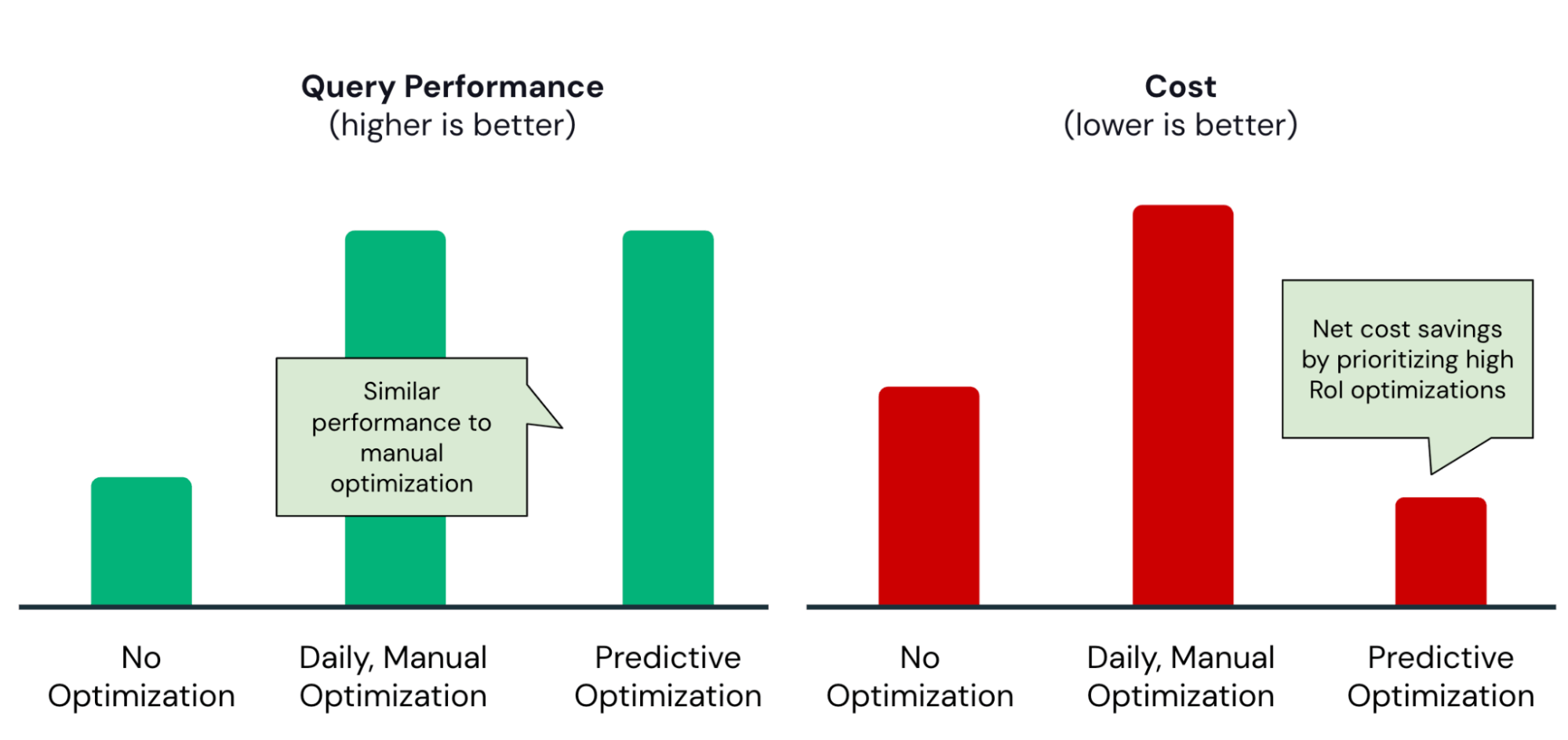

Predictive Optimization aiuta a trovare il giusto equilibrio, garantendo che le ottimizzazioni vengano eseguite solo con un elevato ritorno sull'investimento:

Come esempio concreto, il team di Data ingegneria di Anker ha abilitato Predictive Optimization e ha rapidamente ottenuto i seguenti vantaggi:

Riduzione del 50% dei costi di archiviazione annuali

|

|

Comincia

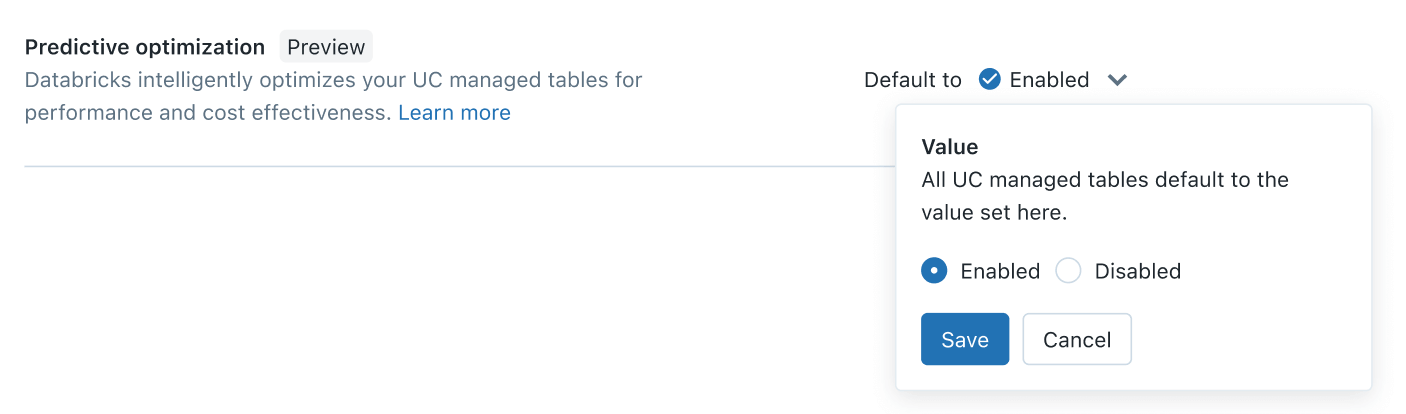

A partire da oggi, l'Ottimizzazione predittiva è disponibile in anteprima pubblica. L'abilitazione dovrebbe richiedere meno di cinque minuti. In qualità di amministratore dell'account, accedi semplicemente alla console dell'account > impostazioni > tab di abilitazione delle funzionalità e attiva l'impostazione Ottimizzazione predittiva:

Con un solo clic, otterrai la potenza dei layout di dati ottimizzati dall'IA su tutte le tue tabelle gestite di Unity Catalog, rendendo i tuoi dati più veloci e convenienti. Per ulteriori informazioni, consultare

E questo è solo l'inizio. Nei prossimi mesi, continueremo ad aggiungere ulteriori ottimizzazioni alla funzionalità. Restate sintonizzati per le novità in arrivo.

(Questo post sul blog è stato tradotto utilizzando strumenti basati sull'intelligenza artificiale) Post originale

Non perdere mai un post di Databricks

Cosa succederà adesso?

Produto

12 giugno 2024/11 min di lettura

Accelerazione delle query 2x

Accelerazione delle query 2x