モデル コンテキスト プロトコル (MCP) とは?AI 統合のための実践ガイド

はじめに: モデル コンテキスト プロトコルの理解

モデル コンテキスト プロトコル (MCP) は、AI アプリケーションが外部のデータソース、ツール、システムとシームレスに接続できるようにするオープン スタンダードです。モデルコンテキストプロトコルは、AIシステムにおけるUSB-Cポートのようなものだとお考えください。USB-Cポートがデバイスのコンピュータへの接続方法を標準化するように、MCPはAIエージェントがデータベース、APIs、ファイルシステム、ナレッジベースなどの外部リソースにアクセスする方法を標準化します。

コンテキスト プロトコルは、AI エージェントを構築する上での重大な課題である「N×M 統合問題」に対処します。標準化されたプロトコルがない場合、各AIアプリケー�ションはすべての外部サービスと直接統合する必要があり、N×M個の個別の統合を作成することになります。ここで、Nはツールの数、Mはクライアントの数を表します。このアプローチでは、すぐにスケールすることが不可能になります。モデルコンテキストプロトコル(MCP)は、各クライアントと各MCPサーバーにプロトコルを一度だけ実装するよう要求することでこの問題を解決し、総統合数をN×MからN+Mに削減します。

AIシステムがLLMのトレーニングデータを超えたリアルタイムデータにアクセスできるようにすることで、MCPはAIモデルが初期学習フェーズの静的なトレーニングデータのみに頼るのではなく、正確で最新の応答を提供できるよう支援します。

Databricks についてさらに詳しく

モデル コンテキスト プロトコルとは?

モデルコンテキストプロトコルは、開発者がコンテキストアウェアなAIアプリケーションを構築できるようにする、オープンソースで統一された相互運用性のための標準です。MCPは、LLMアプリケーションのデプロイ、モニタリング、ライフサイクル管理を簡素化するランタイム統合、可観測性、ガバナンス制御を公開することで、LLMOpsを補完します。

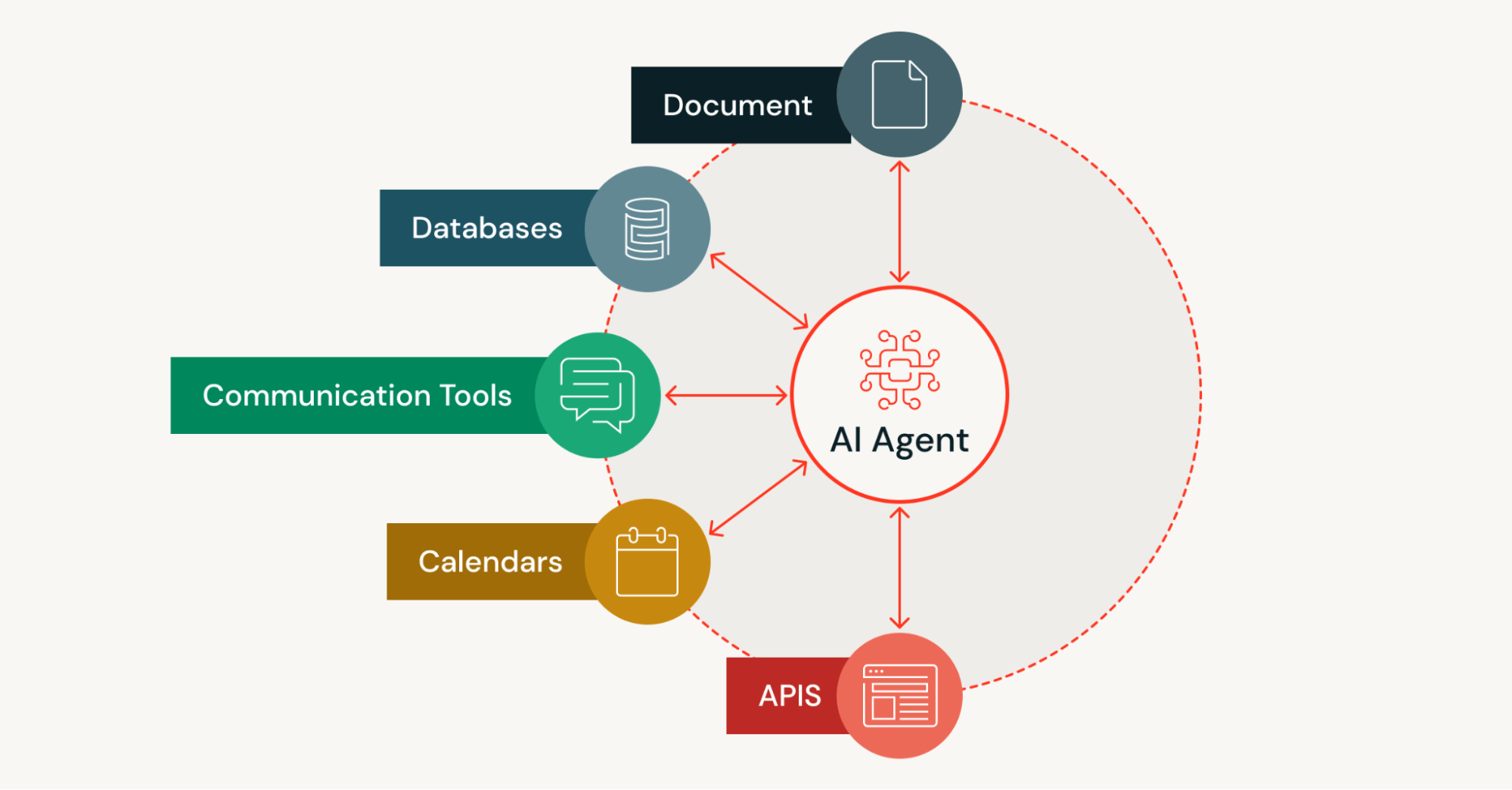

AI アプリケーションは、プロンプトのコンディショニングとグラウンディング生成のために、ローカルリソース、データベース、データパイプライン (ストリーミング/バッチ)、検索エンジン、計算機、ワークフローなどのアセットにアクセスする必要があります。コンテキストプロトコルは、定型的な統合コードを削減する構造化された方法を通じて、アプリケーションがそれらのアセットに接続する方法を標準化します。

スケーラビリティの問題により、AIモデル(特に大規模言語モデル)は通常、トレーニングのために既存の静的データに依存する必要があります。静的データセットでトレーニングされたモデルは、新しい情報を取り込むため追加の更新が必要となるため、不正確または古い応答につながる可能性があります。スケーラビリティに対処することで、MCPはAIアプリケーションがコンテキストを認識し、静的トレーニングデータの制限に制約されない最新の出力を提供できるようにします。

MCP とは何か、なぜ使用されるのか?

モデルコンテキストプロトコル (MCP) は、AIアプリケーションがランタイムに外部のツールやデータソースを検出し、それらと対話するための標準化された方法として機能します。MCP を使用する AI エージェントは、各外部サービスへの接続をハードコーディングするのではなく、利用可能なツールを動的に検出し、構造化された呼び出しを通じてその機能を理解し、適切なツール権限で呼び出すことができます。

MCPは、AI搭載ツールが情報にアクセスする方法を変革するために使用されます。従来のAIシステムはトレーニングデータによって制限されており、そのデータはすぐに古くなります。コンテキストプロトコルにより、開発者は、一般的なエンタープライズシステム、開発環境、その他の外部ソースからのライブデータを使用してタスクを実行できるAIエージェントを構築できます。これらすべてを単一の標準化されたプロトコルを介して行います。

このオープンプロトコルは、定型的な統合コードも削減します。開発者は、新しい統合ごとにカスタムコネクタを作成する代わりに、クライアント側とサーバー側の両方で一度MCPを実装します。このアプローチは、異なるコンテキストにわたって複数のツールを自律的に検出し、使用する必要があるエージェント型AIシステムにとって特に価値があります。

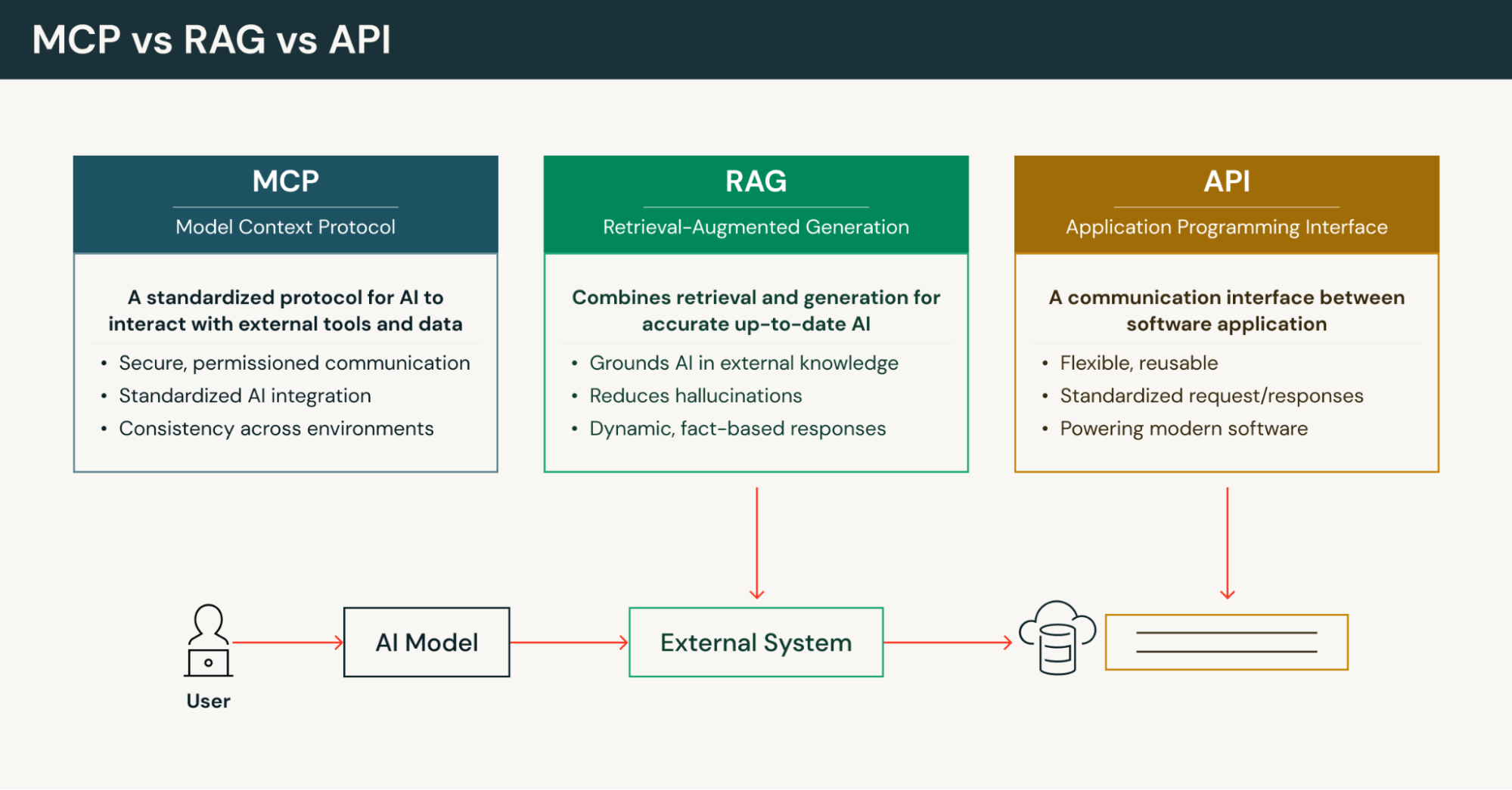

MCPとAPIの比較

従来のAPIの制限

従来のAPIは、型指定されたパラメーターを持つEndpointを公開します。クライアントはこれをハードコーディングし、APIが変更されるたびに更新する必要があります。APIsは返されたデータの使用方法に関するセマンティックなガイダンスを最小限しか提供しないため、コンテキストのつなぎ合わせはクライアントの責任となります。APIリクエストは通常、呼び出し間で状態やコンテキストを維持することなく、単純なリクエスト・レスポンス パターンに従います。

モデル コンテキスト プロトコルの違い

MCPは、従来のAPIsとは異なるアプローチを定義します。ハードコーディングされたエンドポイントではなく、MCP サーバーは実行時に検出可能な、機械可読のケイパビリティ サーフェスを公開します。AIシステムは、事前に定義された接続に依存する代わりに、利用可能なツール、リソース、プロンプトにクエリできます。モデル コンテキスト プロトコルは、リソースの形状(ドキュメント、データベースの行、ファイル)を標準化し、シリアル化の複雑さを軽減することで、AI モデルが推論に最適化された関連コンテキストを受け取れるようにします。

MCP実装は、ストリーミングセマンティクスによる双方向のステートフルな通信をサポートします。これにより、MCP サーバーは更新と進捗通知を AI エージェントのコンテキストループに直接プッシュできるようになり、従来の APIs がネイティブに提供できない複数ステップのワークフローと部分的な結果をサポートします。このクライアントサーバーアーキテクチャにより、エージェントシステムにおいて、より高度なツール使用パターンが可能になります。

MCP と RAG: 補完的なアプローチ

検索拡張生成 (RAG) は、ドキュメントを埋め込みに変換し、それらをベクトルデータベースに保存し、生成中に関連情報を検索することでAIの精度を向上させます。しかし、RAG は通常、コンテンツ リポジトリからインデックス化された静的なソースに依存します。モデル コンテキスト プロトコルは、ライブ API、データベース、ストリームへのオンデマンド アクセスを提供し、鮮度が重要な場合に信頼できる最新のコンテキストを返します。

主に読み取り専用のコンテキストを返すRAGとは異なり、コンテキストプロトコルはリソースとツールを分離するため、AIエージェントは制御されたスキーマを持つ外部システムでデータの取得とタスクの実行の両方が可能です。MCPは、エージェント型ワークフローの有効化、マルチターンオーケストレーション、ランタイム機能検出、マルチテナントガバナン�スといった、RAGがネイティブに提供しない、より広範な統合ニーズに対応します。

MCPはRAGの実装を補完できます。組織は、RAGを使用してエバーグリーンコンテンツをインデックス化して高速検索を実現する一方で、モデルコンテキストプロトコルをトランザクションルックアップ、SQLクエリ実行、ライブシステムからの適切なコンテキストを必要とするアクションに使用できます。このハイブリッドアプローチは、速度と精度の両方を提供します。

MCPエコシステムにおける標準化の価値

ランタイムで検出可能な双方向プロトコルとして、モデルコンテキストプロトコルは、ばらばらの外部ツールとデータを、アドレス指定可能なリソースと呼び出し可能なアクションに変換します。単一のMCPクライアントで、ファイル、データベースの行、ベクトルスニペット、ライブストリーム、APIエンドポイントを統一的に検出できます。インデックス付きRAGキャッシュと共存することで、MCPは信頼できるジャストインタイムのルックアップとアクションセマンティクスを提供します。

その実用的な結果として、特注のコネクタやカスタムコードが減り、統合が高速化され、適切なエラー処理と監査証跡を備えた、より信頼性の高いエージェント型システムが実現します。AIアシスタントをリモートリソースに接続するこの標準化された方法は、エンタープライズセキュリティ制御を維持しながら開発サイクルを加速します。一般的なエンタープライズシステムで利用可能なMCPサーバー実装が増えるにつれて、MCPエコシステムはこの標準化の恩恵を受けます。

MCP のコアアーキテクチャ: クライアントサー�バーモデルを理解する

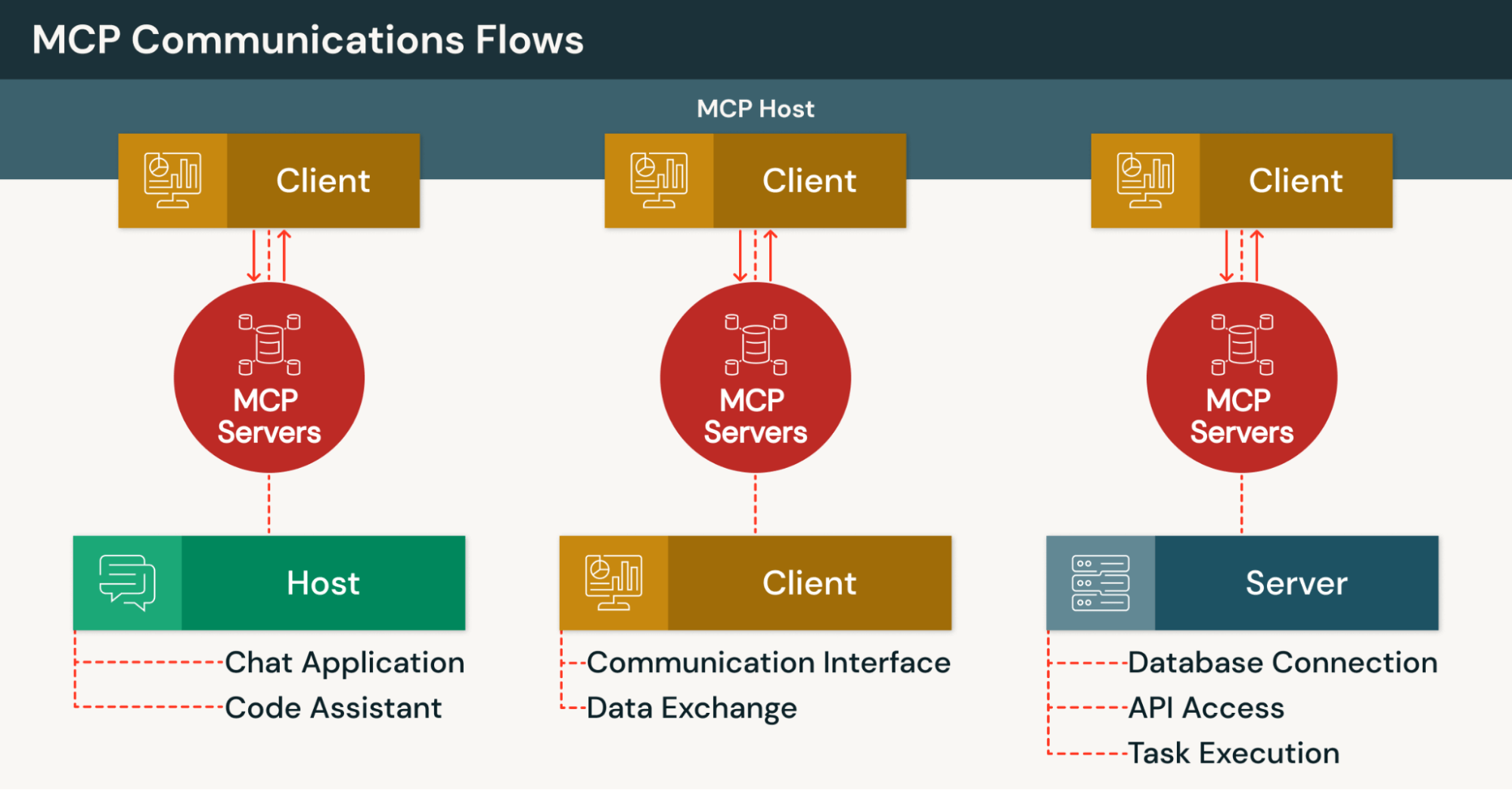

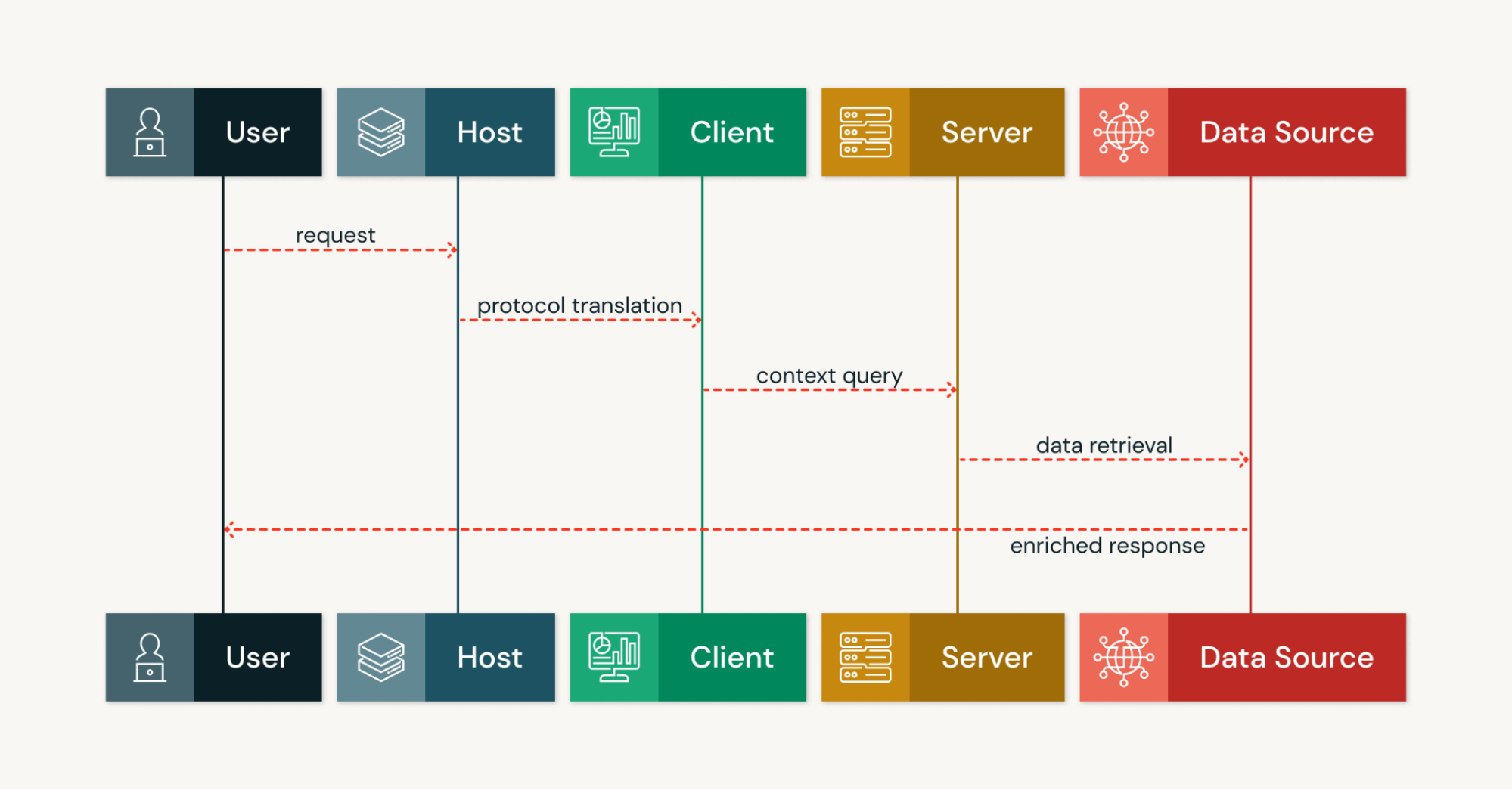

MCP アーキテクチャは、永続的な通信チャンネルを通じて接続された、MCP サーバー、MCP クライアント、MCP ホストという 3 つの主要な役割を中心に統合を構成します。このクライアントサーバーアーキテクチャにより、AI ツールは、個別のリクエスト/レスポンスのやり取りではなく、複数ステップのステートフルなワークフローを実行できるようになります。

MCPサーバーの役割

MCP サーバーは、標準化されたインターフェースを介してデータとツールを公開し、クラウド、オンプレミス、またはハイブリッド環境で実行できます。各サーバーは、名前付きリソース、呼び出し可能なツール、プロンプト、通知フックの機能サーフェスを公開します。リソースには、ドキュメント、データベースの行、ファイル、パイプラインの出力が含まれる場合があります。

MCPサーバーの実装ではJSON-RPC 2.0のメソッドと通知を使用し、長時間実行されるオペレーションのストリーミングをサポートし、トランスポート層を介して機械可読な検出を提供します。これにより、MCPホストとAIモデルは、利用可能なツールに関する事前の知識を必要とせずに、ランタイム時に機能をクエリーできます。

一般的なMCPサーバー実装は、AIシステムをGoogle Drive、Slack、GitHub、PostgreSQLデータベースなどの外部サービスに接続します。これらのMCPサーバーは、認証、データ検索、およびツールの実行を処理し、標準化されたプロトコルを通じて一貫したインターフェースを提供します。MCPエコシステム内の各サーバーは、複数のクライアントに同時にサービスを提供できます。

MCP クライアントの機��能

MCPクライアントは、ホストアプリケーション内のコンポーネントであり、ユーザーまたはモデルのインテントをプロトコルメッセージに変換します。各クライアントは通常、MCPサーバーと1対1の接続を維持し、構造化された方法でライフサイクル、認証、およびトランスポートの詳細を管理します。

MCP クライアントは、JSON-RPC を使用してリクエストを構造化された呼び出しとしてシリアライズし、非同期通知と部分的なストリームを処理し、統合の複雑さを軽減するための統一されたローカル API を提供します。複数のクライアントは、同じ MCP ホストから、それぞれ異なる MCP サーバーに同時に接続して操作できます。

これらのクライアントにより、AI エージェントは各外部サービスの実装の詳細を理解することなく、外部データソースとやり取りできるようになります。クライアントは、すべての通信プロトコル、エラー処理、再試行ロジックを自動的に処理します。

MCPホストの役割

MCPホストは、MCPクライアントとサーバーの機能を調整するAIアプリケーション層を提供します。例としては、Claude Desktop、Claude Code、AI搭載IDE、およびAIエージェントが動作するその他のプラットフォームが挙げられます。MCPホストは、プロンプト、会話の状態、クライアントの応答を集約して、マルチツールワークフローをオーケストレーションします。

MCPホストは、ツールを呼び出すタイミング、追加の入力をリクエストするタイミング、または通知を表示するタイミングを決定します。この一元化されたオーケストレーションにより、AIモデルはサービス固有のコードなしで異種のMCPサーバー間��で動作できるようになり、多様なシステムにAIアシスタントを接続するというMCPエコシステムの普遍的な相互運用性の目標をサポートします。

コンテキストフローと双方向通信

モデル コンテキスト プロトコルにおけるクライアントサーバー通信は、トランスポート層で JSON-RPC 2.0 を使用した、双方向かつメッセージ駆動型です。MCP クライアントはリソースの取得やツールの呼び出しのためにメソッドを呼び出す一方、MCP サーバーは結果を返し、部分的な出力をストリーミングし、関連情報を含む通知を送信します。

MCPサーバーはリクエストを開始することもでき、MCPホストにオプションのサンプリングや、関数呼び出しメカニズムを介したユーザー入力の引き出しを要求します。この双方向機能が、コンテキスト プロトコルを従来の一方向 API パターンと区別しています。MCPのライブの信頼できるルックアップは、トレーサビリティのための出所メタデータを持つジャストインタイムのレコードを提供することで、RAGを補完します。

永続的なトランスポートはメッセージの順序を保持し、リアルタイム更新を可能にします。これにより、AIシステムは中間出力を繰り返し処理し、自律型AIエージェントを可能にするエージェントループを実行できます。

Model Context Protocol の要件

セキュリテ�ィ要件と脅威からの保護

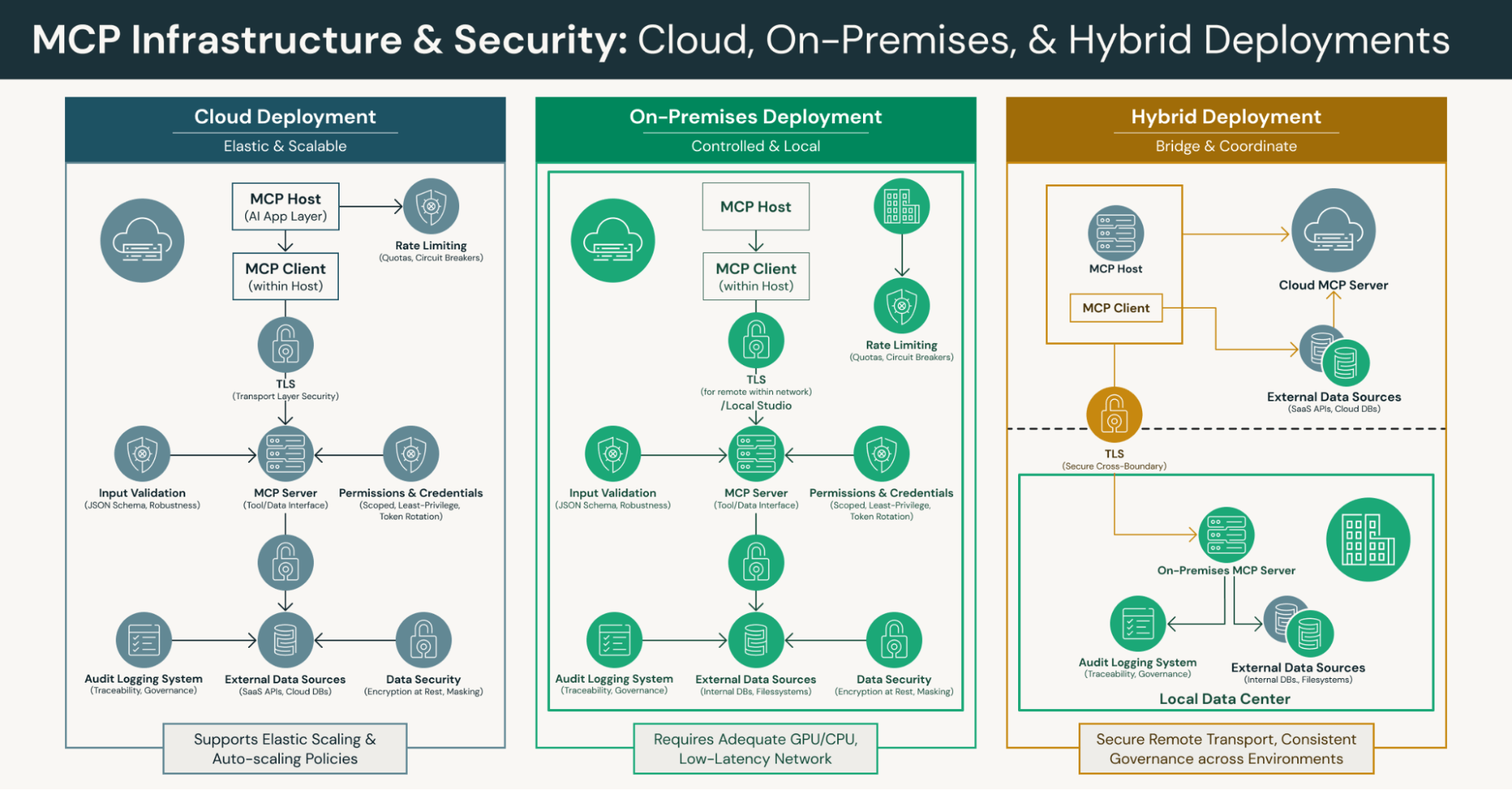

MCPの実装では、セキュリティの脅威から保護するために、リモートトランスポートに対するトランスポート層セキュリティ(TLS)、厳格なツール権限、スコープ付きの認証情報を強制する必要があります。このプロトコルでは、インジェクション攻撃や不正な形式のリクエストを防ぐために、MCPクライアントとサーバーの両方で、JSONスキーマ強制によるレート制限と堅牢な入力検証が要求されます。

監査ロギング、トークンのローテーション、最小権限の付与は、長期間存続するチャンネルを管理するために不可欠な要件です。これらのセキュリティ対策は、モデルコンテキストプロトコルが実現する検出可能な統合機能を維持しつつ、不正アクセスから保護します。組織は、データセキュリティを確保するために、長期間存続するMCPチャンネルに対して、転送中および保存中の暗号化、マスキング、スコープ付き権限を実装する必要があります。

インフラストラクチャとシステム要件

MCPを導入する組織には、大規模言語モデル、MCPサーバー、および接続されたデータソースをホストできるコンピュートおよびネットワーキングインフラストラクチャが必要です。これには、十分なGPU/CPU容量、メモリ、ディスクI/O、およびクライアントサーバーアーキテクチャのコンポーネント間の低遅延ネットワークパスが含まれます。

クラウドプラットフォームは、モデルインスタンスとMCPサーバーのエラスティックスケーリングをサポートする必要があります。チームは、並列ストリームと長時間実行される��操作のためのオートスケールポリシーを定義する必要があります。トランスポート層は、埋め込みコンポーネント用のローカルSTDIOと、分散展開用のHTTP/SSEやWebSocketなどのリモートストリーミングチャンネルの両方をサポートする必要があります。

MCPを機能させるための実装要件

MCP の作業には、JSON-RPC 2.0 メッセージング、ディスカバリエンドポイント、リソース/ツールのスキーマの実装が必要です。MCP サーバーは、その機能を標準プロトコルを介して機械可読形式で公開する必要があります。これにより、開発者は、ハードコードされた接続なしでツールのディスカバリをサポートする、ディスカバリベースの統合を構築できます。

エラー処理、再接続戦略、バックプレッシャー管理は、本番運用における信頼性を確保するための重要な実装要件です。組織は、メトリクス、トレース、logsを使用して、永続的なストリーム、メソッドのレイテンシ、リソース使用量に対する可観測性を実装すべきです。レートリミッター、サーキットブレーカー、クォータは、下流システムを過負荷から保護します。

実用的なメリット: リアルタイムデータアクセスとハルシネーションの軽減

モデル コンテキスト プロトコルにより、AI モデルはキャッシュされた埋め込みや静的な LLM のトレーニングデータのみに頼るのではなく、ライブレコード、パイプライン出力、API 応答、ファイルをオンデマンドで取得します。これにより、応答は最新の信頼できるデータソースに基づいたものとなり、AI システムが不正確な情報を生成するハルシネーションを低減します。

クエリー時に返されるリソースには、ソースIDやTimestampなどの出所メタデータが含まれており、MCPホストはこれにより出所を記録し、出力を追跡可能にすることができます。この透明性は、規制対象の業界で監査可能性が求められるタスクを AI エージェントが実行する際に不可欠です。コンテキスト プロトコルは、信頼できる外部システムから関連するコンテキストが常に利用可能であることを保証します。

エージェント型AIワークフローのサポート

MCPサーバーは標準化された方法でリソース、ツール、プロンプTを公開するため、AIモデルはハードコードされたEndpointなしでサービスを検出して呼び出すことができます。このオープンスタンダードは、サーバー主導の引き出しとMCPサーバーからのストリーミング応答をサポートし、多段階の推論、入力の明確化、部分的な結果に対する反復を可能にします。

ツールは、スコープ付きのツール権限とともにJSONスキーマで定義された入力/出力を公開し、AIエージェントがチケットの作成、SQLクエリーの実行、ワークフローの実行などの制御されたアクションを実行できるようにします。この自律的なツールの検出、双方向のインタラクション、組み込みのガードレールは、外部システム全体で信頼性の高いエージェント型AIの基盤を提供します。

モデルコンテキストプロトコル (MCP) は、動的なツール検出とアクションプリミティブに依存して、システム全体で認識、決定、行動するエージェント型ワークフローを明示的に可能にします。これにより、適切なガバナンス制御を維持しながら、自律的に動作するAIエージェントを構築することが可能になります。

標準化された統合に�よる開発の簡素化

コンテキストプロトコルにより、開発者は、MCPホストとAIモデルが一貫した検出および呼び出しセマンティクスで再利用できる単一のサーバーサーフェスを実装できます。これにより、一般的なサービス用の個別のコネクタが不要になり、AI アシスタントを新しいデータソースに接続するために必要なエンジニアリングの労力が削減されます。

型付きリソースとJSONスキーマにより、他の方法では必要となるカスタムシリアライゼーション、検証、およびエラー処理コードが削減されます。ローカルSTDIOまたはリモートストリーミングトランスポートにより、チームはMCPホストロジックを変更することなく、オンプレミス、クラウド、またはハイブリッドデプロイメントを選択できます。この柔軟性により、さまざまな開発環境におけるチームによる AI エージェントの構築が加速されます。

MCPは、新しい統合ごとにカスタムアダプターを構築するのではなく、統合を一度で標準化するための実用的な方法を提供します。より多くの組織がこの標準を採用するにつれて、この標準化されたプロトコルアプローチはMCPエコシステム全体に利益をもたらします。

複雑なワークフローにおける自動化の可能性の向上

MCPの永続的でステートフルなチャンネルにより、AIシステムは複数の外部サービスにわたるルックアップ、変換、副作用を1つの連続したループ内で組み合わせることができます。長時間実行されるオペレーションの場合、MCPサーバーは部分的な結果をストリーミングできるため、AIエージェントは中間的な決定を下したり、ワークフローをフォークしたり、必要に応じて�人間の入力を要求したりできます。

エバーグリーンコンテンツリポジトリのためのインデックス付き検索と、モデルコンテキストプロトコルのオンデマンドでの信頼できる情報源の参照を組み合わせることで、迅速で正確な応答をサポートします。このハイブリッドアプローチは、AI搭載ツールが静的なナレッジベースと動的な外部データソースの両方にアクセスできるようにしながら、ガバナンス制御を維持します。

コンテキストプロトコルがマルチターンオーケストレーションをサポートすることで、エージェントシステムは、複数のツールやデータソースにまたがる調整が必要な複雑なワークフローを処理できます。この自動化の可能性は、組織が本番運用環境でAIアプリケーションを展開する方法を変革します。

実装のベスト プラクティス: システムの準備

インフラストラクチャが LLM ホスティング、MCP サーバー、接続されたデータソースをサポートできることを検証してください。クライアントサーバーアーキテクチャのために、十分なGPU/CPUリソース、メモリ割り当て、およびネットワーク帯域幅を確保してください。並列ユーザーのための弾力的なスケーリングをサポートし、オートスケールポリシーを定義できるクラウドプラットフォームを選択してください。

MCPクライアントとサーバー間のすべてのリモート接続に対して、TLSを使用して安全なトランスポートを標準化します。再接続戦略や観測可能なストリームのヘルス**メトリクス**など、接続のライフサイクル管理を文書化します。下流の外部システムを過負荷から保護するために、レート制限、サーキットブレーカー�、クォータを実装します。

組織は、組み込みコンポーネント向けに、ストリーミングチャンネル(HTTP/SSE、WebSocket)とローカルのSTDIOを標準化する必要があります。インジェクション攻撃を防ぎ、システム全体で適切なエラー処理を確実に行うために、サーバーとクライアントの両方でJSONペイロードとスキーマを検証します。

プログラミング言語におけるオープンソースリソースの活用

MCPエコシステムには、クライアントとサーバーの開発を加速させる、複数のプログラミング言語のコミュニティSDKが含まれています。これらのSDKは、JSON-RPCメッセージング、ストリーミング、スキーマ検証のための確立されたパターンを提供し、プロトコルの基本的な実装を再実装する必要性をなくします。

開発者は、一般的なエンタープライズシステム向けの既存のMCPサーバー実装を再利用し、オープンスタンダードを通じてドメイン固有のユースケースに拡張できます。通知、長時間実行されるストリーム、エラー条件を模倣するシミュレーターを構築することは、チームが本番運用へのデプロイ前にエージェントシステムをテストするのに役立ちます。

コミュニティリソースを採用してMCPの作業を加速し、共通機能の再構築を回避します。これらのオープンソースツールにより、開発者はプロトコル実装の詳細ではなく、ビジネスロジックに集中できます。

本番運用展開のための統合戦略

コンテキストを認識する AI アシスタントや AI エージェントを使用した自動化ワークフローなど、測定可能な ROI を実証するインパクトの大きいユースケースから始めてください。初期のツールの範囲とツ��ールの権限を制限し、テレメトリーとユーザーフィードバックを収集し、その後、コア機能が安定した後に機能を拡張してください。

コンテンツリポジトリからの大規模な静的コーパスに対して、MCP のライブ ルックアップと RAG を組み合わせることで、レイテンシーと鮮度のバランスを取ります。広範な本番運用への展開の前に、SLA、監査証跡、エスカレーション手順を定義します。この段階的なアプローチは、エージェント AI の展開における組織の信頼を構築しながら、リスクを低減します。

MCPは、エコシステムにさらに多くのMCPサーバーとクライアントが追加されるにつれてスケールする、構造化された統合計画の必要性に対応します。組織は、導入プロセスの早い段階で、統合アーキテクチャとガバナンスポリシーを文書化する必要があります。

よくある誤解: MCP は単なる別の API フレームワークではない

現実:モデルコンテキストプロトコルは、永続的なコンテキスト管理と動的な機能検出を備えたプロトコルレベルの統合を標準化します。RESTまたはRPCコールとは異なり、MCPは、AIエージェントが標準プロトコルを通じて機能を検出し、ストリームにサブスクライブし、インタラクション全体でコンテキストの状態を維持する方法を定義します。

この標準化されたプロトコルにより、ツールを一��度構築するだけで、MCP エコシステムを通じて複数の AI エージェントやモデル プロバイダーに一様に公開できます。コンテキスト プロトコルは、モデル コンテキストを一時的なペイロードとして扱うのではなく、適切なライフサイクル管理を持つ、第一級のバージョン管理されたリソースとして位置づけます。

ツールとエージェントは異なるコンポーネントです

現実:ツールとは、データベースアクセス、ファイル操作、API統合など、MCPサーバーを通じて公開される個別の機能です。AIエージェントは、利用可能なツールを検出、オーケストレーション、および呼び出してタスクを自律的に実行する、意思決定を行うコンピュータープログラムです。

コンテキストプロトコルにより、AI エージェントは、MCP クライアントを介して、ツールのメタデータを動的に検出し、関数呼び出しのセマンティクスでツールインターフェースを安全に呼び出し、出力を会話に統合できるようになります。この分離により、ツール所有者がエージェントのロジックとは独立してインターフェースを更新する一方で、さまざまなエージェントシステムが同じツールカタログを使用できるようになります。

MCPによる包括的なデータ接続の管理

現実: モデルコンテキストプロトコルは、単純なツールの使用を超えて、外部データソースへの包括的な接続性を管理します。これは、ストリーミング通知、コンテンツリポジトリやベクターストアへの認証されたアクセス、および長時間実行されるオペレーションとエラー処理のための一貫したセマンティクスをサポートします。

MCPは、��構造化された方法を通じて、ローカルリソース、リモートリソース、ライブデータクエリ、および操作アクションへのアクセスを統合する実用的な方法を提供します。この統合されたアプローチは、エンタープライズ環境において、ガバナンス、可観測性、アクセス制御がAI機能とともに拡張されるのに役立ちます。コンテキストプロトコルは、一貫したインターフェースを通じて他のツールや外部サービスを処理します。

今後の研究の方向性と進化

オープン スタンダードが成熟するにつれて、将来の研究の方向性には、マルチテナント展開向けの強化されたセキュリティ フレームワーク、複雑なエージェント ワークフローのための改善されたストリーミング セマンティクス、および追加のプログラミング言語や開発環境と統合するための標準化されたパターンが含まれます。

成長を続けるMCPエコシステムは、新たな外部ツールやプラットフォーム向けの新しいMCPサーバー実装によって拡大し続けています。SDK、アダプター、リファレンスアーキテクチャへのコミュニティによる貢献は、プロトコルのコア目標である「あらゆるAIアプリケーションが標準化された方法であらゆる外部サービスに接続できるようにする」を維持しつつ、採用を加速させます。

Model Context Protocol を検討している組織は、エコシステムの動向を監視�し、MCP の実装に貢献し、AI アシスタントを外部システムに接続する方法の進化を形成するワーキンググループに参加することが推奨されます。この協調的なアプローチにより、AIシステムと外部サービスが進化し続けても、MCP実装の相互運用性が確保されます。今後の研究は、プロトコルの中核となるシンプルさを維持しつつ、その機能を拡張することに重点を置くことになるでしょう。

結論:現代AIの基盤としてのモデルコンテキストプロトコル

モデルコンテキストプロトコルは、AIアプリケーションが外部のデータソースやツールにアクセスする方法における根本的な変化を表しています。検出ベースの統合のためのオープン プロトコルを提供することで、コンテキスト プロトコルは、開発者が広範な定型的な統合コードなしで、一般的なエンタープライズ システムからのライブデータを使用してタスクを実行できる、コンテキストを認識する AI エージェントを構築できるようにします。

標準化されたプロトコルは、クライアントサーバーアーキテクチャを通じて複雑さを軽減し、開発サイクルを加速させ、AIシステムが静的なLLMトレーニングデータの限界を超えることを可能にします。MCPクライアントとMCPサーバー間の双方向通信、およびエージェント型AIワークフローのサポートを通じて、モデルコンテキストプロトコルMCPは、多様な環境にわたってより高性能で自律的なAIツールのための基盤を確立します。

新しいMCPサーバー実装と統合によってMCPエコシステムが成長するにつれて、組織は、適切なツールの権限、セキュリティ制御、監査証跡を維持しながら、複数の外部サービスを検出して連携させる高度なAIエージェントを構築できます。AIシステムを外部のツールやデータソースに接続するこの標準化されたアプローチは、企業が本番用のAIアプリケーションを導入する方法を今後も形成していくでしょう。コンテキスト プロトコルは、開発者が自信を持って次世代の AI アプリケーションを構築できるようにする不可欠なインフラストラクチャを提供します。