Das Databricks AI System Framework (DASF)

Das Databricks AI System Framework (DASF) skizziert die Schlüsselkomponenten eines modernen AI/ML-Systems und hilft Organisationen, potenzielle Risiken zu bewerten und Sicherheitsbestpraktiken anzuwenden.

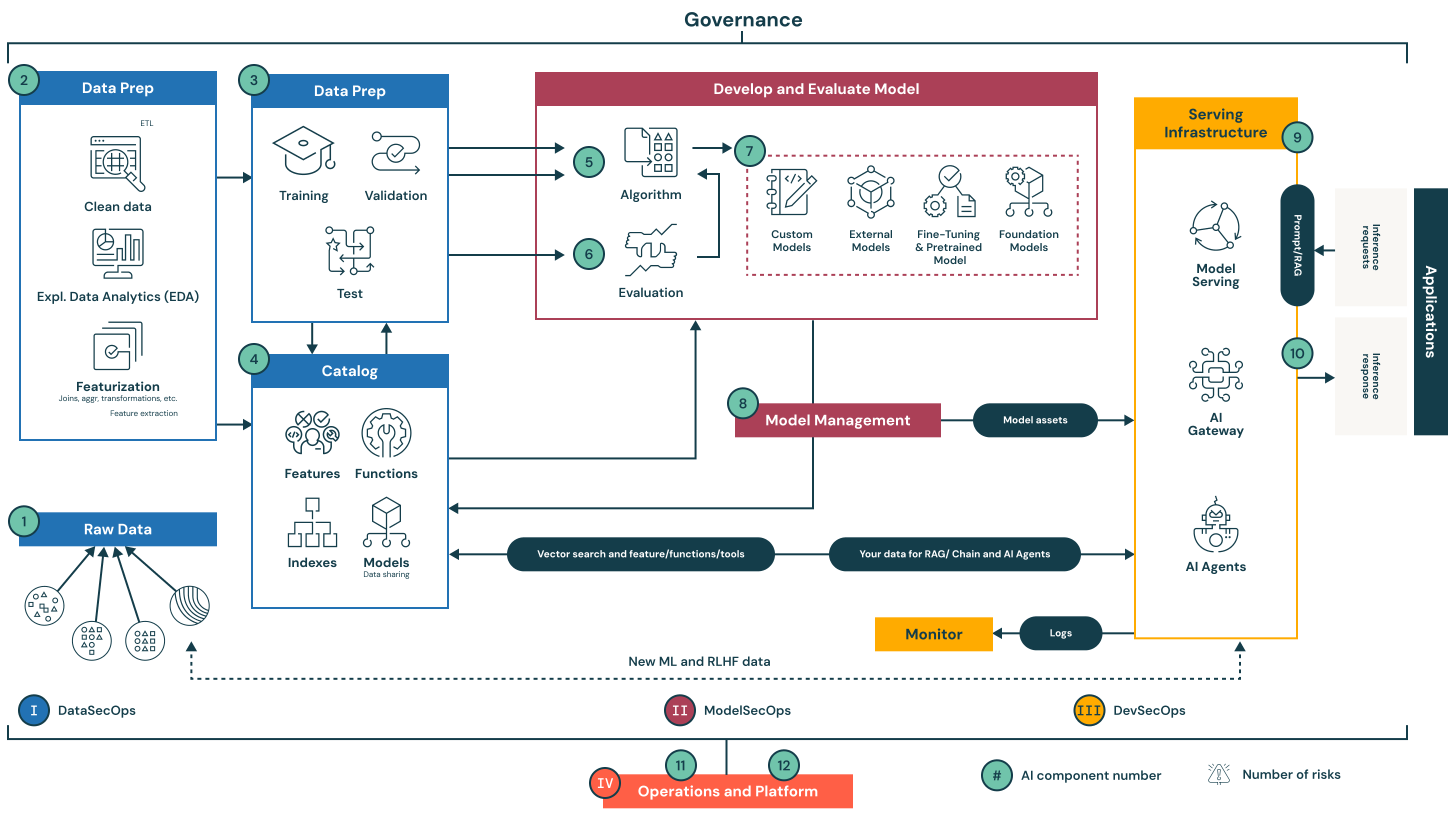

Architekturübersicht

Das Databricks AI System Framework (DASF) skizziert die Schlüsselkomponenten eines modernen AI/ML-Systems und hilft Organisationen, potenzielle Risiken zu bewerten und Sicherheitsbestpraktiken anzuwenden. Durch das Verständnis, wie diese Komponenten interagieren, können Organisationen besser auf Schwachstellen vorbereitet sein und die entsprechenden Minderungsstrategien anwenden.

Das Databricks-Sicherheitsteam hat diese Erkenntnisse in die Databricks Data Intelligence Plattform integriert, mit eingebauten Kontrollen und verlinkter Dokumentation für Sicherheit und Compliance.

Das System ist in 12 grundlegende Komponenten organisiert, die in vier Schlüsselphasen gruppiert sind. Jede Phase repräsentiert eine kritische Säule für sichere, regulierte und betrieblich effiziente AI und ML Workflows.

I. Datenoperationen (Komponenten 1–4)

Datenoperationen konzentrieren sich auf das Einlesen, Vorbereiten und Katalogisieren von Daten. Dies ist die Grundlage jedes vertrauenswürdigen ML-Systems, da die Modellqualität von der Qualität und Sicherheit der Eingabedaten abhängt.

1. Rohdaten: Daten werden aus mehreren Quellen (strukturiert, unstrukturiert und halbstrukturiert) aufgenommen. In dieser Phase müssen die Daten sicher gespeichert und zugriffskontrolliert sein.

2. Datenvorbereitung: Dieser Schritt beinhaltet Reinigung, explorative Datenanalyse (EDA), Transformationen und Merkmalsbildung. Es ist Teil des Extrahieren, Transformieren, Laden (ETL) Prozesses und essentiell, um aussagekräftige Trainingsmerkmale abzuleiten.

3. Datensätze: Vorbereitete Datensätze werden in Trainings-, Validierungs- und Testsets aufgeteilt. Diese Datensätze müssen versioniert und reproduzierbar sein.

4. Katalog: Ein zentralisiertes Register für Datenressourcen: Merkmale, Indizes, Modelle und Funktionen. Es unterstützt Auffindbarkeit, Herkunft, Governance und sicheres Daten Teilen über Teams hinweg.

Schlüssel zur Risikominderung: Zugriffskontrollen, Verschlüsselung, Datenherkunftsnachverfolgung und Audit-Logging helfen sicherzustellen, dass nur autorisierte Benutzer auf Daten zugreifen, diese ändern oder teilen können.

II. Modell-Operationen (Komponenten 5–8)

Modell-Operationen beinhalten Experimentieren, Evaluieren und Lebenszyklusmanagement von ML- und AI-Modellen.

5. Algorithmus: Kundenspezifische oder vorgefertigte Algorithmen, die zur Entwicklung von Vorhersagemodellen verwendet werden.

6. Bewertung: Systematische Beurteilung der Modellleistung mit Validierungsdaten und definierten Metriken.

7. Modell entwickeln und bewerten: Dies beinhaltet das Erstellen von Modellen von Grund auf, die Nutzung externer APIs (z.B. OpenAI), das Feintuning von Grundmodellen oder die Anwendung von Transfer-Learning-Techniken.

8. Modellverwaltung: Zentralisierte Verfolgung und Governance von Modellen, einschließlich Versionierung, Audit Trails und Herkunft für Reproduzierbarkeit und Compliance.

Schlüssel zur Risikominderung: Eingebaute Versionierung, Experimentverfolgung, Zugriffskontrollen und Audit Trails reduzieren das Risiko von nicht autorisierten Modelländerungen und unterstützen die Nachverfolgbarkeit über Modelliterationen hinweg.

III. Modell-Deployment und -Serving (Komponenten 9–10)

Diese Komponenten konzentrieren sich auf die sichere Bereitstellung von Modellen für die Produktion und die Unterstützung von AI-Anwendungen.

9. Prompt/RAG (Retrieval Augmented Generation): Ermöglicht einen sicheren, latenzarmen Zugriff auf strukturierte und unstrukturierte Daten für RAG und andere auf Inferenz basierende Anwendungen.

10. Infrastruktur für die Bereitstellung: Umfasst Modellbereitstellung, AI-Gateways und APIs, die Inferenzanfragen und -antworten über AI-Agenten und Anwendungen verarbeiten.

Schlüssel zur Risikominderung: Sichere Modell-Deployment-Praktiken wie Container-Isolation, Anfragenbegrenzung, Eingabevalidierung und Traffic-Monitoring reduzieren die Angriffsfläche und gewährleisten eine konstante Serviceverfügbarkeit.

IV. Betrieb und Plattform (Komponenten 11–12)

Diese Schicht verwaltet die Infrastruktursicherheit, Zugriffskontrolle und Systemzuverlässigkeit in allen Umgebungen.

11. Überwachen: Sammelt kontinuierlich Logs, Metriken und Telemetrie für Modellleistung, Sicherheitsaudits und Systembeobachtbarkeit.

12. Betrieb und Plattform: Unterstützt sicheres CI/CD, Plattform-Patching, Schwachstellenmanagement und strikte Umgebungstrennung (Entwicklung, Staging, Produktion).

Schlüssel zur Risikominderung: Die Aufrechterhaltung der Umgebungsisolation, die regelmäßige Anwendung von Patches, die Durchsetzung der rollenbasierten Zugriffskontrolle und die Überwachung des Systemverhaltens helfen, Sicherheits- und Compliance-Standards während des gesamten AI-Lebenszyklus aufrechtzuerhalten.

Fazit

Diese Architektur bietet einen umfassenden Blick auf sichere, geregelte und produktionsbereite KI-Systeme. Jede Komponente wurde auf Risiken geprüft und Kontrollen sind nativ in die Databricks Data Intelligence Plattform eingebettet. Organisationen können dies als Referenz nutzen, um die Sicherheitsbewertung und Implementierung ihrer eigenen KI-Systeme zu beschleunigen.