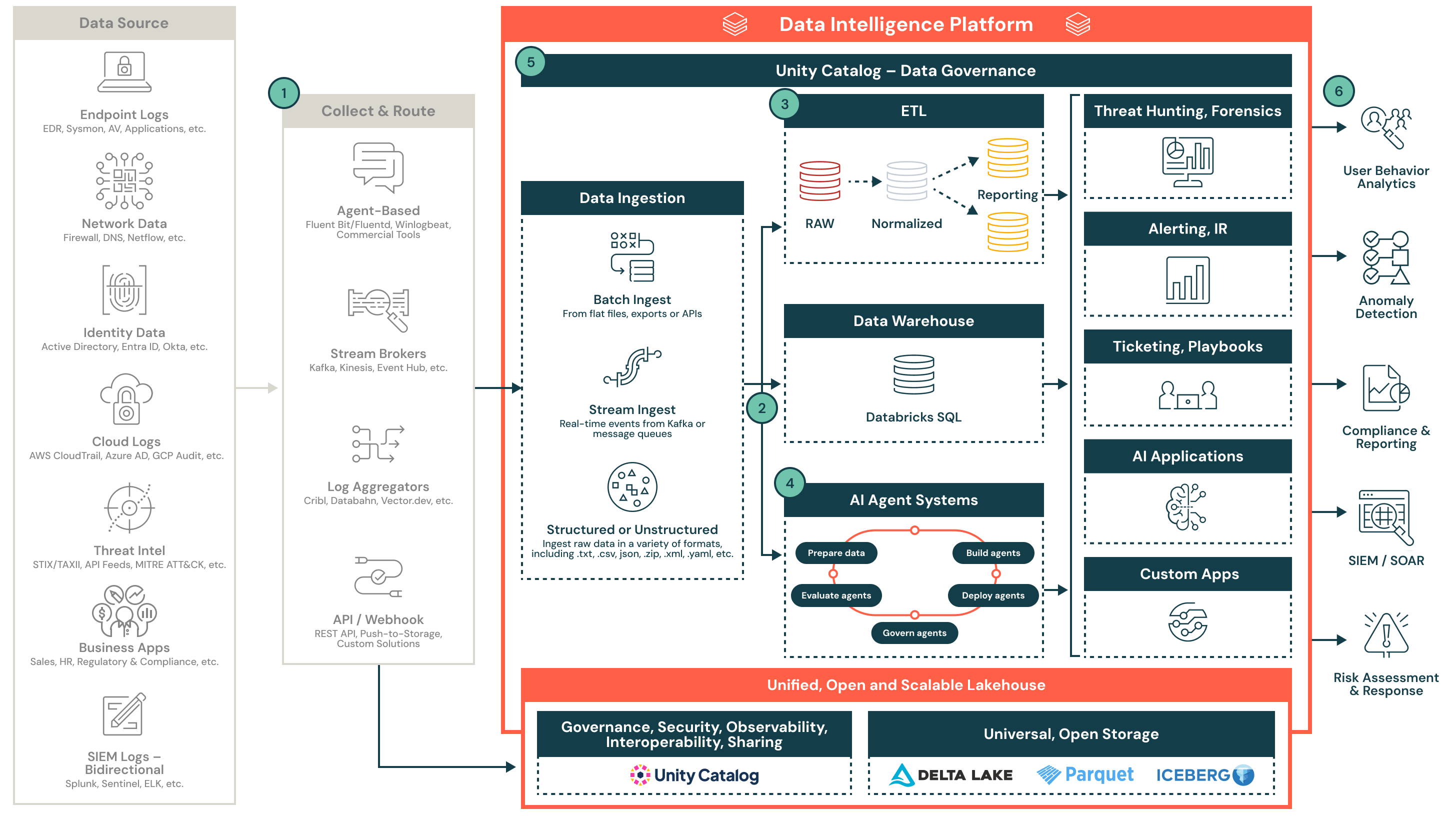

Referenzarchitektur für ein Security Lakehouse

Diese Architektur zeigt, wie man Sicherheitsdaten zentralisieren und die Erkennung, Reaktion und Berichterstattung mit dem Databricks Lakehouse-Ökosystem operationalisieren kann.

Sicherheitstelemetrie im großen Maßstab mit dem Databricks Lakehouse operationalisieren

Diese Referenzarchitektur zeigt, wie Sicherheitsteams diverse Telemetrie im großen Maßstab sammeln, normalisieren und operationalisieren können, indem sie das Databricks Lakehouse verwenden. Sie unterstützt Echtzeitanalysen, Erkennungsengineering, Compliance-Berichterstattung und Integration mit nachgelagerten SOC-Tools.

Übersicht über die Architektur

Sicherheitstelemetrie ist komplex, hat ein hohes Volumen und stammt aus vielen Systemen. Alte Architekturen kämpfen oft mit Kosten, Aufbewahrung und Quer-Korrelation. Das Databricks-Security-Lakehouse hilft Sicherheitsteams, diese Daten zu zentralisieren und zu operationalisieren, indem offene Formate, geregelte Pipelines und eine flexible Rechenengine verwendet werden.

Diese Architektur skizziert ein modulares, Cloud-natives Design zur Erfassung von strukturierten und unstrukturierten Sicherheitsdaten von Endpunkten, Identitätssystemen, Cloud-Anbietern, Bedrohungsfeeds, SIEMs und Geschäftsanwendungen. Sobald diese Daten aufgenommen und normalisiert sind, treiben sie nachgelagerte Anwendungsfälle an, einschließlich Bedrohungserkennung, Triage, KI-gesteuerte Untersuchung und Berichterstattung.

1. Sammeln und weiterleiten

Sicherheitsdaten werden aus mehreren Quellen gesammelt, einschließlich Endpunkten, Cloud-Plattformen, Identitätssystemen und Bedrohungsfeeds. Die Daten werden über agentenbasierte Sammler, Stream-Broker, Log-Aggregatoren oder direkte APIs weitergeleitet. Diese Tools unterstützen sowohl strukturierte als auch unstrukturierte Formate und können in Echtzeit oder in Chargen arbeiten.

Beispiele hierfür sind:

- Fluentd, Vector oder kommerzielle Log-Versender

- Kafka, Event Hub oder Kinesis

- Cribl, Databahn oder Webhook-basierte Pipelines

2. Erfassen und landen

Daten gelangen über strukturierte Batch-Erfassung oder Echtzeit-Streaming in das Lakehouse. Erfasste Daten werden in Delta Lake Bronze-Tabellen geschrieben, um Genauigkeit und Nachverfolgbarkeit zu gewährleisten. Der Unity-Katalog stellt sicher, dass die Daten von Anfang an verwaltet und auffindbar sind.

Hauptmerkmale beinhalten:

- Unterstützung für flache Dateien, JSON, CSV und verschachtelte Formate

- Stream-Erfassung von Kafka oder anderen Brokern

- Governance und Auffindbarkeit durch Unity Catalog

3. Normalisieren und transformieren

Rohdaten werden geparst, abgeflacht und in strukturierte Formate für Analyse und Erkennung angereichert. Diese Phase verwendet die Medaillon-Architektur (Bronze, Silber, Gold), um wiederverwendbare, abfragbare Tabellen zu erstellen, die das Erkennungsengineering und die Berichterstattung unterstützen.

Aufgaben zur Normalisierung beinhalten:

- Schema-Abgleich (z.B., OCSF oder benutzerdefinierte Modelle)

- Anreicherung mit Metadaten oder Bedrohungs-Intel

- Deduplizierung, Parsing und Zeitstempel-Abgleich

4. KI und erweiterte Analysen ermöglichen

Normalisierte Daten speisen native Databricks KI-Agenten-Frameworks, die Sicherheitsanwendungsfälle unterstützen. Diese Agenten können Anomalien erkennen, Alarme priorisieren und investigative Workflows automatisieren. Die Plattform unterstützt das Lebenszyklusmanagement von Agenten von der Entwicklung bis zur Produktion.

Fähigkeiten beinhalten:

- Vorbereitung der Daten für Training und Inferenz

- Bereitstellung und Verwaltung von Erkennungsagenten

- Bewertung und Evaluierung der Modellleistung in der Produktion

5. Sicherheitsoperationen ermöglichen

Das Lakehouse ermöglicht Kernfunktionen des SOC wie Threat Hunting, Alarmierung, Incident Response und Automatisierung. Strukturierte Ausgaben speisen Dashboards, Tickets, SOAR-Workflows und nachgelagerte Systeme.

Ergebnisse beinhalten:

- Schnellere Untersuchungen und reduzierte Alarmmüdigkeit

- Vereinheitlichte Ansicht der Telemetrie über Quellen hinweg

- Verbesserte Zusammenarbeit durch Notebooks und SQL

6. Sicherheitsergebnisse liefern

Kuratierte Einblicke fließen zu den Tools und Teams, die sie benötigen. Datenprodukte unterstützen Compliance, Berichterstattung, Analyse des Benutzerverhaltens, Anomalieerkennung und Risikobewertung. Das SIEM wird zu einem nachgelagerten Verbraucher von verfeinerten Alarmen und Kontexten.

Beispiele für nachgelagerten Verbrauch:

- Compliance-Berichts-Dashboards

- UEBA und Anomalieerkennungspipelines

- SIEM-Anreicherung und SOAR-Playbooks