Une ingestion de données efficace dans votre lakehouse

Faites le premier pas pour débloquer l'innovation avec l'intelligence des données.

Débloquez la valeur de vos données en quelques étapes simples

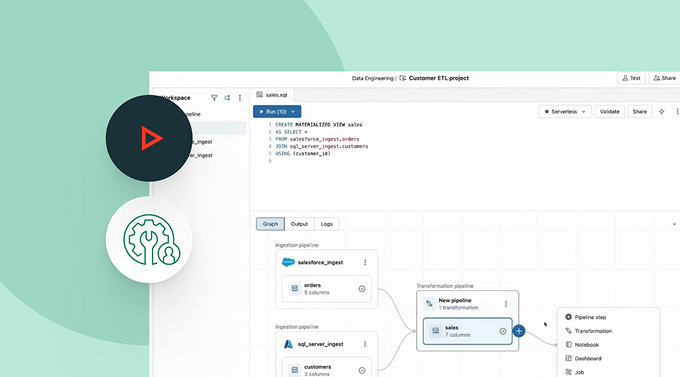

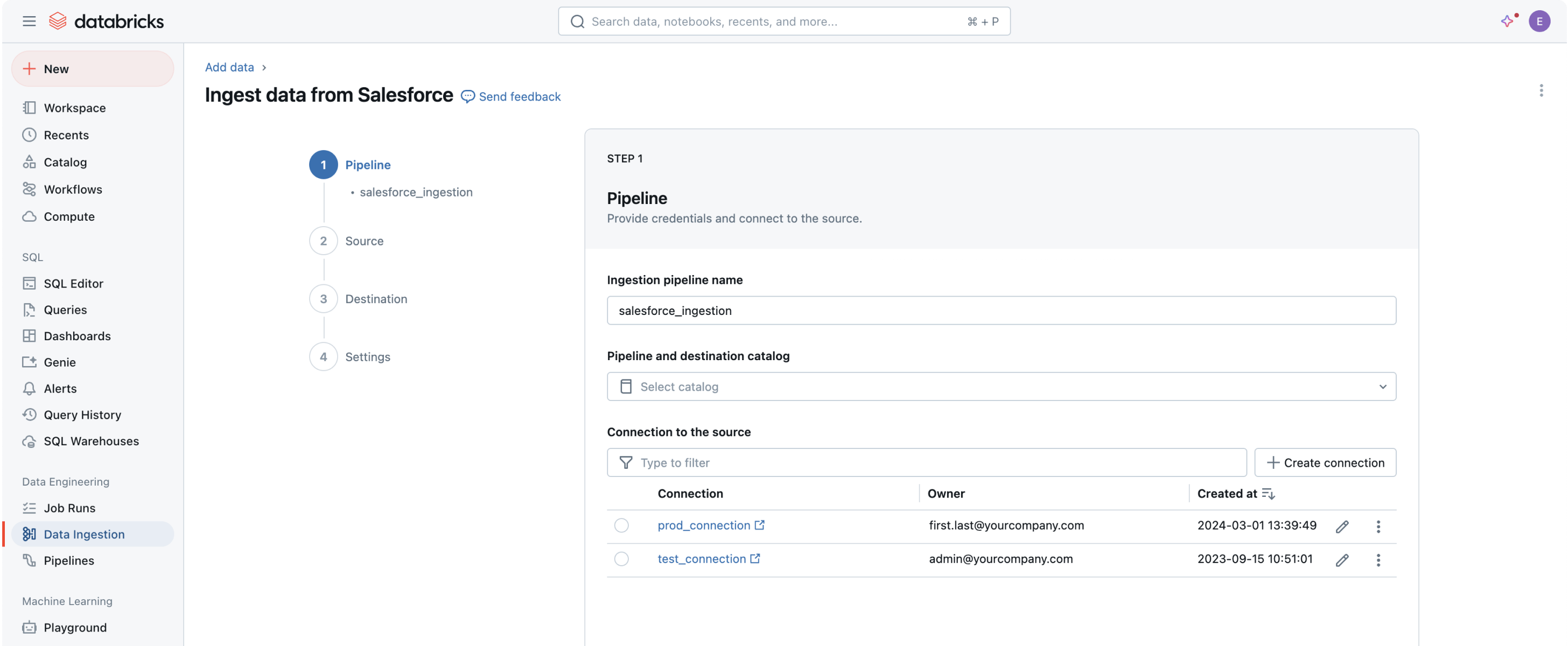

Des connecteurs de données intégrés sont disponibles pour les applications d'entreprise populaires, les sources de fichiers et les bases de données.Capacités d'ingestion robustes pour les sources de données populaires

Rassembler toutes vos données dans la Plateforme d'Intelligence de Données est la première étape pour extraire de la valeur et aider à résoudre les problèmes de données les plus difficiles de votre organisation.L'interface utilisateur sans code (UI) ou une API simple permet aux professionnels de la data de s'autonomiser, économisant des heures de programmation.

L'ingestion de données avec Databricks

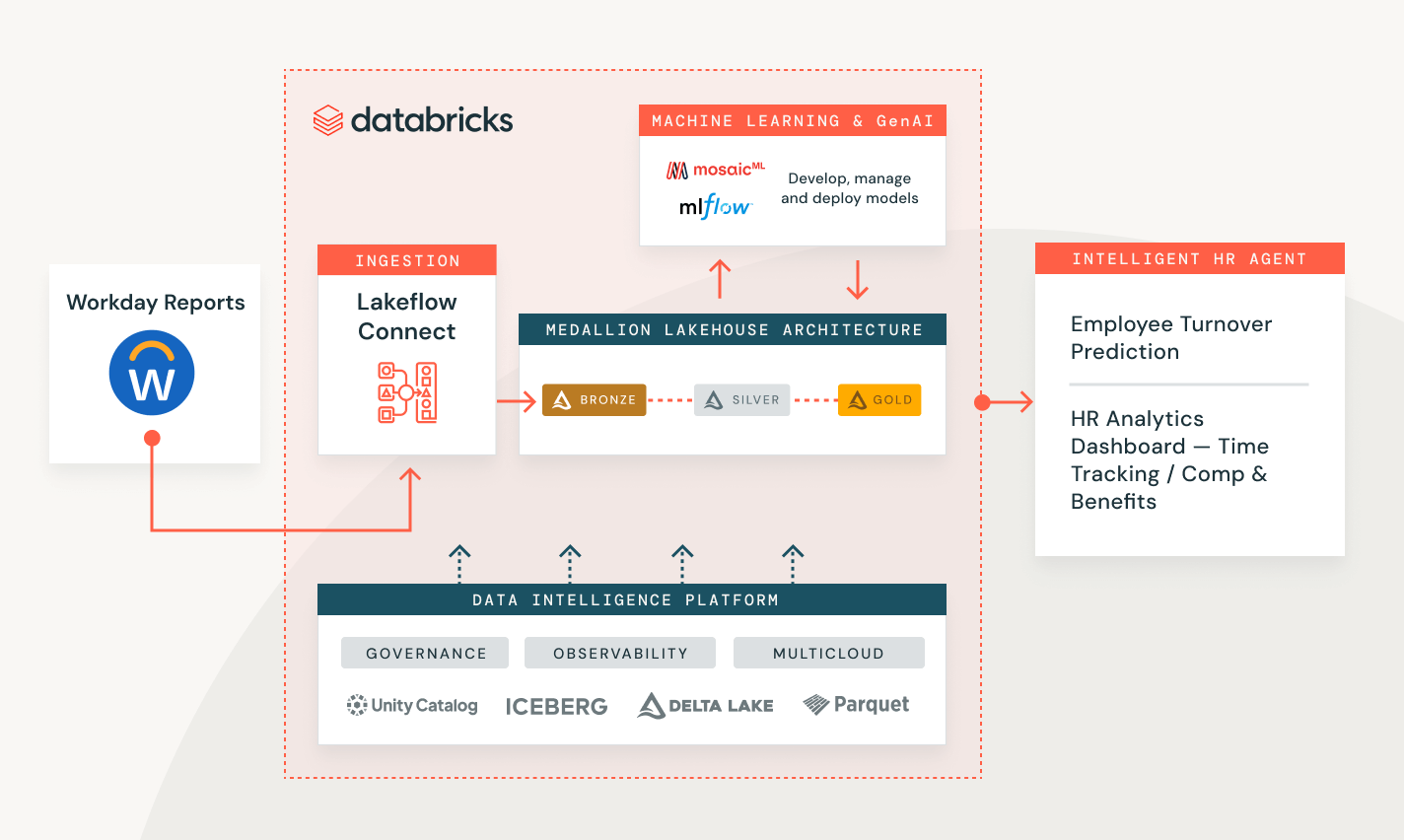

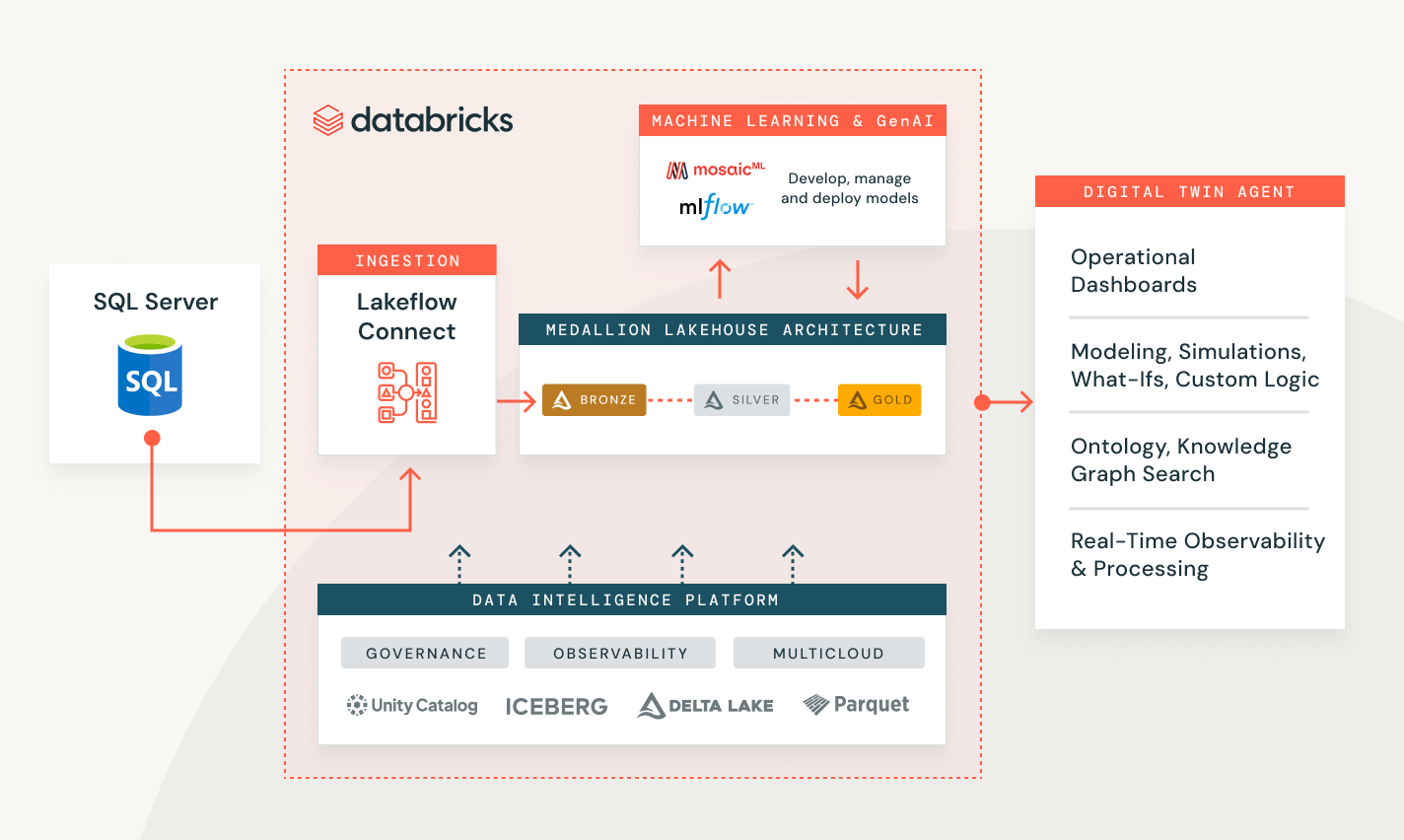

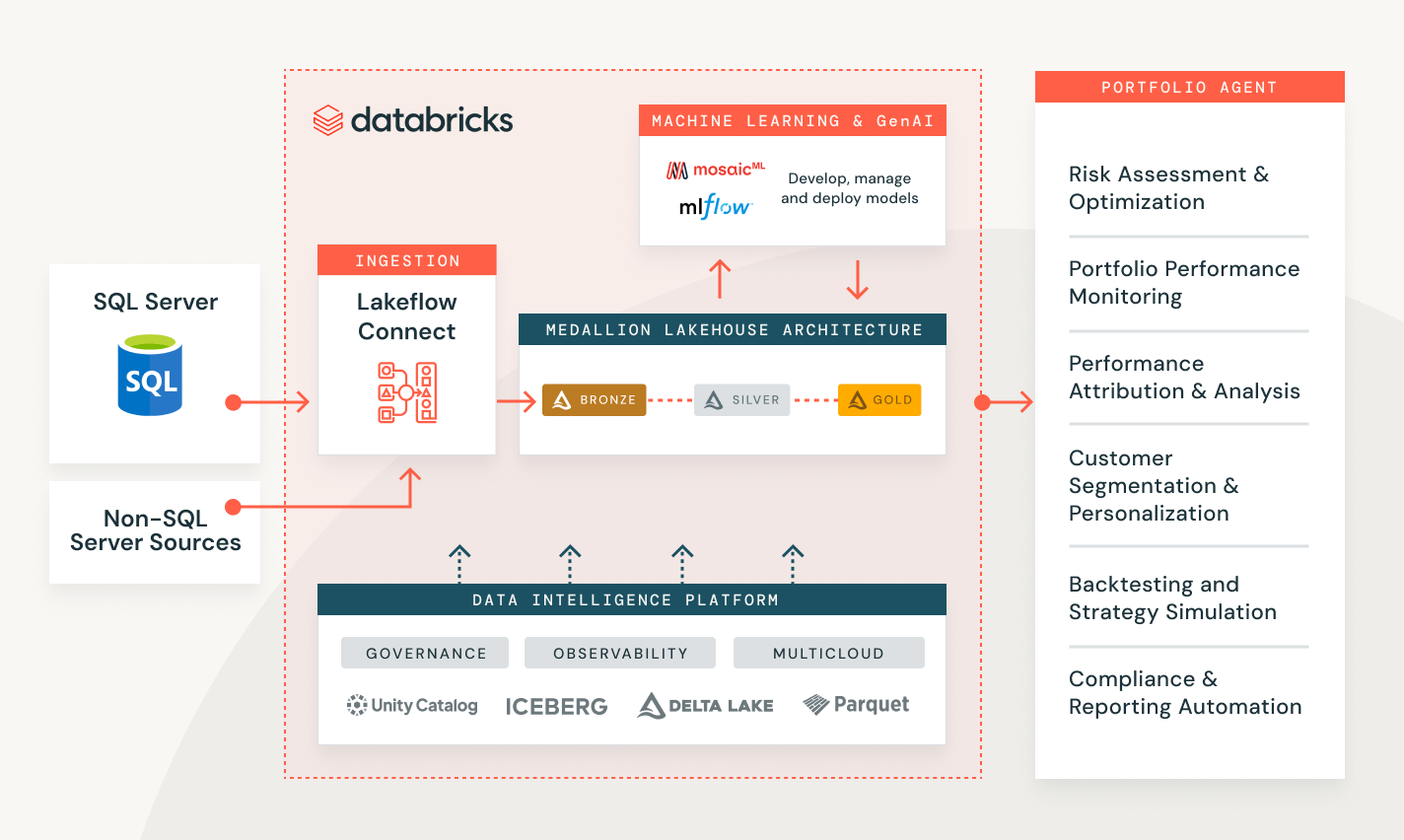

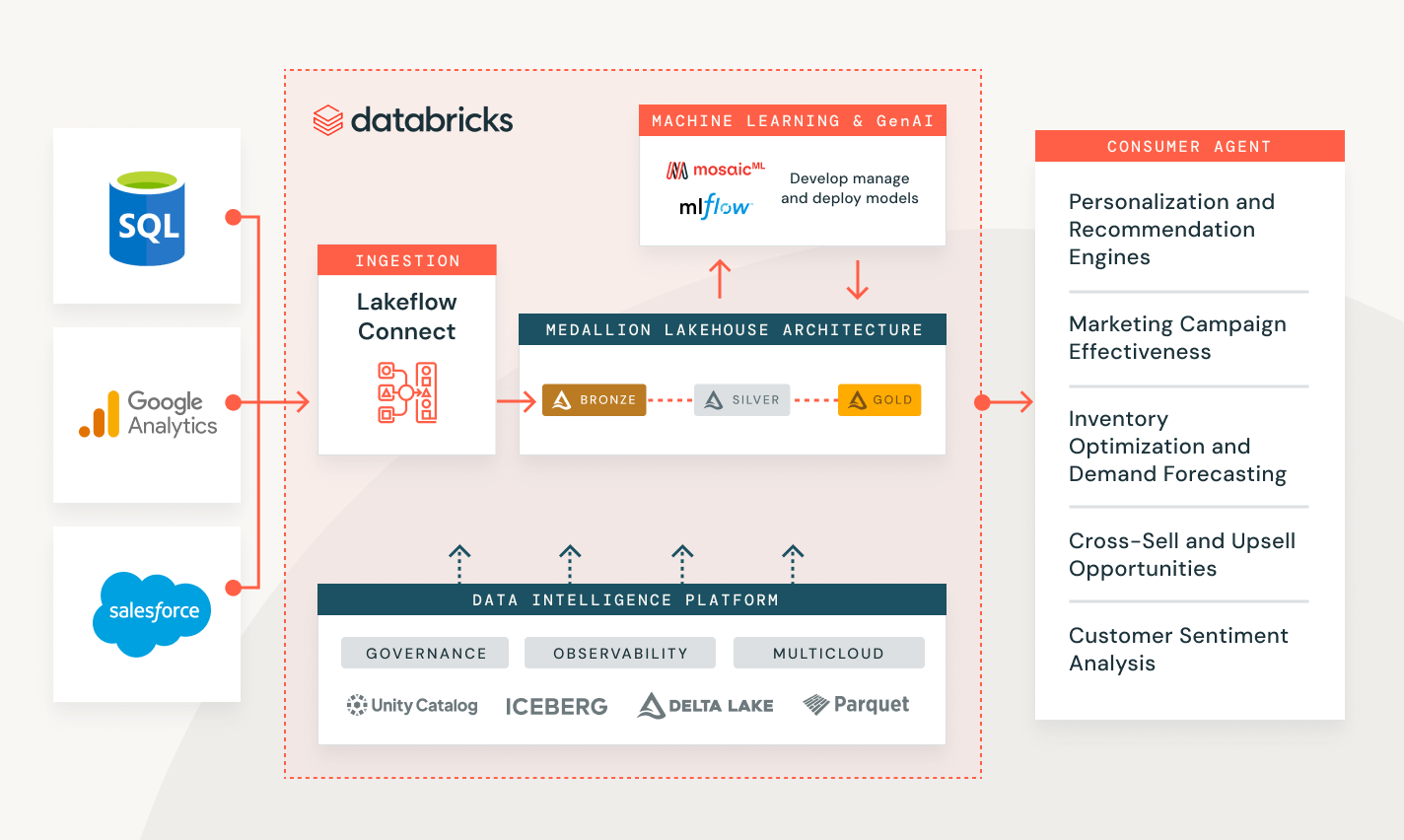

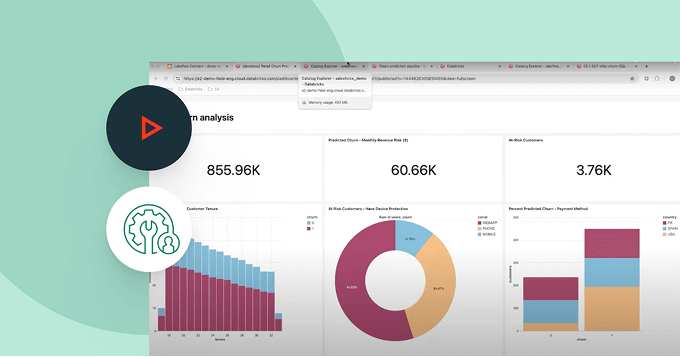

Résoudre les problèmes des clients dans une variété d'industries

Mesurez la performance des campagnes et le scoring des prospects clients

Créez une solution de bout en bout pour transformer, sécuriser et analyser vos données clients et aider à prédire le comportement futur.

Explorez les démonstrations d'ingestion de données

Les tarifs basés sur l'utilisation permettent de maîtriser les dépenses

Ne payez que les produits que vous utilisez, à la seconde près.En savoir plus

Explorez d'autres offres intelligentes et intégrées sur la Data Intelligence Platform.Tâches Lakeflow

Donnez aux équipes les moyens de mieux automatiser et orchestrer tous les workflows d'ETL, d'analytique et d'IA grâce à une observabilité approfondie, une haute fiabilité et la prise en charge d'un large éventail de tâches.

Spark Declarative Pipelines

Simplifiez l'ETL par batch et en streaming grâce à la qualité de données automatisée, la change data capture (CDC), l'acquisition et la transformation des données, ainsi que la gouvernance unifiée.

Unity Catalog

Encadrez sans problème tous vos assets de données avec la seule solution de gouvernance unifiée et ouverte de l'industrie pour les données et l'IA, intégrée à la Databricks Data Intelligence Platform

Delta Lake

Unifiez les données du lakehouse, quels que soient leur format et leur type, pour les mettre à disposition de toutes vos charges d'analytique et d'IA.

Démarrer

Explorez les documents sur l'ingestion de données

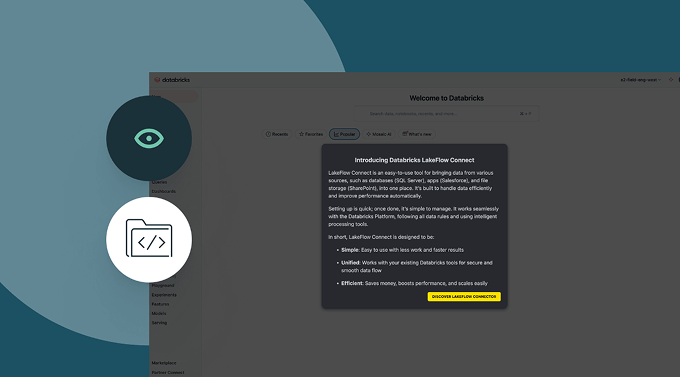

Ingérez des données de diverses sources, à travers les nuages et via Lakeflow Connect.

Visite Lakeflow Connect

Lakeflow Connect est désormais généralement disponible pour Salesforce, Workday et SQL Server.

Pour un accès en avant-première à d'autres connecteurs, veuillez contacter votre équipe de compte Databricks.

FAQ sur l'ingestion de données

Prêts à devenir une entreprise axée sur les données et l'IA ?

Faites le premier pas de votre transformation data