Un framework pratico per la governance dell'AI per le aziende

Una guida completa per l'implementazione di strumenti e programmi di governance dell'AI in modo responsabile ed efficace

Summary

- Per le organizzazioni che desiderano sviluppare e documentare una governance dell'AI rigorosa, abbiamo sviluppato un framework di governance dell'AI che delinea un approccio strutturato allo sviluppo responsabile dell'AI.

- Le best practice di governance dell'AI, tra cui la gestione del rischio, la conformità legale, la supervisione etica e il monitoraggio operativo, sono fondamentali per supportare sistemi di AI trasparenti e responsabili.

- Il framework di governance dell'IA ha lo scopo di aiutare le aziende a scalare i programmi di IA, gestendo al contempo le aspettative normative, riducendo il rischio e mantenendo la fiducia degli stakeholder.

Man mano che le organizzazioni adottano l'AI su vasta scala, cresce la necessità di una governance formale. Le imprese devono allineare lo sviluppo dell'AI con gli obiettivi di business, soddisfare gli obblighi legali e tenere conto dei rischi etici.

Abbiamo introdotto il Databricks AI Governance Framework per fornire un approccio strutturato e pratico alla governance dell'adozione dell'AI in tutta l'impresa. Questo framework è progettato per supportare lo sviluppo, l'implementazione e il miglioramento continuo dei programmi di governance dell'AI.

Introduzione alla governance dell'AI

Il termine "governance dell'IA" si riferisce al tipo di strutture, processi e supervisione che i sistemi di IA richiedono per essere sviluppati e implementati in modo responsabile all'interno di un'azienda. Man mano che le organizzazioni scalano l'IA generativa, la governance diventa un principio fondamentale per questioni quali l'allineamento delle iniziative di IA con gli obiettivi aziendali, la gestione degli obblighi etici e normativi e la conferma che i modelli si comportino in modo coerente e prevedibile durante la fase di produzione.

Inoltre, la governance dell'IA ha un impatto significativo sul ROI dell'IA. Senza una titolarità chiara, policy e controlli del rischio, i programmi di IA possono spesso subire rallentamenti, incorrere in incidenti di sicurezza evitabili o non riuscire del tutto a guadagnarsi la fiducia degli stakeholder. Una ricerca di settore mostra che le sfide legate alla governance costituiscono una barriera primaria all'adozione su larga scala dell'IA, mentre più della metà dei leader indica una titolarità poco chiara, controlli del rischio inadeguati o una mancanza di conformità come cause principali del fallimento dei progetti di IA. Inoltre, problemi come il bias dei modelli, la fuga di dati e il comportamento non autorizzato dei modelli sono in aumento, rendendo necessarie pratiche di governance più solide. Questi dati evidenziano come la governance sia un prerequisito fondamentale per il valore dell'AI, e non un'attività da considerare in un secondo momento.

È anche importante distinguere la governance dalla sicurezza. Mentre la sicurezza si concentra sulla protezione di dati, modelli e infrastrutture dalle minacce, la governance definisce invece come vengono prese le decisioni sullo sviluppo e l'utilizzo dell'IA.

Ciò include questioni come la definizione della responsabilità, la definizione delle policy, la valutazione dei rischi e la garanzia di attività operative etiche e trasparenti. Insieme, governance e sicurezza costituiscono le fondamenta per un'AI sicura e scalabile. Con il Databricks AI Governance Framework, le aziende ottengono un approccio strutturato per sviluppare queste capacità prima di scalare l'IA su prodotti e flussi di lavoro.

Perché la governance dell'AI non può attendere

Secondo un sondaggio globale del 2024 condotto da Economist Impact su 1.100 dirigenti e ingegneri del settore tecnologico, il 40% degli intervistati riteneva che il programma di governance dell'IA della propria organizzazione fosse insufficiente a garantire la sicurezza e la conformità degli asset e dei casi d'uso di IA. Inoltre, le violazioni della privacy e della sicurezza dei dati erano la principale preoccupazione per il 53% degli architetti aziendali, mentre la sicurezza e la governance sono gli aspetti più difficili dell'ingegneria dei dati per gli ingegneri.

Inoltre, secondo Gartner, la gestione della fiducia, del rischio e della sicurezza di AI è la principale tendenza strategica n. 1 nel 2024 che influenzerà le decisioni aziendali e tecnologiche ed entro il 2026 i modelli di AI delle organizzazioni che rendono operative la trasparenza, la fiducia e la sicurezza di AI otterranno un aumento del 50% in termini di adozione, obiettivi aziendali e accettazione da parte degli utenti.

È evidente che la mancanza di programmi di governance dell'IA a livello aziendale sta rapidamente diventando un ostacolo chiave alla realizzazione del ritorno sul valore degli investimenti nell'IA e all'adozione dell'IA nel suo complesso.

Abbiamo quindi sviluppato un framework di orientamento completo che le aziende possono sfruttare per creare programmi efficaci di governance dell'IA.

Un approccio strutturato alla governance dell'IA

Le best practice per l'implementazione della governance dell'AI richiedono una metodologia strutturata e ripetibile che allinei persone, processi e tecnologia in tutta l'organizzazione. Il framework di governance di Databricks AI sviluppa un approccio olistico che inizia con la definizione di obiettivi aziendali chiari, la definizione della proprietà e la creazione di modelli di governance che si integrano perfettamente con le strutture aziendali esistenti. I programmi di governance hanno successo quando vengono trattati come estensioni delle strategie organizzative, delle pratiche di rischio e dei processi di gestione dei dati esistenti.

Un aspetto chiave di questo approccio consiste nell'integrare le responsabilità di governance in tutti i team, anziché centralizzarle in un unico gruppo. I leader aziendali definiscono la direzione strategica articolando gli obiettivi dell'IA, definendo livelli di rischio accettabili e garantendo l'allineamento con le priorità aziendali.

Team come data ingegneria, data science e ML ingegneria rendono operative queste direttive implementando standard per la qualità dei dati, la documentazione dei modelli, il lineage, la riproducibilità e i controlli degli accessi. I team legali, di conformità e di sicurezza svolgono un ruolo aggiuntivo e parallelo per garantire la conformità normativa, l'aderenza alle policy e la protezione degli asset di dati e modelli durante l'intero ciclo di vita.

L'integrazione della governance con i sistemi operativi offre coerenza e scalabilità. Ad esempio, le soluzioni di governance dei dati unificate come Unity Catalog possono standardizzare le policy di accesso, applicare il lineage e centralizzare i metadati per la valutazione del rischio e l'auditabilità. Allo stesso tempo, solide pratiche di data engineering garantiscono che i programmi di IA siano costruiti su fondamenta di dati affidabili e ben governate, con pipeline riproducibili e trasformazioni trasparenti che possono essere monitorate nel tempo.

Una governance dell'AI efficace non è un'attività da svolgere una tantum. Sono necessari processi di monitoraggio e valutazione continui per monitorare le prestazioni dei modelli, valutare il data drift, rilevare i bias, confermare la conformità alle policy e identificare i rischi emergenti. Questo ciclo di feedback continuo garantisce che i modelli rimangano allineati con le aspettative aziendali e i requisiti normativi con l'evolversi delle condizioni. Le revisioni regolari da parte di team interfunzionali aiutano anche le organizzazioni a modificare in modo proattivo le policy, riaddestrare i modelli e perfezionare i processi di governance.

Adottando un approccio strutturato, collaborativo e orientato al ciclo di vita, le organizzazioni possono creare programmi di governance che possono scalare in modo affidabile, ridurre i rischi e accelerare l'adozione sicura dell'AI in tutta l'azienda.

I cinque pilastri fondamentali per la governance dell'IA

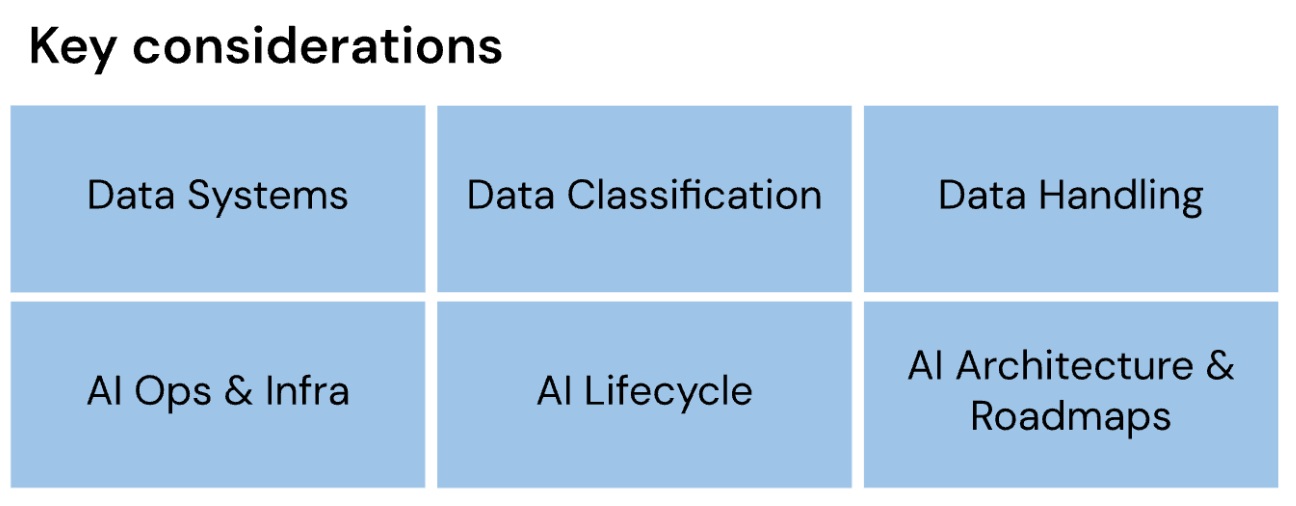

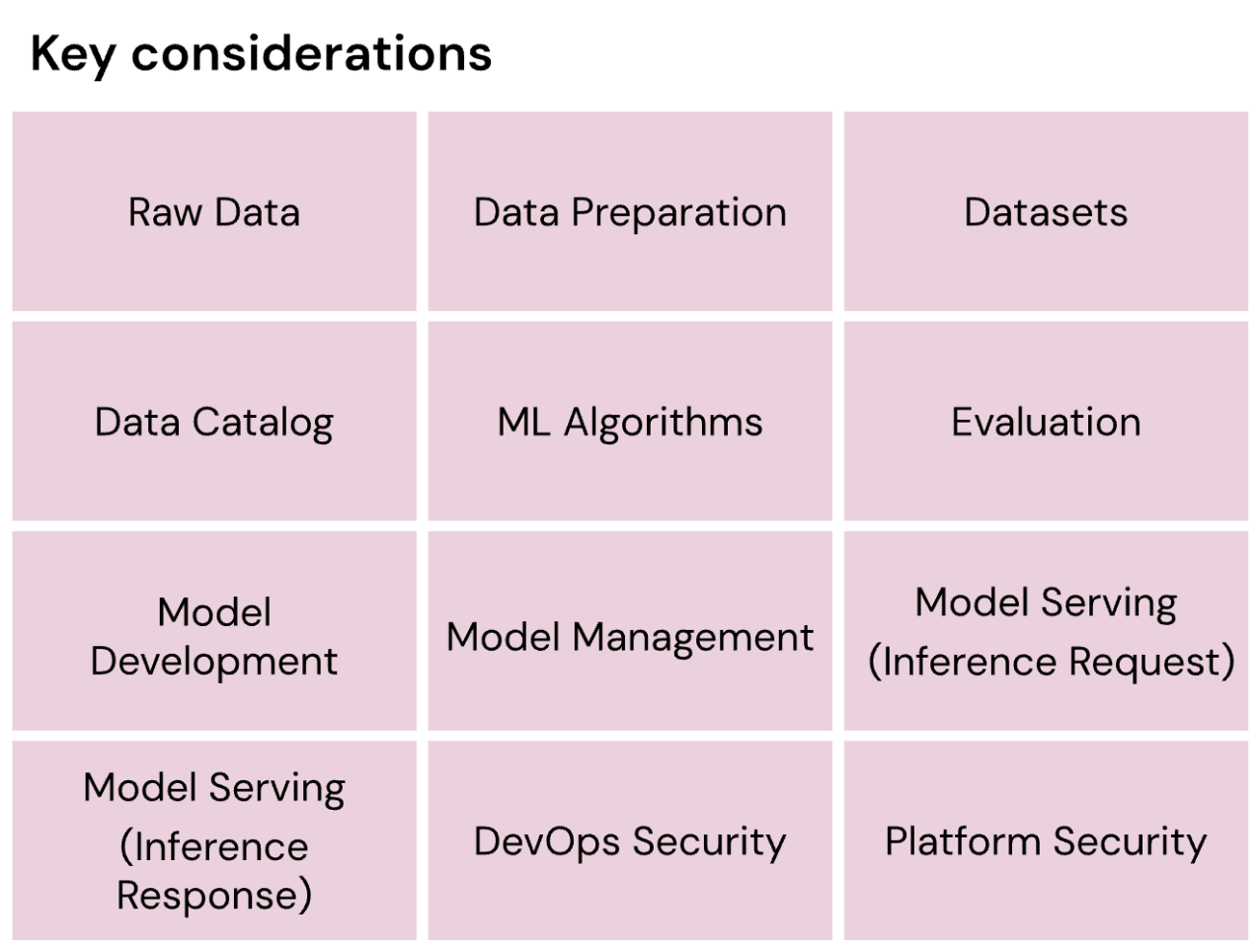

In questo framework, introduciamo 43 considerazioni chiave che sono essenziali per ogni impresa da comprendere (e da implementare secondo necessità) per governare efficacemente i loro percorsi di AI.

Le considerazioni chiave per la governance dell'AI sono raggruppate logicamente in cinque pilastri fondamentali, progettati e sequenziati per rispecchiare le strutture organizzative e le personas aziendali tipiche.

- Organizzazione dell'IA

- Conformità legale e normativa

- Etica, trasparenza e interpretabilità

- Dati, AI ops e infrastruttura

- Sicurezza dell'AI

Gartner®: Databricks leader dei database cloud

Un framework per la governance dell'AI

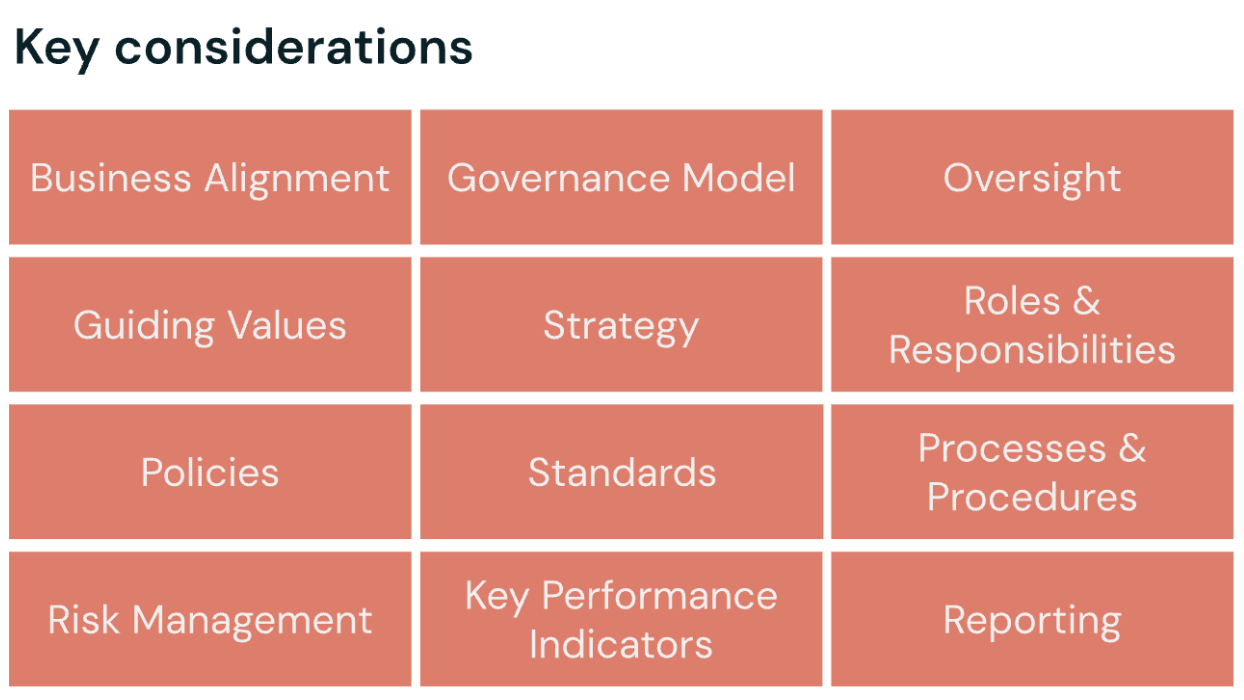

Organizzazione dell'AI

L'organizzazione dell'AI integra la governance dell'AI nella più ampia strategia di governance dell'organizzazione. Sottolinea le fondamenta per un programma di AI efficace attraverso best practice come obiettivi di business chiaramente definiti e l'integrazione di pratiche di governance appropriate che supervisionano persone, processi, tecnologia e dati dell'organizzazione. Spiega come le organizzazioni possono stabilire la supervisione necessaria per raggiungere i loro obiettivi strategici, riducendo al contempo il rischio.

Considerazioni chiave per un'organizzazione efficace di governance dell'AI

- Allineamento aziendale

- Modello di governance

- Supervisione

- Valori guida

- Strategia

- Ruoli & responsabilità

- Criteri

- Standard

- Processi & procedure

- Gestione del rischio

- Indicatori chiave di prestazione

- Reportistica

Scarica il framework di governance dell'IA per scoprire i passaggi per iniziare.

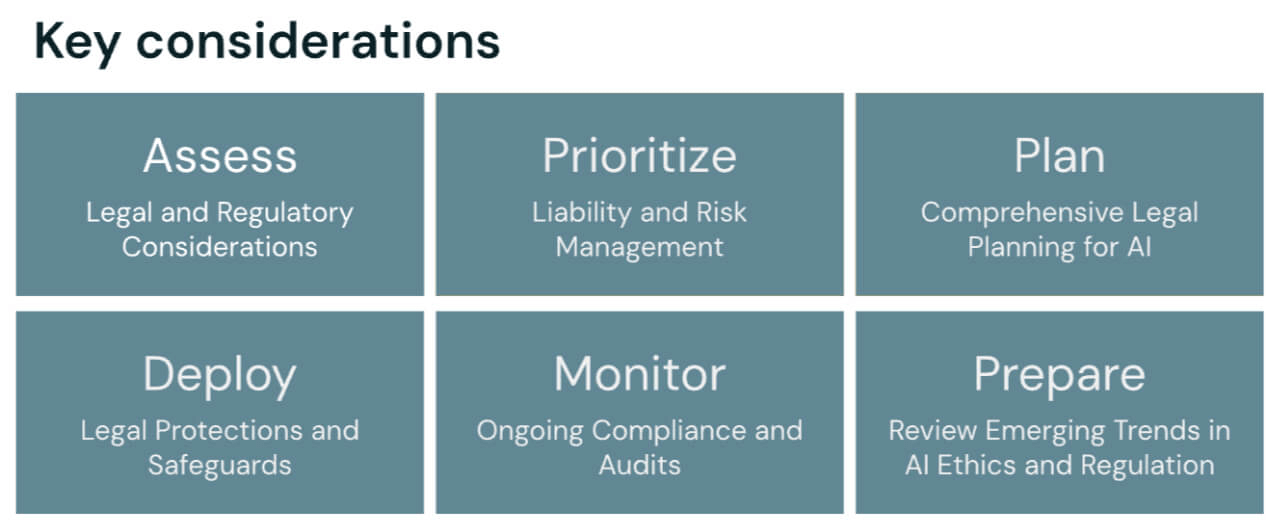

Conformità legale e normativa delle iniziative di AI

Il pilastro della conformità legale e normativa aiuta le organizzazioni ad allineare le iniziative di IA con le leggi e i regolamenti applicabili. Guida nella gestione dei rischi legali, nell'interpretazione dei requisiti specifici del settore e nell'adattamento delle strategie di conformità in risposta ai panorami normativi in evoluzione. Il risultato è che i programmi di AI vengono sviluppati e implementati all'interno di un solido quadro giuridico e normativo.

Passaggi per allineare le iniziative di AI a leggi e normative

- Valutare le considerazioni legali e normative

- Dare priorità alla gestione della responsabilità e del rischio

- Pianificare una revisione legale completa

- Implementare tutele e protezioni legali

- Monitorare la conformità continua e condurre verifiche regolari

- Analizzare le tendenze emergenti nell'etica e nella regolamentazione dell'IA

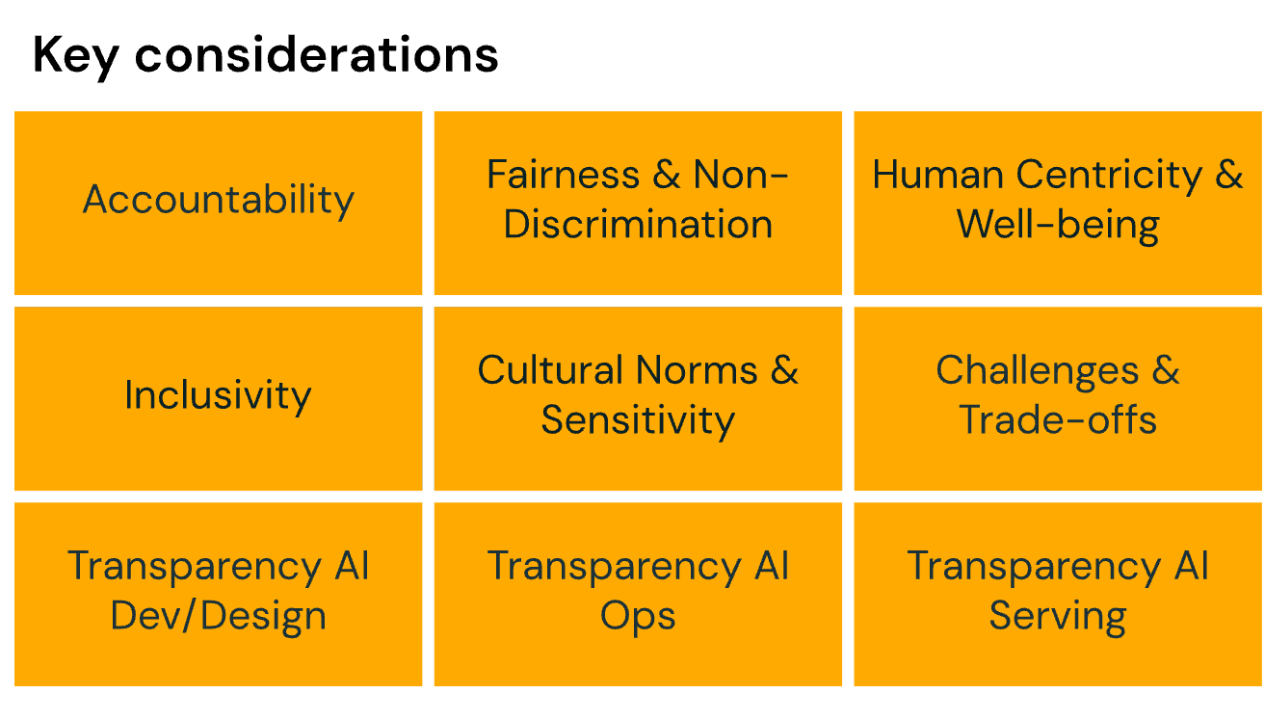

Etica, trasparenza e interpretabilità dei programmi di IA

Nelle organizzazioni che creano sistemi di IA affidabili e responsabili, è importante aderire a principi etici come l'equità, la responsabilità e la supervisione umana, promuovendo al contempo la spiegabilità e il coinvolgimento degli stakeholder. Questo pilastro del framework di governance dell'IA fornisce metodi per stabilire la responsabilità e la struttura all'interno dei team organizzativi, contribuendo a garantire che le decisioni dell'IA siano interpretabili, allineate con gli standard etici in evoluzione e promuovendo la fiducia a lungo termine e l'accettazione da parte della società.

Quando si progettano programmi di IA e si implementano strumenti di governance dell'IA, considerare come affrontare:

- Responsabilità

- Equità e non discriminazione

- Centralità umana e benessere

- Inclusività

- Norme e sensibilità culturali

- Sfide e compromessi di tutto quanto sopra

- Trasparenza nello sviluppo e nella progettazione dell'IA

- Trasparenza nelle operazioni di AI

- Trasparenza nel serving dell'AI

Dati, AI Ops e infrastruttura per la governance dell'IA

Il pilastro Dati, AI attività operative (AIOps) e Infrastruttura definisce le fondamenta che supportano le organizzazioni nell'implementare e mantenere pienamente l'IA. Saranno necessarie linee guida per creare un'infrastruttura AI scalabile e affidabile, gestire il ciclo di vita del machine learning e garantire la qualità, la sicurezza e la conformità dei dati. Questo pilastro sottolinea anche le best practice per le attività operative di AI, tra cui l'addestramento, la valutazione, l'implementazione e il monitoraggio dei modelli, in modo che i sistemi di AI siano affidabili, efficienti e allineati con gli obiettivi aziendali.

Pilastro V: Sicurezza dell'AI

Il pilastro della sicurezza dell'IA presenta il Databricks AI Security Framework (DASF), un framework completo per comprendere e mitigare i rischi per la sicurezza lungo tutto il ciclo di vita dell'IA. Copre aree critiche come la protezione dei dati, la gestione dei modelli, l'erogazione sicura dei modelli e l'implementazione di solide misure di cybersecurity per proteggere gli asset di AI.

Correlato: consulta un esempio pratico di come un'organizzazione può sfruttare il framework di governance dell'AI per creare una titolarità e un allineamento chiari durante tutto il ciclo di vita del programma di AI. Guarda questa presentazione tenuta durante il Data + AI Summit 2025.

Framework di governance dell'AI

Il whitepaper Framework di governance dell'IA è disponibile per le organizzazioni che desiderano sviluppare la propria governance dell'IA.

Contattaci via email all'indirizzo [email protected] per qualsiasi domanda o feedback. Se desideri contribuire ai futuri aggiornamenti di questo framework (e di altri prodotti in arrivo) unendoti alla nostra community di revisori, saremmo felici di sentirti!

Principi chiave per una governance efficace dell'AI

La governance dell'IA si basa su una serie coerente di principi fondamentali che operano in ogni fase del ciclo di vita dell'IA. Questi principi assicurano che i sistemi di IA siano sviluppati e implementati in modo responsabile, fornendo al contempo una struttura necessaria affinché le organizzazioni possano soddisfare le aspettative normative, mantenere la fiducia degli stakeholder e mitigare i rischi con l'aumento dell'adozione. Principi come trasparenza, responsabilità, equità e supervisione umana sono al centro di qualsiasi strategia efficace.

La trasparenza inizia con una documentazione chiara e accessibile delle sorgenti di dati, delle ipotesi dei modelli, delle metodologie di addestramento e dei processi di valutazione. Una pratica di trasparenza richiede il tracciamento sistematico del lineage, del controllo delle versioni e dei comportamenti dei modelli, in modo che i team possano tracciare il modo in cui vengono prese le decisioni e identificare i fattori che contribuiscono quando si verificano problemi. Gli strumenti di governance che centralizzano metadati, audit trail e policy di accesso supportano questo lavoro rendendo i dettagli operativi visibili e verificabili tra i vari team.

La governance dell'IA dovrebbe anche dare priorità a misure di responsabilizzazione, in modo che per ogni sistema di IA siano chiaramente definiti i proprietari responsabili dei risultati, della gestione del rischio e dell'aderenza agli standard di governance. Un quadro di responsabilità efficace stabilisce i ruoli tra i gruppi aziendali, tecnici, legali e di conformità, distribuisce i diritti decisionali e crea meccanismi di escalation quando si verificano comportamenti imprevisti del modello o sorgono preoccupazioni di natura etica. Inoltre, la creazione di KPI e soglie di prestazione può fornire ai leader parametri di riferimento misurabili per la valutazione dei sistemi di IA nel tempo.

Un principio di equità richiede l'identificazione e la mitigazione proattiva dei bias durante la raccolta dei dati, l'addestramento dei modelli e il monitoraggio della produzione. Tecniche come l'analisi dell'impatto disparato, le metriche di rilevamento dei bias e le strategie di campionamento rappresentativo possono aiutare i team a capire come gli output dei modelli variano tra i gruppi di utenti. Le valutazioni continue dell'equità consentono alle organizzazioni di identificare drift o disuguaglianze man mano che l'utilizzo nel mondo reale si evolve.

Infine, la supervisione umana aiuta i sistemi di AI ad allinearsi con i valori organizzativi e i requisiti normativi. Questa fase prevede la definizione dei casi in cui è richiesta la revisione umana, la progettazione di procedure di fallback chiare e la garanzia che gli esperti in materia possano intervenire quando gli output dei modelli sono ambigui, ad alto rischio o sensibili. I meccanismi di supervisione dovrebbero essere integrati sia nei flussi di lavoro di sviluppo che nelle attività operative di produzione, in modo che le misure di salvaguardia rimangano attive durante l'intero ciclo di vita dell'IA.

Implementazione di pratiche di AI responsabile

Le pratiche di AI responsabile sono i guardrail che garantiscono che i sistemi di AI siano al servizio di persone, aziende e società in modi sicuri, equi e allineati con i valori organizzativi. L'implementazione di queste pratiche richiede un approccio olistico per l'intero ciclo di vita dell'AI. Dall'approvvigionamento dei dati e lo sviluppo dei modelli alla loro distribuzione, monitoraggio e ritiro finale, ogni fase è un'opportunità per integrare delle misure di protezione. In sintesi, l'obiettivo di qualsiasi pratica di AI responsabile è ridurre i danni, rafforzare la fiducia e migliorare le prestazioni del sistema nel tempo.

Un componente fondamentale dell'IA responsabile è allineare il comportamento del sistema ai valori umani e ai principi organizzativi. Ciò inizia con la definizione dell'uso previsto di un modello, inclusi eventuali scenari sensibili o ad alto impatto, e con la definizione dei requisiti relativi a privacy, equità, sicurezza e spiegabilità. È fondamentale integrare questi criteri sin dalle prime fasi del processo di progettazione, in modo che i team affrontino esplicitamente le considerazioni etiche invece di avere un approccio puramente reattivo. Tecniche specifiche aiutano i sistemi di IA a operare in modo coerente con le aspettative degli utenti e le norme sociali, come strumenti di interpretabilità dei modelli, set di dati di addestramento rappresentativi e processi di revisione human-in-the-loop.

Inoltre, l'identificazione e la mitigazione dei rischi dovrebbero essere integrate direttamente nei flussi di lavoro di sviluppo. Le organizzazioni devono valutare rischi quali bias, drift del modello, allucinazioni, fughe di dati e output non sicuri, e sviluppare strategie di mitigazione per ciascuno di essi. Queste strategie possono includere anche la privacy differenziale, il filtraggio dei prompt e degli output, test avversari e esercizi di red-teaming adattati ai rischi specifici del dominio. Man mano che questi test procedono, i team dovrebbero documentare le valutazioni dei rischi e i controlli al fine di fornire trasparenza e supportare i requisiti di audit normativi e interni.

L'implementazione di pratiche di IA responsabile è un job continuo. Anche i modelli ben governati possono subire un deterioramento quando le distribuzioni dei dati cambiano o emergono nuovi requisiti. I team dovrebbero creare pipeline di monitoraggio automatizzate che li aiutino a monitorare le metriche delle prestazioni, gli indicatori di equità e la conformità alle policy in produzione. Quando si verificano problemi, le procedure di riaddestramento, le revisioni strutturate degli incidenti e la documentazione aggiornata garantiscono che i sistemi di AI si evolvano in modo responsabile.

È importante per qualsiasi team bilanciare l'innovazione con la cautela. I team dovrebbero creare percorsi che consentano la sperimentazione, come ambienti di prova o implementazioni pilota controllate, pur mantenendo dei guardrail che prevengano danni involontari. Questo equilibrio consente alle organizzazioni di esplorare nuove funzionalità di AI generativa rispettando al contempo le aspettative di governance e gli standard etici.

Introduzione all'implementazione di DAGF

L'implementazione del Databricks AI Governance Framework (DAGF) inizia con una roadmap chiara e pratica che guida le organizzazioni dalla pianificazione iniziale alle attività operative su scala aziendale. Il primo passo consiste nello stabilire strutture di governance fondamentali: definire ruoli e responsabilità, documentare i casi d'uso dell'AI e valutare la preparazione dell'organizzazione in termini di qualità dei dati, pratiche di sviluppo dei modelli e requisiti di conformità. Questo allineamento iniziale garantisce che gli sforzi di governance supportino direttamente le priorità aziendali e la tolleranza al rischio.

Un modello di maturità può aiutare le organizzazioni a valutare la loro posizione attuale e a identificare i passi successivi nel loro percorso di governance. Ad esempio, i programmi in fase iniziale si concentrano sulla documentazione degli asset di IA, sulla centralizzazione dei controlli di accesso e sulla definizione di policy di base per l'utilizzo dei dati, lo sviluppo e la revisione dei modelli. Con la maturazione di questo processo, le organizzazioni possono iniziare a introdurre flussi di lavoro standardizzati, lineage e monitoraggio automatizzati e comitati interfunzionali che supervisionano il rischio e la conformità dell'IA. Infine, i programmi completamente maturi rendono operativa la governance durante l'intero ciclo di vita, il che include pipeline riproducibili, valutazione continua dei modelli e processi ben definiti per il retraining, l'auditing e la risposta agli incidenti.

Indipendentemente da quanto attentamente venga implementato un framework di governance, ci sono alcune insidie comuni che le organizzazioni devono affrontare. Ad esempio, molti incontrano difficoltà quando la governance viene trattata come un aspetto secondario o affidata a un singolo team senza una chiara responsabilità. Altre potrebbero sottovalutare il ruolo dei dati di alta qualità e non implementare alcune pratiche fondamentali come applicazione di uno schema, il monitoraggio del lignaggio e l'accesso controllato. Queste lacune possono sembrare di lieve entità in apparenza, ma possono creare sfide a valle in termini di trasparenza, riproducibilità e verificabilità. Stabilire una titolarità condivisa tra i team aziendali, tecnici e di conformità, così come fondare la governance su solide pratiche di data engineering, può aiutare a prevenire questo problema all'interno di un'organizzazione.

Per misurare il successo, le organizzazioni dovrebbero monitorare i progressi e misurare l'impatto degli investimenti nella governance. Le metriche possono includere riduzioni degli incidenti relativi ai modelli e dei rilevamenti di bias, una migliore riproducibilità dei modelli, una maggiore completezza della documentazione, cicli di revisione più brevi, approvazioni più rapide per nuovi casi d'uso dell'IA e una maggiore adozione di pipeline e strumenti standardizzati. Nel tempo, questi indicatori dimostrano come la governance sia una funzione essenziale per l'affidabilità, la conformità e l'efficienza operativa.

L'implementazione della governance dovrebbe essere un approccio graduale che aiuta le organizzazioni ad allinearsi attentamente con le proprie risorse e i propri obiettivi. Molte iniziano con casi d'uso ad alto impatto, applicando i controlli di governance ai modelli più sensibili o critici per il business prima di espandersi a programmi più ampi. Tuttavia, iterare e scalare in modo incrementale può aiutare le organizzazioni a costruire una solida base di governance che supporti un'adozione dell'AI sicura, trasparente e affidabile in tutta l'organizzazione.

Perché Databricks è leader in questo impegno

In qualità di leader del settore dei dati e dell'IA, con oltre 15.000 clienti in diverse aree geografiche e segmenti di mercato, Databricks ha continuato a mantenere il suo impegno nei confronti dei principi di sviluppo responsabile e dell'innovazione open-source. Abbiamo mantenuto questi impegni attraverso:

- Collaborazione con i settori industriali e il governo per promuovere l'innovazione e sostenere l'uso di un'AI sicura e affidabile

- Workshop interattivi per formare le organizzazioni su come guidare con successo il loro percorso nell'AI in modo consapevole dei rischi

- L'open-source di innovazioni chiave per la governance come MLFlow e Unity Catalog, l'unica soluzione unificata del settore per la governance dei dati e dell'IA su cloud, formati di dati e piattaforme di dati.

Questi programmi ci hanno offerto una visibilità unica sui problemi pratici che aziende e autorità di regolamentazione affrontano oggi nella governance dell'IA. Per rafforzare il nostro impegno ad aiutare ogni azienda ad avere successo e ad accelerare il proprio percorso nei dati e nell'IA, abbiamo deciso di sfruttare questa visibilità per creare (e rendere disponibile gratuitamente) un completo, strutturato e attuabile AI Governance Framework.

(Questo post sul blog è stato tradotto utilizzando strumenti basati sull'intelligenza artificiale) Post originale

Non perdere mai un post di Databricks

Cosa succederà adesso?

IA

7 gennaio 2025/8 min di lettura