Integrazione dei dati di SAP e Salesforce per l'analisi dei fornitori su Databricks

Utilizza SAP Business Data Cloud Connect e Lakeflow Connect per unificare i dati CRM ed ERP per le analitiche dei fornitori.

Summary

- Connetti i dati di SAP S/4HANA e Salesforce direttamente in Databricks

- Usa Lakeflow Connect e SAP BDC per un accesso incrementale e senza copie

- Crea un Gold layer governato per le analitiche e le informazioni dettagliate conversazionali

Come creare analitiche dei fornitori con l'integrazione di Salesforce e SAP su Databricks

I dati dei fornitori interessano quasi ogni parte di un'organizzazione — dall'approvvigionamento e gestione della supply chain alla finanza e alle analitiche. Tuttavia, sono spesso distribuiti su sistemi che non comunicano tra loro. Ad esempio, Salesforce contiene profili dei fornitori, contatti e dettagli degli account, mentre SAP S/4HANA gestisce fatture, pagamenti e registrazioni nella contabilità generale. Poiché questi sistemi operano in modo indipendente, i team non hanno una visione completa delle relazioni con i fornitori. Il risultato è una riconciliazione lenta, la duplicazione dei record e la perdita di opportunità per ottimizzare la spesa.

Databricks risolve questo problema collegando entrambi i sistemi su un'unica piattaforma dati & IA governata. Utilizzando Lakeflow Connect per Salesforce per l'ingestione dei dati e SAP Business Data Cloud (BDC) Connect, i team possono unificare i dati CRM ed ERP senza duplicazione. Il risultato è una vista unica e affidabile di fornitori, pagamenti e metriche delle prestazioni che supporta casi d'uso sia per l'approvvigionamento che per la finanza, oltre all'analitica.

In questa guida, imparerai a collegare entrambe le sorgenti di dati, a creare una pipeline combinata e un Gold layer che alimenta analitiche e insight conversazionali tramite le dashboard di IA/BI e Genie.

Perché funziona l'integrazione zero-copy dei dati SAP e Salesforce

La maggior parte delle aziende cerca di connettere SAP e Salesforce tramite ETL tradizionali o strumenti di terze parti. Questi metodi creano più copie dei dati, introducono latenza e rendono difficile la governance. Databricks adotta un approccio diverso.

Accesso zero-copy a SAP: Il connettore SAP BDC per Databricks offre un accesso governato e in tempo reale ai data product di SAP S/4HANA tramite Delta Sharing. Nessuna esportazione o duplicazione.

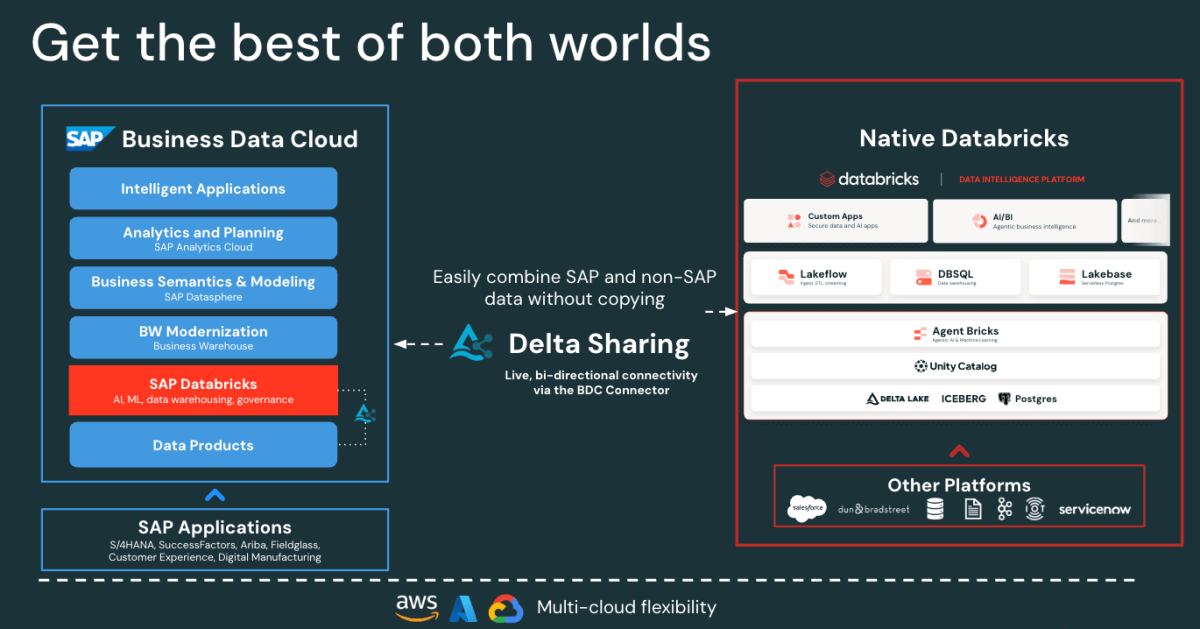

Figure: SAP BDC Connector to Native Databricks(Bi-directional) - Ingestione incrementale rapida di Salesforce: Lakeflow si connette e acquisisce i dati di Salesforce in modo continuo, mantenendo i tuoi set di dati aggiornati e coerenti.

- Governance unificata: Unity Catalog applica autorizzazioni, lineage e auditing su entrambe le origini SAP e Salesforce.

- Pipeline dichiarative: Lakeflow Spark Declarative Pipelines semplifica la progettazione e l'orchestrazione ETL con ottimizzazioni automatiche per prestazioni migliori.

Insieme, queste funzionalità consentono ai data engineer di unire i dati di SAP e Salesforce su un'unica piattaforma, riducendo la complessità e mantenendo al contempo una governance di livello enterprise.

Gartner®: Databricks leader dei database cloud

Architettura di integrazione dei dati di SAP e Salesforce su Databricks

Prima di creare la pipeline, è utile capire come questi componenti si integrano in Databricks.

A livello generale, SAP S/4HANA pubblica dati aziendali come data prodotto curati, pronti per l'uso e gestiti da SAP in SAP Business Data cloud (BDC). SAP BDC Connect for Databricks consente un accesso sicuro e zero-copy a tali prodotti di dati tramite Delta Sharing. Nel frattempo, Lakeflow Connect gestisce l'ingestion di Salesforce, acquisendo dati su account, contatti e opportunità attraverso pipeline incrementali.

Tutti i dati in entrata, provenienti da SAP o Salesforce, sono governati in Unity Catalog per la governance, la derivazione e le autorizzazioni. I data engineer utilizzano quindi Lakeflow Declarative Pipelines per unire e trasformare questi set di dati in un'architettura medallion (livelli bronzo, argento e Gold). Infine, il livello Gold funge da base per l'analisi e l'esplorazione nelle dashboard di AI/BI e in Genie.

Questa architettura garantisce che i dati di entrambi i sistemi rimangano sincronizzati, governati e pronti per le analitiche e l'IA, senza l'onere della replica o di strumenti ETL esterni.

Come creare delle analitiche unificate dei fornitori

I seguenti passaggi descrivono come connettere, unire e analizzare i dati di SAP e Salesforce su Databricks.

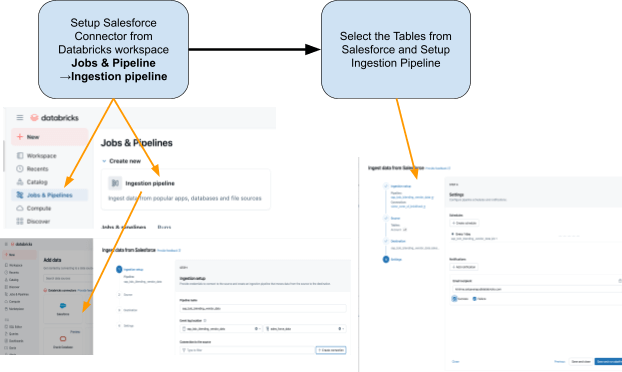

Passaggio 1: ingestione di dati Salesforce con Lakeflow Connect

Utilizza Lakeflow Connect per importare i dati di Salesforce in Databricks. È possibile configurare le pipeline tramite l'interfaccia utente o l'API. Queste pipeline gestiscono automaticamente gli aggiornamenti incrementali, garantendo che i dati rimangano aggiornati senza refresh manuali.

Il connettore è completamente integrato con la governance di Unity Catalog, le pipeline dichiarative Spark di Lakeflow per l'ETL e i processi di Lakeflow per l'orchestrazione.

Queste sono le tabelle che intendiamo acquisire da Salesforce:

- Account: dettagli del fornitore/venditore (i campi includono: AccountId, Name, Industry, Type, BillingAddress)

- Contatto: Contatti fornitore (i campi includono: ContactId, AccountId, FirstName, LastName, Email)

Passaggio 2: Accedi ai dati di SAP S/4HANA con il connettore SAP BDC

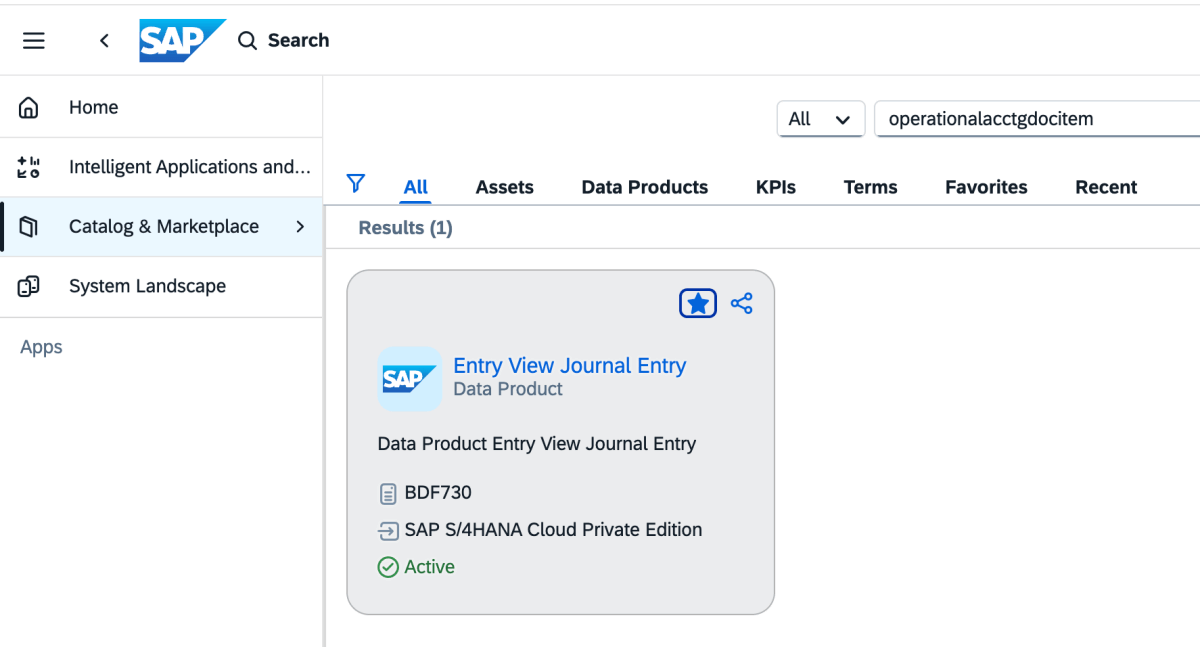

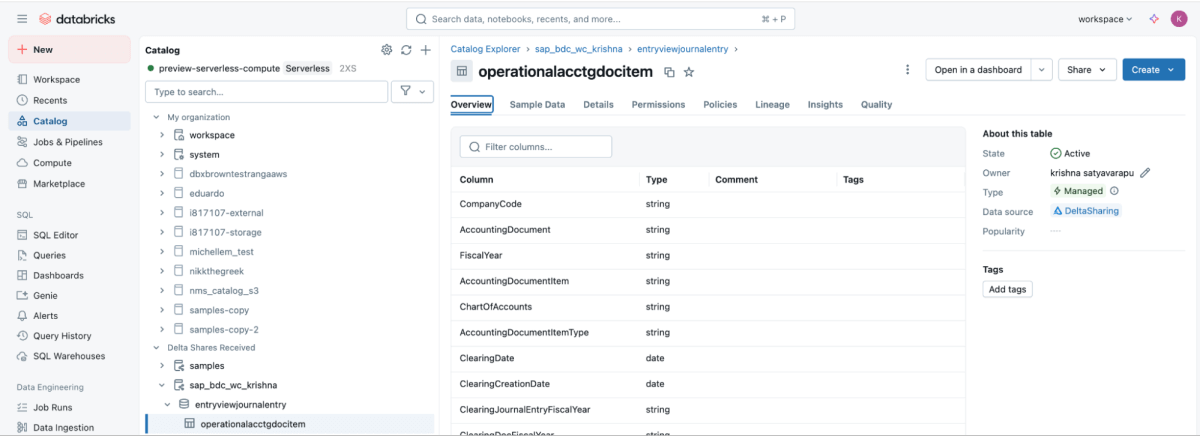

SAP BDC Connect fornisce accesso live e governato ai dati sui pagamenti dei fornitori di SAP S/4HANA direttamente in Databricks, eliminando l'ETL tradizionale e sfruttando il prodotto dati SAP BDC sap_bdc_working_capital.entryviewjournalentry.operationalacctgdocitem, ovvero la vista delle voci del giornale universale (Universal Journal).

Questo data product BDC corrisponde direttamente alla vista CDS di SAP S/4HANA I_JournalEntryItem (Voce del documento contabile operativo) su ACDOCA.

Nel contesto ECC, le strutture fisiche più vicine erano BSEG (voci FI) con intestazioni in BKPF, registrazioni CO in COEP, e indici aperti/compensati BSIK/BSAK (fornitori) e BSID/BSAD (clienti). In SAP S/4HANA, questi oggetti BS** fanno parte del modello di dati semplificato, in cui le voci relative a fornitori e contabilità generale (G/L) sono centralizzate nell'Universal Journal (ACDOCA), sostituendo l'approccio ECC che spesso richiedeva l'unione di più tabelle finanziarie separate.

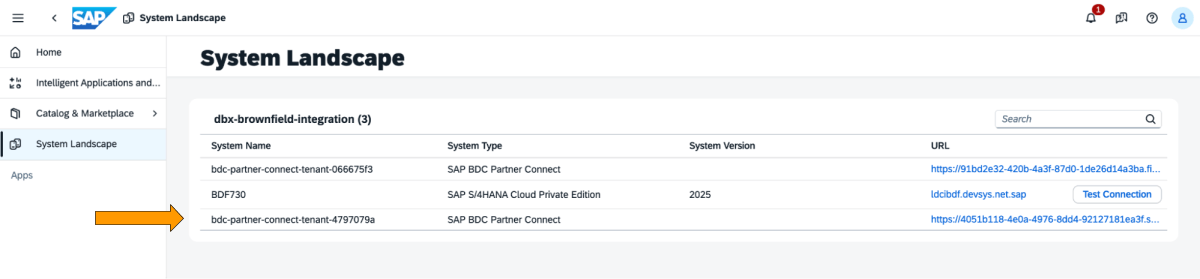

Questi sono i passaggi da eseguire nel cockpit di SAP BDC.

1: Accedi al cockpit di SAP BDC e controlla la formazione di SAP BDC in System Landscape. Connettiti a Native Databricks tramite il connettore delta sharing di SAP BDC. Per maggiori informazioni su come connettere Native Databricks a SAP BDC in modo che diventi parte della sua formazione.

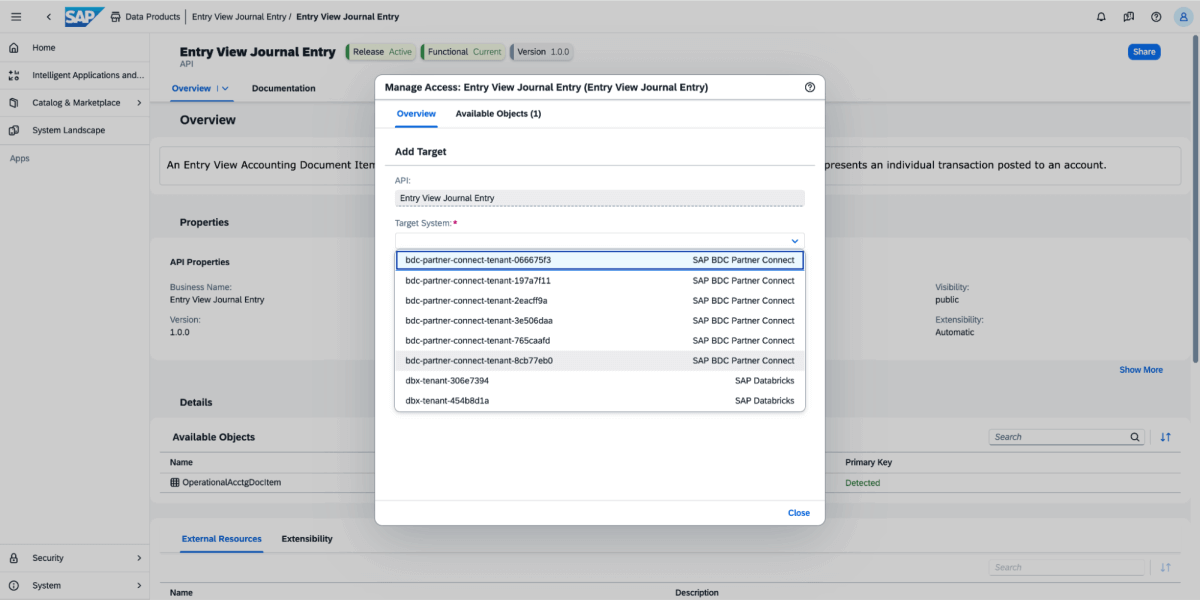

2: Vai a Catalogo e cerca la voce "Data prodotto Entry View Journal Entry" come mostrato di seguito

3: sul prodotto dati, seleziona Condividi, quindi seleziona il sistema di destinazione, come illustrato nell'immagine sottostante.

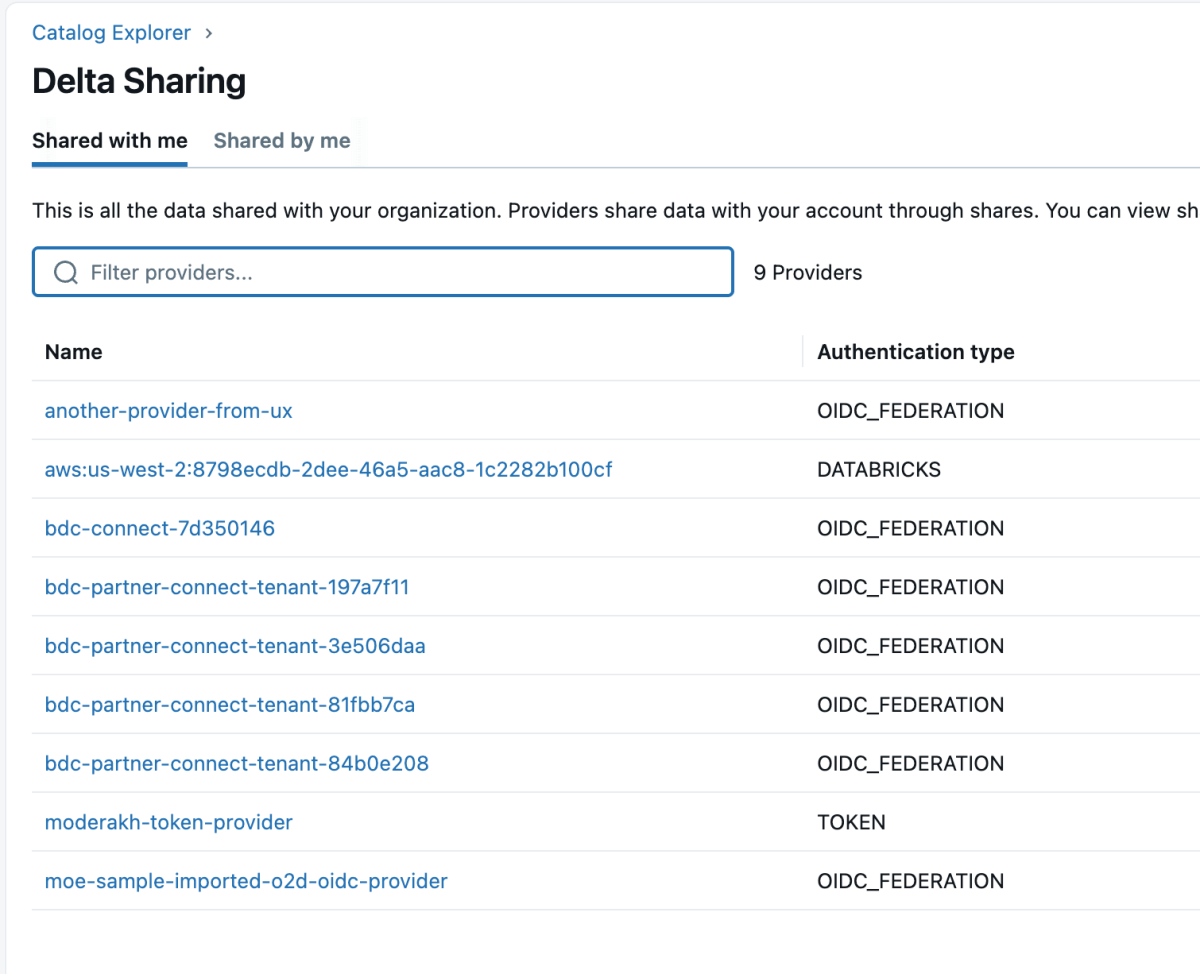

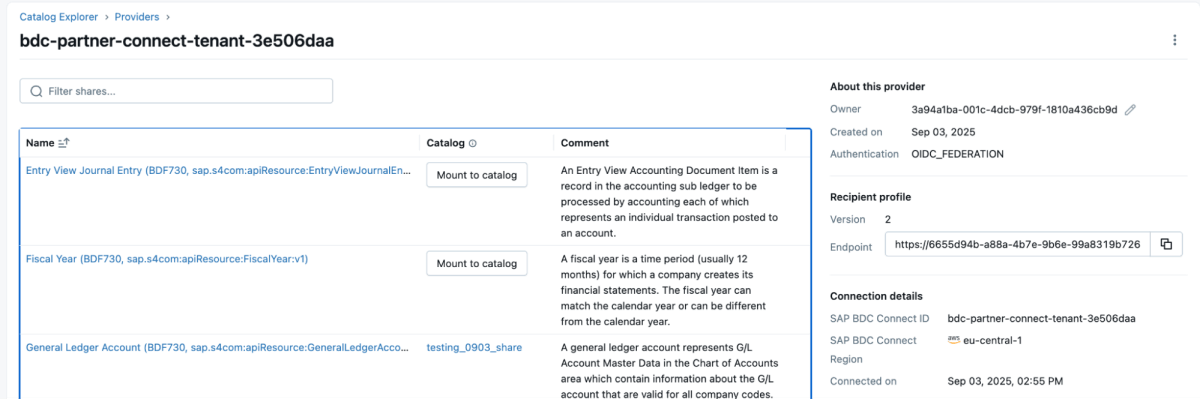

4: Una volta condiviso il prodotto di dati, apparirà come una condivisione delta nella workspace di Databricks, come mostrato di seguito. Assicurati di disporre dell'accesso "Use Provider" per poter visualizzare questi provider.

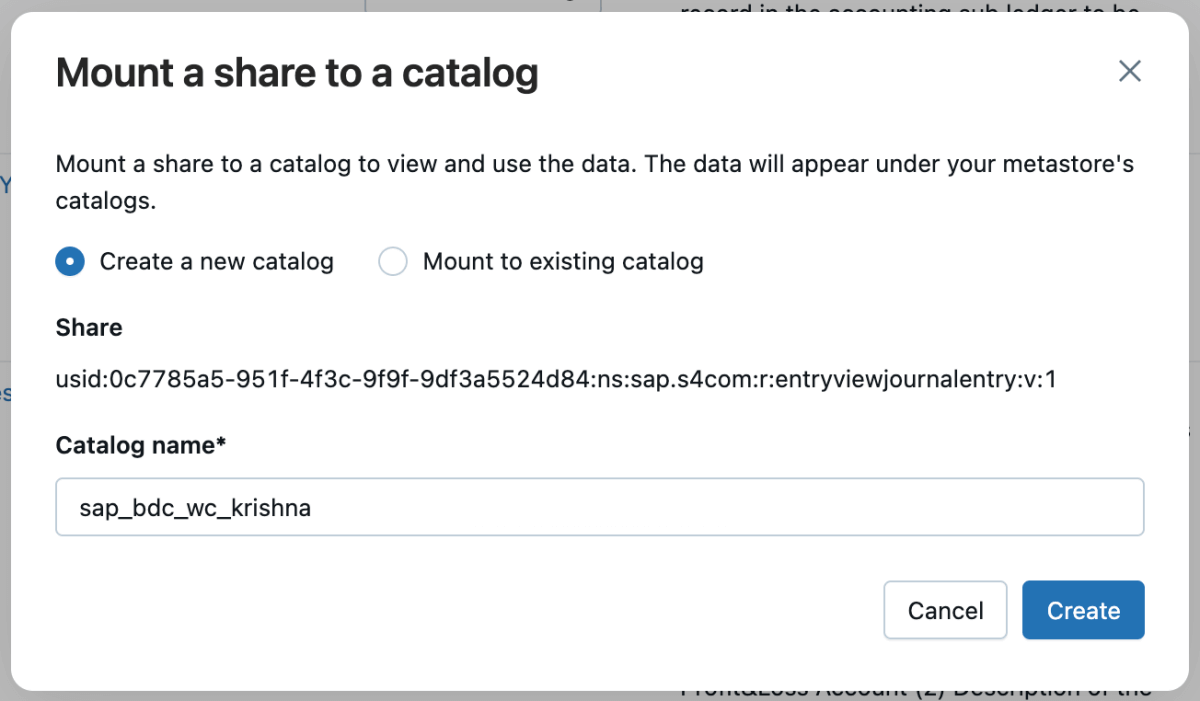

5: È quindi possibile montare la condivisione nel catalogo e creare un nuovo catalogo o montarla in un catalogo esistente.

6: Una volta montata la condivisione, verrà visualizzata nel catalogo.

Passaggio 3: Unione della pipeline ETL in Databricks utilizzando le pipeline dichiarative di Lakeflow

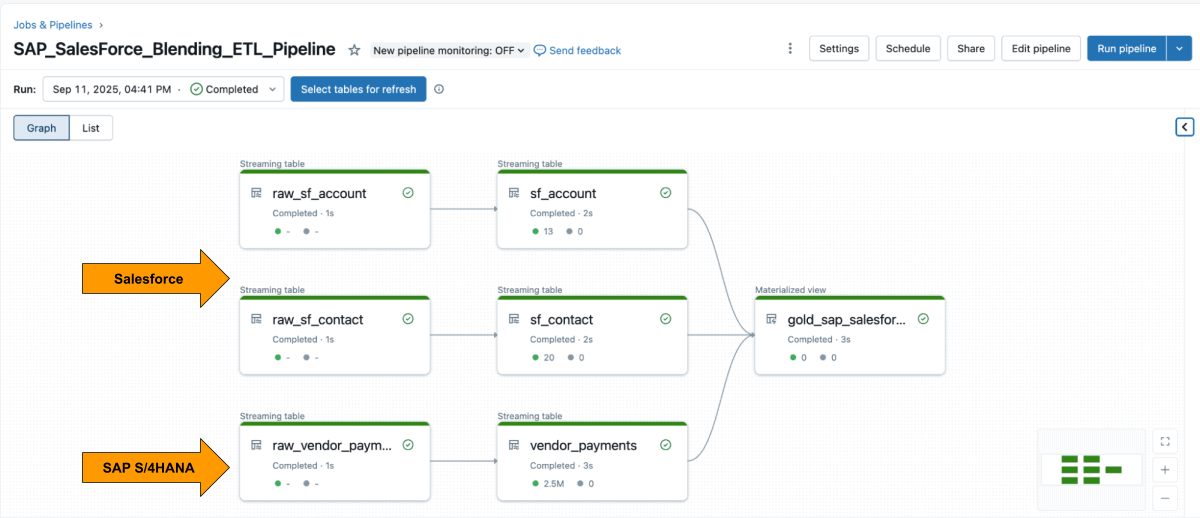

Con entrambe le fonti disponibili, utilizza Lakeflow Declarative Pipelines per creare una pipeline ETL con i dati di Salesforce e SAP.

La tabella Account di Salesforce di solito include il campo SAP_ExternalVendorId__c, che corrisponde all'ID del fornitore in SAP. Questa diventa la chiave di join primaria per il tuo silver layer.

Le Lakeflow Spark Declarative Pipelines consentono di definire la logica di trasformazione in SQL, mentre Databricks gestisce automaticamente l'ottimizzazione e orchestra le pipeline.

Esempio: Creazione di tabelle curate a livello aziendale

Questa query crea una vista materializzata curata a livello aziendale che unifica i record dei pagamenti dei fornitori di SAP con i dettagli dei fornitori di Salesforce, pronta per le analitiche e il reporting.

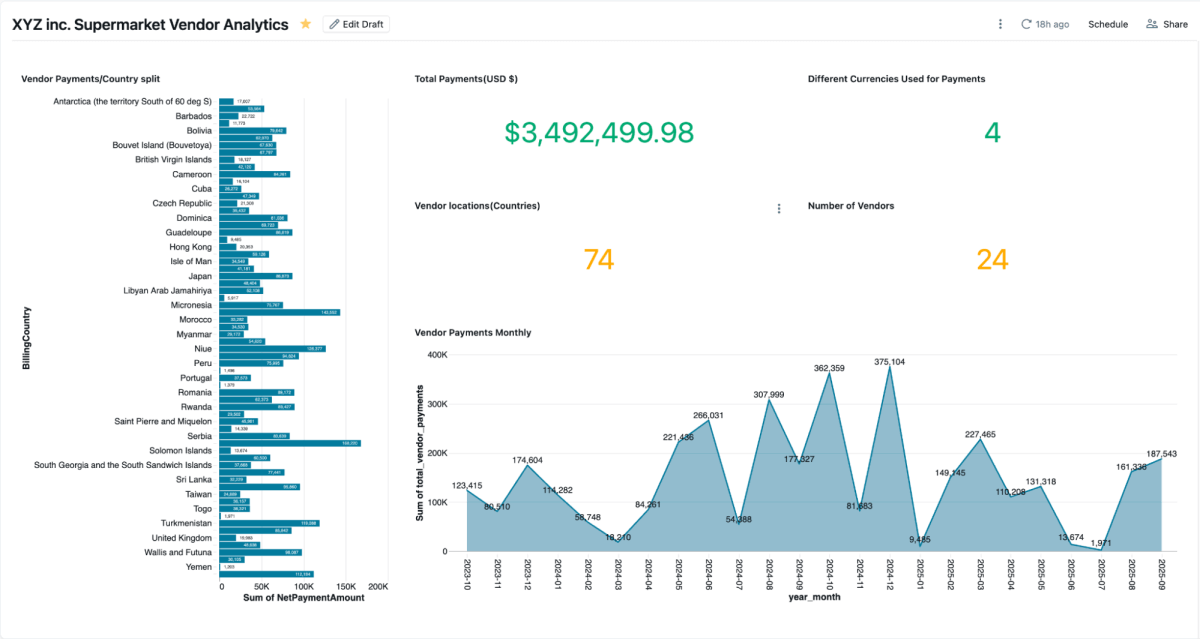

Fase 4: analizza con dashboard AI/BI e Genie

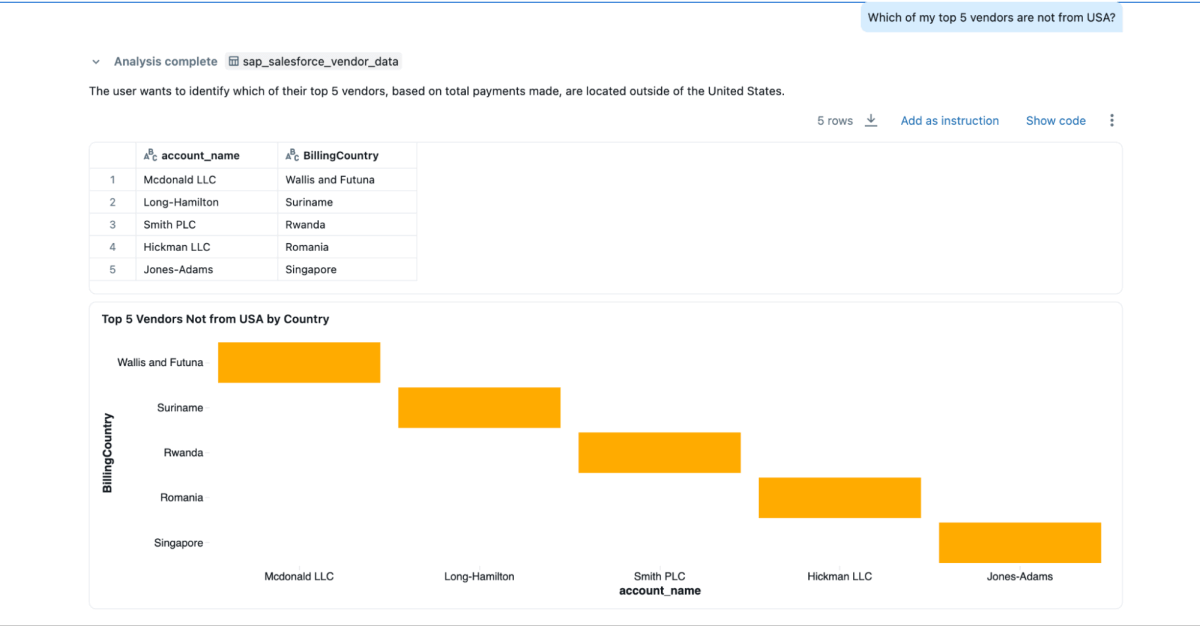

Una volta creata la vista materializzata, è possibile esplorarla direttamente nelle dashboard di AI/BI, che consentono ai team di visualizzare i pagamenti ai fornitori, i saldi insoluti e la spesa per regione. Supportano filtri dinamici, ricerca e collaborazione, il tutto governato da Unity Catalog. Genie consente l'esplorazione in linguaggio naturale degli stessi dati.

È possibile creare spazi Genie su questi dati combinati e porre domande, cosa che non sarebbe possibile se i dati fossero isolati in Salesforce e SAP.

- “Chi sono i miei 3 principali fornitori a cui pago di più e di cui desidero anche le informazioni di contatto?”

- Quali sono gli indirizzi di fatturazione dei primi 3 fornitori?

- “Quali dei miei 5 principali fornitori non provengono dagli Stati Uniti?”

Risultati aziendali

Combinando i dati di SAP e Salesforce su Databricks, le organizzazioni ottengono una visione completa e affidabile delle performance dei fornitori, dei pagamenti e delle relazioni. Questo approccio unificato offre vantaggi sia operativi che strategici:

- Risoluzione più rapida delle controversie: i team possono visualizzare i dettagli dei pagamenti e le informazioni di contatto dei fornitori fianco a fianco, facilitando l'analisi dei problemi e la loro rapida risoluzione.

- Risparmi sui pagamenti anticipati: disponendo in un unico posto di termini di pagamento, date di liquidazione e importi netti, i team finanziari possono identificare facilmente le opportunità di sconto per i pagamenti anticipati.

- Anagrafica fornitori più pulita: l'unione sul campo

SAP_ExternalVendorId__caiuta a identificare e risolvere i record dei fornitori duplicati o non corrispondenti, mantenendo così dati sui fornitori accurati e coerenti tra i sistemi. - Governance pronta per l'audit: Unity Catalog garantisce che tutti i dati siano governati con lineage, autorizzazioni e auditing coerenti, in modo che analitiche, modelli di AI e report si basino sulla stessa fonte attendibile.

Insieme, questi risultati aiutano le organizzazioni a semplificare la gestione dei fornitori e a migliorare l'efficienza finanziaria, mantenendo al contempo la governance e la sicurezza necessarie per i sistemi aziendali.

Conclusione

Unificare i dati dei fornitori tra SAP e Salesforce non deve significare ricostruire le pipeline o gestire sistemi duplicati.

Con Databricks, i team possono lavorare da un'unica base governata che integra perfettamente i dati in tempo reale di ERP e CRM. La combinazione di accesso SAP BDC zero-copy, ingestione incrementale di Salesforce, governance unificata, e pipeline dichiarative sostituisce l'overhead di integrazione con informazioni dettagliate.

Il risultato va oltre la semplice reportistica più veloce. Fornisce una visione connessa delle prestazioni dei fornitori che migliora le decisioni di acquisto, rafforza le relazioni con i fornitori e sblocca risparmi misurabili. E poiché si basa sulla Databricks Data Intelligence Platform, gli stessi dati SAP che alimentano pagamenti e fatture possono anche alimentare dashboard, modelli di AI e analitiche conversazionali, tutto da un'unica fonte affidabile.

I dati SAP sono spesso la colonna portante delle attività operative aziendali. Integrando SAP Business Data Cloud, Delta Sharing e Unity Catalog, le organizzazioni possono estendere questa architettura oltre l'analisi dei fornitori, fino all'ottimizzazione del capitale circolante, alla gestione dell'inventario e alla previsione della domanda.

Questo approccio trasforma i dati SAP da un sistema di registrazione a un sistema di intelligence, in cui ogni set di dati è attivo, governato e pronto per l'uso in tutta l'azienda.

(Questo post sul blog è stato tradotto utilizzando strumenti basati sull'intelligenza artificiale) Post originale