Introduzione ai data lake

I data lake forniscono un archivio dati completo e autorevole in grado di alimentare analisi, business intelligence e machine learning.

Introduzione ai data lake

Che cos'è un data lake?

Un data lake è un archivio centrale che conserva grandi quantità di dati nel loro formato nativo e grezzo. A differenza di un data warehouse gerarchico, che archivia i dati in file o cartelle, un data lake utilizza un'architettura piatta e oggetti di storage per memorizzarli. Lo storage a oggetti salva i dati insieme a metadati e a un identificatore univoco, semplificando la ricerca e il recupero delle informazioni attraverso regioni diverse e migliorando le prestazioni. Grazie all'uso di storage a oggetti a basso costo e di formati aperti, i data lake consentono a numerose applicazioni di sfruttare i dati disponibili.

I data lake sono stati sviluppati per superare i limiti dei data warehouse. Sebbene garantiscano analisi altamente performanti e scalabili, i data warehouse sono costosi, proprietari e incapaci di gestire molti dei casi d’uso moderni che le aziende vogliono essere in grado di affrontare. I data lake vengono spesso utilizzati per consolidare tutti i dati di un'organizzazione in un'unica posizione centrale, dove possono essere salvati "così come sono", senza dover imporre uno schema (ossia una struttura formale dei dati) in anticipo, come invece richiede un data warehouse. In un data lake è possibile salvare dati in qualunque fase di lavorazione: i dati grezzi vengono acquisiti e archiviati accanto alle fonti di dati strutturate e tabellari dell'organizzazione (come le tabelle dei database), e alle tabelle intermedie generate durante il processo di raffinazione. A differenza della maggior parte dei database e dei data warehouse, i data lake possono elaborare tutti i tipi di dati, compresi dati non strutturati e semi-strutturati come immagini, video, audio e documenti, che sono oggi fondamentali per casi d'uso di machine learning e analisi avanzata.

Perché utilizzare un data lake?

Prima di tutto, i data lake utilizzano formati aperti; questo permette di evitare il vincolo a un sistema proprietario tipico dei data warehouse, un requisito sempre più importante nelle architetture dati moderne. Sono inoltre altamente durevoli e a basso costo grazie alla loro capacità di scalare e sfruttare lo storage a oggetti. Inoltre, le analisi avanzate e il machine learning sui dati non strutturati rappresentano oggi una delle priorità strategiche principali per le aziende. La capacità unica di acquisire dati grezzi in una vasta gamma di formati (strutturati, non strutturati e semi-strutturati), insieme ai vantaggi citati, rende il data lake la soluzione naturale per l'archiviazione dei dati.

Se progettati correttamente, i data lake consentono di:

Le sfide dei data lake

Nonostante i data lake presentino innegabili vantaggi, molte delle loro promesse non si sono realizzate a causa della mancanza di alcune funzionalità critiche: assenza di supporto per le transazioni, nessun controllo della qualità dei dati o della governance e insufficienti ottimizzazioni delle prestazioni. Di conseguenza, la maggior parte dei data lake aziendali si è trasformata in veri e propri data swamp.

Per queste ragioni, un semplice data lake tradizionale non è sufficiente per soddisfare le esigenze delle aziende che vogliono innovare: spesso infatti ci si ritrova con architetture complesse e dati suddivisi in silos, distribuiti tra data warehouse, database e altri sistemi di storage. Semplificare questa architettura unificando tutti i dati in un data lake è il primo passo per le aziende che vogliono sfruttare appieno il machine learning e l’analisi dei dati per competere nel prossimo decennio.

Come i data lakehouse risolvono queste sfide

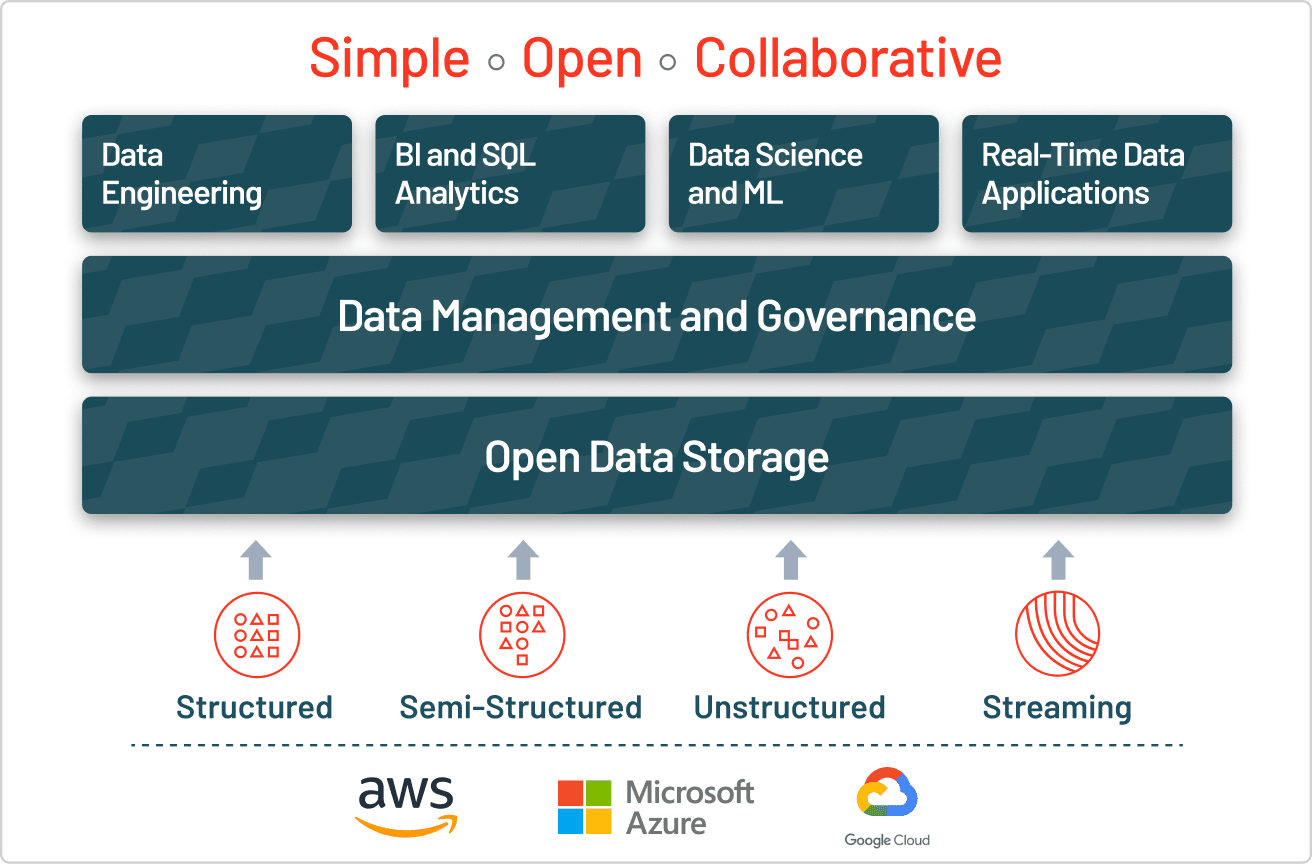

La risposta alle sfide dei data lake è il lakehouse, che aggiunge uno strato transazionale di gestione dello storage al di sopra del data lake. Un lakehouse utilizza strutture e funzionalità di gestione dei dati simili a quelle di un data warehouse, ma le esegue direttamente sui data lake nel cloud. In definitiva, un lakehouse consente ad analisi tradizionali, data science e machine learning di coesistere nello stesso sistema, il tutto in un formato aperto.

Un lakehouse abilita un'ampia gamma di nuovi casi d'uso per analisi aziendali su larga scala, BI e progetti di machine learning in grado di generare enorme valore di business. Gli analisti di dati possono estrarre insight approfonditi interrogando il data lake tramite SQL, i data scientist possono unire e arricchire set di dati per creare modelli di ML via via più accurati, i data engineer possono costruire pipeline ETL automatizzate e gli analisti di business intelligence possono creare dashboard e report più rapidamente e con maggiore facilità. Tutte queste attività possono essere eseguite contemporaneamente sul data lake, senza spostare i dati da un sistema all'altro, anche mentre nuovi dati vengono acquisiti in streaming.

Creare un lakehouse con Delta Lake

Per costruire un lakehouse di successo, le organizzazioni si sono rivolte a Delta Lake, un layer di gestione e governance dei dati in formato aperto che combina il meglio di data lake e data warehouse. Aziende di ogni settore sfruttano Delta Lake per favorire la collaborazione offrendo un'unica fonte attendibile di verità. Garantendo qualità, affidabilità, sicurezza e prestazioni sul data lake, sia per flussi in streaming che batch, Delta Lake elimina i silos e rende l'analisi accessibile a tutta l'organizzazione. Con Delta Lake, i clienti possono creare un lakehouse economico, altamente scalabile e in grado di eliminare la frammentazione dei dati, offrendo analisi self-service agli utenti finali.

Maggiori informazioni su Delta Lake

Differenze tra data lake, data lakehouse e data warehouse

| Data lake | Data lakehouse | data warehouse | |

|---|---|---|---|

| Tipi di dati | Tutti i tipi: dati strutturati, semi-strutturati, non strutturati (grezzi) | Tutti i tipi: dati strutturati, semi-strutturati, non strutturati (grezzi) | Solo dati strutturati |

| Costo | $ | $ | $$$ |

| Formato | Formato aperto | Formato aperto | Formato chiuso e proprietario |

| Scalabilità | Può espandersi per contenere, a basso costo, qualsiasi quantità di dati, indipendentemente dalla tipologia | Può espandersi per contenere, a basso costo, qualsiasi quantità di dati, indipendentemente dalla tipologia | L'espansione diventa esponenzialmente più costosa a causa dei costi dei fornitori |

| Utenza prevista | Limitata: data scientist | Unificata: analisti di dati, data scientist, ingegneri machine learning | Limitata: analisti di dati |

| Affidabilità | Qualità bassa, paludi di dati | Qualità elevata, dati affidabili | Qualità elevata, dati affidabili |

| Facilità d'uso | Difficile: l'esplorazione di grandi quantità di dati grezzi può risultare difficile in assenza di strumenti per organizzarli e catalogarli | Semplice: combina la semplicità e la struttura di un data warehouse con la casistica d'uso più ampia di un data lake | Semplice: la struttura di un data warehouse consente agli utenti di accedere rapidamente e facilmente ai dati per la reportistica e l'analisi |

| Prestazioni | Basse | Elevate | Elevate |

Scopri di più sulle sfide comuni dei data lake