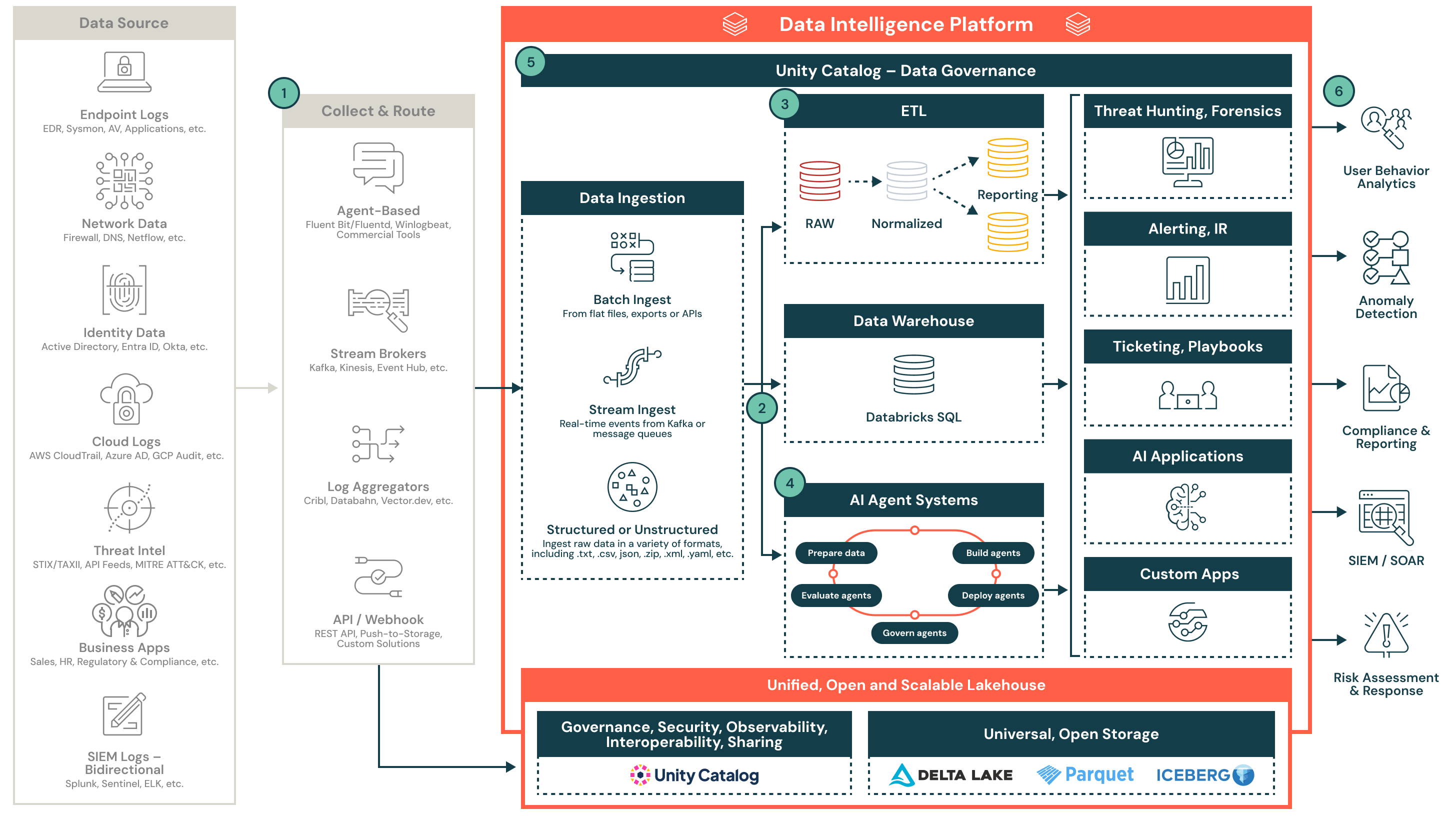

Architettura di riferimento per un Lakehouse di sicurezza

Questa architettura dimostra come centralizzare i dati di sicurezza e operazionalizzare il rilevamento, la risposta e la segnalazione con l'ecosistema Databricks lakehouse.

Operazionalizzazione della telemetria di sicurezza su larga scala con il lakehouse di Databricks

Questa architettura di riferimento dimostra come i team di sicurezza possono raccogliere, normalizzare e operazionalizzare diverse telemetrie su larga scala utilizzando il Databricks lakehouse. Supporta analisi in tempo reale, ingegneria del rilevamento, segnalazione di conformità e integrazione con strumenti SOC a valle.

Panoramica dell'architettura

La telemetria di sicurezza è complessa, ad alto volume e proviene da molti sistemi. Le architetture legacy spesso faticano con i costi, la conservazione e la correlazione tra diverse fonti. Il lakehouse di sicurezza Databricks aiuta i team di sicurezza a centralizzare e operazionalizzare questi dati utilizzando formati aperti, pipeline governate e un motore di calcolo flessibile.

Questa architettura delinea un design modulare e nativo del cloud per l'ingestione di dati di sicurezza strutturati e non strutturati da endpoint, sistemi di identità, fornitori di cloud, feed di minacce, SIEM e applicazioni aziendali. Una volta ingeriti e normalizzati, questi dati alimentano casi d'uso a valle, tra cui il rilevamento delle minacce, il triage, le indagini guidate dall'IA e la segnalazione.

1. Raccogli e instrada

I dati di sicurezza vengono raccolti da molteplici fonti, tra cui endpoint, piattaforme cloud, sistemi di identità e feed di minacce. I dati vengono instradati attraverso collector basati su agent, broker di flussi, aggregatori di log o API dirette. Questi strumenti supportano sia formati strutturati che non strutturati e possono operare in tempo reale o in batch.

Ecco alcuni esempi:

- Fluentd, Vector o log shippers commerciali

- Kafka, Event Hub o Kinesis

- Pipeline basate su Cribl, Databahn o webhook

2. Ingestione e atterraggio

I dati entrano nel lakehouse tramite l'ingestione batch strutturata o lo streaming in tempo reale. I dati ingeriti vengono scritti nelle tabelle Delta Lake Bronze per preservare la fedeltà e la tracciabilità. Unity Catalog assicura che i dati siano governati e scopribili fin dall'inizio del pipeline.

Le caratteristiche chiave includono:

- Supporto per file piatti, JSON, CSV e formati nidificati

- Ingestione di flussi da Kafka o altri broker

- Governance e scopribilità attraverso Unity Catalog

3. Normalizza e trasforma

I dati grezzi vengono analizzati, appiattiti e arricchiti in formati strutturati per l'analisi e il rilevamento. Questa fase utilizza l'architettura medaglione (Bronze, Silver, Gold) per creare tabelle riutilizzabili e interrogabili che alimentano l'ingegneria del rilevamento e la segnalazione.

I compiti di normalizzazione includono:

- Allineamento dello schema (ad es., OCSF o modelli personalizzati)

- Arricchimento con metadati o intelligence sulle minacce

- Deduplicazione, analisi e allineamento dei timestamp

4. Abilitare l'IA e l'analisi avanzata

I feed di dati normalizzati supportano i framework di agenti IA nativi di Databricks che supportano casi d'uso di sicurezza. Questi agenti possono rilevare anomalie, gestire allarmi e automatizzare i flussi di lavoro investigativi. La piattaforma supporta la gestione del ciclo di vita degli agenti dalla fase di sviluppo alla produzione.

Le capacità includono:

- Preparazione dei dati per l'addestramento e l'inferenza

- Distribuzione e gestione degli agenti di rilevamento

- Valutazione e punteggio delle prestazioni del modello in produzione

5. Potenziare le operazioni di sicurezza

Il lakehouse consente funzioni SOC di base come la caccia alle minacce, l'allertamento, la risposta agli incidenti e l'automazione. Le uscite strutturate alimentano i cruscotti, i ticket, i flussi di lavoro SOAR e i sistemi a valle.

I risultati includono:

- Indagini più rapide e riduzione della fatica da allerta

- Vista unificata della telemetria attraverso diverse fonti

- Migliorata collaborazione attraverso notebook e SQL

6. Fornire risultati di sicurezza

Le intuizioni curate fluiscono verso gli strumenti e i team che ne hanno bisogno. I prodotti dati supportano la conformità, la segnalazione, l'analisi del comportamento degli utenti, il rilevamento delle anomalie e la valutazione del rischio. Il SIEM diventa un consumatore a valle di allerte raffinate e contesto.

Esempi di consumo a valle:

- Cruscotti per la segnalazione della conformità

- Pipeline di rilevamento di anomalie e UEBA

- Arricchimento SIEM e playbook SOAR