Koalas:pandas から Apache Spark への容易な移行 – データラングリング(カテゴリ変数の導入)

データブリックスは本日開催された Spark + AI Summit において、PySpark の DataFrame API を拡張してpandas と互換性を持たせる新しいオープンソースプロジェクトの Koalas(コアラズ) を発表しました。

Python のデータサイエンスはここ数年で急速に拡大し、pandas は今ではエコシステムの要となっています。データサイエンティストはデータセットを入手する場合、pandas を使って検証します。pandas はデータラングリング(データクレンジング/データクリーニングおよびデータ整形)や分析に最適のツールです。実際に、pandas の read_csv は、データサイエンスに取り組む多くの学生が最初に学習する実行コマンドです。

pandas に課題があるとすれば、ビッグデータのスケーリングに適していないことです。pandas は単一のマシンで扱えるスモールデータ用に設計されています。一方、Apache Spark はビッグデータワークロードのデファクトスタンダードとして登場しました。今日、データサイエンティストの多くは pandas を使って、コースワーク、ペットプロジェクト、小さなデータタスクを行っています。しかし、膨大なデータセットを扱うために Spark を活用するには、 PySpark に移行するか、pandas で扱えるようにデータをダウンサンプリングしなければなりません。

Koalas はこの問題を解決します。Koalas を使用することで、データサイエンティストは新しいフレームワークを覚えなくとも、単一のマシンから分�散環境へ移行することが可能です。次のように、1つのパッケージを別のパッケージに置き替えるだけで Spark 上で pandas のコードを Koalas にスケーリングすることが可能です。

pandas:

Koalas:

pandasはPython データサイエンスの標準表現

Python がデータサイエンスの主要言語として認知され、データコミュニティは pandas、matplotlib、numpy などの重要なライブラリをベースとした表現型を開発しました。これらのライブラリが使用できれば、データサイエンティストは自分の考えを十分に表現し、アイデアどおりの結論を導くことが可能になります。また、アイデアを概念化し、すぐに実行することができます。

しかし、自分の専門ではない表現型でライブラリを扱わなければならない場合、作業を中断して数分ごとにスタックオーバーフローをチェックし、コードの動作確認のためだけにワークフローを妨げることになってしまいます。PySpark は使いやすく、pandas との類似点が多くありますが、表現に違いがあります。

データブリックスは、Spark で pandas を有効にすることで、データサイエンティストやデータドリブンな組織の生産性が大幅に向上すると確信しています。Koalas がもたらすメリットは以下のとおりです。

- Koalas によって、特定のデータセットに pandas も PySpark も使用できる

- データサイエンティストは、単一のマシン向けに記述された pandas を Koalas に切り替えるだけで、Spark 上でコードのスケールアップができる

- Koalas を使用することで、Spark の活用するために PySpark を学�ぶ必要がなくなり、より多くのデータサイエンティストがビッグデータを扱える

次に、Koalas を使って Spark で簡単に実行できる、シンプルで優れた pandas メソッドの 2 つの例を紹介します。

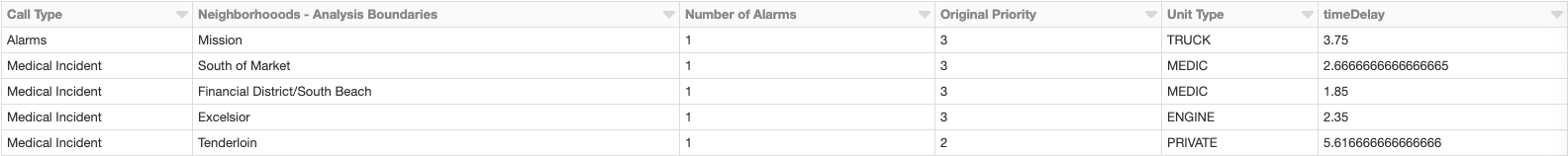

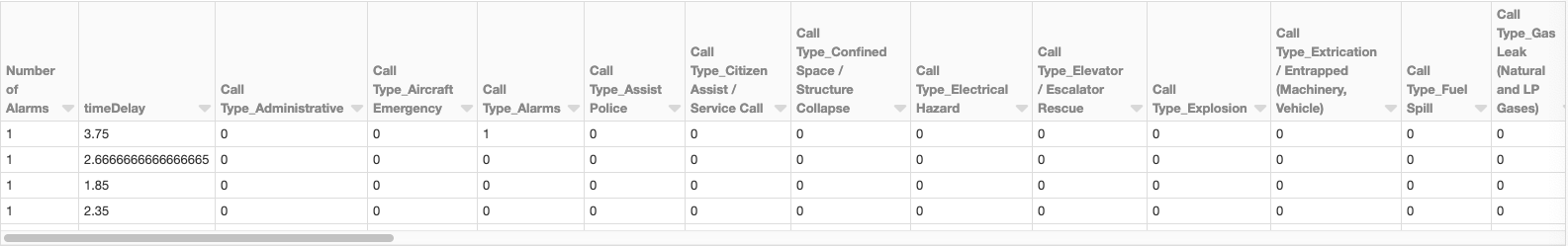

カテゴリ変数による特徴量エンジニアリング

データサイエンティストが機械学習モデルを構築する際、データラングリングの過程でカテゴリ変数を扱うことがよくあります。通常の手法は、カテゴリ変数をダミー変数としてエンコードすることです。以下の例には、コールタイプ、近傍、ユニットタイプなど、いくつかのカテゴリ変数が含まれています。pandas の get_dummies メソッドは、まさにこれらの変数をエンコードするのに便利なメソッドです。pandas を使って行う方法は以下のとおりです。

Koalas を使うことで、ほんの少し調整すれば Spark で次のように実行できます。

これだけです。

ガートナー®: Databricks、クラウドデータベースのリーダー

タイムスタンプによる算術演算

データサイエンティストは常にタイムスタンプを扱っていますが、実際に正しく処理することはとても厄介です。しかし、pandas は見事な解決策を提供してくれます。日付の DataFrame で説明しましょう。

pandas で終了日から開始日を引くには、以下のコマンドを実行するだけです。

pandas を Koalas に置き換えるだけで Spark 上で同じことができます。

繰り返しますが、ただこれだけです。

次のステップと Koalas の使用開始

Spark + AI Summit で Reynold Xin が公式発表した Koalas に関する動画をご覧ください。

私たちはこれまで、データラングリング(クレンジング/クリーニング)の困難さや、pandas でのダウンサンプリングの��必要性などから、大規模なデータを扱うことに積極的ではない多くのデータサイエンティストに出会いました。そしてそのデータサイエンティストを支援するために Koalas を開発しました。Koalas は Spark での作業のスケーリングを劇的に容易にし、データサイエンティストの意欲を高めると確信しています。

ここまで、一般的な DataFrame の操作メソッドと、pandas の優れたインデックス作成技術を実行してきました。ロードマップの今後の項目は次のとおりです。主にカバレッジの改善に焦点を当てます。

このプロジェクトはまだ初期段階ですが、今後、急速に進展していく予定です。Koalas や使用開始についての詳細は、こちらのプロジェクトの GitHub リポジトリを参照してください。皆様のご意見をお待ちしております。