AIセキュリティリスクの管理:CISOのための新しいワークショップの紹介

CISOのためのAIとMLシステムに関連するセキュリティリスクの概要

AIの導入は、ほとんどの企業にとって必要不可欠である

Machine Learning(ML)とジェネレーティブAI(GenAI)は、仕事の未来に革命を起こそうとしている。組織は、AIがイノベーションの構築、競争力の維持、従業員の生産性向上に役立っていることを理解している。同様に、企業は自社のデータがAIアプリケーションに競争上の優位性をもたらすことを理解している。これらのテクノロジーは、組織にとってチャンスであると同時に潜在的なリスクでもある。

顧客との会話では、データ損失、データポイズニング、モデルの盗難、コンプライアンスや規制の課題といったリスクが頻繁に挙げられている。最高情報セキュリティ責任者(CISO)は、こうしたリスクを迅速に軽減しながら、ビジネスのニーズに適応する必要に迫られている。しかし、CISOがビジネスにノーと言えば、チームプレーヤーではなく、企業を第一に考えているとみなされる。逆に、リスクのあることにイエスと言えば、不注意だと思われる。CISOは、ビジネスの成長、多様化、実験に対する意欲に追いつく必要があるだけでなく、ビジネスに革命をもたらすと期待されるテクノロジー、技術の爆発的な増加に追いつかなければならない。

このブログシリーズのパート1では、企業がエンタープライズAIアプリケーションを評価、導入、採用する際にCISOが知っておくべきセキュリティリスクについて説明する。

データプラットフォームはAIセキュリティの専門家であるべきだ

Databricksでは、データとAIは人以外の最も貴重な資産であり、あらゆる業界の勝者はデータとAIの企業になると信じている。Databricks Data Intelligence Platformにセキュリティが組み込まれているのはそのためだ。Databricks Data Intelligence Platformは、組織全体でデータとAIを活用することを可能にする。レイクハウスの上に構築され、すべてのデータとガバナンスのためのオープンで統一された基盤を提供し、データの独自性を理解するデータ・インテリジェンス・エンジンを搭載している。

当社のDatabricksセキュリティチームは、何千ものお客様と協力して、アーキテクチャ要件を満たす適切なセキュリティ機能を備えたAIとMachine Learning をDatabricks上に安全に導入している。私たちはまた、Databricksの社内およびMLやGenAIのコミュニティで数十人の専門家と協力して、AIシステムのセキュリティリスクを特定し、それらのリスクを軽減するために必要なコントロールを定義している。Databricksは、数多くのAIおよびMLリスクフレームワーク、基準、勧告、ガイダンスをレビューしてきた。その結果、CISOやセキュリティ・チームが組織のMLやAIアプリケーションを安全に展開する方法を理解するのに役立つ、強固なAIセキュリティ・ガイドラインが作成された。しかし、MLとAIアプリケーションのリスクについて議論する前に、データの管理、モデルの構築��、アプリケーションの提供に使用されるAIとMLシステムの構成要素について説明しよう。

効果的なセキュリティのためのAIシステムのコアコンポーネントを理解する

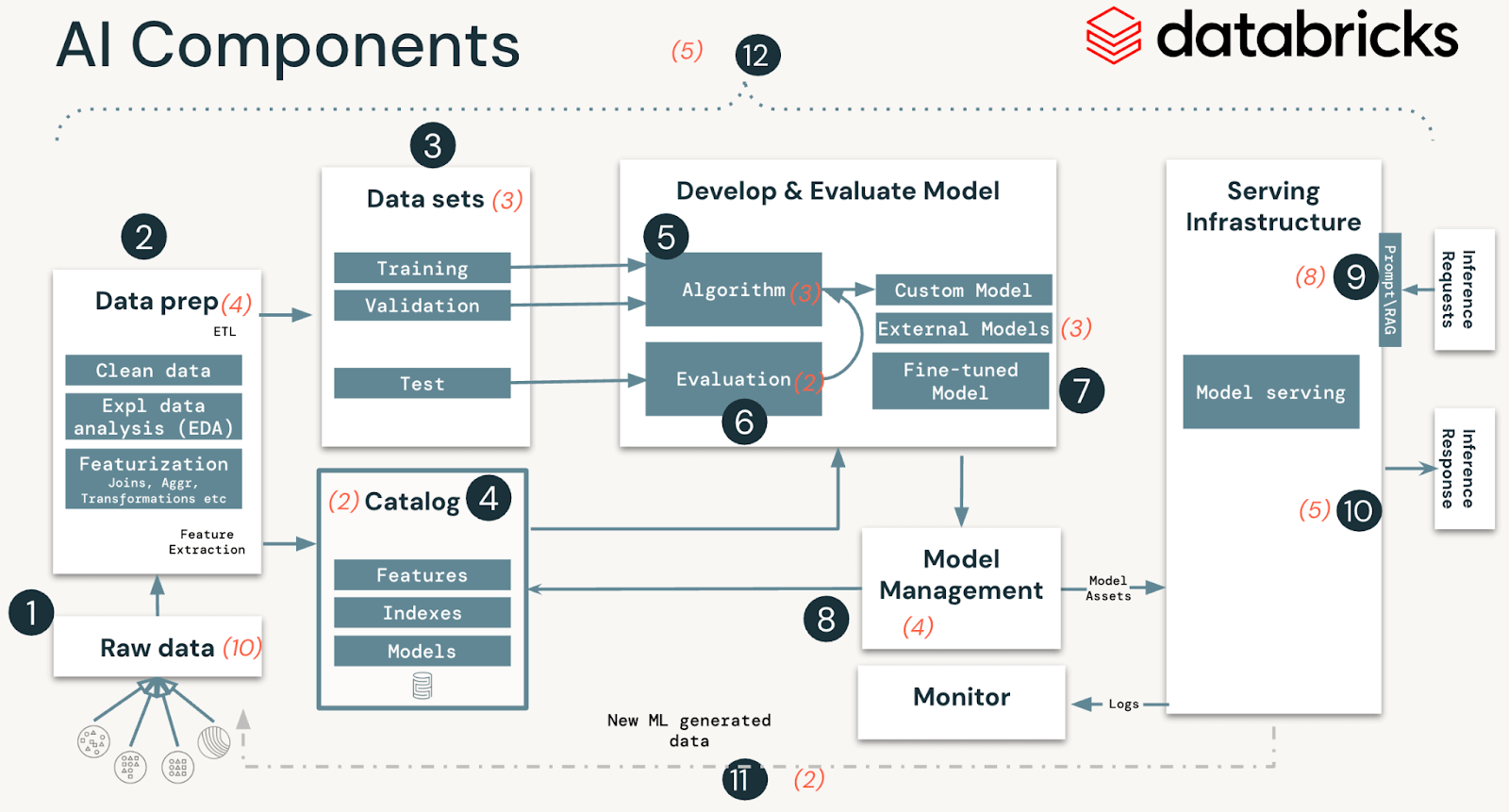

AIやMLのシステムは、データ、コード、モデルで構成されている。このようなソリューションの典型的なシステムには、12の基本的なアーキテクチャコンポーネントがあり、大きく4つの段階に分類される:

- データの運用は、データの取り込みと変換、データのセキュリティとガバナンスの確保で構成される。 優れたMLモデルは、信頼できるデータパイプラインと安全なインフラに依存する。

- モデルの運用には、カスタムモデルの構築、モデルマーケットプレイスからのモデルの取得、または(OpenAIのような)SaaS LLMの利用が含まれる。 モデルを開発するには、一連の実験と、それらの実験の条件と結果を追跡し比較する方法が必要である。

- モデルの展開と提供は、モデルイメージの安全な構築、モデルの分離と安全な提供、自動化されたスケーリング、レート制限、および展開されたモデルの監視で構成される。

- 運用とプラットフォームには、プラットフォームの脆弱性管理とパッチ適用、モデルの分離とシステムに対する制御、アーキテクチャのセキュリティによるモデルへのアクセス許可などが含まれる。また、CI/CDのための運用ツールも含まれる。セキュアなMLOpsのために開発、ステージング、本番という個別の実行環境を維持することで、ライフサイクル全体が要求される基準を満たすことを保証する 。

MLOpsは、AIとMLシステム�のコード、データ、モデルを管理するための一連のプロセスと自動化されたステップである。MLOpsは、MLのライフサイクル全体をセキュアにするために、セキュリティ・オペレーション、運用(SecOps)と組み合わせるべきである。 これには、モデルのトレーニングやテストに使用されるデータの保護、悪意のある攻撃からのモデルとそのインフラストラクチャの展開が含まれる。

AIとMLシステムの上位のセキュリティリスク

技術的なセキュリティリスク

AIとMLシステムの分析では、12のコンポーネントにわたって51の技術的セキュリティリスクを特定した。 以下の表では、AIやMLシステムのステップに沿った基本的な構成要素を概説し、私たちのチームが特定したセキュリティリスクの種類を強調している:

| システムステージ | システム・コンポーネント(図1) | 潜在的なセキュリティリスク |

|---|---|---|

| データの運用 |

|

19の具体的なリスク

|

| モデルの運用 |

|

12の具体的なリスク

|

| モデルの展開とサービング |

|

13の具体的なリスク

|

| 運用とプラットフォーム |

|

7つの具体的なリスク

|

Databricks は、上記のすべてのリスクに対して緩和策を講じている。今後のブログとホワイトペーパーでは、リスクの完全なリストと、関連するコントロールに関するガイダンス、および上記のリスクに対する緩和コントロールとして使用できるDatabricks Delta Lake、Databricks Managed MLflow、Unity Catalog、Model Servingのようなすぐに使える機能について説明する。

組織のセキュリティリスク

技術的なリスクに加えて、CISOとの議論では、AIとMLの導入への道を容易にするために、4つの組織的なリスク領域に対処する必要性が浮き彫りになった。これらは、セキュリティ機能を、彼らがサービスを提供するビジネスのニーズ、ペース、成果、リスク選��好度に合致させるための鍵となる。

- 人材:セキュリティ組織は、新しいテクノロジー、技術を採用する際、他の組織に遅れをとる可能性がある。CISOは、人材プールの中でどの職務がAIにスキルアップすべきかを理解し、部門全体でMLSecOpsを実施する必要がある。

- 運用モデル:新しいAIのユースケースを安全に導入するための主要な利害関係者、チャンピオン、企業全体のプロセスを特定することは、リスクレベルを評価し、アプリケーション導入への適切な道筋を見出すために不可欠である。

- 変更管理:ADKARなどの組織変更管理フレームワークを活用することで、変更のハードルを見つけ、期待を伝え、惰性をなくして加速させる。

- 意思決定支援:どの技術的な取り組みやビジネスユースケースに優先順位をつけるか、技術的な作業とビジネス上の成果を結びつけることが、組織全体の優先順位を決める鍵となる。

CISO主導のワークショップでAIのセキュリティリスクを効果的に軽減する

CISOは本能的にリスクを評価する。しかし、CISOのこの超能力は、AIには通じにくい。 その第一の理由は、CISOがAIやMLシステムについて、資産、脅威、影響、コントロールを総合して容易に視覚化できるような単純なメンタルモデルを持っていないからだ。

これを支援するため、Databricksセキュリティチームは、CISOおよびセキュリティリーダー向けに新しい機械学習および生成AIのセキュリティワークショップを設計した。これらのワークショップの内容は、CISOの本能的な超能力であるリスク評価をAIに関して運用可能かつ効果的なものにするため、AIセキュリティ管理のフレームワークとしてさらに発展させている。

ここでは、MLやAIアプリケーションの技術的なセキュリティリスクを管理するための、私たちが推奨する最重要アプローチを紹介する:

- MLのビジネスユースケースの特定:すでに実装されているか、計画段階であるかにかかわらず、十分に確保しようとしている利害関係者との明確なユースケースがあることを確認する。

- ML導入モデルの決定:適切なモデル(カスタム、SaaS LLM、RAG、ファインチューニングモデルなど)を選択し、12個のML/GenAIコンポーネントの共有責任(特に各コンポーネントのセキュリティ確保)を、組織と関係するパートナー間でどのように分担するかを決定する。

- 最も適切なリスクの選択:文書化された51のMLリスクリストから、ステップ#2の結果に基づき、組織に最も関連性の高いリスクを特定する。

- 各リスクの脅威の列挙:各リスクに関連する具体的な脅威と、各脅威の対象となるML/GenAIコンポーネントを特定する。

- コントロールの選択と実施:組織のリスク選好度に合致したコントロールを選択する。 これらのコントロールは、どのようなデータ・プラットフォームとも互換性があるように、汎用的に定義されている。 また、当社のフレームワークは、これらのコントロールをDatabricks環境に特化して調整するためのガイドラインも提供している。

- コントロールの運用化:コントロールの所有者を決定する。その多くはデータプラットフォームプロバイダーから継承する。 統制が確実に実施され、有効性が監視され、定期的に見直されるようにする。 ビジネスのユースケース、展開モデル、脅威の状況の変化に応じて、調整が必要になることもある。

詳細とチームとのつながり

当社のCISOワークショップへの参加や、近日公開予定のDatabricks AIセキュリティフレームワークのホワイトペーパーにご興味のある方は、[email protected]までご連絡ください。

Databricksがどのようにセキュリティに取り組んでいるかについてご興味のある方は、当社のセキュリティおよびトラストセンターをご覧ください。