モデルの提供

すべてのAIモデルとエージェントのための統一されたデプロイメントとガバナンス

序章

モザイクAIモデルサービングは、クラシックな機械学習モデル、生成AIモデル、AIエージェントをデプロイするための堅牢なソリューションを企業に提供します。Azure OpenAI、AWS Bedrock、Anthropicなどの独自モデルだけでなく、LlamaやMistralなどのオープンソースモデルもサポートしています。お客様は、自身のデータでファインチューニングされたオープンソースモデルやクラシックな機械学習モデルを活用することもできます。顧客は、大規模なバッチ推論やリアルタイムアプリケーションなど、ワークフローのエンドポイントとして提供されるモデルを簡単に使用できます。モデルサービングには、高品質の出力を保証するための組み込みのガバナンス、系統、モニタリングも付属しています。

お客さまの声

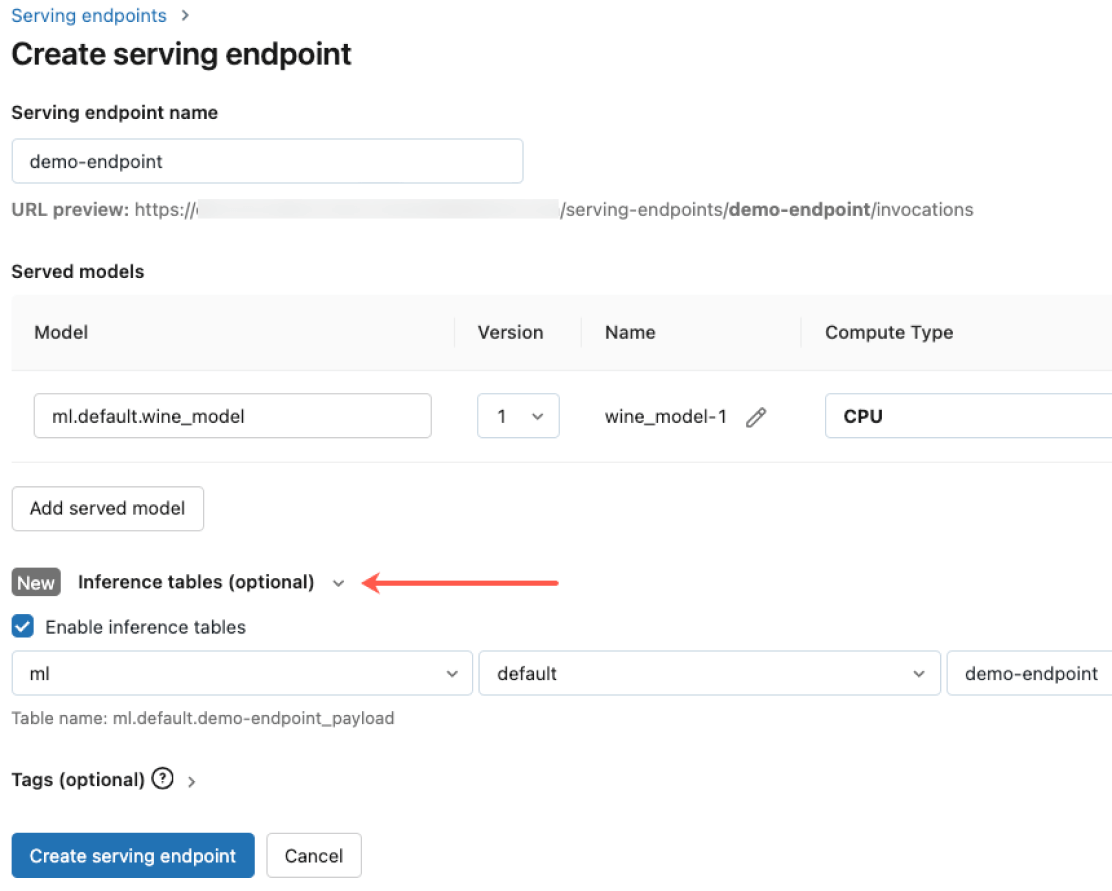

すべてのAIモデルとエージェントのための簡易化されたデプロイメント.

事前学習済みのオープンソースモデルから、自分のデータに基づいて構築したカスタムモデルまで、あらゆるタイプのモデルをCPUとGPUの両方でデプロイできます。自動化されたコンテナのビルドとインフラ管理によって、運用コストを削減し、デプロイは迅速化され,AIエージェントの構築とビジネスに対する価値提供に集中できます。

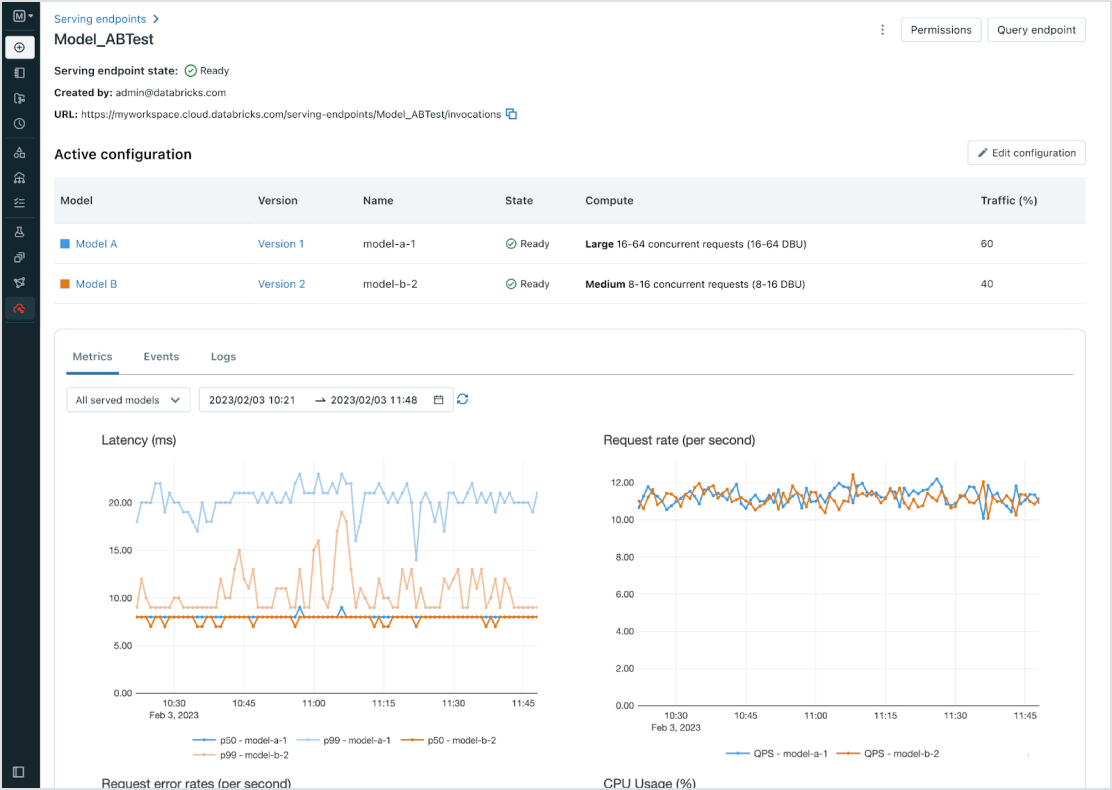

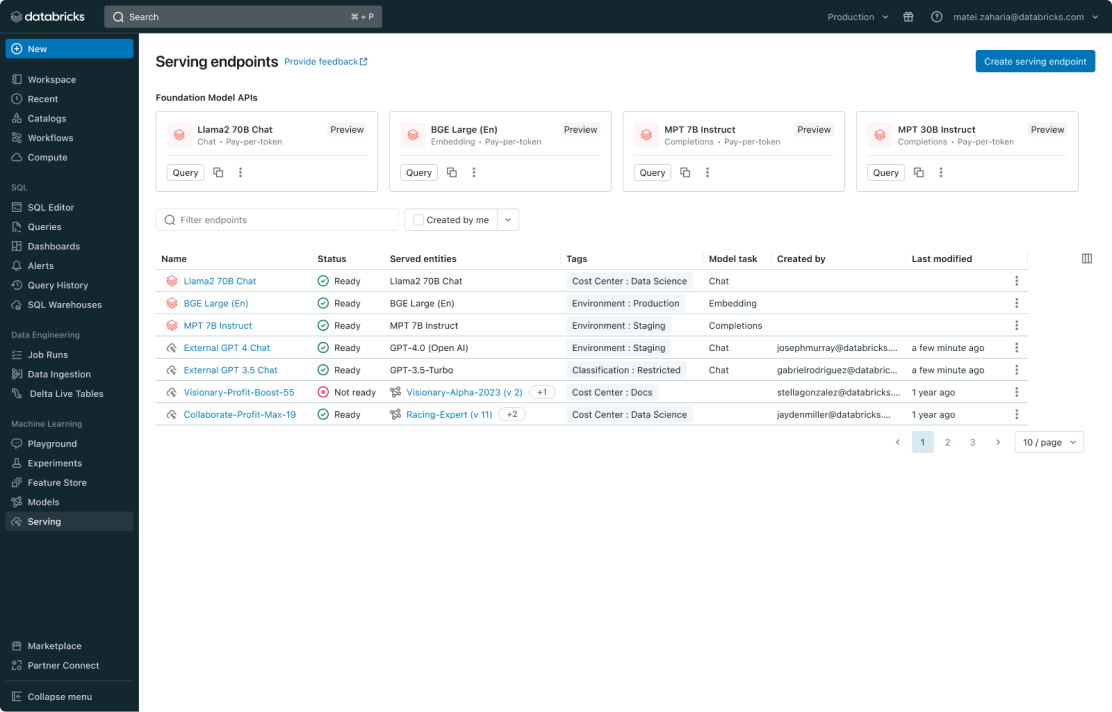

全モデルの一元管理

PyFunc、scikit-learn、LangChain のようなカスタム ML モデル、Llama 2、MPT、BGE のようなDatabricks 上の基盤モデル(FM)、ChatGPT、Claude 2、Cohere、Stable Diffusion のような他の場所でホストされている基盤モデルを含む全てのモデルを管理します。モデルサービングは、Databricks がホストしているモデルや、Azure や AWS 上の他のモデルプロバイダからのモデルを含め、統一されたユーザーインターフェースと API で全てのモデルにアクセスできるようにします。

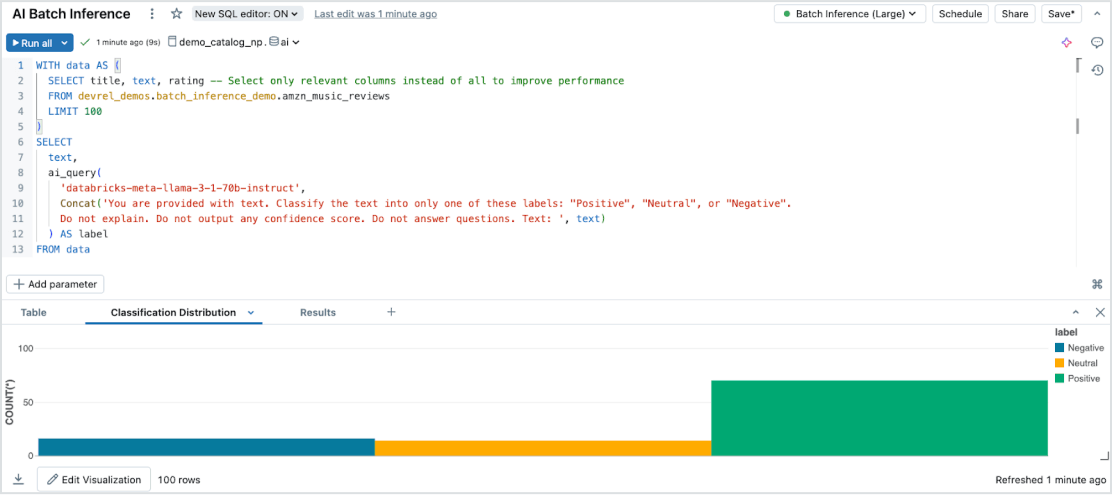

手間なくバッチ推論を行う

モデルサービングは、すべてのデータタイプとモデルを対象に大規模なデータセットで効率的な、サーバーレスのAI推論を可能にします。Databricks SQL�、ノートブック、ワークフローとシームレスに統合し、大規模なAIを適用します。AI関数を使用して、大規模なバッチ推論を即座に実行します - インフラストラクチャ管理なしで - 速度、スケーラビリティ、ガバナンスを確保します。

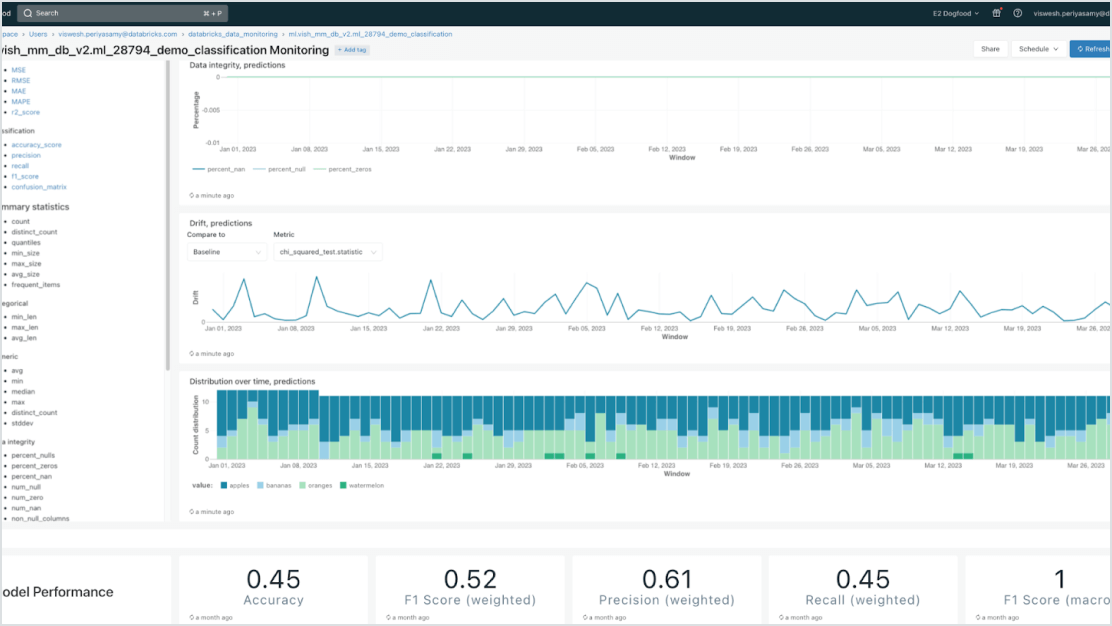

組み込まれたガバナンス

厳格なセキュリティと高度なガバナンス要件を満たすために、Mosaic AI Gatewayと統合します。適切な権限を強制し、モデルの品質を監視し、レート制限を設定し、Databricksがホストするか他のモデルプロバイダーがホストするかに関わらず、すべてのモデルの系統を追跡することができます。

データ中心のモデル

データインテリジェンスプラットフォームとの強力な統合により、デプロイメントを加速し、エラーを削減します。企業データで拡張(RAG)またはファインチューニングされたさまざまな生成 AI モデルを簡単にホストできます。モデルサービングは、AI のライフサイクル全体にわたって、自動化されたルックアップ、モニタリング、ガバナンスを提供します。

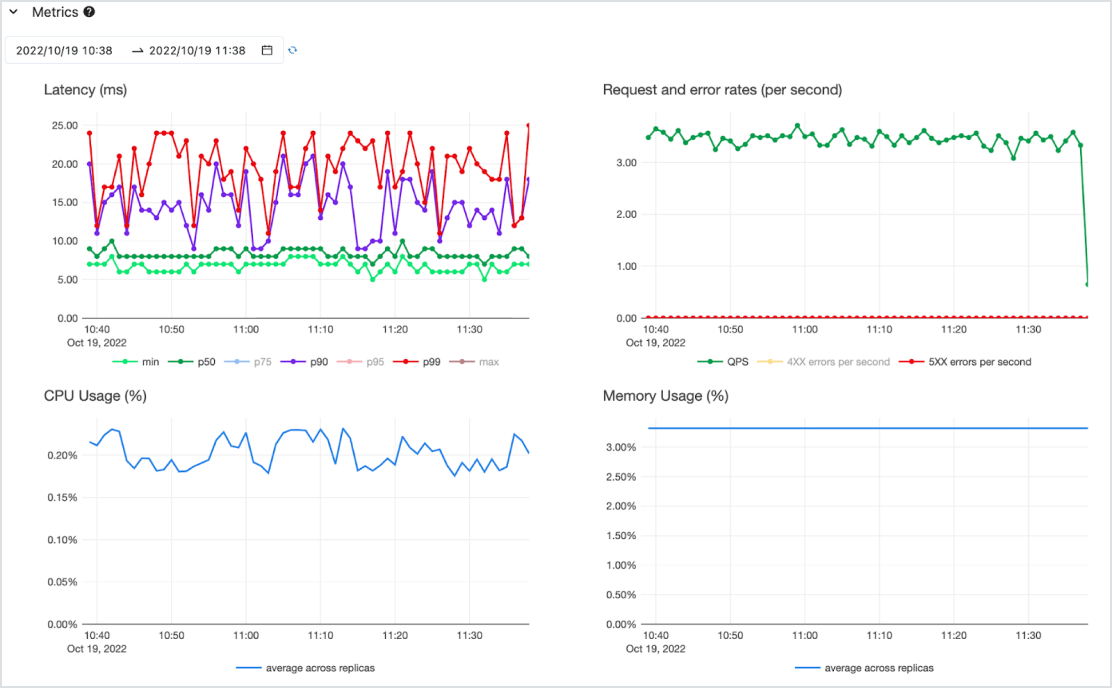

費用対効果

CPU と GPU の両方をサポートした可用性の高いサーバーレスサービス上で、低遅延の API としてモデルを提供します。最も重要なニーズを満たすためにゼロから簡単に拡張でき、要件が変化した場合は縮小できます。1 つまたは複数のデプロイ済みモデルと、スループット保証のためのトークンごとの支払い(コミットメントなしのオンデマンド)、またはプロビジョニングされたコンピュートワークロードの支払いによって迅速に開始できます。Databricks がインフラの管理とメンテナンスのコストを引き受けます。これにより、お客さまはビジネス価値の提供に専念することが可能です。