Mosaic AI エージェントフレームワーク

本番品質の検索拡張生成(RAG)アプリの構築

検索拡張生成(RAG)は、質問やタスクに関連するデータや文書を見つけ、それらを大規模言語モデル(LLM)がより正確な応答をコンテキストとして生成するための生成的 AI のアプリケーションパターンです。

Mosaic AI エージェントフレームワークは、開発者が高品質な生成 AI アプリケーションを構築およびデプロイするために設計されたツール群で、RAG を使用して出力を一貫して測定し、評価することで、正確で安全かつ管理された成果を提供します。また、Mosaic AI エージェントフレームワークは、開発者が RAG アプリケーションの品質を容易に評価し、仮説をテストして迅速に反復を行い、アプリケーションを容易に再デプロイメントし、品質を継続��的に確保するための適切なガバナンスとガードレールを提供します。

最高の本番品質

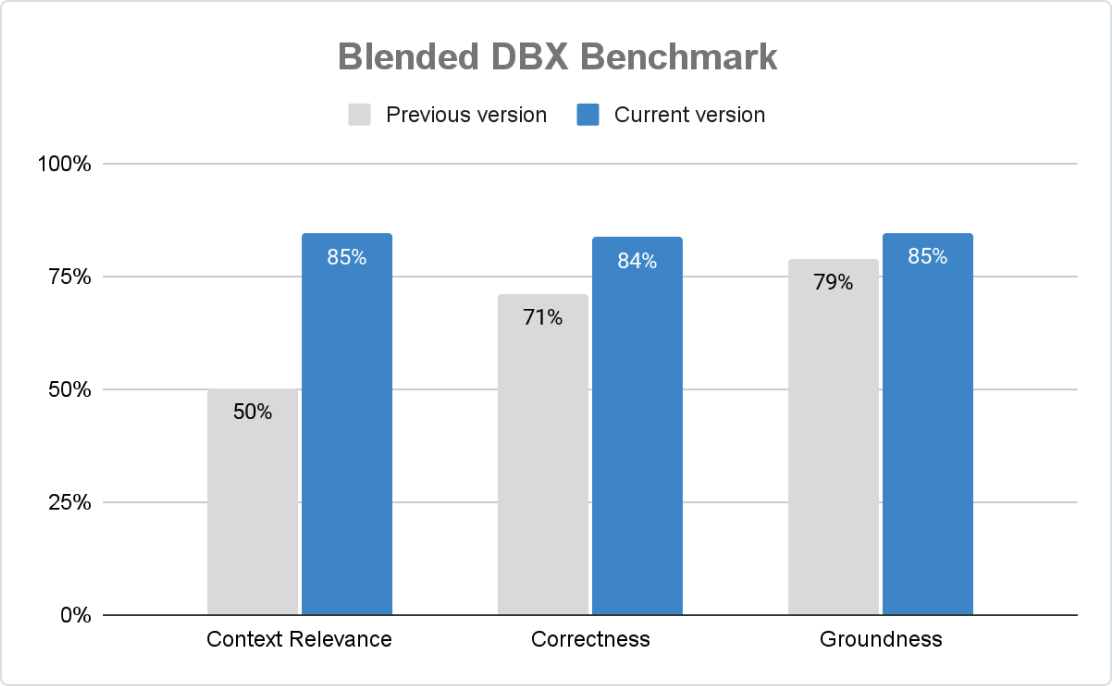

エージェントフレームワークは、スケールでの正確で安全な、そして統制されたGenAIアプリケーションを保証します。モザイクAIエージェント評価を使用すると、組織はルールベースのチェック、LLM判定、人間のフィードバックでスコアリングをカスタマイズでき、組み込みのAI支援評価と直感的なUIが継続的な改善を推進します。

迅速な開発イテレーション

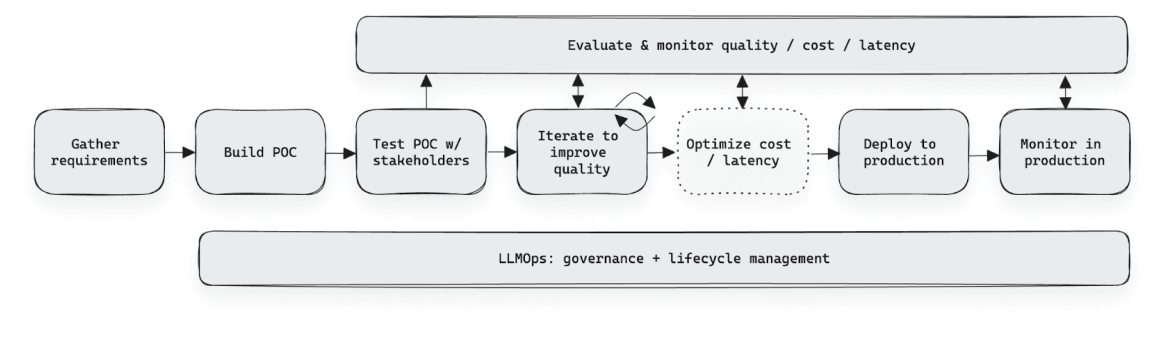

エージェントフレームワークは、フィードバックの収集と評価を効率化することでGenAIの開発を加速します。エージェント評価レビューアプリを使用すると、ドメイン専門家は評価、ラベル付け、基準の定義を行うことができます—スプレッドシートやカスタムツールは必要ありません。構造化されたフィードバックは、パフォーマンスの洗練、精度の向上、コードの変更なしでのシーム�レスな再デプロイをチームに助け、同時にガバナンスとセキュリティを確保します。

ガバナンスとガードレール

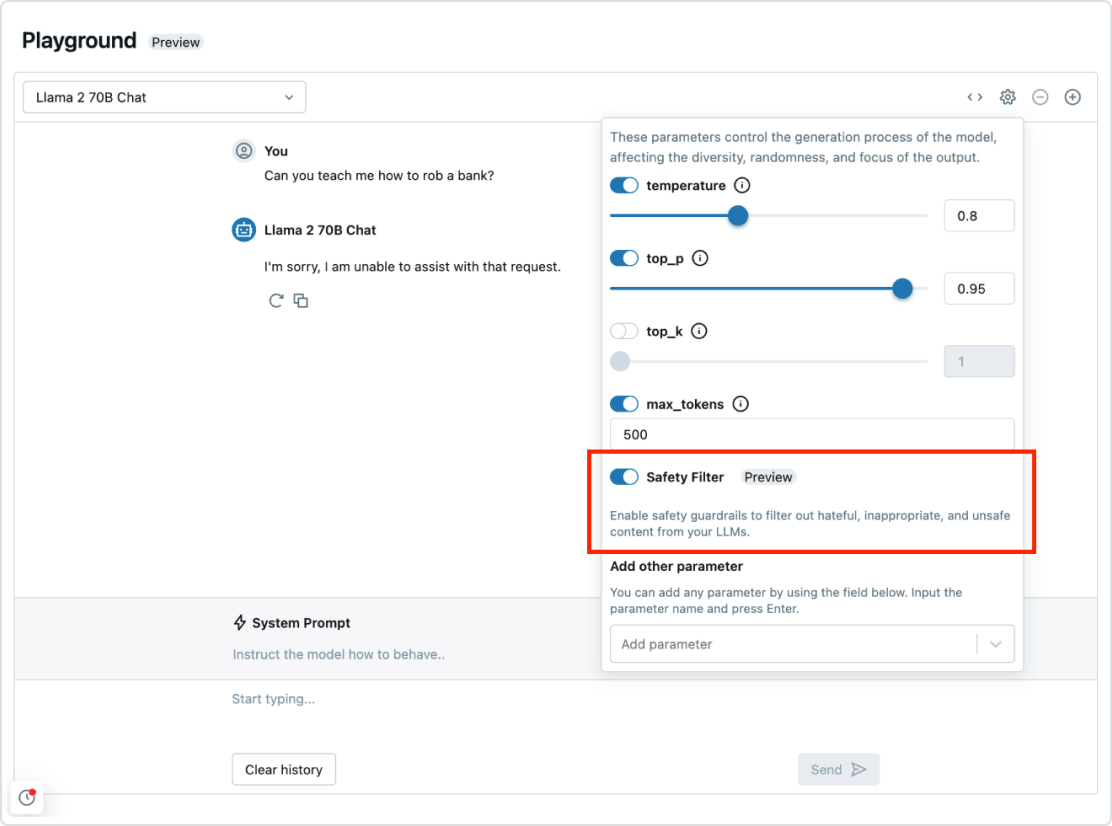

Mosaic AI エージェントフレームワークは、Databricks のデータ・インテリジェンス・プラットフォームの他の全ての部分とシームレスに統合されています。これにより、セキュリティやガバナンス、データ統合、ベクターデータベース、品質評価、ワンクリックで最適化されたデプロイメントまで、エンドツーエンドのRAG システムをデプロイするために必要なものが全て揃います。ガバナンスとガードレールが整備されていることで、有害な応答を防止し、アプリケーションが組織のポリシーに従うことを確保できます。

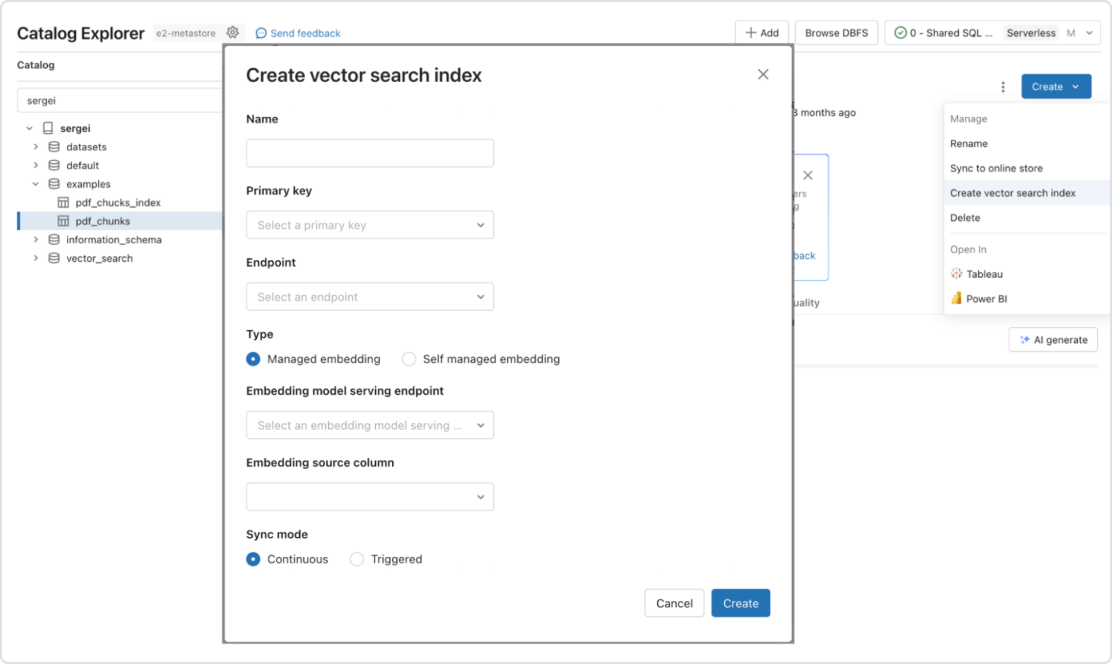

あらゆる種類のデータに対応する自動化されたリアルタイムパイプライン

Mosaic AI は、オンライン検索のためのデータ提供とインデックス作成をネイティブにサポートします。非構造化データ(テキスト、画像、動画)の場合、Vector Search が自�動的にインデックス化してデータを提供するため、個別のデータパイプラインを作成することなく、RAG アプリケーションからデータにアクセスすることができます。Vector Search は、障害の管理、再試行の処理、バッチサイズの最適化を行い、最高のパフォーマンス、スループット、コストを提供します。構造化データについては、Feature and Function Serving がユーザーやアカウントデータを含むコンテキストデータのクエリをミリ秒単位で提供します。これらのデータは、企業がプロンプトに注入し、ユーザー情報に基づいてカスタマイズすることがよくあります。