데��이터브릭스 Lakeflow 소개: 데이터 엔지니어링을 위한 통합 지능형 솔루션

데이터베이스, 엔터프라이즈 앱, 클라우드 소스에서 데이터를 수집하고, 배치 작업과 실시간 스트리밍으로 변환하여 프로덕션 환경에서 자신 있게 배포 및 운영하세요.

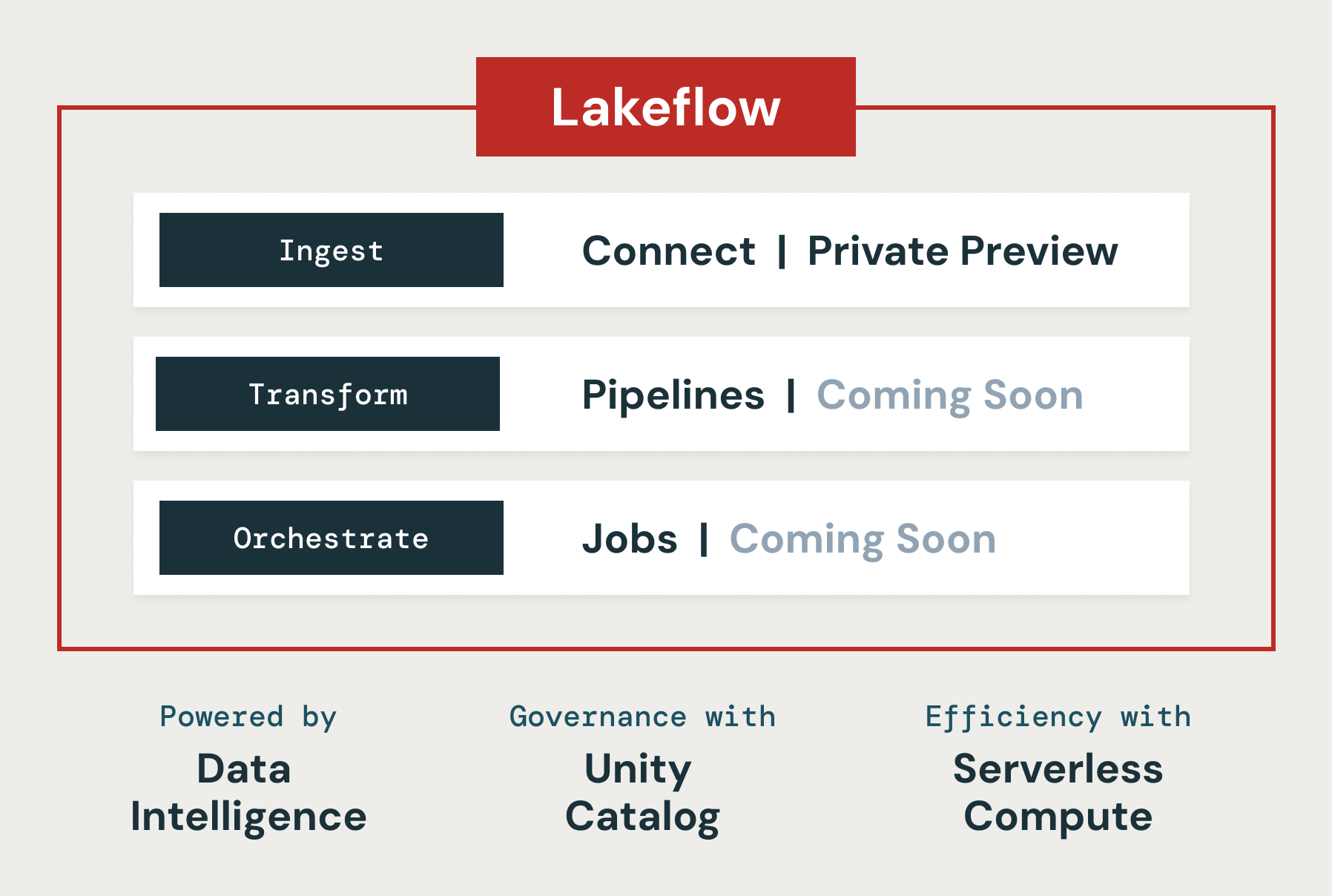

오늘, 프로덕션 데이터 파이프라인 구축과 운영에 필요한 모든 것이 포함된 새로운 솔루션 Databricks Lakeflow를 발표하게 되어 기쁩니다. 이 솔루션에는 SQL Server와 같은 데이터베이스와 Salesforce, Workday, Google Analytics, ServiceNow, SharePoint와 같은 엔터프라이즈 애플리케이션을 위한 확장성있는 새로운 네이티브 커넥터가 포함되어 있습니다. 사용자는 표준 SQL과 Python을 사용해 배치 및 스트리밍 방식으로 데이터를 변환할 수 있습니다. 또한, 마이크로배치보다 훨씬 빠른 지연 시간으로 스트림 처리가 가능한 Apache Spark용 실시간 모드도 발표할 예정입니다. 마지막으로, CI/CD를 사용해 워크플로를 오케스트레이션 및 모니터링하고 프로덕션에 배포할 수 있습니다. Databricks Lakeflow는 데이터 인텔리전스 플랫폼에 기본 탑재되어 서버리스 컴퓨팅과 Unity Catalog를 통한 통합 거버넌스를 제공합니다.

이 블로그 포스트에서는 데이터 팀들이 신뢰할 수 있는 데이터와 AI에 대한 증가하는 수요를 충족하는 데 Lakeflow가 도움이 될 것이라고 믿는 이유와 함께, 단일 제품 경험으로 통합된 Lakeflow의 주요 기능에 대해 논의합니다.

신뢰성 높은 데이터 파이프라인 구축 및 운영의 과제

데이터 엔지니어링 - 신뢰성 높은 고품질의 최신 데이터를 수집하고 준비하는 것 - 은 기업에서 데이터와 AI를 대중화하는 데 필수적인 요소입니다. 그러나 이를 달성하는 것은 여전히 복잡하며 많은 다양한 도구들을 연결해야 합니다.

우선, 데이터 팀은 각각 고유한 형식과 접근 방식을 가진 여러 시스템에서 데이터를 수집해야 합니다. 이를 위해서는 데이터베이스와 기업용 애플리케이션을 위한 내부 커넥터를 구축하고 유지 관리해야 합니다. 기업용 애플리케이션의 API 변경 사항을 따라가는 것만으로도 전체 데이터 팀이 풀타임으로 일해야 할 정도입니다. 그 다음, 데이터는 배치와 스트리밍 방식 모두로 준비되어야 하는데, 이는 트리거링과 증분 처리를 위한 복잡한 로직을 작성하고 유지 관리해야 함을 의미합니다. 지연 시간이 급증하거나 장애가 발생하면, 긴급 호출을 받게 되고 데이터 소비자들이 불만을 제기하며 심지어 기업의 수익에 영향을 미치는 업무 중단까지 발생할 수 있습니다. 마지막으로, 데이터 팀은 CI/CD를 사용하여 이러한 파이프라인을 배포하고 데이터 자산의 품질과 리니지(계보)를 모니터링해야 합니다. 이는 일반적으로 Prometheus나 Grafana와 같은 완전히 새로운 도구를 배포하고, 학습하고, 관리해야 함을 의미합니다.

이것이 바로 우리가 데이터 인텔리전스를 기반으로 한 데이터 수집, 변환, 그리고 오케스트레이션을 위한 통합 솔루션인 Lakeflow를 개발하기로 결정한 이유입니다. Lakeflow의 세 가지 주요 구성 요소는 Lakeflow Connect, Lakeflow Pipelines, 그리고 Lakeflow Jobs입니다.

Lakeflow Connect: 간단하고 확장성있는 데이터 수집

Lakeflow Connect는 SQL Server와 같은 데이터베이스와 Salesforce, Workday, Google Analytics, ServiceNow와 같은 기업용 애플리케이션에서 point-and-click 방식의 데이터 수집을 제공합니다. 로드맵에는 MySQL, Postgres, Oracle과 같은 데이터베이스뿐만 아니라 NetSuite, Dynamics 365, Google Ads와 같은 기업용 애플리케이션도 포함되어 있습니다. Lakeflow Connect는 또한 SharePoint와 같은 소스에서 PDF와 Excel 스프레드시트 같은 비정형 데이터도 수집할 수 있습니다.

이는 클라우드 스토리지(�예: S3, ADLS Gen2, GCS) 및 메시지큐(예: Kafka, Kinesis, Event Hub, Pub/Sub 커넥터)를 위한 인기 있는 기본 커넥터와 Fivetran, Qlik, Informatica 등의 파트너 솔루션을 보완합니다.

우리는 특히 Arcion 인수를 통해 강화된 데이터베이스 커넥터에 대해 매우 기대하고 있습니다. 엄청난 양의 가치 있는 데이터가 운영 데이터베이스에 갇혀 있습니다. Lakeflow는 운영 및 확장 문제에 부딪히는 단순한 접근 방식 대신, 변경 데이터 캡처(CDC) 기술을 사용하여 이 데이터를 레이크하우스로 간단하고 안정적이며 운영 효율적으로 가져올 수 있게 합니다.

Lakeflow Connect를 사용하는 데이터브릭스 고객들은 간단한 수집 솔루션이 생산성을 향상시키고 데이터에서 인사이트를 얻는 과정을 더 빠르게 만든다는 것을 발견했습니다. 웨어러블 인슐린 관리 시스템인 Omnipod의 제조업체인 Insulet은 Salesforce 수집 커넥터를 사용하여 고객 피드백 관련 데이터를 데이터브릭스 기반으로 구축된 데이터 솔루션으로 수집합니다. 이 데이터는 Databricks SQL을 통해 분석에 사용되어 품질 문제에 대한 인사이트를 얻고 고객 불만을 추적합니다. Insulet 팀은 Lakeflow Connect의 새로운 기능을 사용하면서 주목할만한 가치를 발견했습니다.

"데이터브릭스의 새로운 Salesforce 수집 커넥터를 통해 취약하고 문제가 많은 미들웨어를 제거함으로써 데이터 통합 프로세스를 크게 간소화했습니다. 이러한 개선 덕분에 Databricks SQL이 데이터브릭스 내에서 Salesforce 데이터를 직접 분석할 수 있게 되었습니다. 그 결과, 데이터 실무자들은 이제 거의 실시간으로 업데이트된 인사이트를 제공하여 대기 시간을 며칠에서 몇 분으로 단축할 수 있게 되었습니다." - Bill Whiteley, AI, 분석 및 고급 알고리즘 부문 선임 이사, Insulet

Lakeflow Pipelines: 효율적인 선언적 데이터 파이프라인

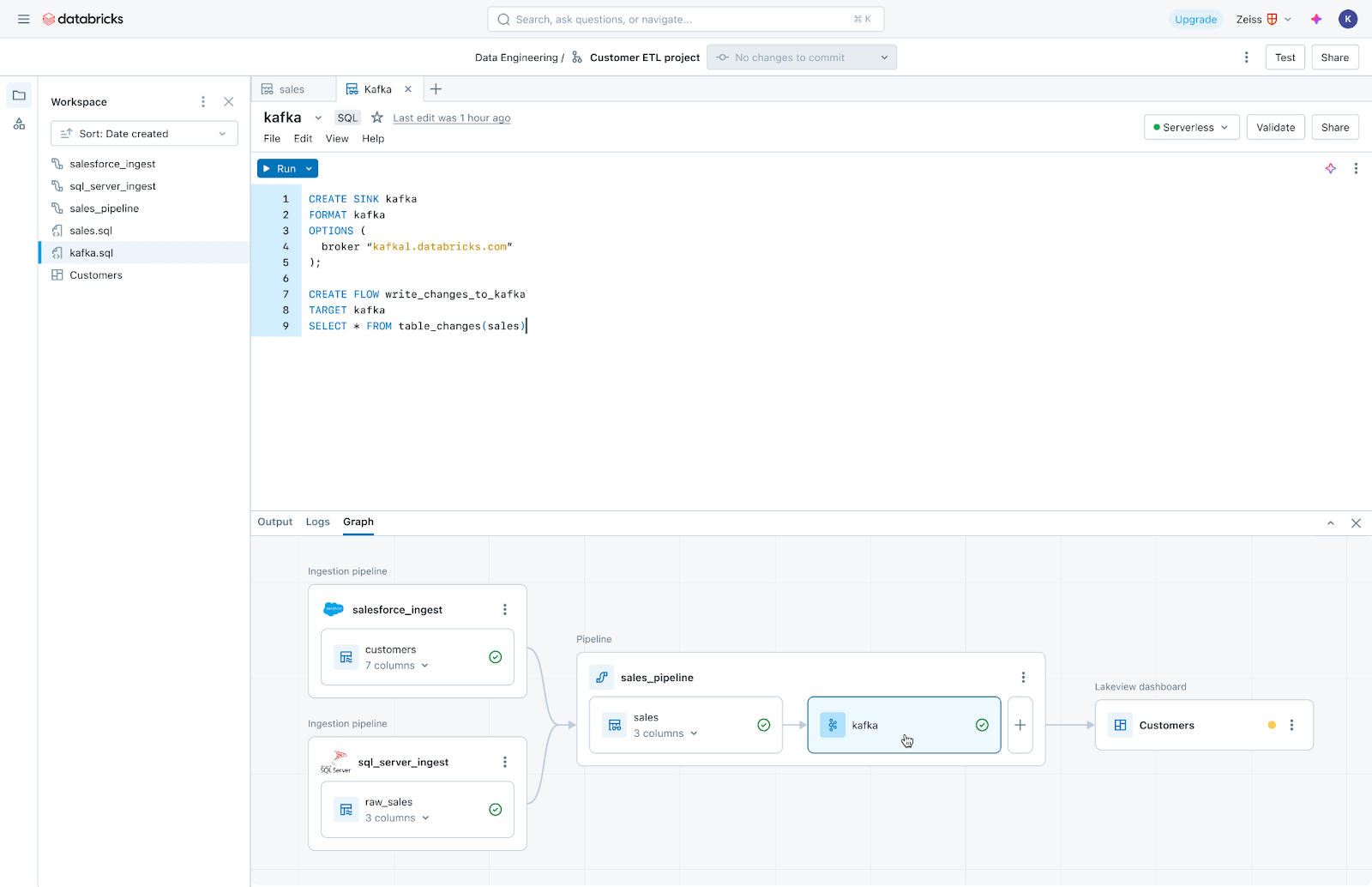

Lakeflow Pipelines는 효율적인 배치 및 스트리밍 데이터 파이프라인 구축과 관리의 복잡성을 줄여줍니다. 선언적 Delta Live Tables 프레임워크를 기반으로 구축되어 SQL과 Python으로 비즈니스 로직을 자유롭게 작성할 수 있으며, 데이터브릭스가 사용자를 대신해 데이터 오케스트레이션, 증분 처리, 컴퓨팅 인프라 자동 확장을 자동화합니다. 또한, Lakeflow Pipelines는 내장된 데이터 품질 모니터링 기능을 제공하며, 실시간 모드를 사용하면 코드 변경 없이 시간에 민감한 데이터셋을 일관되게 짧은 지연 시간으로 전송할 수 있습니다.

Gartner®: Databricks 클라우드 데이터베이스 리더

Lakeflow Jobs: 모든 워크로드를 위한 안정적인 오케스트레이션

Lakeflow Jobs는 프로덕션 워크로드를 안정적으로 오케스트레이션하고 모니터링합니다. Databricks Workflows의 고급 기능을 기반으로 구축되어 수집, 파이프라인, 노트북, SQL 쿼리, 머신 러닝 교육, 모델 배포 및 추론을 포함한 모든 워크로드를 오케스트레이션합니다. 또한 데이터 팀은 트리거, 분기 및 루핑을 활용하여 복잡한 데이터 전송 사용 사례에 적용할 수 있습니다.

Lakeflow Jobs는 또한 데이터 상태를 파악하고 전달을 추적하는 과정을 자동화, 단순화합니다. 이는 데이터 중심의 상태 관점으로 수집, 변환, 테이블 및 대시보드 간의 관계를 포함한 전체 리니지(계보)를 데이터 팀에게 제공합니다. 또한, 데이터의 신선도와 품질을 추적하여 데이터 팀이 버튼 클릭만으로 Lakehouse Monitoring을 통해 모니터링 설정을 추가할 수 있게 합니다.

데이터 인텔리전스 플랫폼 기반으로 구축

Databricks Lakeflow에는 이러한 기능을 제공하는 데이터 인텔리전스 플랫폼이 기본적으로 통합되어 있습니다:

- 데이터 인텔리전스: AI 기반 인텔리전스는 단순한 Lakeflow의 기능이 아니라 제품의 모든 측면에 영향을 미치는 기본 기능입니다. Databricks Assistant는 데이터 파이프라인의 검색, 작성 및 모니터링을 지원하므로 신뢰할 수 있는 데이터를 구축하는 데 더 많은 시간을 할애할 수 있습니다.

- 통합 거버넌스: Lakeflow는 리니지와 데이터 품질을 지원하는 Unity Catalog와도 긴밀하게 통합되어 있습니다.

- 서버리스 컴퓨팅: 대규모로 파이프라인을 빌드하고 오케스트레이션하여 인프라에 대한 걱정 없이 팀이 업무에만 집중할 수 있도록 지원합니다.

데이터 엔지니어링의 미래는 간결함, 통합적, 지능적

우리는 Lakeflow를 통해 고객이 더 신선하고 완전하며 고품질의 데이터를 비즈니스에 제공할 수 있게 될 것이라고 믿습니다. Lakeflow는 곧 Lakeflow Connect를 시작으로 미리 보기에 들어갈 예정입니다. 액세스 권한을 요청하려면 여기에서 등록하세요. 앞으로 몇 달 동안 추가 기능이 제공될 예정이므로, 더 많은 Lakeflow 공지를 기대해 주세요.

(번역: Youngkyong Ko) Original Post