Best Practices für KI-Governance: Wie man verantwortungsvolle und effektive KI-Programme aufbaut

Summary

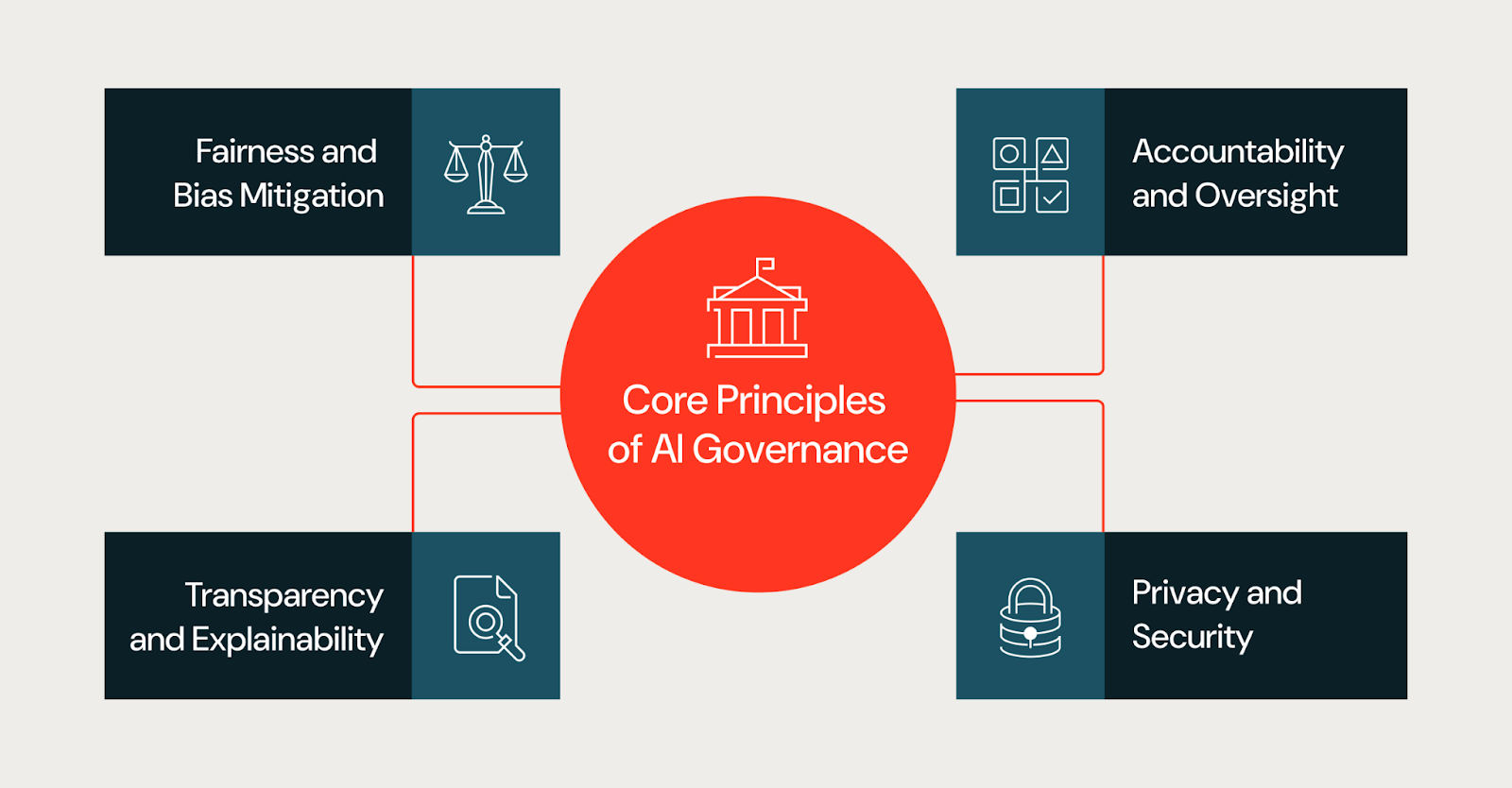

- Enterprise-KI-Governance verwaltet Risiko, Compliance und Vertrauen, wenn KI-Systeme in risikoreiche Produktionsanwendungen übergehen, und stützt Entscheidungen auf Prinzipien wie Fairness, Transparenz, Rechenschaftspflicht, Datenschutz, Sicherheit und integrierte Schutzmaßnahmen.

- Effektive Governance-Frameworks gleichen die Aufsicht mit dem Geschäftsrisiko ab, definieren klare funktionsübergreifende Rollen und Richtlinien, integrieren Kontrollpunkte über den gesamten KI-Lebenszyklus hinweg und stützen sich auf strukturierte Risikobewertungen, Monitoring, Reaktion auf Vorfälle und standardisierte Dokumentation.

- Skalierbare Programme nutzen zentralisierte Standards mit föderierter Ausführung, Human-in-the-Loop für risikoreiche Entscheidungen, proaktives Tracking sich entwickelnder Vorschriften und eine starke Unterstützung durch die C-Suite, sodass Governance zu einem Wegbereiter für verantwortungsvolle KI-Innovationen wird und nicht zu einem Engpass.

Warum KI-Governance für Unternehmen jetzt wichtig ist

Die Einführung von KI in Unternehmen beschleunigt sich rapide, angetrieben durch Fortschritte in der generativen KI. Diese Modelle lernen aus Daten, verändern sich bei geänderten Eingaben und entwickeln sich mit Trainingstechniken und Datensätzen weiter.

Doch auch wenn die Modelle immer ausgefeilter und genauer werden, bergen hochmoderne LLMs und KI-Projekte nach wie vor Unternehmensrisiken, insbesondere wenn sie in der Produktion angewendet werden. Die Folge ist, dass die KI-Governance wichtiger ist als je zuvor und Unternehmen eine robuste und vielschichtige Strategie benötigen.

Die wichtigsten Säulen der Governance sind:

- Datenzugriffskontrollen und Berechtigungen

- Datenherkunft und vollständige Beobachtbarkeit

- Integrierte KI-Sicherheitsmaßnahmen zum Schutz von PII und zum Blockieren unsicherer Inhalte

- Compliance und regulatorische Anforderungen

Was sind die Ziele eines KI-Governance-Frameworks?

Best Practices für die KI-Governance bieten eine strukturierte Möglichkeit, um sicherzustellen, dass KI-Systeme verantwortungsvoll entwickelt, angewendet und betrieben werden. Darüber hinaus stehen diese Praktiken im Einklang mit den Geschäftszielen, steuern das Risiko über den gesamten KI-Lebenszyklus hinweg und schaffen Vertrauen bei Nutzern und Stakeholdern.

Auch der regulatorische Druck auf den Einsatz von KI nimmt zu. Regierungen und Normungsgremien stoßen neue Diskussionen über Transparenz, Rechenschaftspflicht und Aufsicht von KI-Systemen an und geben den Nutzern eine Reihe von theoretischen und praktischen Rahmenwerken an die Hand, auf denen sie ihre Governance aufbauen können. So bilden beispielsweise die KI-Prinzipien der OECD eine wertebasierte Grundlage für einen KI-Governance-Rahmen, während der KI-Act der Europäischen Union einen risikobasierten Rahmen mit erhöhten Anforderungen für KI-Anwendungsfälle mit hohem Risiko festlegt.

Über die reine Compliance hinaus hat die KI-Governance einen direkten Geschäftswert. Organisationen mit klaren Governance-Strukturen sind besser positioniert, um:

- Vertrauen der Stakeholder in KI-gestützte Entscheidungen gewinnen

- Betriebliche und rechtliche Risiken reduzieren

- KI-Systeme team- und anwendungsfallübergreifend effizienter skalieren

- Verantwortlichkeit und Kontrolle mit zunehmender Reife von KI-Programmen nachweisen

Allgemeine Herausforderungen, die eine Governance erforderlich machen

Viele Unternehmen stehen bei der zunehmenden Einführung von KI vor ähnlichen Herausforderungen:

- Unklare Zuständigkeit: Die Verantwortung für die Ergebnisse von KI ist oft auf Daten-, Engineering-, Rechts- und Geschäftsteams verteilt. Teams liefern möglicherweise Modelle aus, aber kein einzelnes Team ist für die Ergebnisse verantwortlich.

- Sich schnell entwickelnde Tools: Neue KI und GenAI verbessern sich rasant, und die schiere Geschwindigkeit ihrer Entwicklung bedeutet, dass es ihnen möglicherweise an angemessenen Kontrollen und Prozessen mangelt.

- Fragmentierte Daten und Prozesse: Daten, Training, Bereitstellung und Monitoring können sich in separaten Systemen befinden, was die Beaufsichtigung und eine konsistente Dokumentation erschwert.

- Begrenzte Prüfbarkeit: Der Nachweis, wie ein KI-System trainiert, bewertet und angewendet wurde, kann ohne Governance-Artefakte zeitaufwändig oder unmöglich sein.

Diese Herausforderungen unterstreichen, warum Governance von Anfang an beabsichtigt und in Kernprozesse eingebettet sein muss, anstatt sie erst nach Auftreten von Problemen nachzurüsten.

Grundprinzipien für eine effektive KI-Governance

Governance gilt für KI-Systeme als Ganzes, einschließlich Daten, Prompts, Workflows, menschlicher Entscheidungspunkte und nachgelagerter Anwendungen, und nicht nur für einzelne Modelle. Viele Unternehmensrisiken entstehen durch die Interaktion dieser Komponenten und nicht durch das Modell selbst. Best Practices für KI-Governance basieren auf einem konsistenten Satz grundlegender Prinzipien. Diese Prinzipien leiten Entscheidungen während des gesamten KI-Lebenszyklus und bieten einen gemeinsamen Rahmen für Teams mit unterschiedlichen Zuständigkeiten.

Fairness und Bias-Minderung

Bias kann durch Trainingsdaten, die Feature-Auswahl oder den Bereitstellungskontext entstehen und zu unterschiedlichen Ergebnissen in verschiedenen Bevölkerungsgruppen führen. Governance-Programme sollten von Teams verlangen, Fairness-Risiken frühzeitig zu bewerten, bekannte Einschränkungen zu dokumentieren und auf unbeabsichtigten Bias zu überwachen, während sich Modelle in der Produktion weiterentwickeln.

In der Praxis bewerten Teams die Fairness, indem sie Trainingsdaten auf Repräsentationslücken untersuchen, die Modellausgaben über demografische Gruppen hinweg testen und vor der Bereitstellung Fairness-Metriken definieren. Gängige Ansätze umfassen die disaggregierte Bewertung, Bias-Audits während der Entwicklung und das kontinuierliche Monitoring auf Drift in der Produktionsumgebung. Teams sollten außerdem bekannte Einschränkungen und Grenzfälle dokumentieren, in denen das Modell möglicherweise eine unterdurchschnittliche Leistung erbringt.

Transparenz und Erklärbarkeit

Transparenz hilft Stakeholdern zu verstehen, wie KI-Systeme entwickelt werden und wie sie die Ergebnisse beeinflussen. Das bedeutet nicht, dass man volle Einsicht in die proprietäre Modellarchitektur oder die Trainingsdaten eines Anbieters verlangen sollte, da Anbieter geschlossener Modelle diese Details in der Regel nicht preisgeben. Stattdessen konzentriert sich die Transparenz auf das, was eine Organisation kontrollieren und dokumentieren kann.

Dies umfasst Klarheit darüber, welche Modelle und Versionen ein Team möglicherweise verwendet, welche Daten es an sie übergibt, wie es sie anstößt oder verfeinert und welche Bewertungskriterien ein Team vor der Bereitstellung anwenden könnte. Teams sollten auch die Entscheidungslogik auf der Anwendungsebene dokumentieren, um zu erklären, wie Modellausgaben in nachgelagerten Workflows verwendet, gefiltert oder außer Kraft gesetzt werden. Für Stakeholder, die Erklärungen benötigen, wie z. B. Regulierungsbehörden, Führungskräfte oder betroffene Nutzer, besteht das Ziel darin, einen angemessenen Kontext dafür bereitzustellen, wie das System zu seinen Ergebnissen gelangt, selbst wenn das zugrunde liegende Modell eine Blackbox ist.

Rechenschaftspflicht und Aufsicht

Effektive Governance definiert klare Zuständigkeiten für KI-Systeme. Jedes Modell und jede KI-Anwendung sollte verantwortliche Personen oder Teams haben, die für Ergebnisse, Risikomanagement und Compliance mit internen Richtlinien zuständig sind. Aufsichtsmechanismen stellen sicher, dass die Verantwortung auch nach der Bereitstellung bestehen bleibt, anstatt zu verschwinden, sobald ein Modell ausgeliefert wird.

Datenschutz und Sicherheit

KI-Systeme verarbeiten oft sensible oder regulierte Daten, und die Governance muss sicherstellen, dass Datenschutz- und Sicherheitskontrollen konsequent angewendet werden, einschließlich rollenbasierter Zugriffskontrolle, PII-Filter und Filterung unsicherer Ausgaben. Datenschutz- und Sicherheitsaspekte sollten während des gesamten KI-Lebenszyklus integriert und nicht erst zum Zeitpunkt der Bereitstellung berücksichtigt werden.

Integrierte Sicherheitsvorkehrungen

KI-Systeme benötigen Leitplanken, die schädliche oder unbeabsichtigte Ausgaben verhindern. Eingebaute Schutzmaßnahmen umfassen die Eingabevalidierung zum Abfangen fehlerhafter oder gegnerischer Abfragen, Ausgabefilter, die unsichere oder unangemessene Inhalte blockieren, die PII-Erkennung zur Verhinderung der Datenexposition und die Inhaltsmoderation für Anwendungen mit Nutzerkontakt. Diese Kontrollen sollten nach Risikostufe konfigurierbar sein; ein internes Tool mit geringem Risiko benötigt möglicherweise leichtere Schutzmaßnahmen als ein Agent mit Kundenkontakt.

Einheitlicher Zugriff für Modelle und KI-Projekte

Wenn Unternehmen die KI-Einführung skalieren, sollte der Zugriff auf Modelle und KI-Projekte über ein zentrales Framework geregelt werden. Einheitliche Zugriffskontrollen gewährleisten konsistente Berechtigungen über Entwicklungs-, Staging- und Produktionsumgebungen hinweg. Dazu gehören der rollenbasierte Zugriff darauf, wer Modelle ansehen, ändern oder anwenden kann, Audit-Trails, die Änderungen und die Nutzung nachverfolgen, sowie die Integration mit Identitätsmanagementsystemen. Der zentralisierte Zugriff reduziert das Risiko von Schatten-KI-Projekten und erleichtert den Nachweis der Compliance. Ohne einheitliche Zugriffskontrollen haben Unternehmen oft mit „Schatten-KI“ (Modelle und Anwendungen, die ohne formale Aufsicht angewendet werden) zu kämpfen, was zu einem der größten Hindernisse für eine konsistente Governance bei der Scale wird.

Aufbau eines praktischen KI-Governance-Rahmens

Während Governance-Grundsätze definieren können, wie eine gute Governance aussieht, definieren Frameworks, wie diese Organisationen ihre Prozesse umsetzen. Mit anderen Worten: Ein praktisches KI-Governance-Framework übersetzt übergeordnete Ziele in spezifische Rollen, Richtlinien und Kontrollen, die zur Gesamtstruktur und Risikotoleranz einer Organisation passen.

Ein Beispiel für einen strukturierten Ansatz zur Definition von Governance-Säulen und Key Überlegungen finden Sie im KI-Governance-Framework von Databricks.

Governance mit Geschäftszielen in Einklang bringen

Unternehmen erzielen bessere Ergebnisse, wenn die Governance auf die geschäftlichen Auswirkungen und das Risiko abgestimmt ist. Nicht jedes KI-System erfordert das gleiche Maß an Aufsicht. Ein Chatbot, der externe Dokumente zusammenfasst, birgt ein anderes Risiko als ein Modell, das Kredite genehmigt oder medizinische Fälle priorisiert.

Governance-Rollen und -Strukturen festlegen

Damit KI-Governance möglichst effektiv ist, muss sie funktionsübergreifend sein. Dies erfordert eine kontinuierliche und gezielte Zusammenarbeit zwischen Daten- und KI-Teams, Rechts- und Compliance-Abteilungen, Datenschutz- und Sicherheitsexperten sowie den Stakeholdern aus dem Geschäftsbereich. Gängige Strukturen umfassen:

- Funktionsübergreifende Governance-Ausschüsse

- Klar definierte RACI-Modelle

- „Human-in-the-Loop“-Anforderungen für Entscheidungen mit hohem Risiko

- Rollenbasierte Zugriffskontrolle

Diese Strukturen klären Entscheidungsrechte und verringern Unklarheiten bei der Skalierung von KI-Programmen.

KI-Richtlinien, Standards und Kontrollen definieren

Klare Standards reduzieren Reibungsverluste. Effektive Governance-Frameworks legen fest:

- Erforderliche Dokumentation und Artefakte

- Kriterien zur Klassifizierung von KI-Risiken

- Genehmigungsschwellen nach Risikostufe

- Expectations, Reaktion auf Vorfälle und Audits

Wenn Standards vage bleiben, erfinden Teams lokale Interpretationen. Wenn Standards konkret bleiben, arbeiten Teams schneller und mit weniger Überraschungen.

Operationalisierung der KI-Governance

KI-Governance muss in die eigentliche Struktur des Workflows integriert werden, z. B. wie Teams KI-Systeme entwerfen, bereitstellen und betreiben. Es muss jedoch mehr als nur Theorie sein; operative Governance muss praktische Fragen beantworten, wie zum Beispiel, wer entscheidet, welche Nachweise Teams erbringen müssen und wie Systeme im Laufe der Zeit konform bleiben. Das Ergebnis ist ein expliziter Prozess, dem Teams folgen können, um KI-Governance in ihre Workflows zu integrieren.

Integration der Governance in den KI-Entwicklungslebenszyklus

Die meisten Unternehmen entwickeln Foundation Models nicht von Grund auf neu. Sie kombinieren bestehende Modelle mit proprietären Daten, um KI-Projekte, -Agenten und -Anwendungen zu erstellen. Die Governance sollte diese Realität widerspiegeln, indem sie Prüfpunkte direkt in den Entwicklungslebenszyklus einbettet. Beispielsweise kann ein interner KI-Assistent, der externe Dokumente zusammenfasst, anfangs als risikoarm eingestuft werden. Wenn dasselbe System später Kunden zur Verfügung gestellt oder zur Fundierung regulierter Entscheidungen verwendet wird, ändert sich sein Risikoprofil, was neue Genehmigungen, Sicherheitsvorkehrungen und Monitoring erfordert.

- Umfang und Zweck definieren. Dokumentieren Sie vor Beginn der Entwicklung den beabsichtigten Verwendungszweck, die unzulässigen Verwendungszwecke und den Entscheidungskontext des Systems. Dies verhindert Scope Creep, bei dem Systeme ohne Überprüfung in Szenarien mit höherem Risiko wiederverwendet werden.

- Datenquellen dokumentieren. Erfassen Sie Dateninhaberschaft, Einschränkungen bei der Einwilligung und bekannte Beschränkungen. Wenn Teams nicht erklären können, woher die Daten stammen und warum sie geeignet sind, sollten sie sie nicht verwenden, um ein System zu erstellen oder feinabzustimmen.

- Bewertungskriterien festlegen. Legen Sie vor dem Testen Metriken, Schwellenwerte und akzeptable Kompromisse fest. Teams sollten dokumentieren, warum sie bestimmte Metriken gewählt und welche Fehlermodi sie beobachtet haben. Dadurch wird die Bewertung zu einem Entscheidungsprotokoll für zukünftige Referenzzwecke.

- Release-Gates durchsetzen. Benannte Verantwortliche, eine vollständige Dokumentation und eine auf die Risikostufe des Systems abgestimmte Freigabe sind erforderlich. Definieren Sie Rollback-Kriterien, damit die Teams wissen, wann ein System aus der Produktion genommen werden muss.

- Überwachen und überprüfen. Überprüfen Sie nach der Bereitstellung das Produktionsverhalten, validieren Sie Annahmen anhand der tatsächlichen Nutzung und dokumentieren Sie Änderungen im Laufe der Zeit.

KI-Risikobewertungen durchführen

Die Risikobewertung ist das Herzstück der praktischen Governance. Sie bestimmt, wie viel Kontrolle ein System benötigt und worauf Teams ihre Aufmerksamkeit richten sollten. Wenn Teams effektive Bewertungen anwenden, sollten sie sich auf einige wenige Fragen konzentrieren:

- Wen betrifft dieses System?

- Welche Entscheidungen beeinflusst oder automatisiert es?

- Was passiert, wenn es ausfällt?

- Wie einfach können Menschen eingreifen?

- Welche Sensibilität weisen die Daten auf?

Sobald die Teams Antworten auf diese Fragen gesammelt haben, können sie eine Risikostufe zuweisen, was eine Möglichkeit ist, eine Beurteilung in eine Handlung zu übersetzen. Beispielsweise kann ein internes Tool mit geringem Risiko eine schlanke Dokumentation und eine regelmäßige Überprüfung erfordern, während ein System mit hohem Risiko eine häufige menschliche Aufsicht, eine formelle Genehmigung und ein kontinuierliches Monitoring erfordern kann.

Risikobewertungen sollten frühzeitig erfolgen und im Laufe der Zeit kontinuierlich aktualisiert werden. Wenn Systeme auf neue Benutzer oder Anwendungsfälle ausgeweitet werden, ändert sich oft ihr Risikoprofil. Governance-Prozesse sollten so gestaltet sein, dass sie dieser Entwicklung Rechnung tragen.

Genehmigungs- und Eskalationspfade definieren

Die operative Governance hängt von klaren Entscheidungswegen ab. Teams müssen wissen, wer ein System genehmigen kann, wann eine Eskalation erforderlich ist und wie Meinungsverschiedenheiten gelöst werden können. Daher definieren Organisationen in der Regel die folgenden Entscheidungswege:

- Genehmigungsinstanzen nach Risikostufe

- Eskalations-Trigger für ungelöste Probleme

- Zeitpläne für die Überprüfung und Reaktion

- Kriterien für das Anhalten oder Zurücksetzen von Systemen

Ohne definierte Pfade kann Governance verwirrend werden und Teams können handlungsunfähig werden, da Entscheidungen ins Stocken geraten, die Verantwortung sich verflüchtigt und Teams Kontrollen umgehen, um voranzukommen. Die Schaffung klarer Pfade reduziert Unklarheiten und erhöht die Compliance, da die Teams verstehen, wie sie vorgehen sollen.

Monitoring- und Compliance-Kontrollen implementieren

Angesichts der schnellen und kontinuierlichen Entwicklung von KI-Systemen kann die KI-Governance nicht statisch sein. Im Laufe der Zeit ändern sich die Daten, Nutzungsmuster verschieben sich und die Performance lässt nach. Es ist entscheidend, dass Teams das Verhalten der KI in der Produktion überwachen, indem sie sich auf Folgendes konzentrieren:

- Performance im Vergleich zu definierten Metriken

- Datendrift und Verteilungsänderungen

- unerwartete Ein- oder Ausgaben

- Systemnutzung außerhalb des vorgesehenen Bereichs

Governance legt fest, was Teams überwachen müssen, wie oft sie die Ergebnisse überprüfen und welche Maßnahmen sie ergreifen, wenn Schwellenwerte überschritten werden. Diese Maßnahmen können eine Neutrainierung, die Einschränkung der Nutzung, die Eskalation an Prüfungsgremien oder die Abschaltung von Systemen umfassen. Indem das Monitoring in eine Feedbackschleife umgewandelt wird, können Organisationen sicherstellen, dass sie die Vorteile ihrer internen Prozesse maximieren.

Prozesse für die Reaktion auf Vorfälle und deren Behebung einrichten

Starke Governance-Frameworks müssen nicht nur eine Kultur des Feedbacks und der Rechenschaftspflicht schaffen, sondern auch Ausfälle berücksichtigen. Selbst gut konzipierte Systeme gehen im Laufe der Zeit kaputt oder ihre Leistung lässt nach.

Ein weiterer Schritt zur Governance ist die Definition, wie ein Team auf KI-Vorfälle reagiert, einschließlich verzerrter Ergebnisse, unsicheren Verhaltens, Datenlecks oder aufsichtsrechtlicher Bedenken. Teams benötigen vordefinierte Playbooks, die Folgendes spezifizieren:

- Wie Vorfälle identifiziert und klassifiziert werden

- Wer ist für die Reaktion und Kommunikation zuständig?

- Wie Schaden eingedämmt wird

- Wie man Ursachen und Abhilfemaßnahmen dokumentiert

Überprüfungen nach einem Vorfall können dazu beitragen, neue Erkenntnisse oder Aktualisierungen in die etablierte Governance zurückzuführen und so Risikobewertungen zu aktualisieren, Kontrollen zu verbessern und Richtlinien zu verfeinern. Dieser Kreislauf stellt sicher, dass sich die Governance mit den Erfahrungen aus der Praxis weiterentwickelt.

Governance-Artefakte standardisieren

Während Teams ihre Governance entwickeln, ist eine standardisierte Dokumentation wichtig für den Nachweis und die Konsistenz im gesamten System. Eine konsistente Dokumentation kann auch bei Audits helfen und den doppelten Aufwand bei der Erstellung von Dokumenten reduzieren. Unternehmen priorisieren die folgenden standardisierten Dokumente:

- Systemzusammenfassungen, die Zweck und Umfang definieren

- Datendokumentation, die Quellen und Einschränkungen festhält

- Evaluierungszusammenfassungen, die Performance und Einschränkungen erfassen

- Monitoringpläne, die eine laufende Aufsicht definieren

Governance über Teams und Domänen auf Scale ausweiten

Da die Akzeptanz von KI weiter zunimmt, muss die Governance einer Organisation skalieren können, ohne Engpässe zu verursachen. Viele Teams verwenden ein zentralisiert-föderiertes Modell, bei dem eine zentrale Gruppe Standards, Risikorahmen und Richtlinien definiert, während die Fachteams diese lokal anwenden und für die Ergebnisse verantwortlich bleiben. Dieses Modell hilft, ein Gleichgewicht zwischen Konsistenz und Geschwindigkeit zu finden.

Die Skalierung erfordert auch Training. Während sich Governance-Systeme weiterentwickeln, müssen Teams verstehen, was Governance erfordert und wie sie die Anforderungen am besten erfüllen können.

Gartner®: Databricks als Leader für Cloud-Datenbanken

Gewährleistung von Transparenz, Vertrauen und Erklärbarkeit

Vertrauen ist ein zentrales Ergebnis einer effektiven KI-Governance. Stakeholder sind eher bereit, KI-Systeme zu übernehmen und sich auf sie zu verlassen, wenn sie verstehen, wie Entscheidungen getroffen und Risiken während des gesamten KI-Lebenszyklus gemanagt werden.

„Human-in-the-Loop“-Aufsicht

Bei risikoreichen oder sensiblen Anwendungsfällen sollten Menschen die endgültige Entscheidungsgewalt über KI-gesteuerte Entscheidungen behalten. Governance-Rahmenwerke sollten definieren, wann eine menschliche Überprüfung erforderlich ist, wie Interventionen stattfinden und wie Entscheidungen dokumentiert werden.

Kommunikation von KI-Entscheidungen an Stakeholder

Unterschiedliche Stakeholder benötigen unterschiedlich ausführliche Erklärungen. Technische Teams benötigen möglicherweise detaillierte Evaluierungsmetriken, während sich Führungskräfte und Aufsichtsbehörden auf Zusammenfassungen, Modellkarten oder Entscheidungsbegründungen stützen. Klare Kommunikation schafft Vertrauen und fördert die Rechenschaftspflicht.

Mit regulatorischen und branchenspezifischen Veränderungen Schritt halten

KI-Governance ist nie abgeschlossen. Gesetze und Vorschriften entwickeln sich weiter, Standards reifen und KI-Fähigkeiten machen schnellere Fortschritte als Politikzyklen.

Mit Standards und Updates auf dem Laufenden bleiben

Organisationen bleiben auf dem Laufenden, indem sie klare Zuständigkeiten für das Monitoring von regulatorischen und normativen Änderungen zuweisen. Effektive Programme schaffen eine kleine funktionsübergreifende Gruppe, die aus Recht, Compliance, Datenschutz, Sicherheit und KI-Praktikern besteht, anstatt sich auf Ad-hoc-Updates zu verlassen.

Monitoring funktioniert am besten in einem festen Rhythmus, z. B. vierteljährlich, anstatt mit reaktiven Updates. Um proaktiv zu bleiben, sollten Teams jede Änderung bewerten, indem sie fragen:

- Betrifft dies bestehende KI-Systeme oder nur neue?

- Führt es neue Dokumentations- oder Aufsichts-Expectations ein?

- Gilt dies weltweit oder nur in bestimmten Regionen?

Diese Auswirkungsprüfungen helfen den Teams, bestehende Governance-Prozesse zu nutzen und zu verfeinern, anstatt parallele Kontrollen zu schaffen.

Vorbereitung auf zukünftige Anforderungen an die KI-Governance

Zukünftige Anforderungen an die KI-Governance werden wahrscheinlich die Expectations an Erklärbarkeit, Prüfbarkeit und Dokumentation erweitern. Organisationen können ihre Prozesse schon jetzt vorbereiten, ohne auf detaillierte Mandate zu warten.

Rückverfolgbarkeit und Erklärbarkeit: Teams sollten je nach Risikostufe und Zielgruppe definieren, welche Erklärungen sie benötigen, von technischen Überprüfungen bis hin zu Zusammenfassungen für Führungskräfte und für Aufsichtsbehörden.

Auditierbarkeit: Es ist wichtig, Entscheidungsaufzeichnungen zu führen, die zeigen, wofür ein System konzipiert wurde, wie es bewertet wurde, wer es genehmigt hat und wie es sich nach der Bereitstellung verändert hat.

Dokumentation: Die Standardisierung Ihrer Dokumentation ist entscheidend. Stellen Sie sicher, dass Ihre Governance-Teams Systemzusammenfassungen, Risikobewertungen, Evaluierungsunterlagen und Monitoringpläne dokumentieren – und diese kontinuierlich auf dem neuesten Stand halten.

Überwindung gängiger Hindernisse bei der Einführung von KI-Governance

Trotz ihrer Vorteile stellt die KI-Governance Organisationen vor ganz eigene Herausforderungen. Zu den häufigsten Hindernissen gehören:

Nachhaltigkeit. Wenn organisatorische Anreize die schnellstmögliche Bereitstellung von Modellen belohnen, können Teams Governance als Hindernis ansehen. Daten- und KI-Teams konzentrieren sich darauf, Modelle schnell anzuwenden, während Governance-Anforderungen später als unerwartete Überprüfungszyklen oder Dokumentationsaufwand auftreten.

Fragmentierte Zuständigkeit. Wenn die Verantwortung für KI-Ergebnisse auf mehrere Teams verteilt ist, können die Zuständigkeiten für die Governance unklar sein. Kein einzelnes Team ist für das Ergebnis verantwortlich, also ist auch niemand für die Kontrollen verantwortlich.

Technische Altschulden. Älteren Pipelines und Modellen fehlen oft die Metadaten, das Monitoring oder die Dokumentation, die von der Governance erwartet werden. Die Nachrüstung dieser Systeme erfordert einen Aufwand, der mit neuen Entwicklungsprioritäten konkurriert.

Strategien zur Steigerung der Akzeptanz

Erfolgreiche Governance-Programme konzentrieren sich auf Proaktivität, nicht auf reaktive Reformen. Es sollte eine konsistente Botschaft von der Führungsebene geben, warum Governance wichtig ist. Klare Kommunikation und Trainings helfen den Praktikern zu verstehen, wie sich die Governance in bestehende Arbeitsabläufe einfügt, anstatt parallele Prozesse hinzuzufügen. In der Zwischenzeit spielen Pilotinitiativen eine entscheidende Rolle, indem sie zeigen, dass Governance Nacharbeit reduziert, Produktionsvorfälle verhindert und Genehmigungen beschleunigt, sobald Standards etabliert sind. Zusammen verschieben diese Strategien die Governance von einem wahrgenommenen Hindernis zu einer praktischen Grundlage für die verantwortungsvolle Skalierung von KI.

Wie Sie mit dem Aufbau einer KI-Governance-Strategie starten

Eine starke KI-Governance hilft Organisationen, die Einführung von KI zuversichtlich zu skalieren. Merkmale wie klare Zuständigkeiten, risikobasierte Kontrollen und kontinuierliche Aufsicht reduzieren Überraschungen und halten Systeme im Einklang mit geschäftlichen und regulatorischen Erwartungen.

Teams sollten mit einer praktischen Grundlage starten: die aktuellen KI-Anwendungsfälle inventarisieren, sie nach Risiko klassifizieren und verantwortliche Eigentümer zuweisen. Governance-Kontrollen sollten für eine kleine Gruppe von Systemen mit hoher Auswirkung als Pilotprojekt eingeführt werden, um Standards zu etablieren und Prozesse zu verfeinern. Wenn Teams mehr Erfahrung sammeln, können sie die Governance auf zusätzliche Anwendungsfälle und Domänen ausweiten, wodurch die Aufsicht gestärkt wird, während die für die Aufrechterhaltung von KI-Innovationen erforderliche Geschwindigkeit und Flexibilität erhalten bleiben.

(Dieser Blogbeitrag wurde mit KI-gestützten Tools übersetzt.) Originalbeitrag

Verpassen Sie keinen Beitrag von Databricks

Was kommt als Nächstes?

IA

7. Januar 2025/8 min Lesezeit