Bekanntgabe der allgemeinen Verfügbarkeit der Modellbereitstellung von Databricks

Vereinfachtes Produktions-ML auf der Databricks Lakehouse Platform

Virtuelle ML-Veranstaltung

Wir freuen uns, die allgemeine Verfügbarkeit von Databricks Model Serving bekannt zu geben. Model Serving stellt Machine-Learning-Modelle als REST-API bereit, sodass Sie ML-Anwendungen in Echtzeit wie personalisierte Empfehlungen, Kundenservice-Chatbots, Betrugserkennung und mehr erstellen können – und das alles, ohne sich um die Verwaltung der Bereitstellungsinfrastruktur kümmern zu müssen.

Mit der Einführung von Databricks Model Serving können Sie Ihre Modelle jetzt neben Ihrer bestehenden Daten- und Trainingsinfrastruktur bereitstellen, was den ML-Lebenszyklus vereinfacht und die Betriebskosten senkt.

"Indem wir Model Serving auf derselben Plattform betreiben, auf der unsere Daten liegen und wir Modelle trainieren, konnten wir die Bereitstellungen beschleunigen und den Wartungsaufwand reduzieren. Das hilft uns letztendlich, für unsere Kunden einen Mehrwert zu schaffen und ein angenehmeres und nachhaltigeres Leben auf der ganzen Welt zu fördern."– Daniel Edsgärd, Head of Data Science bei Electrolux

Herausforderungen beim Aufbau von Echtzeit-ML-Systemen

Echtzeit-Systeme für machine learning revolutionieren die Arbeitsweise von Unternehmen, indem sie die Möglichkeit bieten, auf der Grundlage eingehender Daten sofortige Vorhersagen zu treffen oder Maßnahmen zu ergreifen. Anwendungen wie Chatbots, Betrugserkennung und Personalisierungssysteme nutzen Echtzeitsysteme, um sofortige und genaue Antworten zu liefern, und verbessern dadurch das Kundenerlebnis, steigern den Umsatz und reduzieren das Risiko.

Die Implementierung solcher Systeme bleibt jedoch eine Herausforderung für Unternehmen. Echtzeit-ML-Systeme benötigen eine schnelle und skalierbare Serving-Infrastruktur, für deren Aufbau und Wartung Expertenwissen erforderlich ist. Die Infrastruktur muss nicht nur Serving unterstützen, sondern auch Feature-Lookups, Monitoring, automatisiertes Deployment und Modell-Retraining umfassen. Dies führt oft dazu, dass Teams unterschiedliche Tools integrieren, was die betriebliche Komplexität erhöht und zu Wartungsaufwand führt. Unternehmen wenden oft mehr Zeit und Ressourcen für die Wartung der Infrastruktur auf, anstatt ML in ihre Prozesse zu integrieren.

Gartner®: Databricks als Leader für Cloud-Datenbanken

Model Serving für die Produktion auf dem Lakehouse

Databricks Model Serving ist die erste serverlose Echtzeit-Serving-Lösung, die auf einer einheitlichen Daten- und KI-Plattform entwickelt wurde. Diese einzigartige Serving-Lösung beschleunigt den Weg von Data-Science-Teams in die Produktion, indem sie Deployments vereinfacht und Fehler durch integrierte Tools reduziert.

Eliminieren Sie den Verwaltungsaufwand mit Echtzeit-Model Serving.

Databricks Model Serving bietet einen hochverfügbaren, serverlosen Dienst mit geringer Latenz für die Bereitstellung von Modellen hinter einer API. Sie müssen sich nicht mehr um die aufwändige Verwaltung einer skalierbaren Infrastruktur kümmern. Unser vollständig verwalteter Dienst nimmt Ihnen die ganze schwere Arbeit ab, sodass Sie keine Instanzen verwalten, die Versionskompatibilität aufrechterhalten oder Versionen patchen müssen. Endpoints skalieren automatisch je nach Bedarf nach oben oder unten, sparen so Infrastrukturkosten und optimieren gleichzeitig die Latenz-Performance.

„Die schnelle automatische Skalierung hält die Kosten niedrig und ermöglicht uns gleichzeitig, bei zunehmendem Datenverkehr zu skalieren. Unser Team verbringt jetzt mehr Zeit damit, Modelle zur Lösung von Kundenproblemen zu erstellen, als infrastrukturbezogene Probleme zu beheben.“ – Gyuhyeon Sim, CEO bei Letsur.ai

Beschleunigen Sie Bereitstellungen durch Lakehouse-Unified Model Serving

Databricks Model Serving beschleunigt die Bereitstellung von ML-Modellen durch native Integrationen mit verschiedenen Diensten. Sie können jetzt den gesamten ML-Prozess von der Datenaufnahme und dem Training bis hin zur Bereitstellung und dem Monitoring auf einer einzigen Plattform verwalten und erhalten so eine konsistente Ansicht über den gesamten ML-Lebenszyklus, die Fehler minimiert und das Debugging beschleunigt. Model Serving lässt sich in verschiedene Lakehouse-Dienste integrieren, darunter

- Feature-Store-Integration: Lässt sich nahtlos in den Databricks Feature Store integrieren und bietet automatisierte Online-Lookups, um Online/Offline-Skew zu verhindern – Sie definieren Features einmal während des Trainings, und wir rufen die relevanten Features automatisch ab und verknüpfen sie, um die Inferenz-Payload zu vervollständigen.

- MLflow-Integration: Stellt eine native Verbindung zur MLflow Model Registry her und ermöglicht eine schnelle und einfache Bereitstellung von Modellen – stellen Sie uns einfach das Modell zur Verfügung, und wir bereiten automatisch einen produktionsbereiten Container vor und stellen ihn auf Serverless Compute bereit.

- Qualität & Diagnose (demnächst verfügbar): Erfassen Sie automatisch Anfragen und Antworten in einer Delta-Tabelle, um Modelle zu überwachen und zu debuggen oder Trainingsdatensätze zu generieren.

- Einheitliche Governance: Verwalten und steuern Sie alle Daten- und ML-Assets, einschließlich derer, die von Model Serving genutzt und erstellt werden, mit Unity Catalog.

„Durch die Modellbereitstellung auf einer einheitlichen Daten- und KI-Plattform konnten wir den ML-Lebenszyklus vereinfachen und den Wartungsaufwand reduzieren. Dies ermöglicht es uns, unsere Bemühungen darauf auszurichten, den Einsatz von KI auf weitere Geschäftsbereiche auszuweiten.“ – Vincent Koc, Head of Data bei hipages Group

Stärken Sie Teams durch eine vereinfachte Bereitstellung

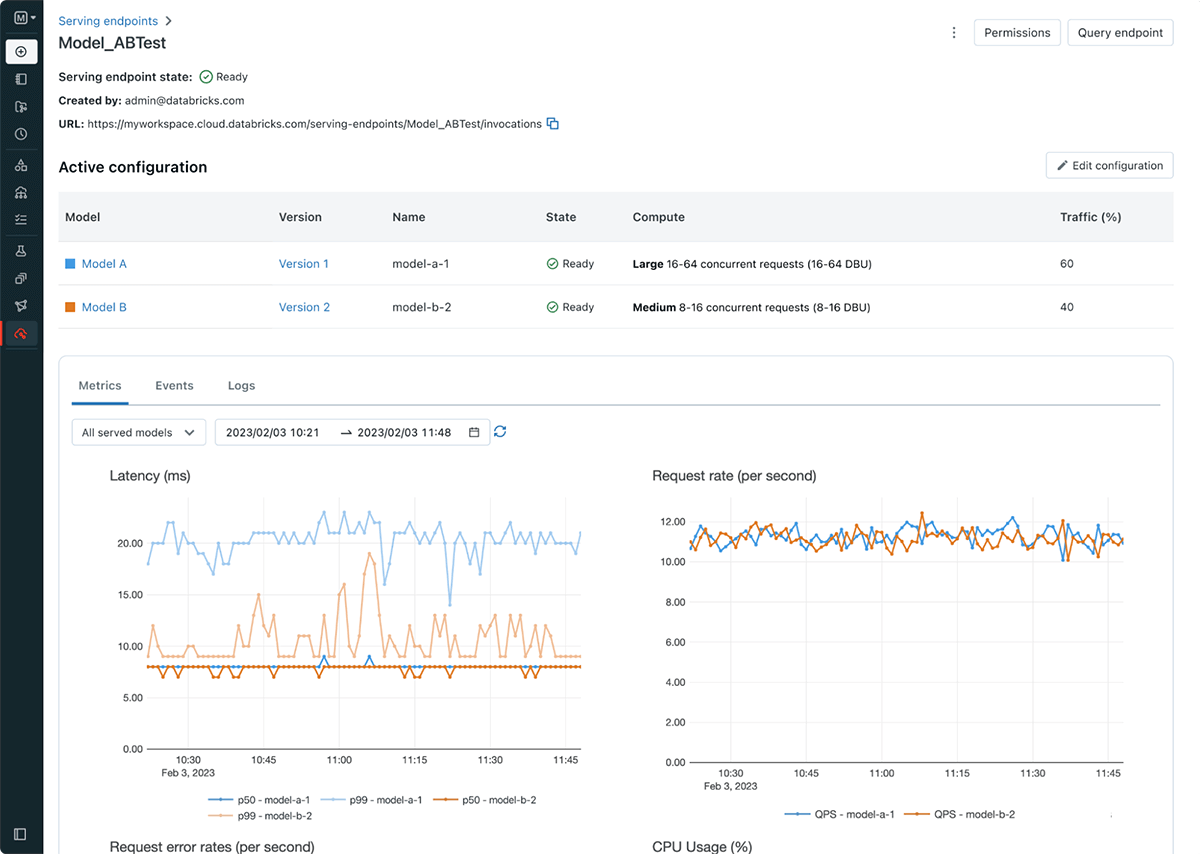

Databricks Model Serving vereinfacht den Workflow für die Modellbereitstellung und befähigt Data Scientists, Modelle ohne komplexe Infrastrukturkenntnisse oder -erfahrung bereitzustellen. Im Rahmen der Einführung werden auch Serving-Endpunkte eingeführt, die die Modellregistrierung und den Scoring-URI entkoppeln, was zu effizienteren, stabileren und flexibleren Bereitstellungen führt. Sie können jetzt beispielsweise mehrere Modelle hinter einem einzigen Endpunkt bereitstellen und den Traffic wie gewünscht auf die Modelle verteilen. Die neue Serving-Benutzeroberfläche und die neuen APIs erleichtern das Erstellen und Verwalten von Endpoints. Endpoints bieten außerdem integrierte Metriken und Logs, die Sie zur Überwachung und zum Empfang von Benachrichtigungen verwenden können.

Erste Schritte mit Databricks Model Serving

- Registrieren Sie sich für die bevorstehende Konferenz, um zu erfahren, wie Databricks Model Serving Ihnen helfen kann, Echtzeitsysteme zu erstellen und Einblicke von Kunden zu erhalten.

- Probieren Sie es aus! Starten Sie die Bereitstellung von ML-Modellen als REST-API

- Weitere Informationen finden Sie in der Dokumentationzu Databricks Model Serving.

- Lesen Sie den Leitfaden zur Migration von Legacy MLflow Model Serving zu Databricks Model Serving.

Verpassen Sie keinen Beitrag von Databricks

Was kommt als Nächstes?

Produto

12. Juni 2024/11 min Lesezeit