Solution Accelerators für die Fertigung

Veröffentlicht: 21. September 2023

von Will Block, Ramdas Murali, Nicole Lu und Bala Amavasai

Seit der Veröffentlichung des bahnbrechenden Artikels über Transformer von Vaswani et. al. von Google dominieren große Sprachmodelle (LLMs) den Bereich der generativen KI. Zweifellos hat die Einführung von OpenAIs ChatGPT für viel dringend benötigte Aufmerksamkeit gesorgt und zu einem steigenden Interesse an der Nutzung von LLMs geführt, sowohl für den privaten als auch für den unternehmerischen Gebrauch. In den letzten Monaten haben Google mit der Veröffentlichung von Bard und Meta mit ihren Llama 2 -Modellen den intensiven Wettbewerb großer Technologieunternehmen demonstriert.

Die Fertigungs- und Energiebranche steht vor der Herausforderung, eine höhere Produktivität zu erzielen, was durch steigende Betriebskosten noch erschwert wird. Datenorientierte Unternehmen investieren in KI und in jüngster Zeit auch in LLMs. Im Wesentlichen schöpfen datenorientierte Unternehmen aus diesen Investitionen einen enormen Wert.

Databricks glaubt an die Demokratisierung von KI-Technologien. Wir sind davon überzeugt, dass jedes Unternehmen die Möglichkeit haben sollte, seine LLMs zu trainieren und die Hoheit über seine Daten und Modelle zu behalten. In der Fertigungs- und Energiebranche sind viele Prozesse proprietär, und diese Prozesse sind entscheidend, um im harten Wettbewerb einen Vorsprung zu behaupten oder die Betriebsmargen zu verbessern. „Geheimrezepte“ werden als Geschäftsgeheimnisse geschützt und nicht durch Patente oder Veröffentlichungen öffentlich zugänglich gemacht. Viele der öffentlich verfügbaren LLMs erfüllen diese Grundanforderung nicht, die die Preisgabe von Wissen erfordert.

Hinsichtlich der Anwendungsfälle stellt sich in dieser Branche oft die Frage, wie man die derzeitige Belegschaft unterstützen kann, ohne sie mit noch mehr Apps und Daten zu überfluten. Darin liegt die Herausforderung, mehr KI-gestützte Apps für die Belegschaft zu entwickeln und bereitzustellen. Allerdings glauben wir, dass mit dem Aufkommen von generativer KI und LLMs diese LLM-gestützten Apps die Abhängigkeit von mehreren Apps reduzieren und wissenserweiternde Funktionen in weniger Apps konsolidieren können.

Datenintelligenz gestaltet Branchen neu

Mehrere Anwendungsfälle in der Branche könnten von LLMs profitieren. Dazu gehören unter anderem:

- Unterstützung der Kundendienstmitarbeiter. Mitarbeiter im Kundensupport möchten abfragen können, welche offenen/ungelösten Anliegen für den jeweiligen Kunden bestehen, und ein KI-gestütztes Skript bereitstellen, um den Kunden zu unterstützen.

- Erfassung und Verbreitung von Fachwissen durch interaktives Training. Die Branche wird von tiefem Know-how dominiert, das oft als "Stammeswissen" bezeichnet wird. Mit der alternden Belegschaft entsteht die Herausforderung, dieses Fachwissen dauerhaft zu erfassen. LLMs könnten als Wissensspeicher fungieren, deren Wissen dann leicht für Trainingszwecke verbreitet werden kann.

- Erweiterung der Diagnosefähigkeiten von Diensttechnikern. Außendiensttechniker stehen oft vor der Herausforderung, auf unzählige miteinander verknüpfte Dokumente zuzugreifen. Ein LLM, das die Zeit für die Problemdiagnose verkürzt, steigert unbeabsichtigt die Effizienz.

In diesem Lösungsbeschleuniger konzentrieren wir uns auf den oben genannten Punkt (3), nämlich den Anwendungsfall der Unterstützung von Außendiensttechnikern mit einer Wissensdatenbank in Form einer interaktiven, kontextbezogenen Q&A-Sitzung. Die Herausforderung für Hersteller besteht darin, Daten aus proprietären Dokumenten aufzubereiten und in LLMs einzubinden. Das Training von LLMs von Grund auf ist ein sehr kostspieliges Unterfangen, das Hunderttausende, wenn nicht Millionen von Dollar kostet.

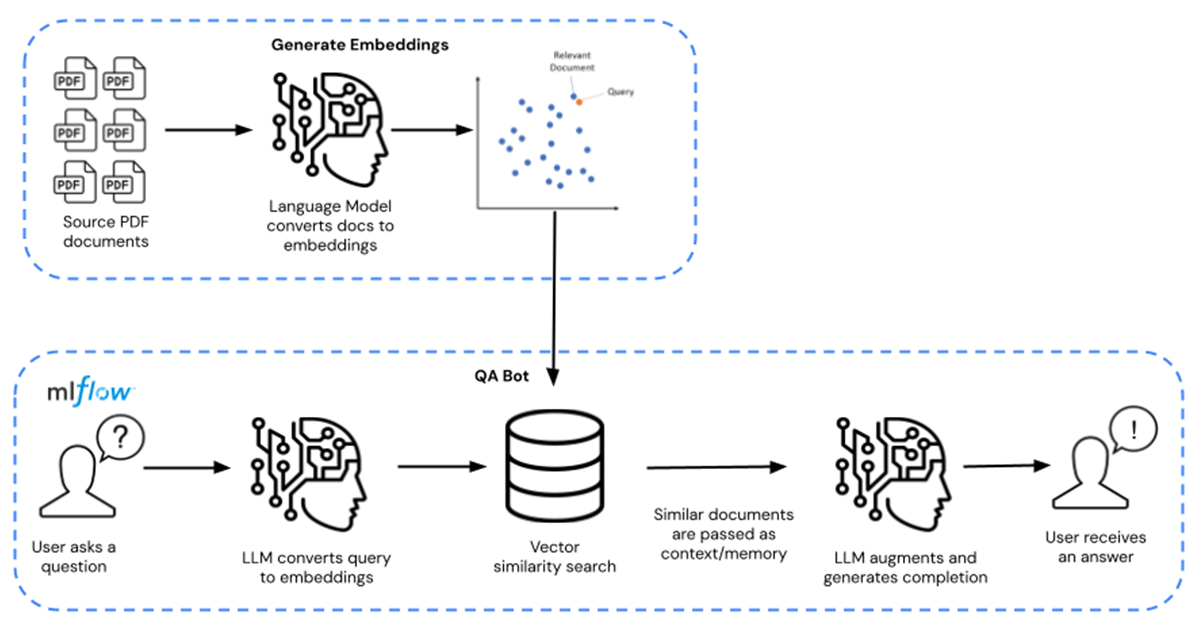

Stattdessen können Unternehmen auf vortrainierte grundlegende LLM-Modelle (wie MPT-7B und MPT-30B von MosaicML) zugreifen und diese Modelle mit ihren proprietären Daten erweitern und feinabstimmen. Dies senkt die Kosten auf Dutzende, wenn nicht Hunderte von Dollar, was effektiv einer Kostenersparnis von 10000x entspricht. In der nachstehenden Abbildung 1 wird der vollständige Pfad zur Feinabstimmung von links nach rechts und der Pfad zur Q/A-Abfrage von rechts nach links dargestellt.

In diesem Lösungsbeschleuniger wird das LLM durch öffentlich verfügbare chemische Datenblätter erweitert, die in Form von PDF-Dokumenten verteilt werden. Dies kann durch beliebige proprietäre Daten Ihrer Wahl ersetzt werden. Die Datenblätter werden in Embeddings umgewandelt und als Retriever für das Modell verwendet. Langchain wurde dann verwendet, um das Modell zu kompilieren, das anschließend auf Databricks MLflow gehostet wird. Die Bereitstellung erfolgt in Form eines Databricks- Model Serving -Endpunkts mit GPU-Inferenz.

Erweitern Sie Ihr Unternehmen noch heute, indem Sie diese Assets hier herunterladen. Wenden Sie sich an Ihren Databricks-Ansprechpartner, um besser zu verstehen, warum Databricks die bevorzugte Plattform für die Erstellung und Bereitstellung von LLMs ist.

Entdecken Sie den Lösungsbeschleuniger hier.

Verpassen Sie keinen Beitrag von Databricks

Was kommt als Nächstes?

Produção industrial

30. Oktober 2025/9 min Lesezeit

Como construir Gêmeos Digitais para eficiência operacional

Produção industrial

11. November 2025/9 min Lesezeit