LakeFlow

Importez, transformez et orchestrez vos données avec une solution de data engineering unifiée

LES MEILLEURES ENTREPRISES UTILISENT LAKEFLOWUne solution de bout en bout pour des données de haute qualité.

Des outils qui aident toutes les équipes à développer des pipelines de données fiables pour l'analytique et l'IA.85 % d'accélération du développement

50 % de réduction des coûts

99 % de réduction de la latence des pipelines

2 500 exécutions de tâches par jour

Corning utilise Lakeflow pour simplifier l'orchestration des données et mettre un processus automatisé et reproductible à la disposition de différentes équipes de l'organisation. Ces workflows automatisés déplacent des quantités considérables de données des tables bronze à gold au sein d'une architecture en médaillon.

Outils unifiés pour les data engineers

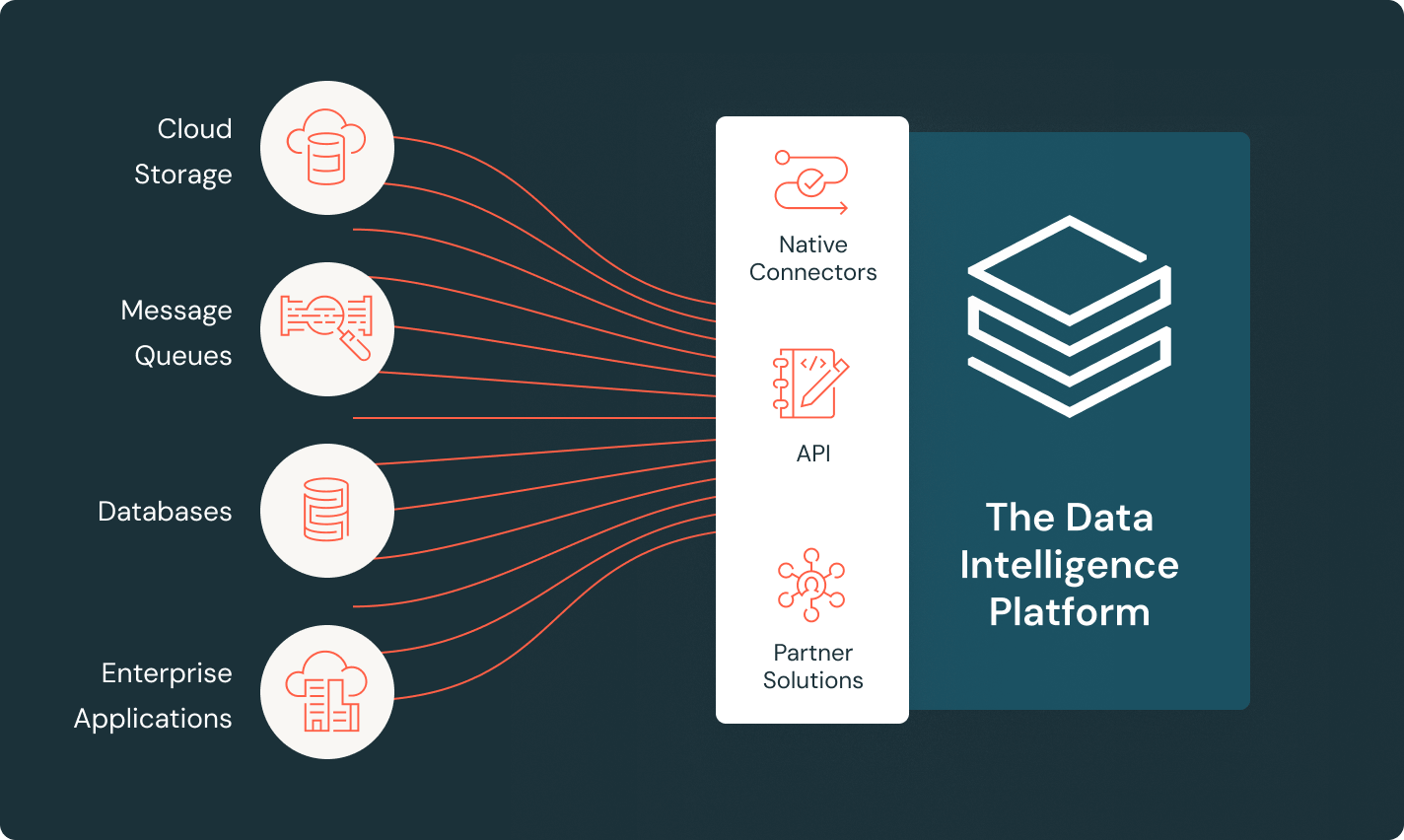

LakeFlow Connect

Avec des connecteurs d'ingestion de données efficaces et une intégration native à la Data Intelligence Platform, les équipes accèdent en toute simplicité à l'analytique et à l'IA avec une gouvernance unifiée.

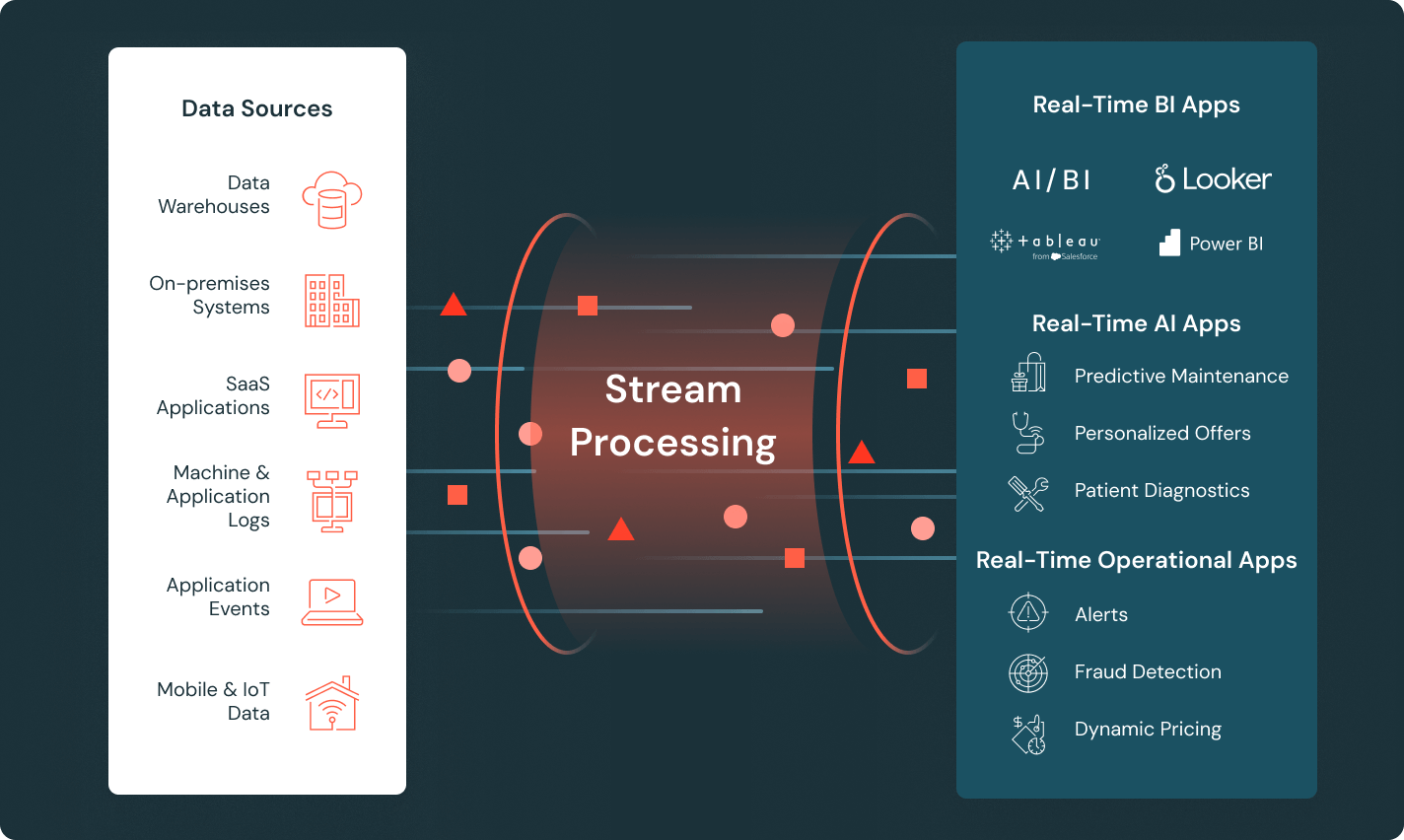

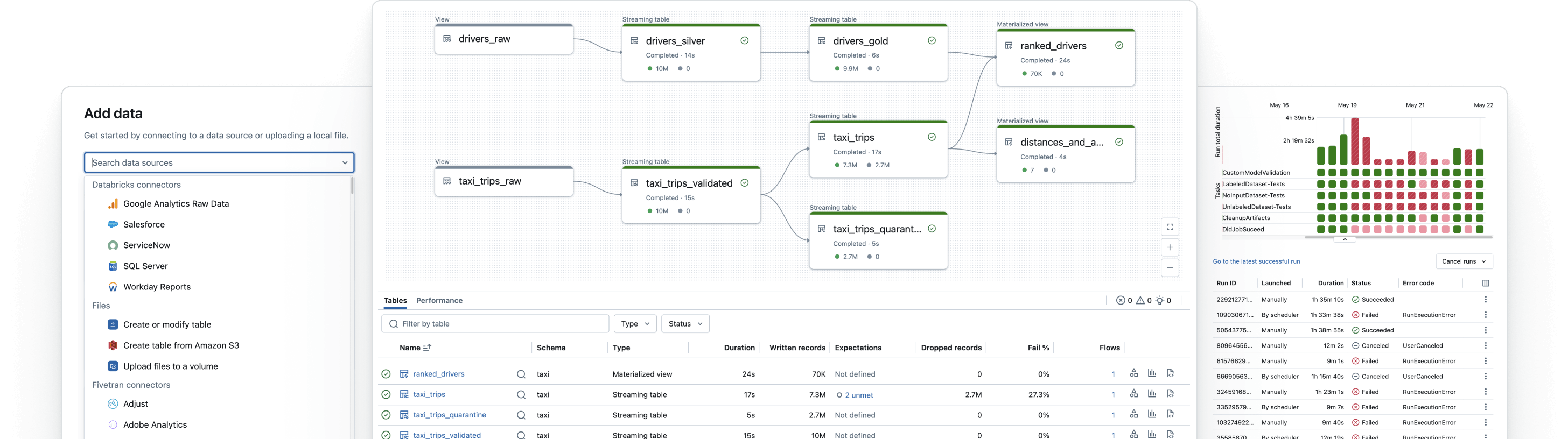

Spark Declarative Pipelines

Simplifiez l'ETL par batch et en streaming grâce à la qualité de données automatisée, la change data capture (CDC), l'acquisition et la transformation des données, ainsi que la gouvernance unifiée.

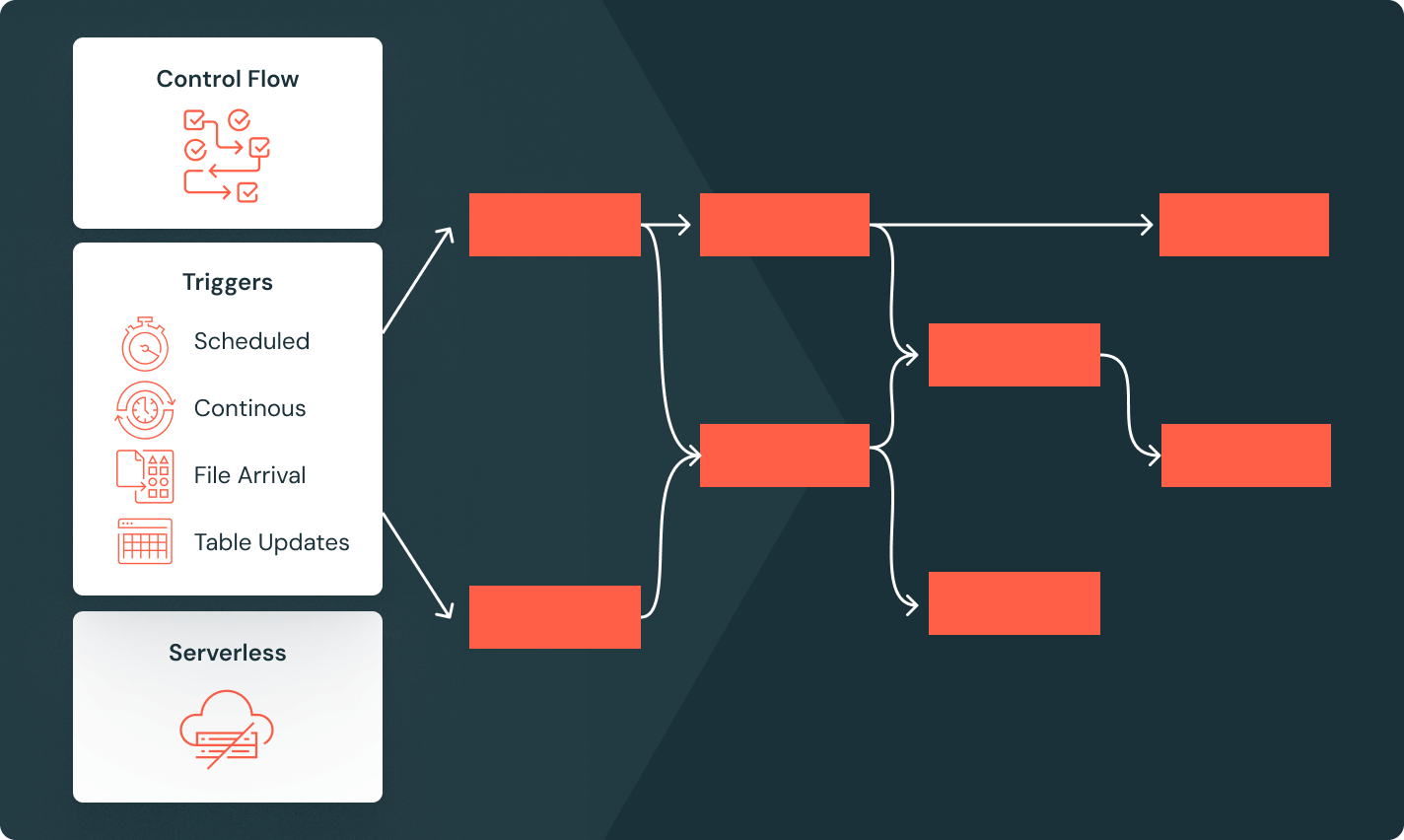

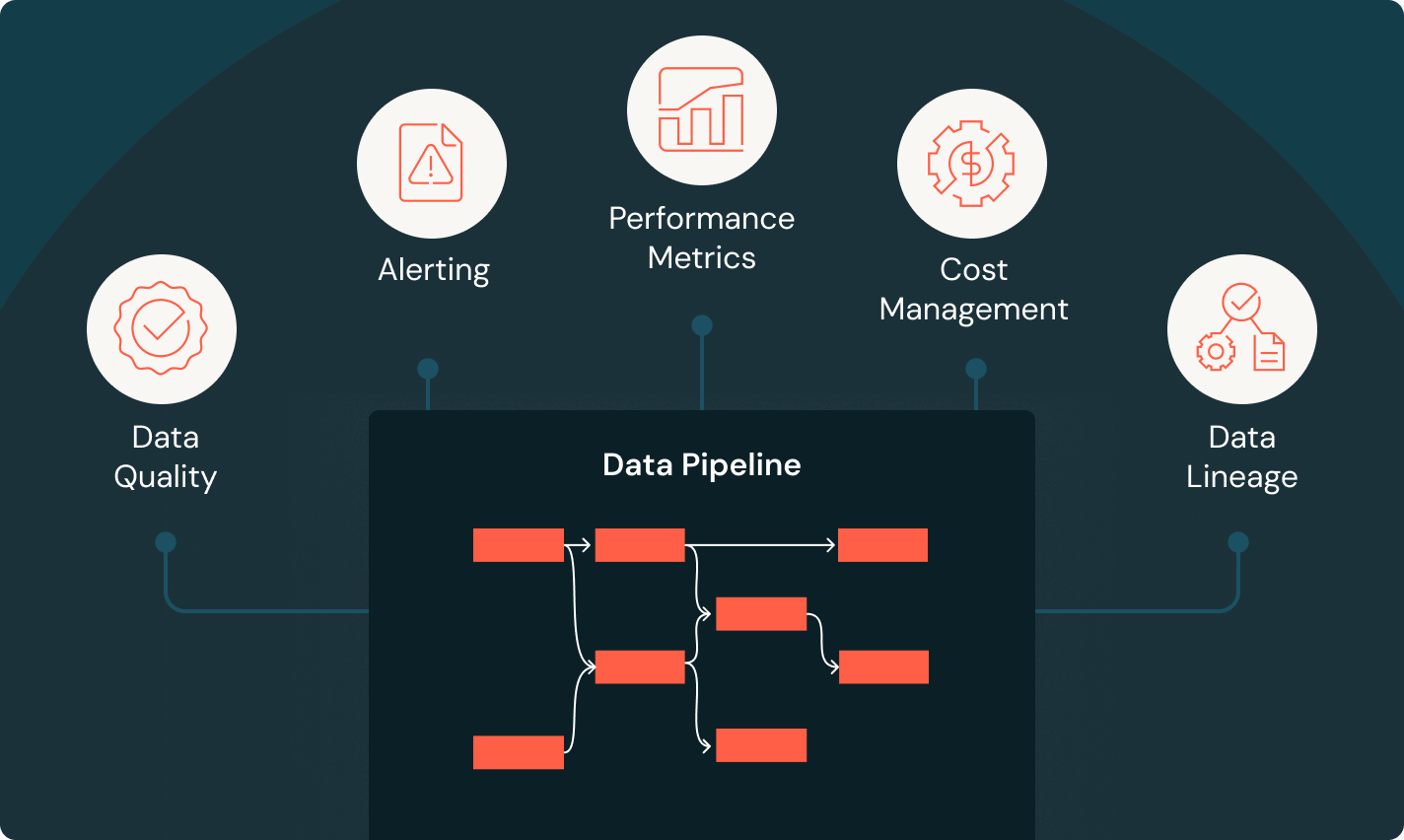

Tâches Lakeflow

Donnez aux équipes les moyens de mieux automatiser et orchestrer tous les workflows d'ETL, d'analytique et d'IA grâce à une observabilité approfondie, une haute fiabilité et la prise en charge d'un large éventail de tâches.

Unity Catalog

Encadrez sans problème tous vos assets de données avec la seule solution de gouvernance unifiée et ouverte de l'industrie pour les données et l'IA, intégrée à la Databricks Data Intelligence Platform

Stockage en lakehouse

Unifiez les données du lakehouse, quels que soient leur format et leur type, pour les mettre à disposition de toutes vos charges d'analytique et d'IA.

Data Intelligence Platform

Explorez tout l'éventail des outils disponibles sur la Databricks Data Intelligence Platform pour intégrer les données et l'IA de toute votre organisation de façon fluide et transparente.

Développez des pipelines de données fiables

Transformez les données brutes en tables gold de haute qualité

Mettez en œuvre des pipelines ETL pour filtrer, enrichir, nettoyer et agréger les données pour toutes vos initiatives d'analytique, d'IA et de BI. Optez pour une architecture en médaillon pour traiter les données et les faire passer des tables bronze à silver et gold.

Passez à l'étape suivante

FAQ sur le data engineering

Prêts à devenir une entreprise axée sur les données et l'IA ?

Faites le premier pas de votre transformation data