Agenti AI addestrati sui tuoi dati aziendali

Usa Agent Bricks per creare, addestrare e implementare agenti AI che funzionano davvero

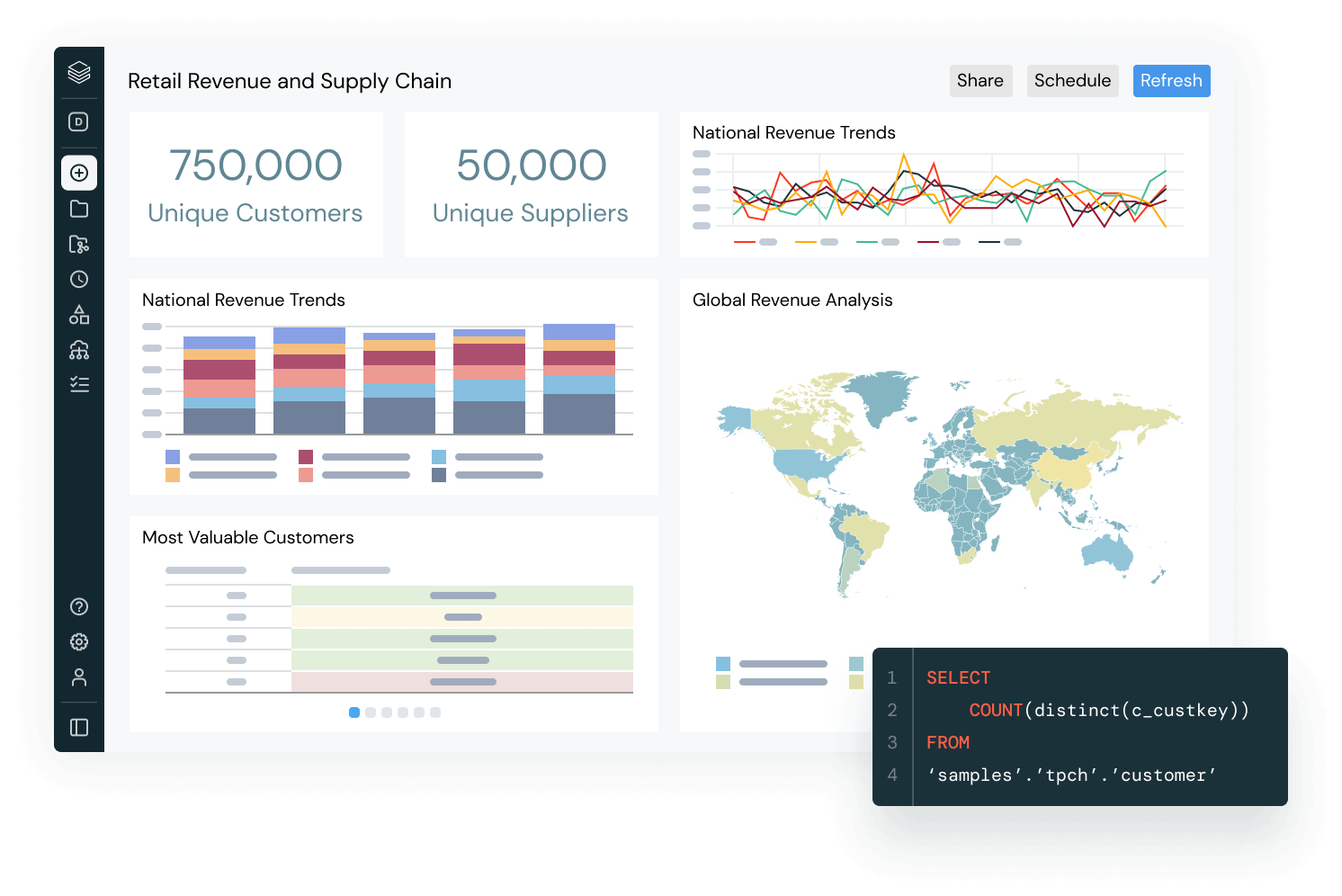

La piattaforma di intelligenza dei dati di Databricks

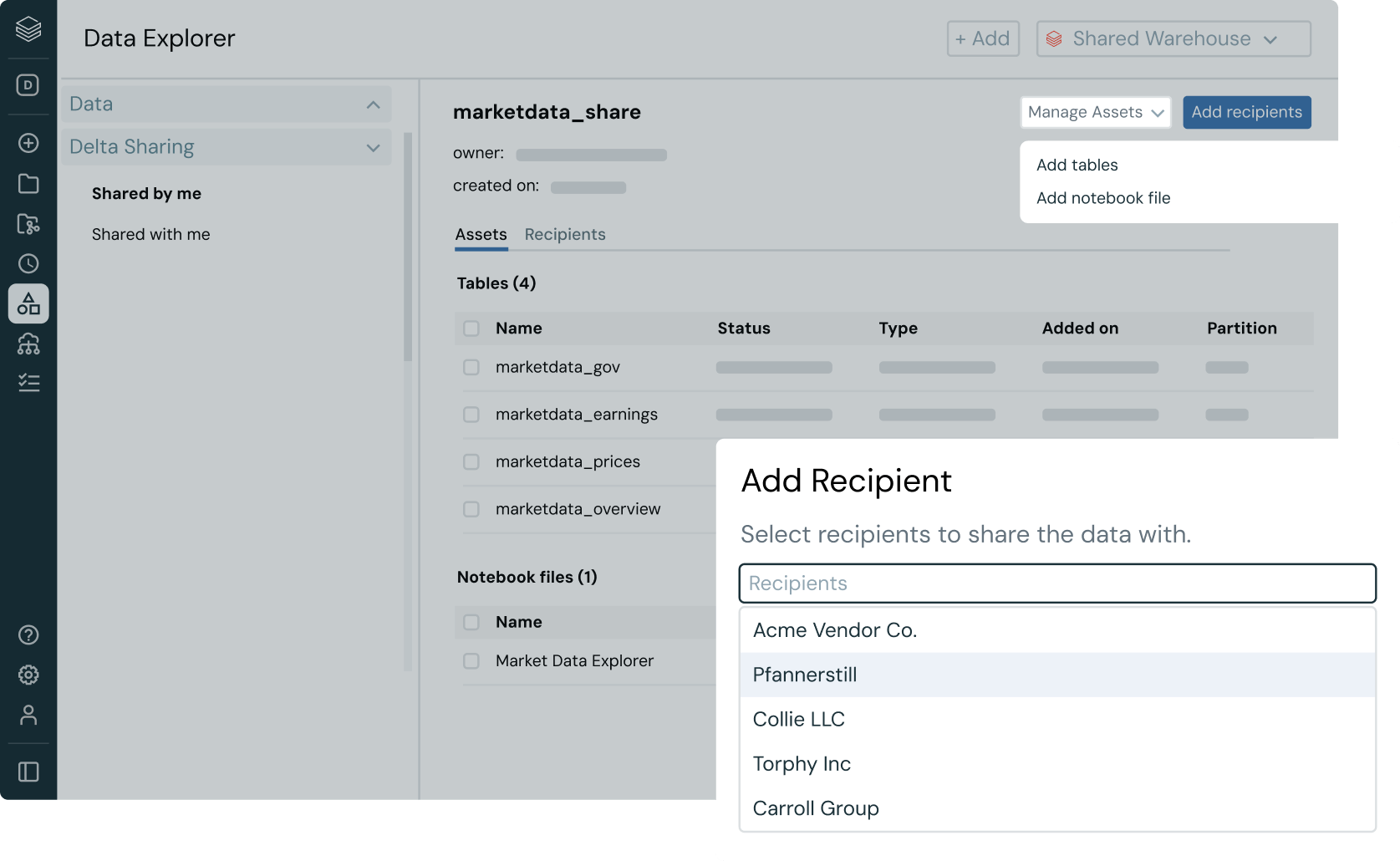

Databricks porta l'AI nella gestione dei dati, così tu puoi portare l'AI nel mondo.Unifica tutti i dati + AI

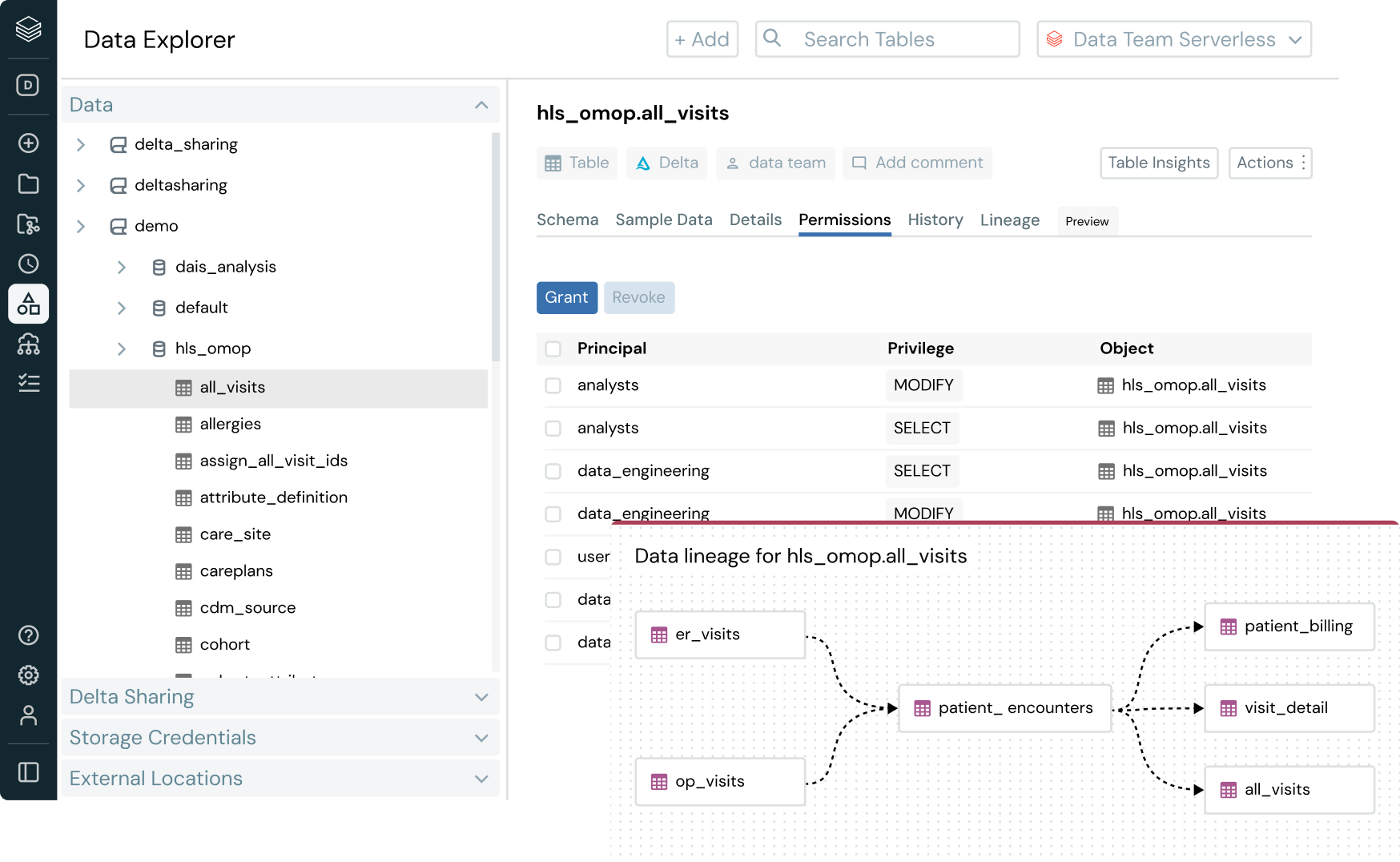

Costruisci un'AI migliore con un approccio incentrato sui dati

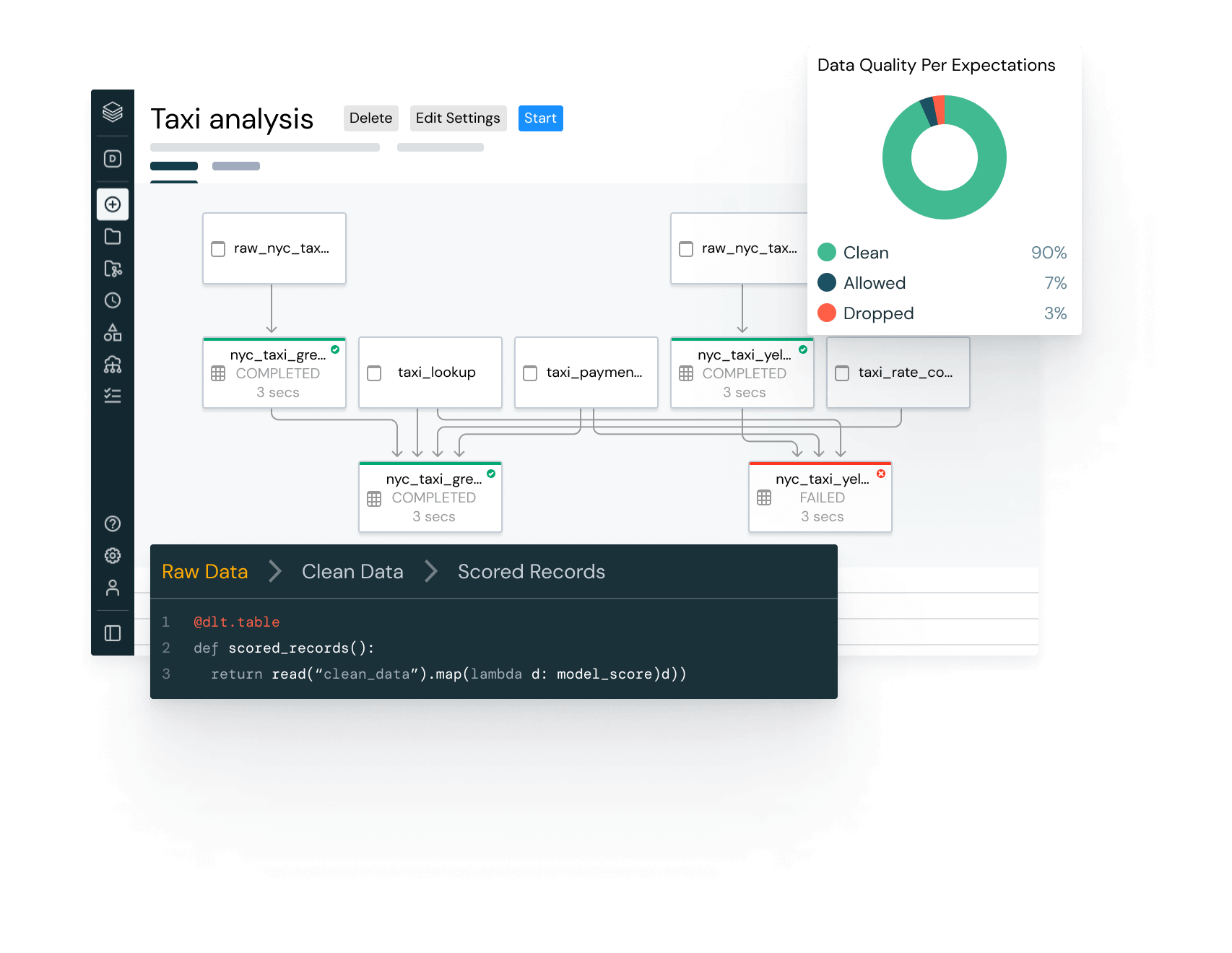

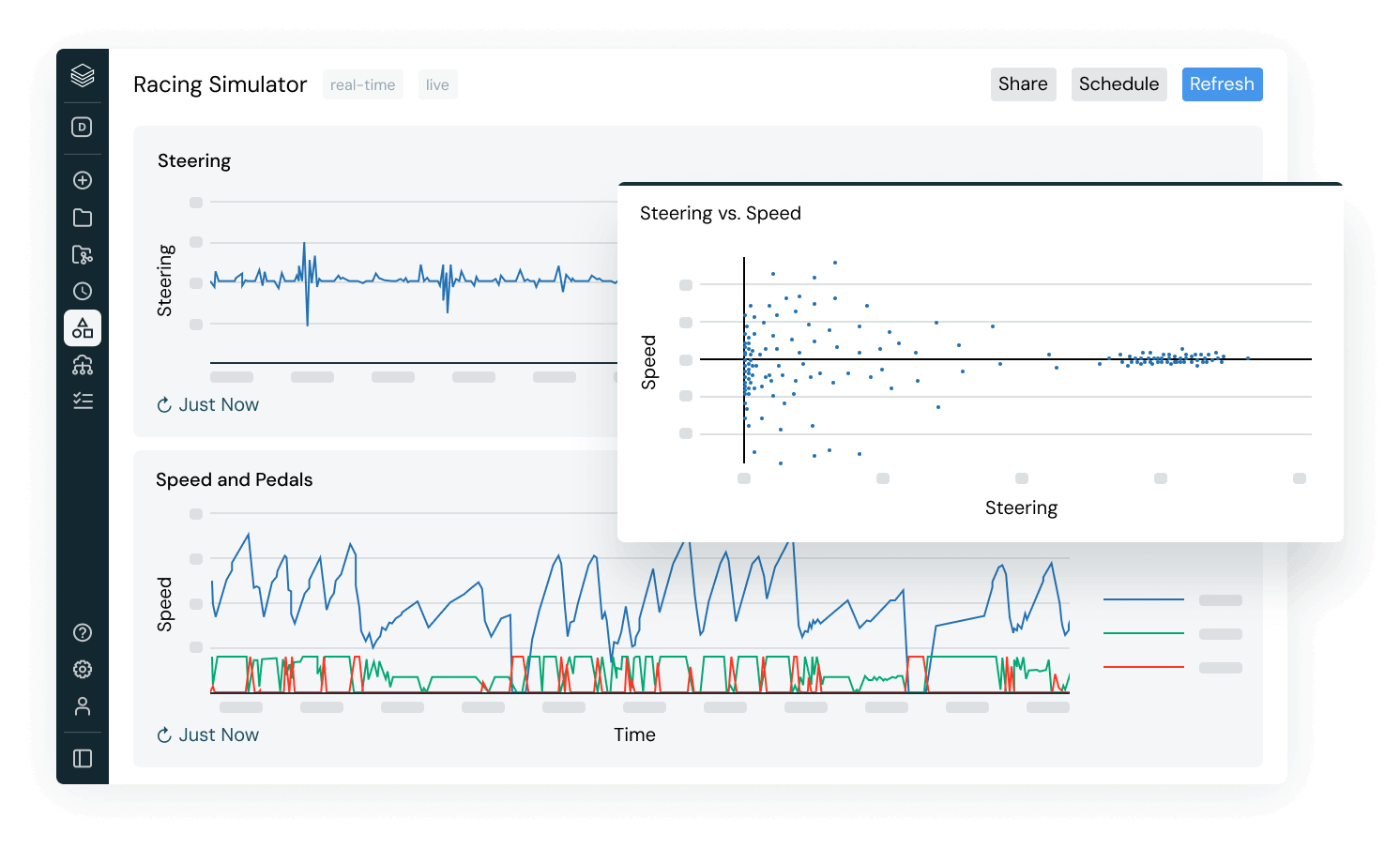

Per realizzare ottimi modelli servono ottimi dati. Con Databricks, provenienza, qualità, controllo e riservatezza dei dati vengono mantenuti lungo tutto il flusso di lavoro dell'AI, alimentando un pacchetto completo di strumenti per realizzare qualsiasi caso d'uso con AI.

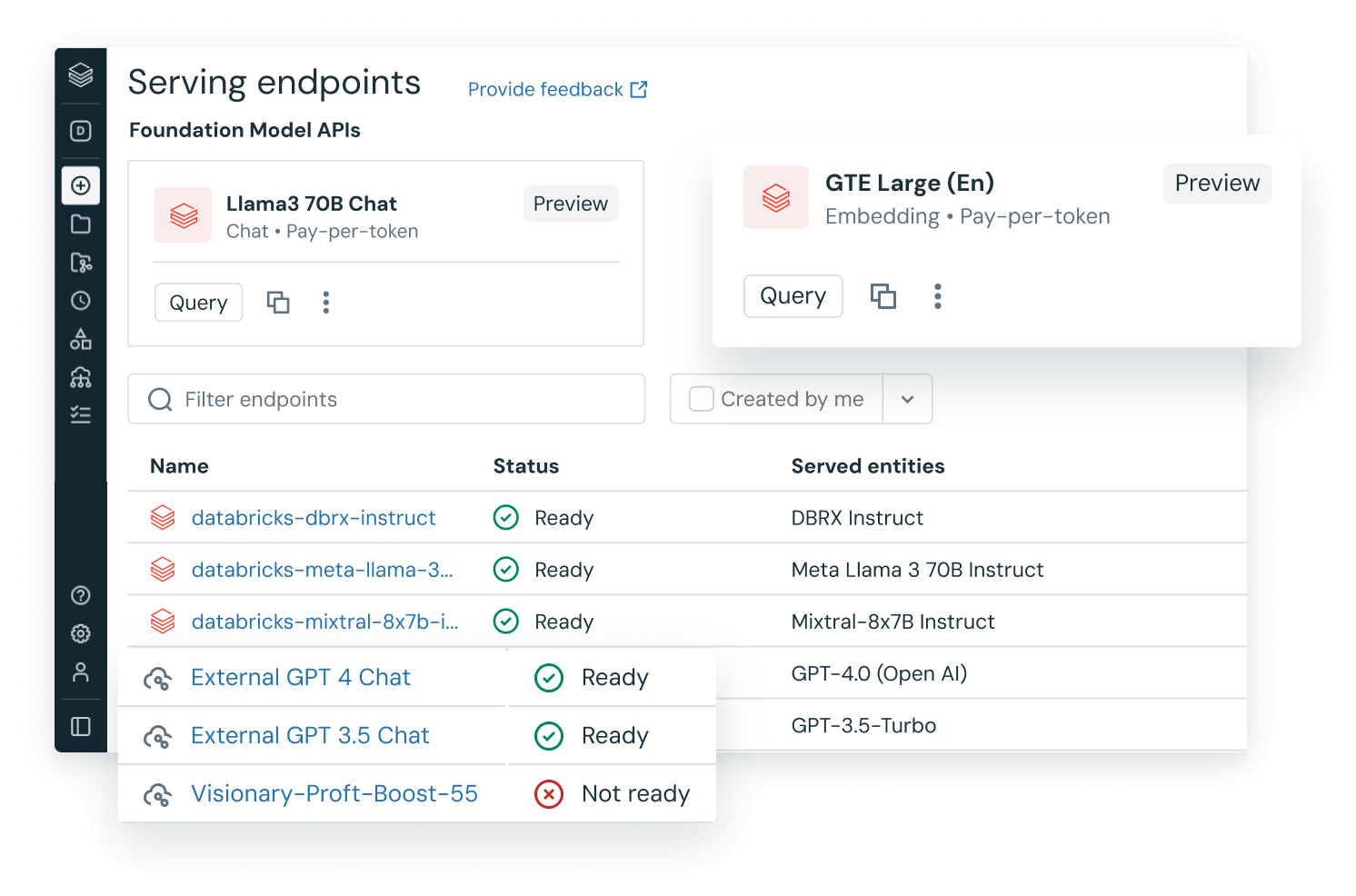

✔ Crea, sintonizza e implementa i tuoi modelli di AI generativa

✔ Automatizza il tracciamento e la governance degli esperimenti.

✔ Implementa e monitora modelli su larga scala.

Oltre l'AI

Sotto i riflettori

Report

Scopri la strategia di AI alla base dei team dati di maggior successo

Data intelligence per tutti

Il Data + AI Summit è terminato, ma puoi ancora guardare gli interventi principali e centinaia di sessioni su tutti i temi più importanti: dal data warehousing alla governance fino alle ultime novità sull’AI generativa.

eBook

La tua guida pratica completa al data warehousing con la Data Intelligence Platform

Report

Databricks è leader nel MQ 2025 per le piattaforme di Data Science e ML

Vuoi diventare un'azienda basata su dati e AI?

Inizia il percorso di trasformazione