Efficiente ingestione di dati nel tuo lakehouse

Fai il primo passo per sbloccare l'innovazione con l'intelligenza dei dati.

Sblocca il valore dei tuoi dati in pochi semplici passaggi

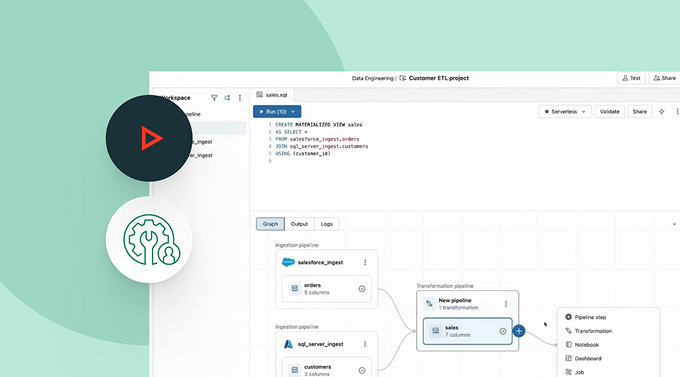

I connettori di dati integrati sono disponibili per applicazioni aziendali popolari, fonti di file e database.Robuste capacità di ingestione per le fonti di dati più popolari

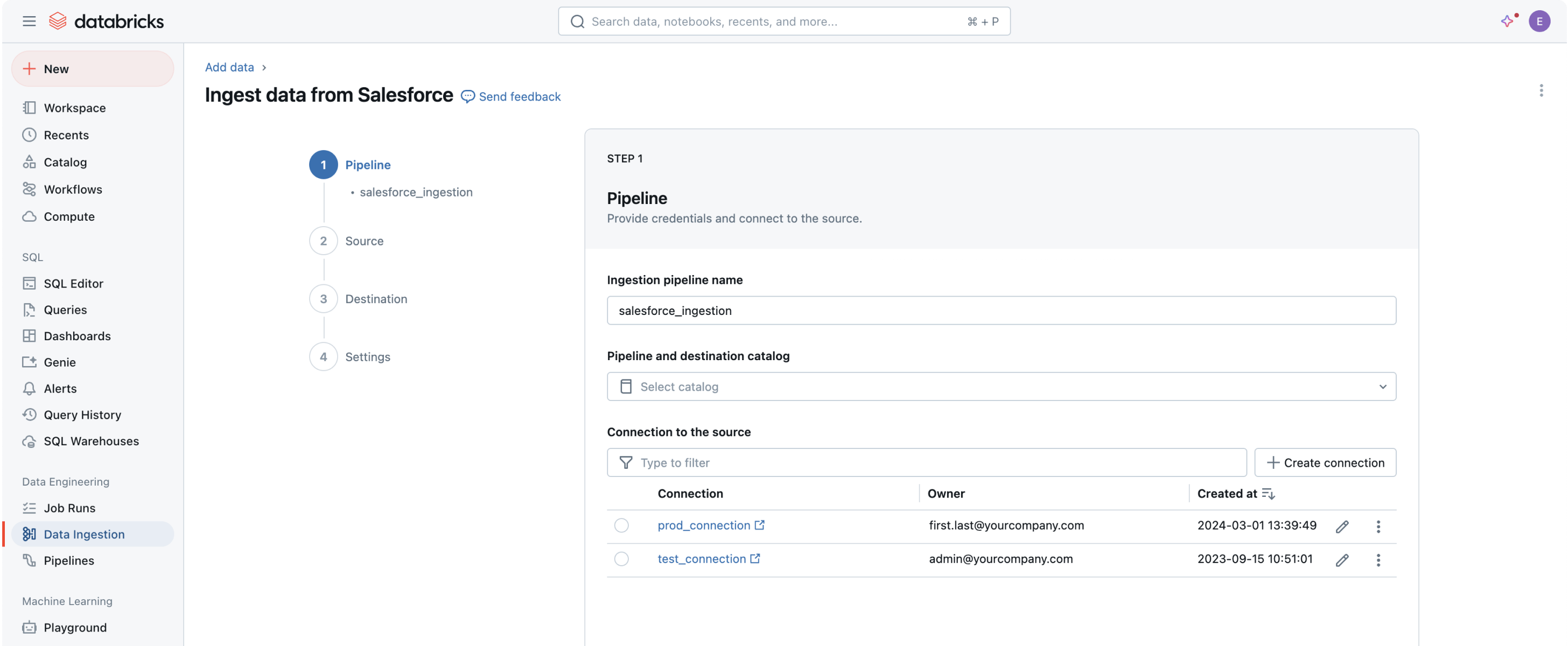

Portare tutti i tuoi dati nella Piattaforma di Intelligenza dei Dati è il primo passo per estrarre valore e aiutare a risolvere i problemi di dati più impegnativi della tua organizzazione.L'interfaccia utente (UI) senza codice o una semplice API permette ai professionisti dei dati di servirsi autonomamente, risparmiando ore di programmazione.

Ingestione dei dati con Databricks

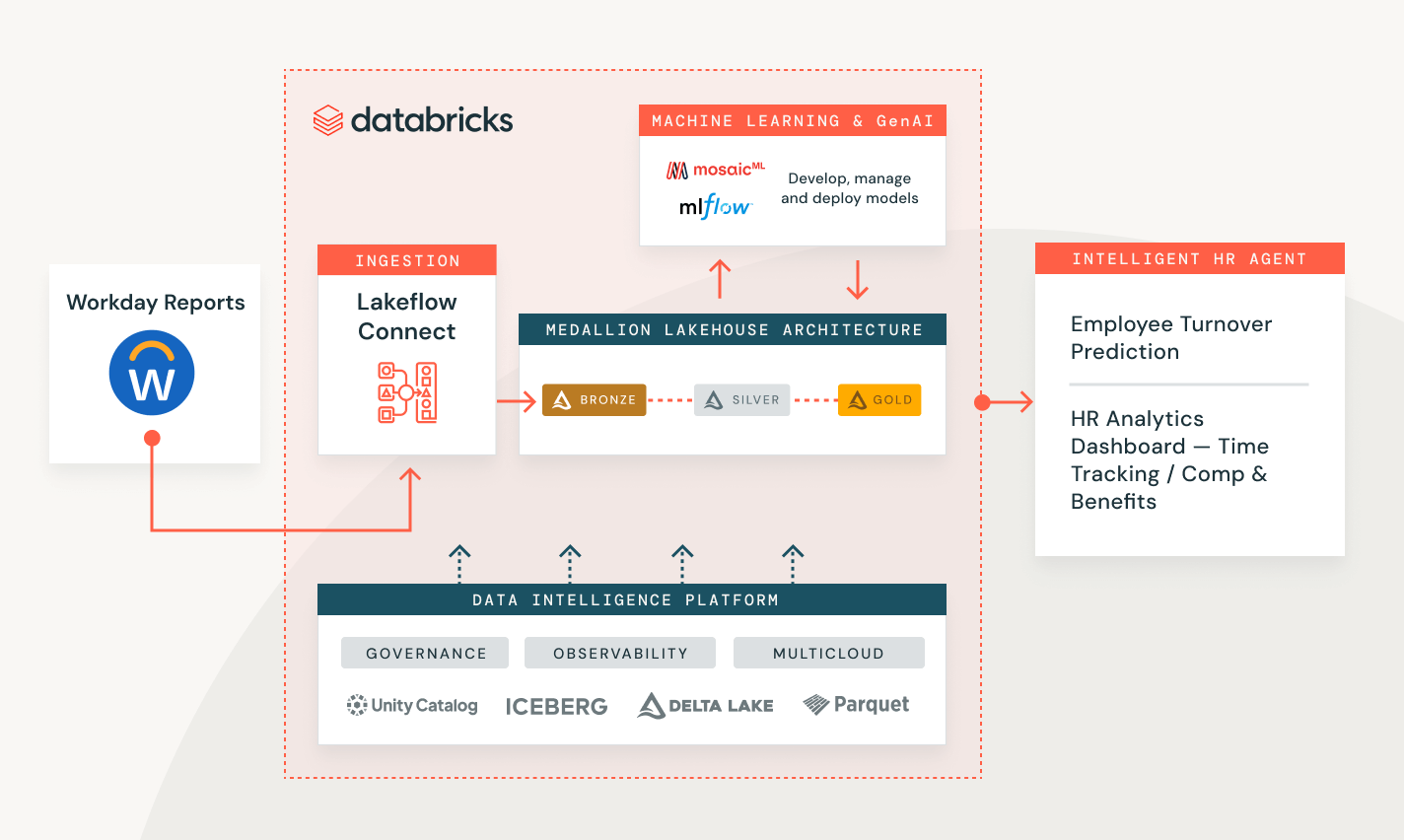

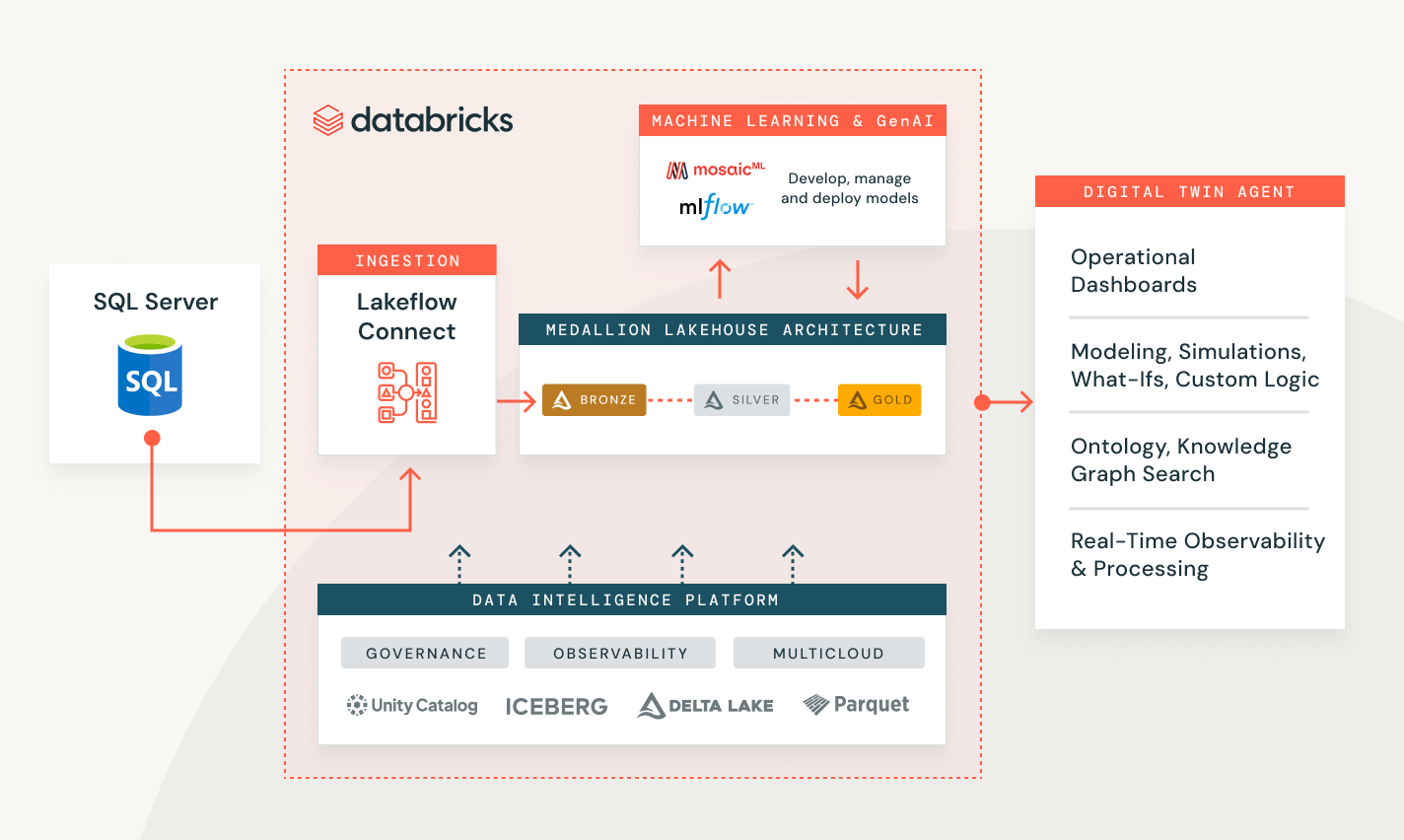

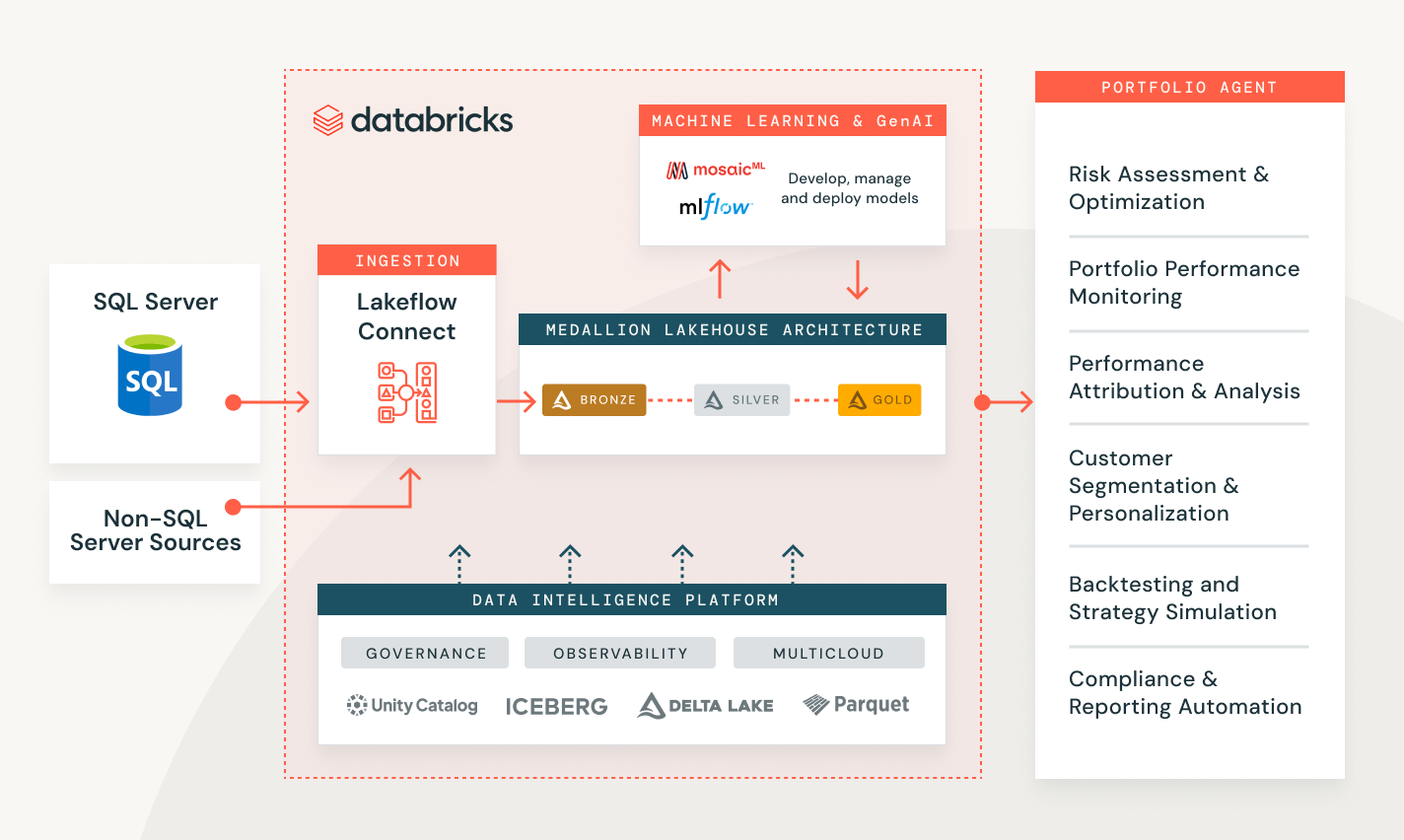

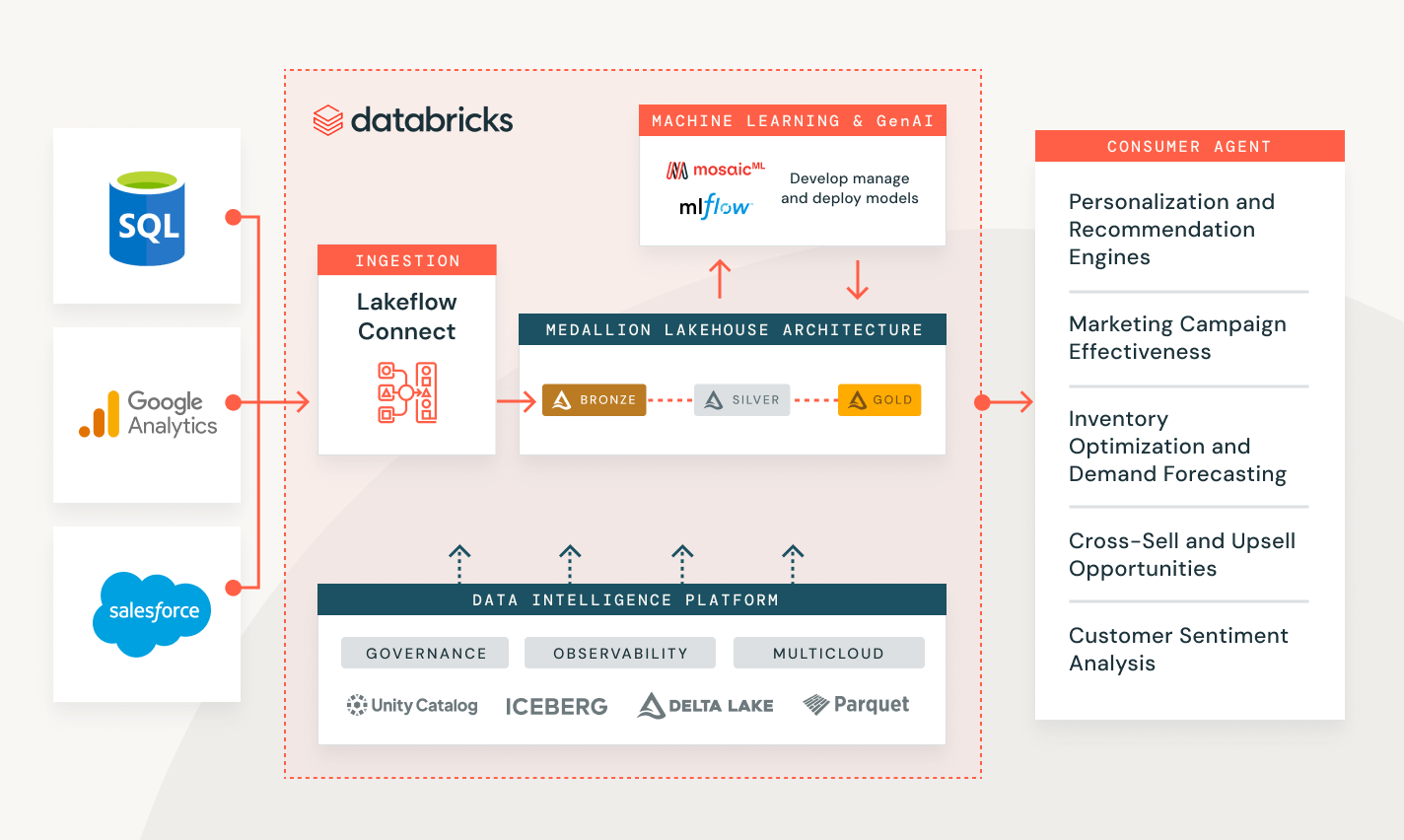

Risoluzione dei problemi dei clienti in una serie di settori

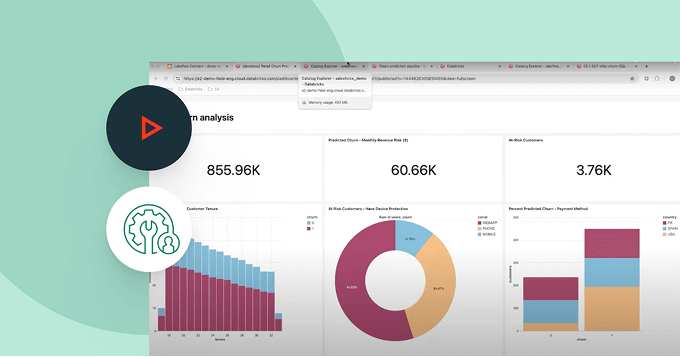

Misura le prestazioni della campagna e il punteggio dei lead dei clienti

Crea una soluzione end-to-end per trasformare, proteggere e analizzare i dati dei tuoi clienti e aiutare a prevedere il comportamento futuro.

Esplora le demo di ingestione dati

I prezzi basati sull'utilizzo tengono sotto controllo la spesa

Paga solo per i prodotti che utilizzi con una granularità al secondo.Scopri di più

Esplora altre offerte integrate e intelligenti sulla Data Intelligence Platform.Job di Lakeflow

Fornisci ai team gli strumenti per automatizzare e orchestrare al meglio qualsiasi flusso di lavoro ETL, di analisi o AI, con osservabilità avanzata, alta affidabilità e supporto per una vasta gamma di attività.

Spark Declarative Pipelines

Semplifica l’ETL batch e in streaming grazie a funzionalità automatizzate per la qualità dei dati, il Change Data Capture (CDC), l’ingestione, la trasformazione e la governance centralizzata.

Unity Catalog

Gestisci tutti i tuoi asset di dati con l'unica soluzione di governance unificata e aperta del settore per dati e AI, integrata nella Databricks Data Intelligence Platform.

Delta Lake

Unifica i dati nel tuo lakehouse, di qualunque formato e tipo, per tutti i tuoi carichi di lavoro di analisi e AI.

Guida introduttiva

Esplora i documenti sull'ingestione dei dati

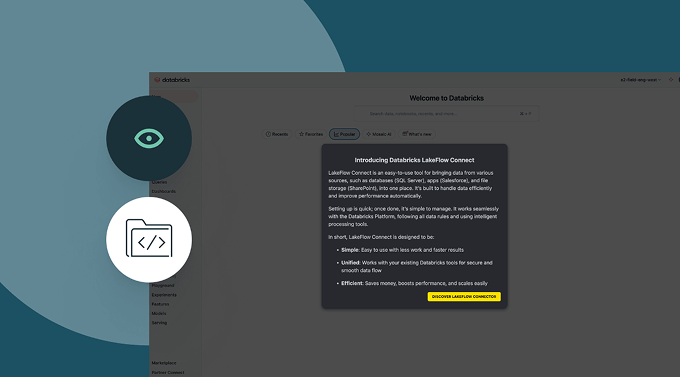

Ingestione dati da varie fonti, attraverso le nuvole e tramite Lakeflow Connect.

Tour Lakeflow Connect

Lakeflow Connect è ora generalmente disponibile per Salesforce, Workday e SQL Server.

Per l'accesso in anteprima ad altri connettori, si prega di contattare il tuo team di account Databricks.

Domande Frequenti sull'Ingestione dei Dati

Sei pronto a mettere dati e AI alla base della tua azienda?

Inizia il tuo percorso di trasformazione dei dati