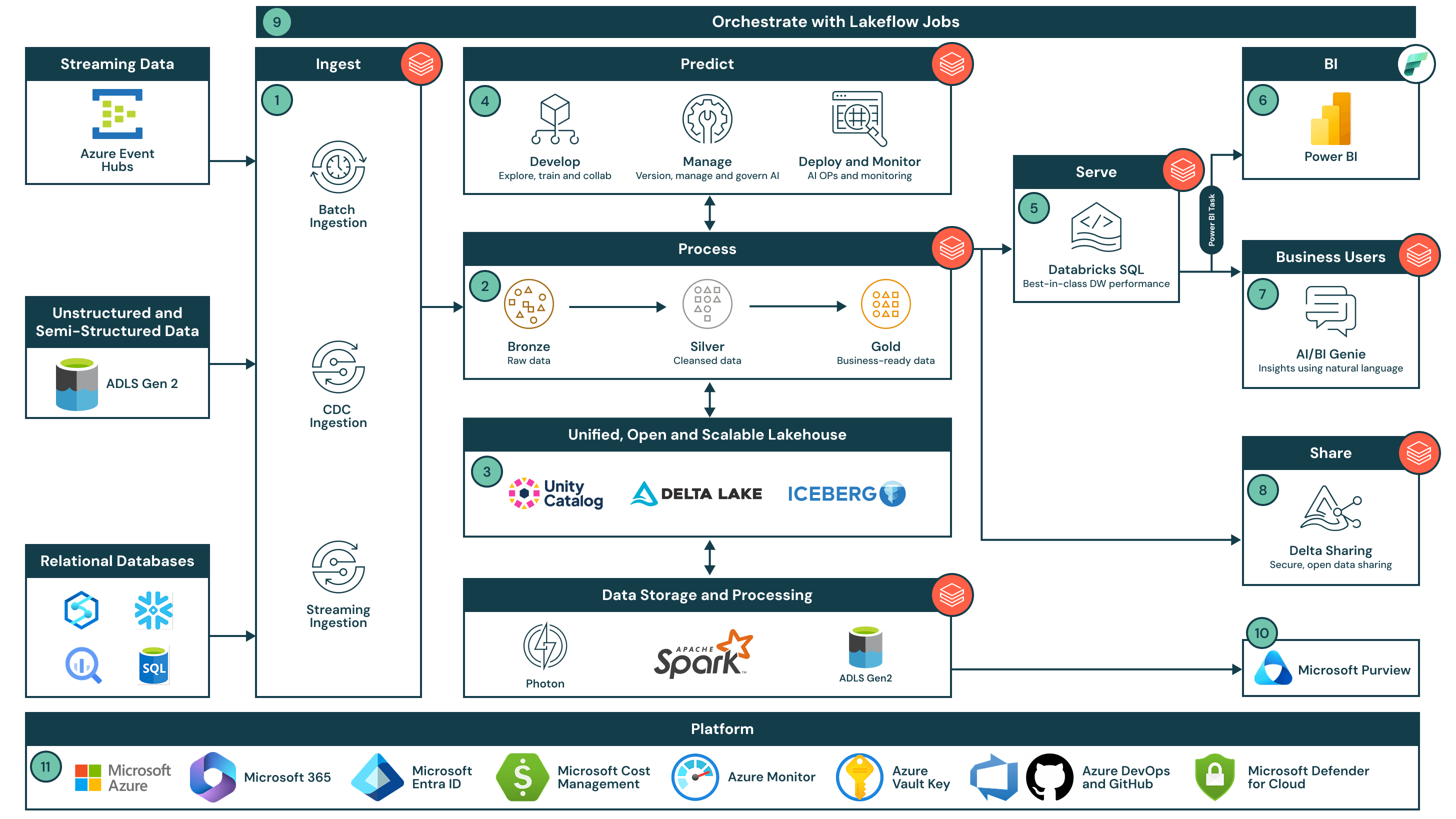

Architettura end-to-end di Data Intelligence con Azure Databricks

L'architettura end-to-end dell'intelligenza dei dati fornisce una base scalabile e sicura per l'analisi, l'IA e le intuizioni in tempo reale su entrambi i dati batch e streaming.

Riassunto dell'architettura

L'architettura end-to-end di Data Intelligence si integra perfettamente con Power BI e Copilot in Microsoft Fabric, Microsoft Purview, Azure Data Lake Storage Gen2 e Azure Event Hubs, potenziando la decisione basata sui dati in tutta l'impresa. Questa soluzione dimostra come è possibile sfruttare la Piattaforma di Intelligenza dei Dati per Azure Databricks in combinazione con Power BI per democratizzare i dati e l'IA, soddisfacendo al contempo le esigenze di sicurezza e scala a livello aziendale. Partendo da un'architettura di lakehouse unificata e aperta, governata dal Catalogo Unity, l'intelligenza dei dati sfrutta i dati unici di un'organizzazione per fornire una soluzione semplice, robusta e accessibile per ETL, data warehousing e IA, in modo da poter fornire prodotti dati più rapidamente e facilmente.

Casi d'uso

Questa architettura end-to-end può essere utilizzata per:

- Modernizzare un'architettura dati legacy combinando ETL, data warehousing e IA per creare una piattaforma più semplice e a prova di futuro

- Potenzia casi d'uso di analisi in tempo reale come raccomandazioni di e-commerce, manutenzione predittiva e ottimizzazione della catena di fornitura su larga scala

- Costruisci applicazioni GenAI di livello produttivo come agenti di servizio clienti guidati dall'IA, personalizzazione e automazione dei documenti

- Abilita i leader aziendali all'interno di un'organizzazione a trarre intuizioni dai loro dati senza un profondo bagaglio tecnico o cruscotti personalizzati

- Condividi o monetizza i dati in modo sicuro con partner e clienti

Dataflow

- Acquisizione di dati

- Trasmetti dati da Azure Event Hubs a Lakeflow Spark Declarative Pipelines, con l'applicazione dello schema e la governance tramite Unity Catalog

- Usa Auto Loader per ingerire in modo incrementale dati non strutturati e semi-strutturati da ADLS Gen2 in Delta Lake

- Accedere ai sistemi relazionali esterni utilizzando Lakehouse Federation, garantendo che tutte le fonti seguano lo stesso modello di governance

- Elabora sia dati batch che streaming su larga scala utilizzando Lakeflow Spark Declarative Pipelines e il motore Photon, seguendo l'architettura medaglione.

- Bronzo: Dati grezzi batch e streaming ingeriti così come sono per la conservazione e l'auditabilità

- Argento: Set di dati puliti e uniti - la logica di streaming e batch è definita in modo dichiarativo per semplificare la complessità

- Oro: Dati aggregati, pronti per l'azienda, progettati per il consumo da parte di sistemi di analisi e AI downstream

- Questo approccio unificato consente ai team di costruire pipeline resilienti che supportano l'elaborazione dei dati in tempo reale e storici nella stessa architettura

- Conservare tutti i dati in un formato aperto e interoperabile utilizzando Delta Lake su ADLS Gen2.

Abilita la compatibilità tra motori come Delta, Apache Iceberg™ e Hudi centralizzando lo storage in un ambiente sicuro e scalabile. - Esplora, arricchisci e addestra modelli di intelligenza artificiale utilizzando quaderni collaborativi e strumenti di ML governati.

Usa notebook serverless per l'esplorazione e l'addestramento del modello, con MLflow, feature store e Unity Catalog che gestiscono modelli, funzionalità e indici vettoriali. - Servire query ad hoc e ad alta concorrenza direttamente dal tuo data lake utilizzando Databricks SQL.

Fornire un accesso veloce ed economico ai dati di livello Gold senza la necessità di spostare o duplicare i dati. - Visualizza dati pronti per l'uso aziendale in Power BI utilizzando modelli semantici collegati a Unity Catalog.

Crea report in Microsoft Fabric con connessioni in tempo reale a dati governati tramite Databricks SQL. - Permetti agli utenti aziendali di esplorare i dati utilizzando il linguaggio naturale con AI/BI Genie.

Democratizza l'accesso ai dati consentendo a chiunque di interrogare i dati in modo conversazionale senza scrivere SQL. - Condividere dati live e governati esternamente utilizzando Delta Sharing.

Utilizza standard aperti per distribuire dati in modo sicuro con partner, clienti o altre unità aziendali. - Orchestrare dati e flussi di lavoro AI attraverso la piattaforma utilizzando Databricks Jobs.

Gestisci le dipendenze, la programmazione e l'esecuzione da un unico pannello di controllo per le tue pipeline e i tuoi lavori ML. - Pubblica i metadati su Microsoft Purview per una scoperta e governance unificata dei dati.

Estendi la tua portata di governance sincronizzando i metadati del Catalogo Unity per una visibilità a livello aziendale. - Sfrutta i servizi core di Azure per la governance della piattaforma.

- Gestione dell'identità e single sign-on (SSO) tramite Microsoft Entra ID

- Gestisci i costi e la fatturazione tramite Microsoft Cost Management

- Monitora la telemetria e la salute del sistema tramite Azure Monitor

- Gestisci chiavi crittografate e segreti tramite Azure Key Vault

- Facilita il controllo delle versioni e CI/CD tramite Azure DevOps e GitHub

- Garantisci la gestione della sicurezza cloud tramite Microsoft Defender per Cloud