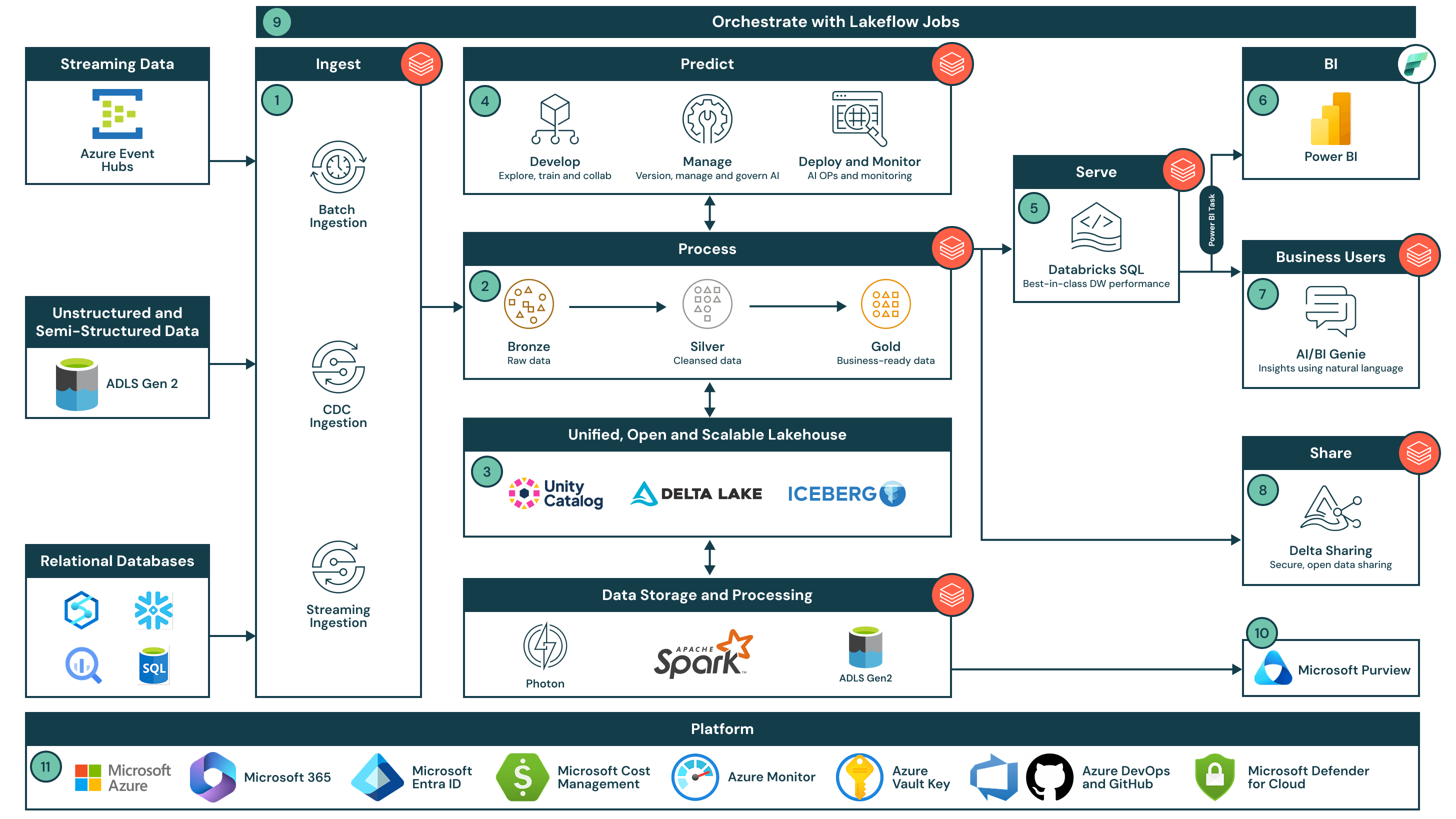

Data Intelligence End-to-End-Architektur mit Azure Databricks

Die End-to-End-Architektur für Datenintelligenz bietet eine skalierbare, sichere Grundlage für Analysen, KI und Echtzeit-Einblicke in sowohl Batch- als auch Streaming-Daten.

Zusammenfassung der Architektur

Die Datenintelligenz-End-to-End-Architektur integriert sich nahtlos mit Power BI und Copilot in Microsoft Fabric, Microsoft Purview, Azure Data Lake Storage Gen2 und Azure Event Hubs und ermöglicht datengesteuerte Entscheidungsfindung im gesamten Unternehmen. Diese Lösung zeigt, wie Sie die Datenintelligenzplattform für Azure Databricks in Kombination mit Power BI nutzen können, um Daten und KI zu demokratisieren und gleichzeitig die Anforderungen an unternehmensweite Sicherheit und Skalierbarkeit zu erfüllen. Beginnend mit einer offenen, einheitlichen Lakehouse-Architektur, die vom Unity-Katalog gesteuert wird, nutzt die Datenintelligenz die einzigartigen Daten einer Organisation, um eine einfache, robuste und zugängliche Lösung für ETL, Data Warehousing und KI bereitzustellen, damit sie Datenprodukte schneller und einfacher liefern können.

Anwendungsfälle

Diese End-to-End-Architektur kann verwendet werden, um:

- Eine veraltete Datenarchitektur zu modernisieren, indem ETL, Data Warehousing und KI kombiniert werden, um eine einfachere und zukunftssichere Plattform zu schaffen

- Echtzeitanalyse-Anwendungsfälle wie E-Commerce-Empfehlungen, vorausschauende Wartung und Supply-Chain-Optimierung im großen Maßstab zu ermöglichen

- Produktionsreife GenAI-Anwendungen wie KI-gesteuerte Kundenservice-Agenten, Personalisierung und Dokumentenautomatisierung zu erstellen

- Geschäftsführern innerhalb einer Organisation zu ermöglichen, Einblicke aus ihren Daten zu gewinnen, ohne tiefe technische Kenntnisse oder individuell erstellte Dashboards

- Daten sicher mit Partnern und Kunden zu teilen oder zu monetarisieren

Datenfluss

- Datenaufnahme

- Streamen Sie Daten von Azure Event Hubs in Lakeflow Spark Declarative Pipelines, mit Schema-Durchsetzung und Governance über Unity Catalog

- Verwenden Sie Auto Loader zum inkrementellen Einlesen von unstrukturierten und halbstrukturierten Daten aus ADLS Gen2 in Delta Lake

- Zugriff auf externe relationale Systeme mit Lakehouse Federation, um sicherzustellen, dass alle Quellen dem gleichen Governance-Modell folgen

- Verarbeiten Sie sowohl Batch- als auch Streaming-Daten im großen Maßstab mit Lakeflow Spark Declarative Pipelines und dem Photon-Motor, entsprechend der Medaillon-Architektur.

- Bronze: Rohdaten und Streaming-Daten werden zur Aufbewahrung und Nachvollziehbarkeit so wie sie sind aufgenommen

- Silber: Gesäuberte und verbundene Datensätze - Streaming- und Batch-Logik werden deklarativ definiert, um die Komplexität zu vereinfachen

- Gold: Aggregierte, geschäftsreife Daten, die für den Verbrauch durch nachgelagerte Analyse- und KI-Systeme konzipiert sind

- Dieser einheitliche Ansatz ermöglicht Teams den Aufbau von widerstandsfähigen Pipelines, die Echtzeit- und historische Datenverarbeitung in derselben Architektur unterstützen

- Speichern Sie alle Daten in einem offenen, interoperablen Format mit Delta Lake auf ADLS Gen2.

Ermöglichen Sie die Kompatibilität über Engines wie Delta, Apache Iceberg™ und Hudi hinweg, während die Speicherung in einer sicheren, skalierbaren Umgebung zentralisiert wird. - Erkunden, bereichern und trainieren Sie KI-Modelle mit Hilfe von kollaborativen Notizbüchern und geregelten ML-Tools.

Nutzen Sie serverlose Notebooks für Exploration und Modelltraining, mit MLflow, Feature Store und Unity Catalog zur Verwaltung von Modellen, Features und Vektorindizes. - Bedienen Sie ad-hoc- und hochkonkurrente Abfragen direkt aus Ihrem Data Lake mit Databricks SQL.

Bieten Sie schnellen, kosteneffizienten Zugang zu Gold-Level-Daten, ohne Daten verschieben oder duplizieren zu müssen. - Visualisieren Sie geschäftsrelevante Daten in Power BI mit semantischen Modellen, die mit Unity Catalog verbunden sind.

Erstellen Sie Berichte in Microsoft Fabric mit Live-Verbindungen zu verwalteten Daten über Databricks SQL. - Lassen Sie Geschäftsanwender Daten mit dem AI/BI Genie in natürlicher Sprache erkunden.

Demokratisieren Sie den Datenzugriff, indem Sie es jedem ermöglichen, Daten konversationell abzufragen, ohne SQL zu schreiben. - Teilen Sie live, verwaltete Daten extern mit Delta Sharing.

Nutzen Sie offene Standards, um Daten sicher mit Partnern, Kunden oder anderen Geschäftseinheiten zu verteilen. - Orchestrieren Sie Daten- und KI-Workflows über die Plattform hinweg mit Databricks Jobs.

Verwalten Sie Abhängigkeiten, Planung und Ausführung von einem einzigen Kontrollfenster aus über Ihre Pipelines und ML-Jobs. - Veröffentlichen Sie Metadaten in Microsoft Purview für einheitliche Datenentdeckung und -steuerung.

Erweitern Sie Ihren Governance-Bereich, indem Sie Metadaten des Unity-Katalogs synchronisieren, um eine unternehmensweite Sichtbarkeit zu erzielen. - Nutzen Sie die Kernservices von Azure für die Plattform-Governance.

- Identitätsmanagement und Single Sign-On (SSO) über Microsoft Entra ID

- Verwalten Sie Kosten und Abrechnung über Microsoft Cost Management

- Überwachen Sie Telemetrie und Systemgesundheit über Azure Monitor

- Verwalten Sie verschlüsselte Schlüssel und Geheimnisse über Azure Key Vault

- Erleichtern Sie die Versionskontrolle und CI/CD über Azure DevOps und GitHub

- Stellen Sie die Cloud-Sicherheitsverwaltung über Microsoft Defender for Cloudsicher