Créez plus rapidement des applications d'IA générative avec les nouvelles capacités de modèle de fondation

Accédez, gouvernez et surveillez n'importe quel modèle de fondation avec le Model Serving de Databricks

Suite aux annonces que nous avons faites la semaine dernière concernant la génération augmentée par récupération (RAG), nous sommes ravis d'annoncer des mises à jour majeures pour le Model Serving. Databricks Model Serving propose désormais une interface unifiée, qui facilite l'expérimentation, la personnalisation et la mise en production de modèles de fondation sur tous les clouds et fournisseurs. Cela signifie que vous pouvez créer des applications d'IA générative (GenAI) de haute qualité en utilisant le modèle le mieux adapté à votre cas d'usage, tout en exploitant en toute sécurité les données propres à votre organisation.

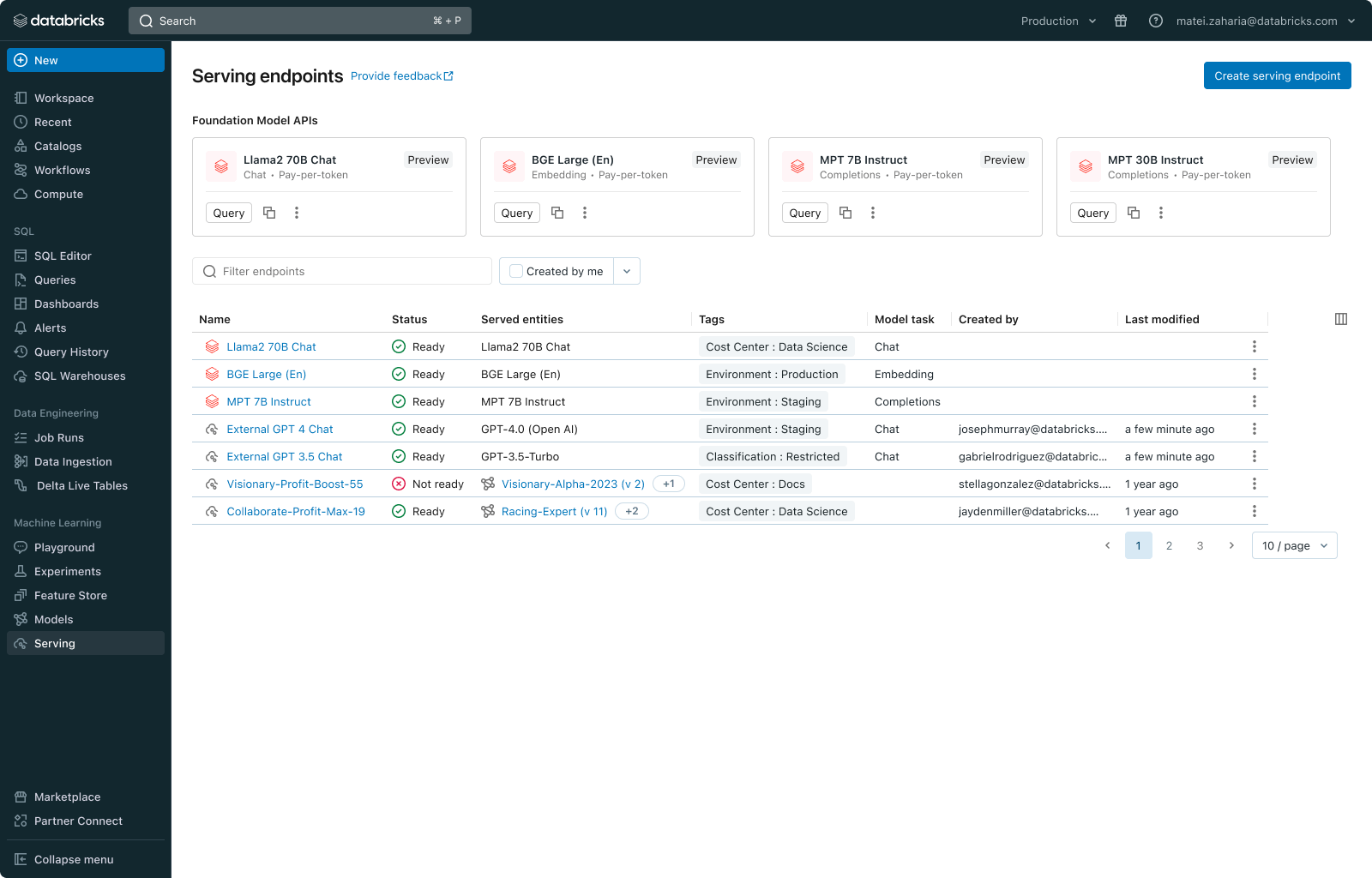

La nouvelle interface unifiée vous permet de gérer tous les modèles en un seul endroit et de les queryer avec une seule API, qu'ils soient sur Databricks ou hébergés en externe. De plus, nous lançons les API de modèles de fondation qui vous donnent un accès instantané aux grands modèles de langage (LLM) populaires, tels que les modèles Llama2 et MPT, directement depuis Databricks. Ces APIs s'accompagnent d'options de Tarifs à la demande, telles que le paiement par jeton ou le débit provisionné, ce qui réduit les coûts et augmente la flexibilité.

Commencez à créer des applications GenAI dès aujourd'hui ! Visitez le Databricks AI Playground pour essayer rapidement des modèles d'IA générative directement depuis votre workspace.

Défis liés à la mise en production des modèles de fondation

Les outils ont révolutionné tous les secteurs d'activité, et nous pensons que l'IA transformera bientôt les outils existants pour les rendre plus intelligents. Les implications sont vastes et variées, et touchent tous les domaines, du support client à la santé en passant par l'éducation. Bien que nombre de nos clients aient déjà commencé à intégrer l'IA dans leurs produits, le passage à la production à grande échelle se heurte encore à plusieurs défis :

- Expérimentation sur plusieurs modèles : chaque cas d'utilisation nécessite une expérimentation pour identifier le meilleur modèle parmi plusieurs options open source et propriétaires. Les entreprises doivent expérimenter rapidement sur différents modèles, ce qui implique de gérer les identifiants, les limites de débit, les autorisations et les syntaxes de requête des différents fournisseurs de modèles.

- Manque de contextualisation : les modèles de base possèdent des connaissances généralistes mais manquent d'expertise dans un domaine et ne maîtrisent pas les savoirs internes. Utilisés tels quels, ils ne répondent pas entièrement aux exigences métier uniques.

- Opérationnalisation des modèles : les requêtes et les réponses des modèles doivent faire l'objet d'une surveillance constante pour des raisons de qualité, de débogage et de sécurité. Les disparités d'interface entre les modèles compliquent les efforts de gouvernance et d'intégration.

Model Serving de Databricks : un service unifié pour n'importe quel modèle de fondation

Databricks Model Serving est déjà utilisé en production par des centaines d'entreprises pour un large éventail de cas d'usage, y compris les grands modèles de langage et les applications de vision. Avec la dernière mise à jour, nous simplifions considérablement la query, la gouvernance et la supervision de n'importe quel modèle de fondation.

« Avec le service de modèles Databricks, nous intégrons l'IA générative à nos processus pour améliorer l'expérience client et accroître l'efficacité de nos opérations. Le service de modèles nous permet de déployer des LLM tout en conservant un contrôle total sur nos données et nos modèles. » — Ben Dias, Directeur de la Data Science et de l'analytique chez easyJet

Accédez à n'importe quel modèle de fondation

Databricks Model Serving prend en charge n'importe quel modèle de fondation, qu'il s'agisse d'un modèle entièrement personnalisé, d'un modèle géré par Databricks ou d'un modèle de fondation tiers. Cette flexibilité vous permet de choisir le bon modèle pour le bon job, ce qui vous permet de rester à la pointe des progrès futurs dans la gamme de modèles disponibles. Pour concrétiser cette vision, nous introduisons aujourd'hui deux nouvelles fonctionnalités :

- APIs de modèle de fondation: les APIs de modèle de fondation fournissent un accès instantané aux modèles de fondation populaires sur Databricks. Ces API suppriment complètement les contraintes liées à l'hébergement et au déploiement des modèles de fondation, tout en garantissant la sécurité de vos données au sein du périmètre de sécurité de Databricks. Vous pouvez commencer à utiliser les APIs de modèle de fondation sur la base d'un paiement par jeton, ce qui réduit considérablement les coûts opérationnels. Pour les charges de travail nécessitant des modèles affinés ou des garanties de performances, vous pouvez également passer à Provisioned Throughput (anciennement connu sous le nom d'Optimized LLM Serving). Les API prennent actuellement en charge divers modèles, notamment des modèles de chat (llama-2-70b-chat), de complétion (mpt-30B-instruct & mpt-7B-instruct) et d'intégration (bge-large-en-v1.5). Nous étendrons l'offre de modèles au fil du temps.

- Modèles externes: les modèles externes (anciennement AI Gateway) vous permettent d'ajouter des points de terminaison pour accéder à des modèles hébergés en dehors de Databricks, tels que les modèles GPT d'Azure OpenAI, les modèles Claude d'Anthropic ou les modèles Bedrock d'AWS. Une fois ajoutés, ces modèles peuvent être gérés depuis Databricks.

De plus, nous avons ajouté une liste de modèles de fondation sélectionnés à la Databricks Marketplace, une open marketplace pour les données et les assets d'IA, qui peuvent être affinés et déployés sur Model Serving.

« Les API Foundation Model de Databricks nous permettent d'interroger des modèles de pointe en quelques clics : nous pouvons ainsi consacrer bien plus de temps à nos clients qu'à la gestion des capacités de calcul. Nous utilisons plusieurs modèles sur la plateforme. Nous sommes impressionnés par la stabilité et la fiabilité dont nous avons profité jusqu'à présent. Et à chaque difficulté, nous avons reçu un excellent soutien. » — Sidd Seethepalli, CTO et fondateur, Vellum

Démarrer avec l'ETL

"Le produit des APIs de modèles de fondation de Databricks a été extrêmement simple à configurer et à utiliser dès la première utilisation, ce qui a grandement simplifié nos workflows RAG. Nous avons été impressionnés par les performances, le throughput et les Tarifs que nous avons observés avec ce produit, et nous sommes ravis du temps qu'il nous a fait gagner !” - Ben Hills, PDG, HeyIris.AI"

Interrogez des modèles via une interface unifiée

Databricks Model Serving propose désormais une API et un SDK unifiés compatibles avec OpenAI pour interroger facilement les modèles de fondation. Vous pouvez également interroger des modèles directement depuis SQL via des fonctions d'IA, ce qui simplifie l'intégration de l'IA dans vos workflows d'analyse. Une interface standard permet une expérimentation et une comparaison faciles. Par exemple, vous pouvez commencer avec un modèle propriétaire, puis passer à un modèle ouvert affiné pour réduire la latence et les coûts, comme le montre la documentation générée par l'IA de Databricks.

Gérer et surveiller tous les modèles

La nouvelle interface utilisateur et la nouvelle architecture de Databricks Model Serving permettent de gérer en un seul endroit tous les points de terminaison de modèle, y compris ceux hébergés en externe. Cela inclut la possibilité de gérer les autorisations, de suivre les limites d'utilisation et de surveiller la qualité de tous les types de modèles. Par exemple, les administrateurs peuvent configurer des modèles externes et accorder l'accès à des équipes et à des applications, leur permettant ainsi de queryer les modèles via une interface standard sans exposer leurs identifiants. Cette approche démocratise l'accès aux puissants LLM SaaS et ouverts au sein d'une organisation, tout en fournissant les garde-fous nécessaires.

« Databricks Model Serving accélère nos projets d'IA en simplifiant et en sécurisant l'exploitation et la gestion de plusieurs modèles SaaS et ouverts, qu'ils soient hébergés dans Databricks ou en dehors. Son approche centralisée, qui simplifie la gestion de la sécurité et des coûts, allège la charge administrative de nos équipes de données qui peuvent librement se concentrer sur l'innovation. » — Greg Rokita, AVP Technologie, Edmunds.com

Personnalisez les modèles en toute sécurité avec vos données privées

Construit sur une plateforme d'intelligence des données, Databricks Model Serving facilite l'extension de la puissance des modèles de fondation à l'aide de techniques telles que la génération augmentée par récupération (RAG), l'affinement efficace en termes de paramètres (PEFT) ou l'affinement standard. Vous pouvez affiner les modèles de fondation avec des données propriétaires et les déployer sans effort sur Model Serving. Le nouveau Databricks Vector Search s'intègre en toute transparence à Model Serving, vous permettant de générer des réponses à jour et contextuellement pertinentes.

« Grâce à Databricks Model Serving, nous avons rapidement déployé un modèle d'IA GenAI affiné pour Stardog Voicebox, un outil de questions-réponses et de modélisation de données qui démocratise l'analytique d'entreprise et réduit le coût des Graphes de connaissances. La facilité d'utilisation, les options de déploiement flexibles et l'optimisation des LLM fournies par Databricks Model Serving ont accéléré notre processus de déploiement, libérant notre équipe pour qu'elle puisse se concentrer sur l'innovation plutôt que sur la gestion de l'infrastructure. » — Evren Sirin, CTO et co-fondateur de Stardog

Commencez dès maintenant avec Databricks AI Playground

Visitez l'AI Playground dès maintenant et commencez immédiatement à interagir avec de puissants modèles de fondation. Avec l'AI Playground, vous pouvez envoyer des prompts, comparer et ajuster des paramètres tels que le prompt système et les paramètres d'inférence, le tout sans avoir besoin de compétences en programmation.

Pour plus d'informations

- Explorez la documentation de l'API des modèles de fondation et des modèles externes.

- Découvrez les modèles de fondation dans la Marketplace Databricks

- Inscrivez-vous à un webinaire Databricks sur l'IA générative

- Vous souhaitez résoudre des cas d'usage d'IA générative ? Participez au Hackathon sur l'IA générative de Databricks & AWS ! Inscrivez-vous ici

- Accédez à la page web Databricks Model Serving

Ne manquez jamais un article Databricks

Et ensuite ?

Engenharia

21 janvier 2026/14 min de lecture