Orchestrazione nativamente gestita per qualsiasi carico di lavoro

Orchestrazione unificata per dati, analitiche e AI sulla Data Intelligence Platform

CLIENTI CHE UTILIZZANO I LAVORI DI LAKEFLOW

Orchestrare qualsiasi workflow di dati, analisi o AI

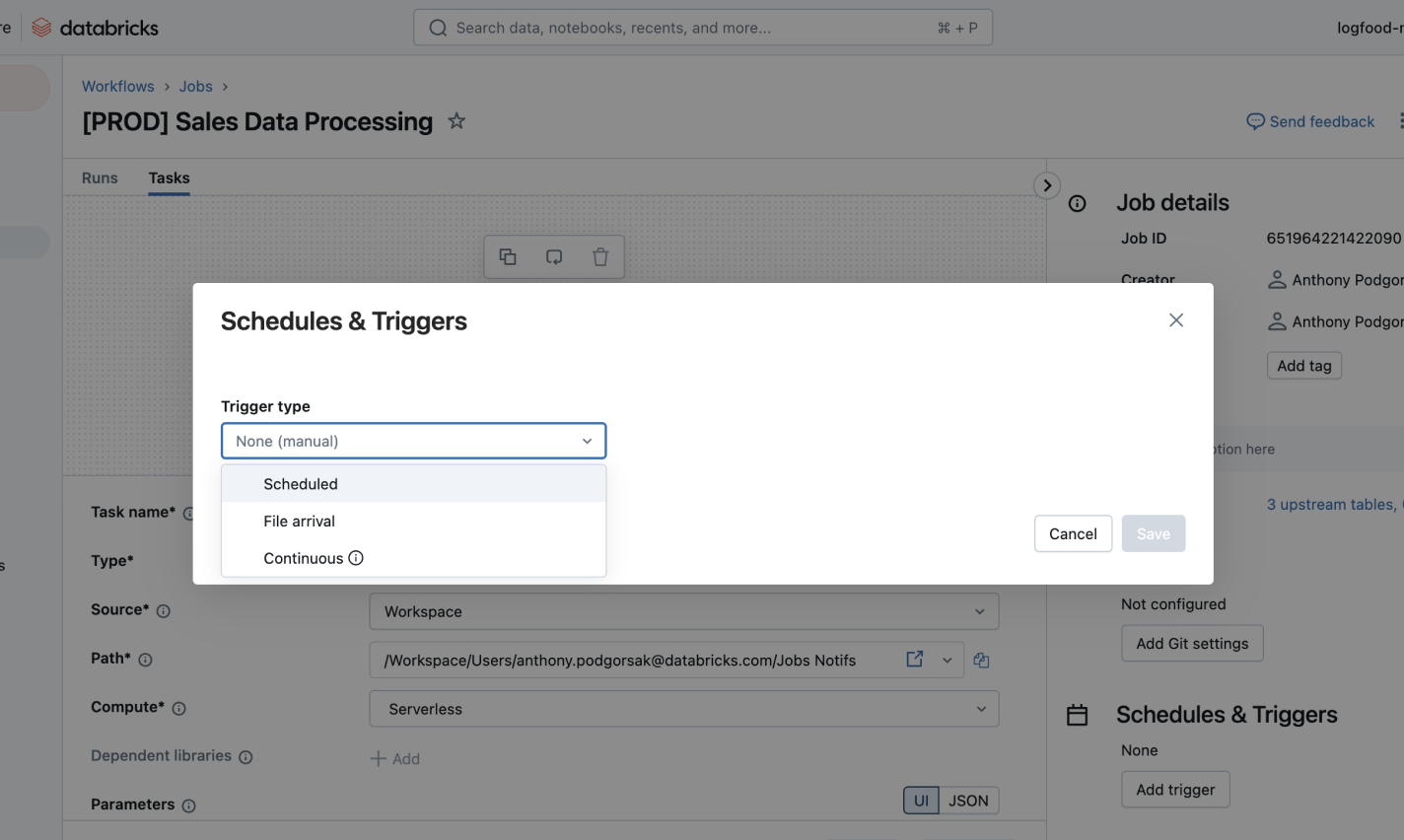

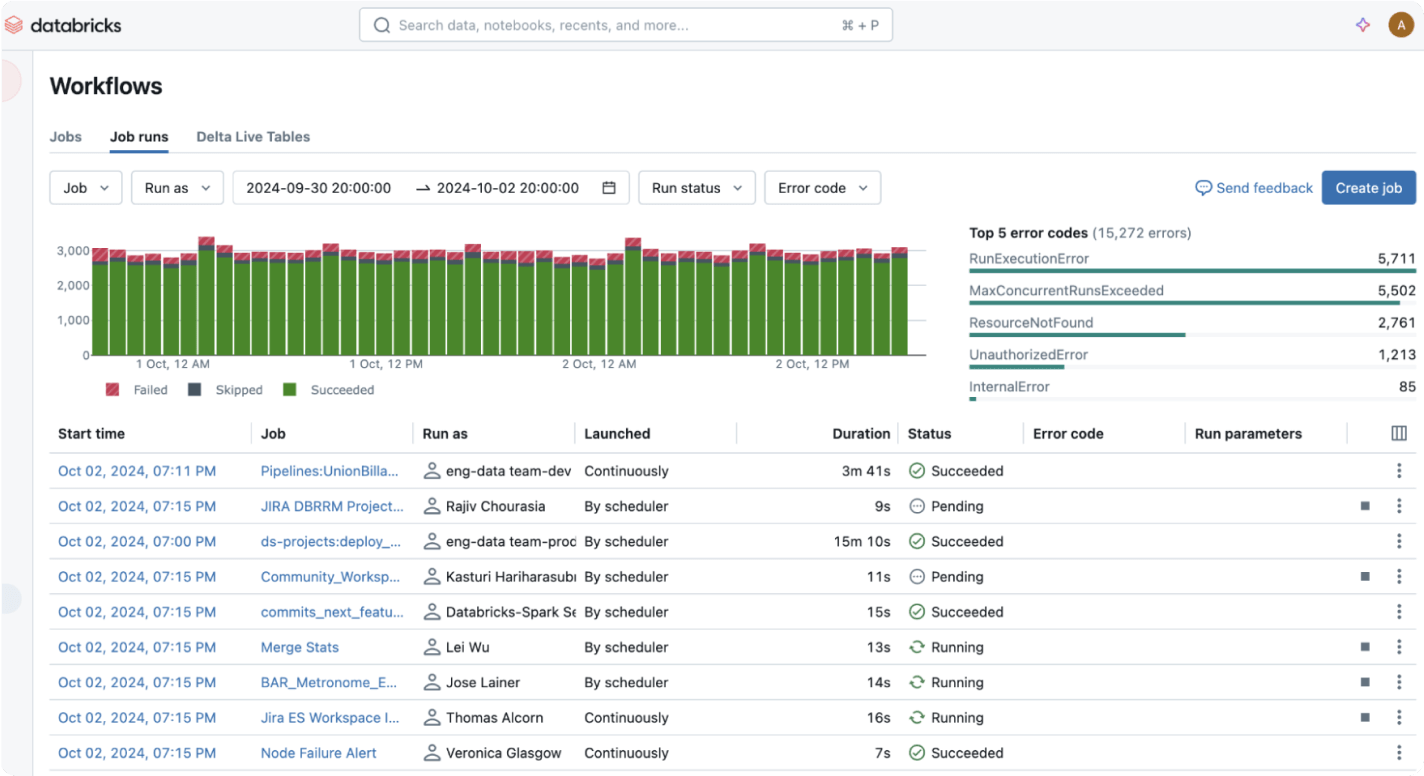

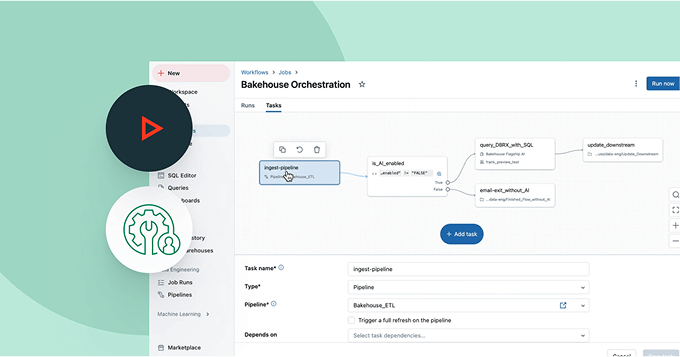

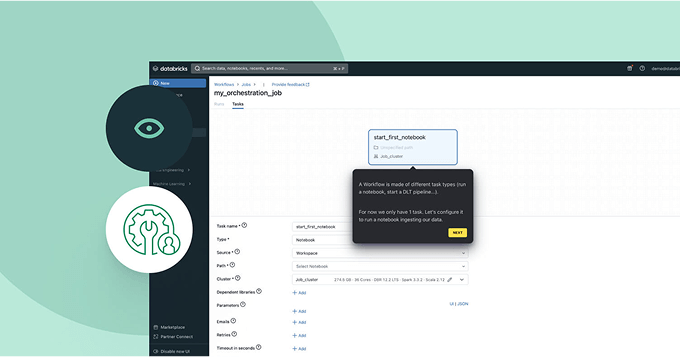

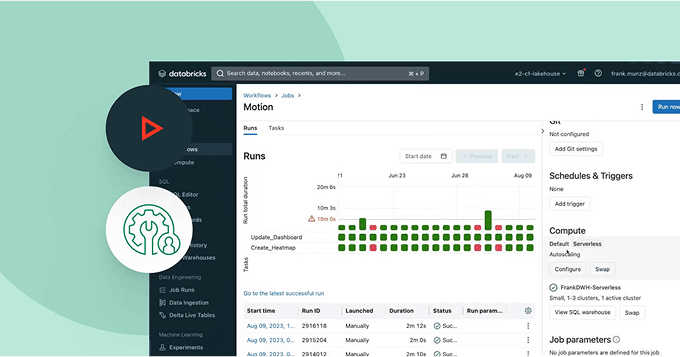

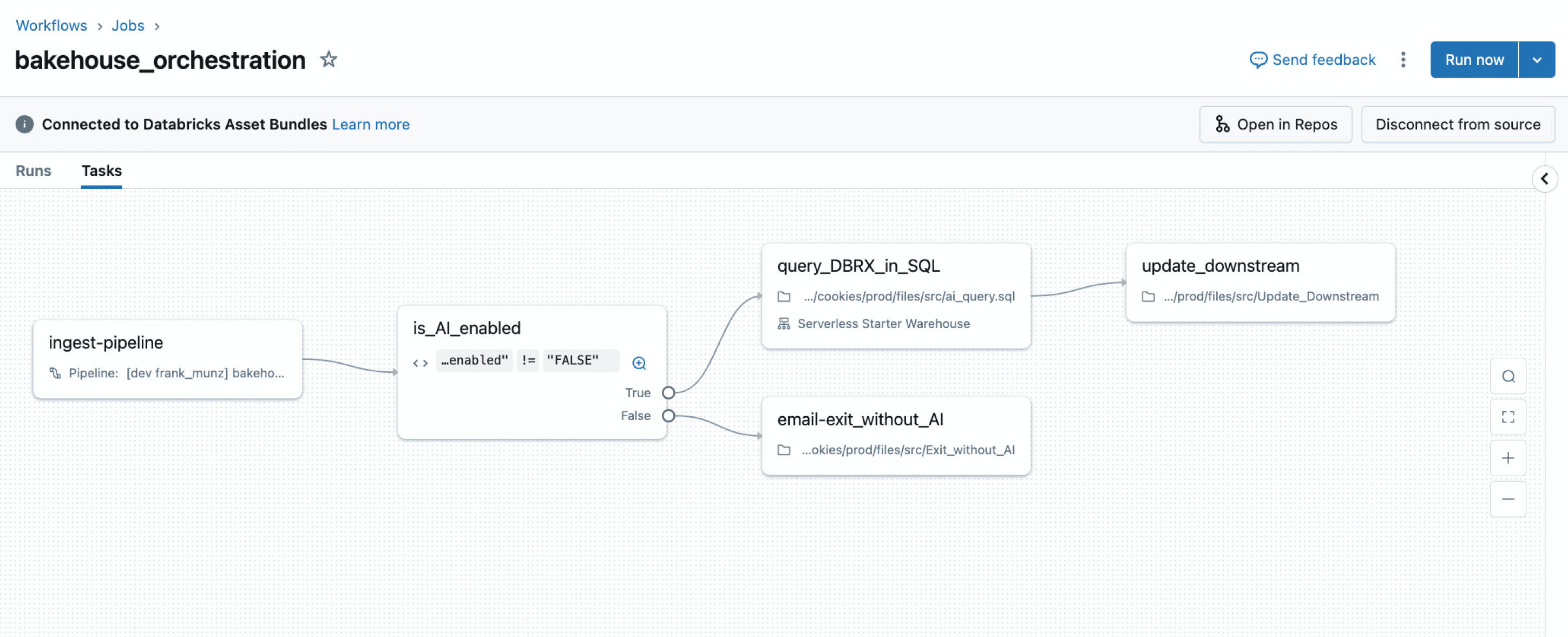

Semplifica le tue pipeline con un servizio di orchestrazione gestito completamente integrato nella tua piattaforma di dati. Definisci facilmente, monitora e automatizza i flussi di lavoro ETL, di analisi e di ML con affidabilità e profonda osservabilità.Semplifica e orchestri i tuoi flussi di dati

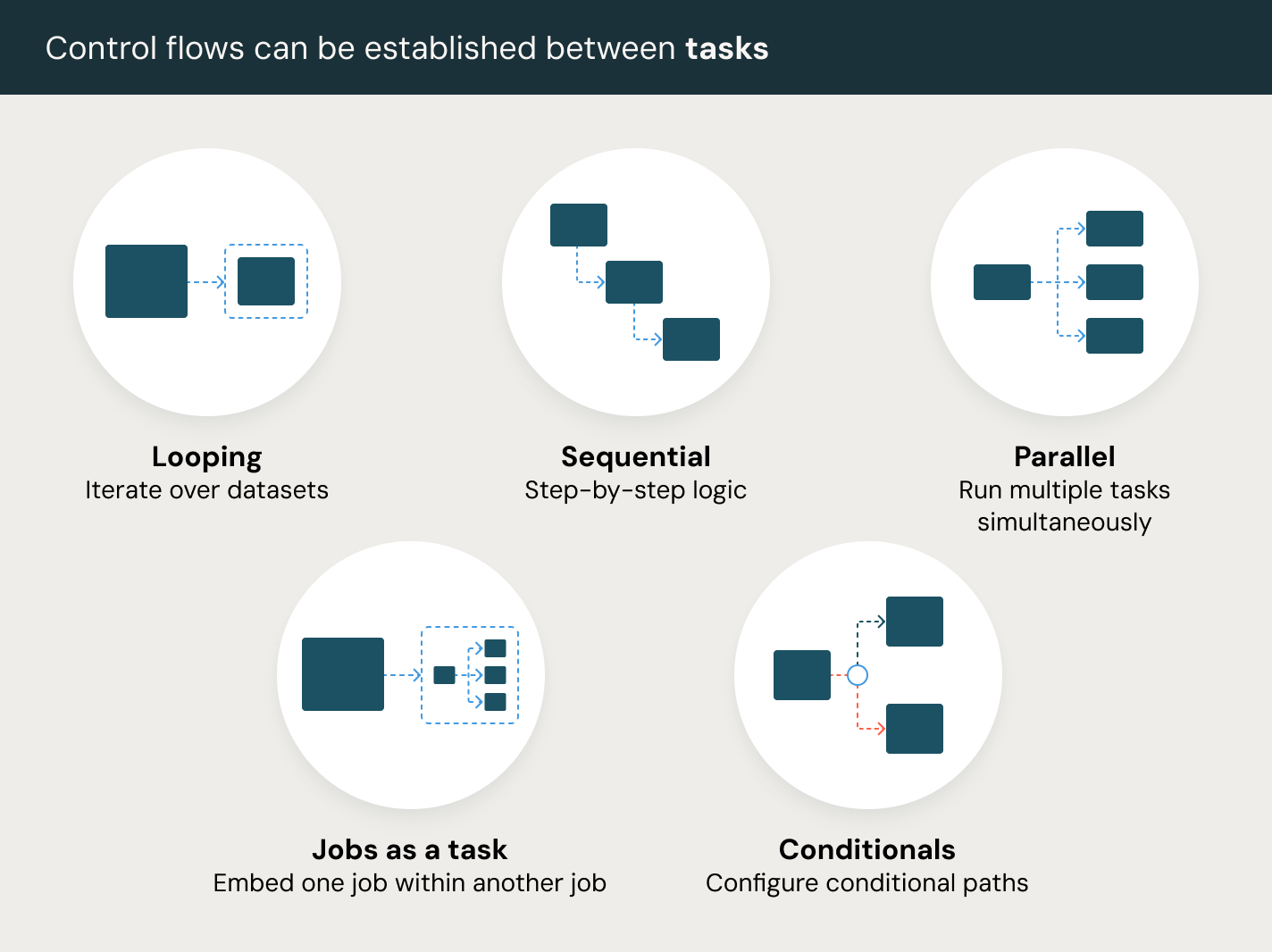

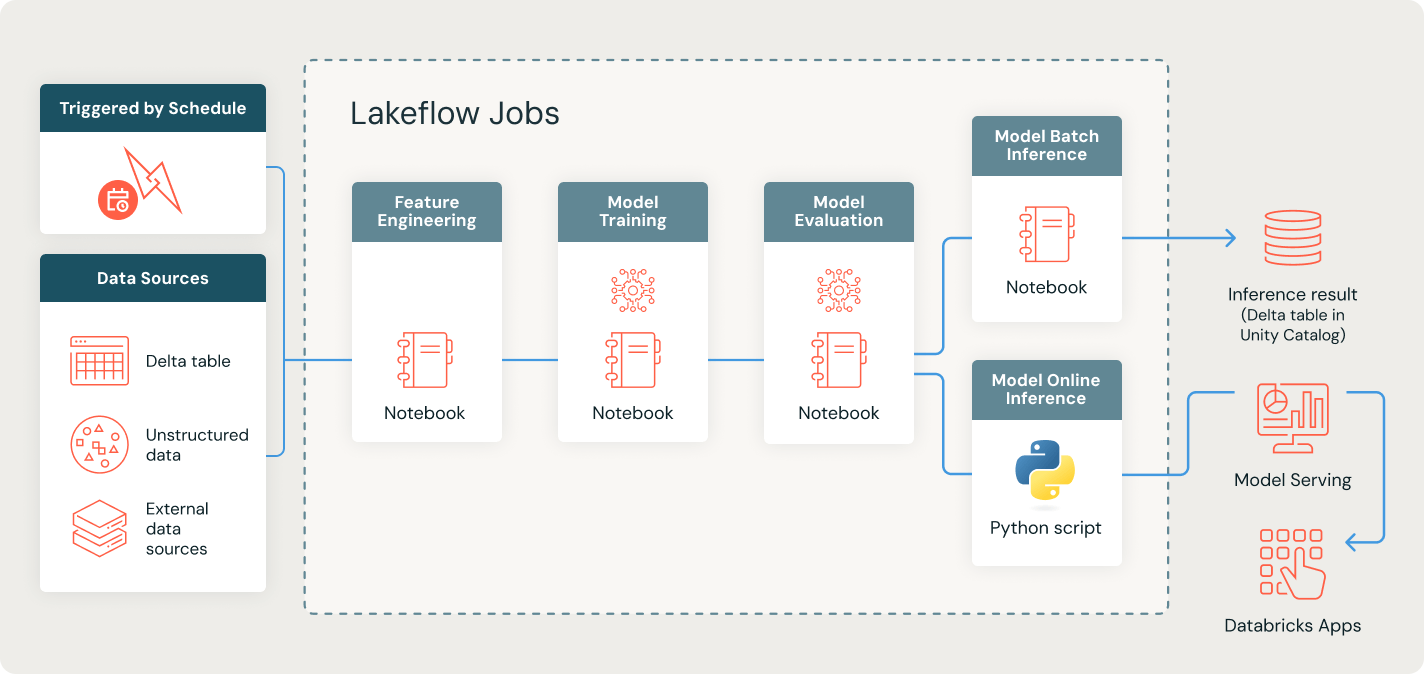

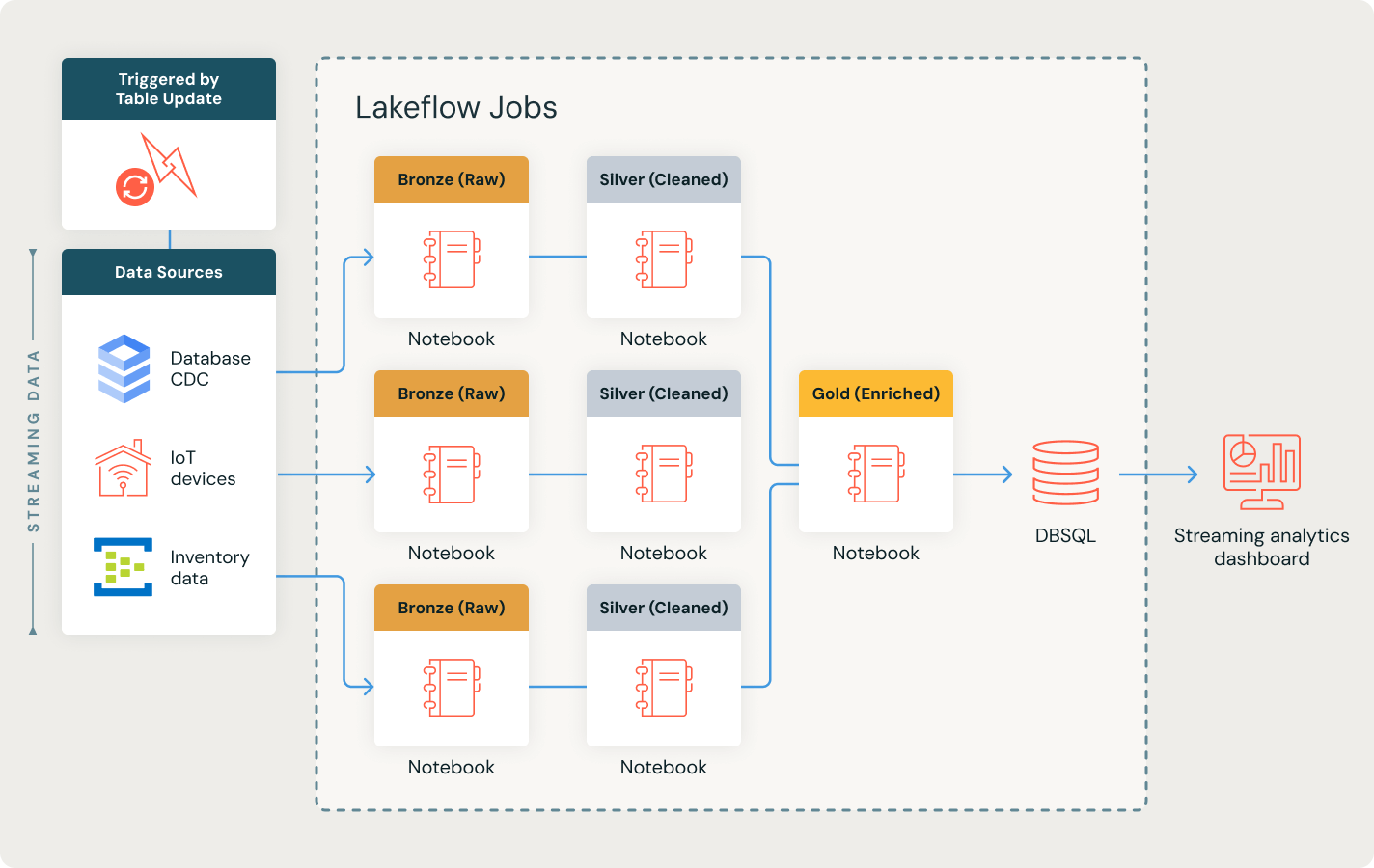

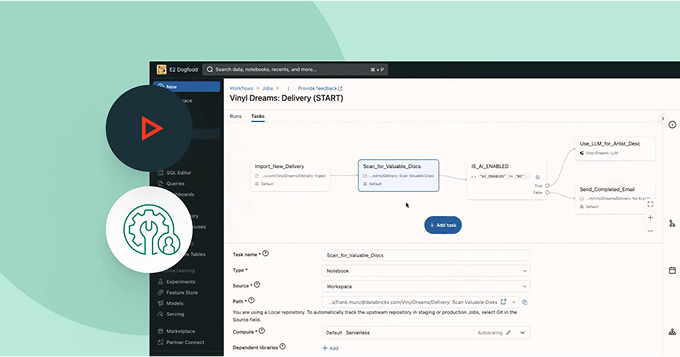

Definisci, gestisci e monitora facilmente i lavori attraverso pipeline ETL, di analisi e di intelligenza artificiale.Sblocca un'orchestrazione senza soluzione di continuità con tipi di attività versatili, tra cui notebook, SQL, Python e altro, per alimentare qualsiasi flusso di lavoro dei dati.

Altre funzioni

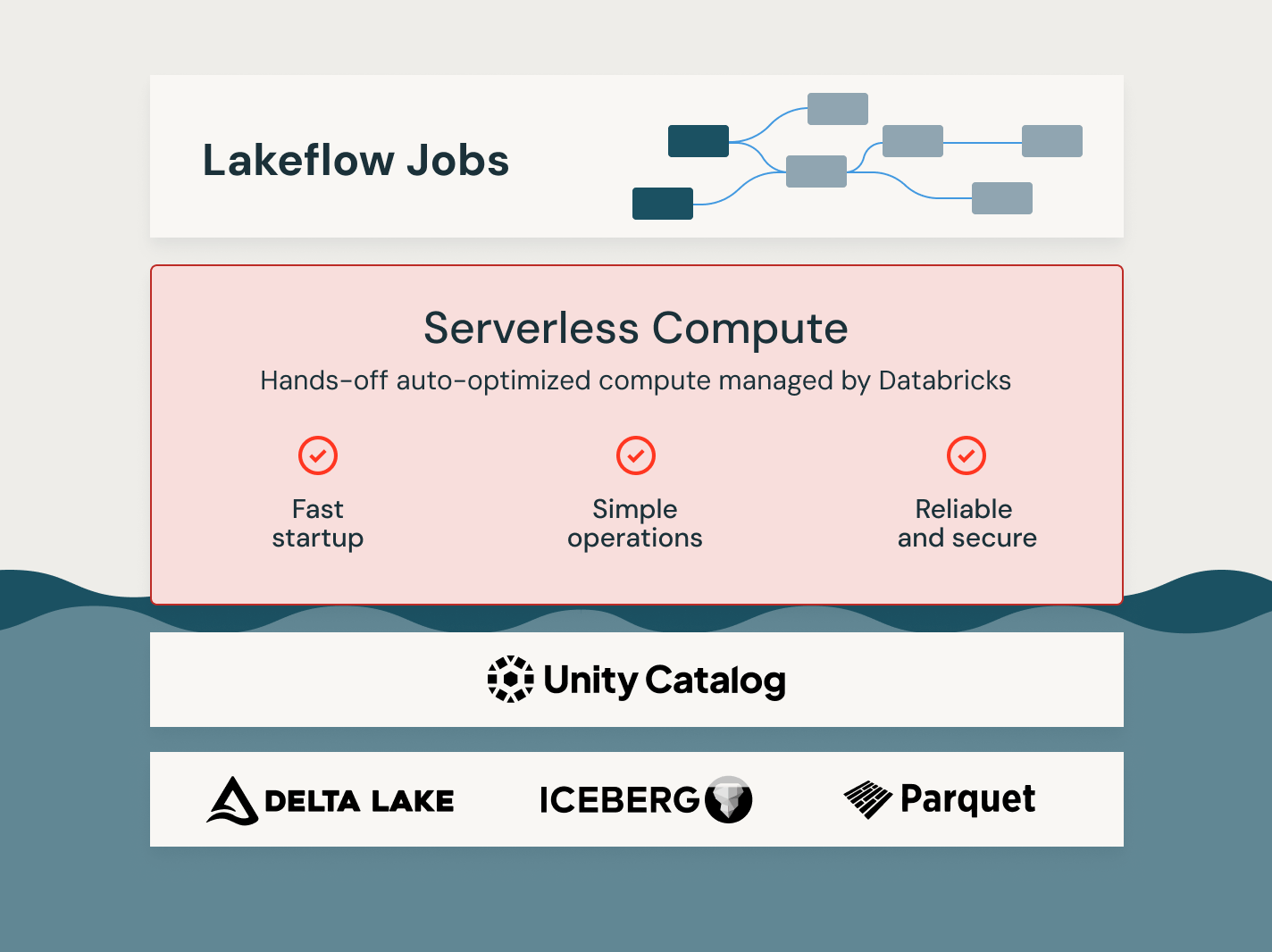

Sblocca il potere dei Lavori Lakeflow

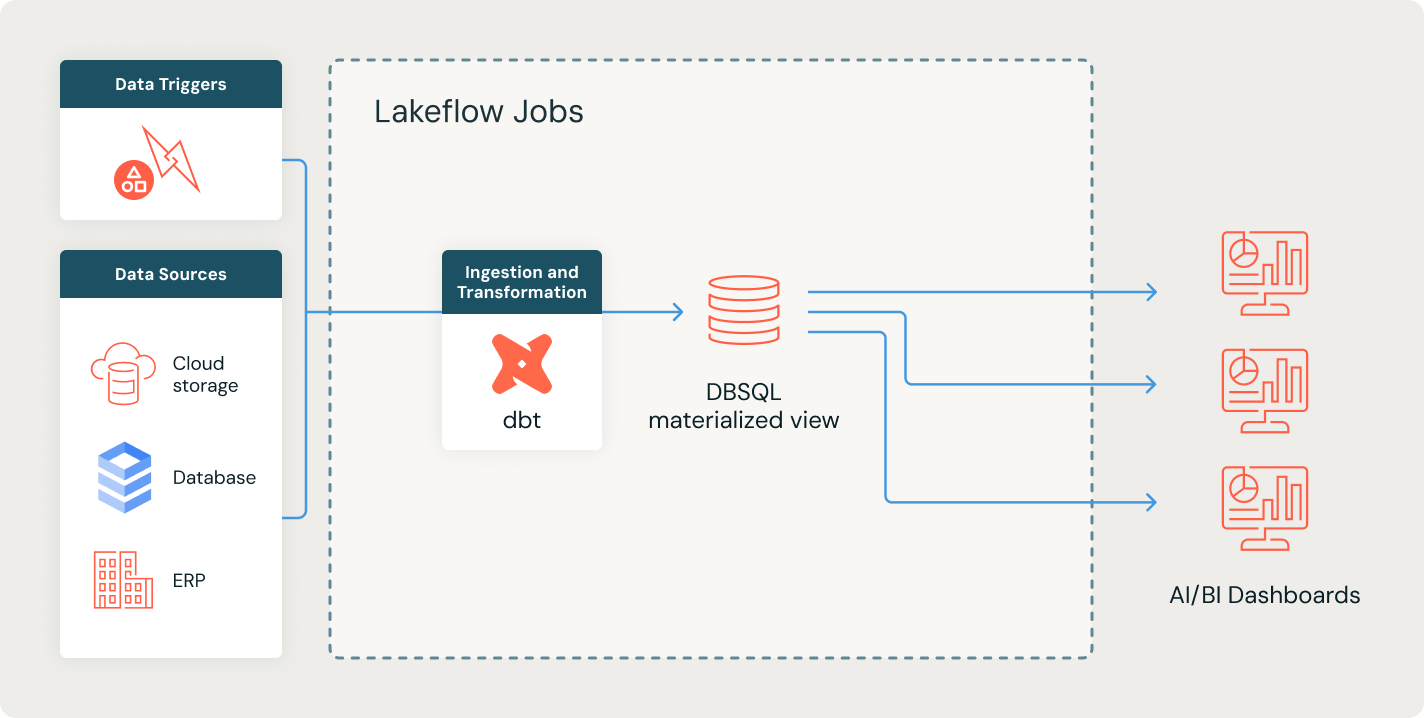

Automatizza l'orchestrazione dei dati per i processi di estrazione, trasformazione, caricamento (ETL)

Automatizza l'ingestione e la trasformazione dei dati da varie fonti in Databricks, garantendo una preparazione dei dati accurata e coerente per qualsiasi carico di lavoro.

Esplora le demo dei lavori di Lakeflow

Scopri di più

Scopri come la Databricks Data Intelligence Platform supporta i tuoi team di dati in tutti i carichi di lavoro di dati e AI.LakeFlow Connect

Connettori efficienti per l'acquisizione di dati da qualsiasi fonte e integrazione nativa con la Data Intelligence Platform facilitano l'accesso all'analisi e all'AI, con una governance unificata.

Spark Declarative Pipelines

Fornisce pipeline dichiarative semplificate per l'elaborazione di dati batch e streaming, garantendo trasformazioni automatizzate e affidabili per compiti di analisi e AI/ML.

Databricks Assistant

Sfrutta l'assistenza potenziata dall'IA per semplificare la codifica, debug dei flussi di lavoro e ottimizzare le query utilizzando il linguaggio naturale per un ingegneria e analisi dei dati più veloce ed efficiente.

Archiviazione nel lakehouse

Unifica i dati nel tuo lakehouse, di qualunque formato e tipo, per tutti i tuoi carichi di lavoro di analisi e AI.

Unity Catalog

Gestisci tutti i tuoi asset di dati con l'unica soluzione di governance unificata e aperta del settore per dati e AI, integrata nella Databricks Data Intelligence Platform.

La Data Intelligence Platform

Scopri come la Databricks Data Intelligence Platform abilita i tuoi carichi di lavoro di dati e AI.

Fai il passo successivo

FAQ sui lavori di Lakeflow

Sei pronto a mettere dati e AI alla base della tua azienda?

Inizia il tuo percorso di trasformazione dei dati