データエンジニアリングとストリーミングの最新動向 - 2024年1月

Databricksはこのほど、当社が開拓したレイクハウス・アーキテクチャの自然な進化形であるデータ・インテリジェンス・プラットフォームを発表しました。 データ・インテリジェンス・プラットフォームとは、組織固有のデータを深く理解し、誰でも簡単に必要なデータにアクセスし、ターンキー方式のカスタムAIアプリケーションを迅速に構築できるようにする、単一の統合プラットフォームという考え方です。

データインテリジェンスプラットフォーム上に構築されたすべてのダッシュボード、アプリ、およびモデルが適切に機能するには信頼できるデータが必要であり、信頼できるデータには最高のデータエンジニアリングプラクティスが必要です。 Databricksは、Spark、Delta Lake、ワークフロー、Delta Live Tables、そしてDatabricks Assistantのような新しいAI機能を通じて、データエンジニアにベストプラクティスを提供してきました。

AIの時代には、データエンジニアリングのベストプラクティスがさらに重要になります。 私たちは、データ・インテリジェンス・プラットフォームのインテリジェンスを引き続き引き出す、明確なジェネレーティブAI機能へのアクセスを民主化することに尽力していますが、それと同様に、基礎的なデータエンジニアリングの提供を通じて、中核となる革新に取り組んでいます。 結局のところ、経営幹部のほぼ3/4は、信頼性の低いデータがAIイニシアチブの成功に対する唯一最大の脅威であると考えています。

2023年6月に開催されたData + AI Summitでは、データエンジニアリングとストリーミングのポートフォリオにおける新機能の発表を行いました。

アナリストの評価

Databricks は最近、The ForresterWave™ のリーダーに選ばれました:Cloud Data Pipelines, Q4 2023においてリーダーに選ばれました。 Forrester社は、クラウド・データ・パイプライン・プロバイダーを26の基準で評価し、最も重要なものを特定して調査、分析、採点しました。 本レポートでは、各プロバイダーの評価を示し、データ管理プロフェッショナルがニーズに合ったプロバイダーを選択できるよう支援しま��す。

主要ベンダーの現在の製品、戦略、市場での存在感に関するForresterの見解など、本レポートはこちらからご覧いただけます。

Databricksのデータインテリジェンスプラットフォームは、AIとアナリティクスのイニシアチブのためのデータパイプラインを構築するための最適な場所です。 このビジョンを実現するために、過去6ヶ月間の新機能をご紹介します。

データの取り込み

11月には、リアルタイム・データ・レプリケーション技術のリーディング・プロバイダーであるArcion社の買収を発表しました。 Arcion の機能により、Databricks はさまざまなデータベースや SaaS アプリケーションからデータを複製および取り込むためのネイティブソリューションを提供できるようになり、顧客はデータから価値と AI 主導の洞察を生み出す実際の作業に集中できるようになります。

Arcion のコードオプション、低メンテナンスの Change Data Capture (CDC) テクノロジーは、Oracle、SQL Server、SAP などのエンタープライズデータベースシステムや、Salesforce、Workday などの SaaS アプリケーションへのネイティブコネクタを通じて、ダウンストリーム分析、ストリーミング、AIのユースケースを可能にする Databricks プラットフォームの新機能を強化します。

Spark 構造化ストリーミング

Spark Structured Streamingはスト��リーム処理に最適なエンジンであり、DatabricksはSparkワークロードを実行するのに最適な場所です。 Spark Structured Streamingエンジン上に構築されたDatabricksストリーミングの以下の改善は、リアルタイム分析、リアルタイムのAI + ML、リアルタイムの運用アプリケーションなどのユースケースを強化するための長年のストリーミングイノベーションを拡張するものです。

Apache Pulsarのサポート

Apache Pulsarは、オールインワンのメッセージングおよびストリーミング・プラットフォームであり、Apacheソフトウェア財団のトップ10プロジェクトです。

Project Lightspeedの理念の1つは、エコシステムの拡大です。 Kafka、Kinesis、Event Hubs、Azure Synapse、Google Pub/Subなどのメッセージ・キューに対する既存のサポートに加え、Databricks Runtime 14.1以上では、Structured Streamingを使用してApache PulsarからDatabricks上でデータをストリーミングすることができます。 他のメッセージング/ストリーミング・ソースと同様、構造化ストリーミングは、Pulsarソースから読み取られたデータに対し、正確に一度だけ処理するセマンティクスを提供します。

すべてのソースはこちらで、特にパルサー・コネクターのドキュメントはこちらでご覧いただけます。

ストリーミングソースとしてのUnity Catalogビュー

ガートナー®: Databricks、クラウドデータベースのリーダー

Databricks Runtime 14.1以上では、Structured Streamingを使用して、Unity Catalogに登録されたビューからストリーミング読み取りを実行できます。 詳しくはドキュメントをご覧ください。

AAD認証サポート

Databricksは、Azure Event HubsでDatabricks Kafkaコネクタを使用する際に、多くの組織で必須の認証プロトコルであるAzure Active Directory認証をサポートするようになりました。

Delta Live Tables

Delta Live Tables(DLT) は、Databricks Data Intelligence Platform のための宣言型 ETL フレームワークで、ストリーミングおよびバッチ ETL をコスト効率よく簡素化します。 DLTでデータパイプラインを作成すると、ユーザーは実行する変換を定義するだけで、タスクオーケストレーション、クラスタ管理、モニタリング、データ品質、エラー処理が自動的に行われます。

フローの追加API

append_flow API を使用すると、パイプライン内の 1 つのストリーミングテーブルに複数のストリームを書き込むことができます (たとえば、複数の Kafka トピックから)これにより、ユーザーは以下のことが可能になります:

- 完全な更新を必要とせずに、既存のストリーミング・テーブルにデータを追加するストリーミング・ソースの追加と削除

- 欠落している履歴データを追加して、ストリーミング・テーブルを更新します(バックフィル)

正確な構文と例については、こちらのドキュメントをご覧ください。

Unity Catalog インテグレーション

Unity Catalogは、DLTパイプラインを含むすべてのデータおよびAI資産にわたって、Data Intelligence Platform上で統一されたガバナンスを実現する鍵です。 デルタ・ライブ・テーブルとUnityカタログの統合には、最近��いくつかの改良が加えられました。 以下がサポートされました:

- Unityカタログ・スキーマへのカスタム・ストレージ・ロケーションによるテーブルの書き込み

- HiveメタストアからUnityカタログにDLTパイプラインをクローンすることで、HMSパイプラインをUnityカタログに簡単かつ迅速に移行可能

サポート内容の完全なドキュメントはこちらをご覧ください。

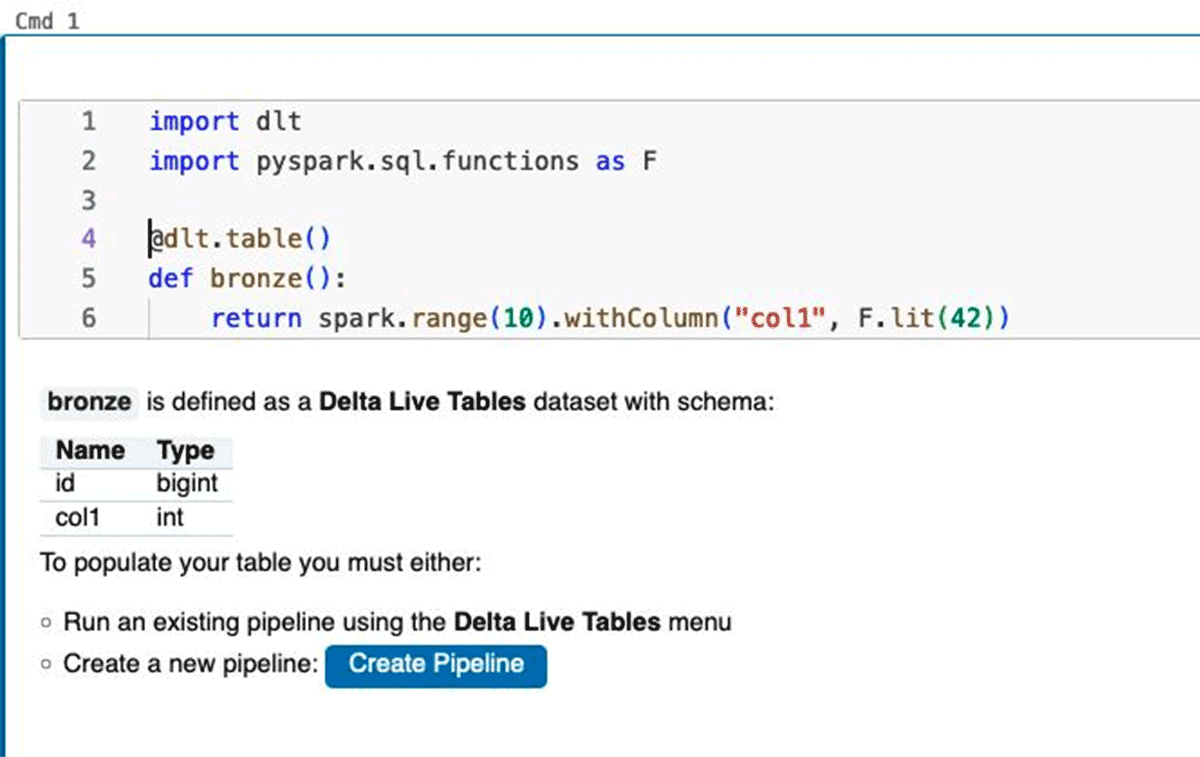

開発者エクスペリエンス+ノートブックの改善

Databricks Runtime 13.3以降でインタラクティブクラスタを使用すると、通常のDBRクラスタでDLTコードを定義している個々のノートブックセルを実行することで、実際にデータを処理することなく、ノートブックコードの構文エラーや解析エラーを早期に発見できるようになります。 これにより、構文エラー、間違ったテーブル名、間違ったカラム名などの問題を、実際にパイプラインを実行することなく、開発プロセスの早い段階で発見することができます。 また、ノートブックセルの実行を通じて、DLTデータセットのスキーマをインクリメンタルに構築し、解決することもできます。

Google Cloud GA

DLTパイプラインはGoogle Cloudで一般的に利用できるようになり、データエンジニアはGCPクラウド環境で信頼性の高いストリーミングおよびバッチデータパイプラインを容易に構築できるようになりました。 Databricks は、DLT パイプラインの可用性を Google Cloud に拡大することで、パートナーフレンドリーなエコシステムを提供すると同時に、顧客のニーズに最適なクラウドプラットフォームを柔軟に選択できるようにするというコミットメントを強化しています。 Pub/Subストリーミングコネクタと連携することで、Google Cloud上でストリーミングデータパイプラインをより簡単に扱うことができます。

Databricks Workflows

強化された制御フロー

データオーケストレーションの重要な部分は、タスクの依存関係を管理し、それらのタスクがどのように実行されるかを制御するコントロールフローです。 このため、Databricks Workflowsでは、タスクやジョブパラメータの条件付き実行の導入など、制御フロー機能に重要な追加を行いました。 タスクの条件付き実行とは、"if/else" ロジックをワークフローに追加し、より洗練されたマルチタスク依存関係を定義することで、ワークフローの実行方法に影響を与える条件を追加するユーザーの能力を指します。 ジョブパラメータは、ワークフロー内のすべてのタ�スクで利用可能なキーと値のペアを定義することができ、より詳細な設定を追加することでワークフローの実行方法を制御するのに役立ちます。 これらの新機能については、こちらのブログをご覧ください。

モジュラー・オーケストレーション

お客様がより多くのタスクと依存関係を持つ複雑なワークフローを構築するにつれて、これらのワークフローを保守、テスト、監視することはますます難しくなります。 複雑なワークフローを"子ジョブ" に分割して、より上位の"親ジョブ" 内でタスクとして起動する機能です。この機能により、企業は異なるチームが所有するDAGを分解し、ワークフローの再利用性を導入し、大規模なワークフローをオーケストレーションするための迅速な開発と信頼性の高い運用を実現できます。

最近のイノベーションの概要

これで、Data + AI Summit 2023以降にデータエンジニアリングとストリーミングのポートフォリオで発表した機能の概要を終了します。 以下は、昨年(2023年初頭以降)にブログで紹介した新車発表の全リストです:

- 2023年11月 Databricksワークフローにおける制御フローの強化

- 2023年9月 Databricksワークフローによるデータ分析のオーケストレーション

- 2023年8月 Delta Live Tables GA on Google Cloud

- 2023年8月 構造化ストリーミングにおける複数のステートフル・オペレータ

- 2023年8月 Databricksワークフローによるモジュラー・オーケストレーション

- 2023年7月 Databricksワークフローにおける新たなモニタリングとアラート機能

- 2023年6月 データエンジニアリングの最新動向 - DAIS 2023

- 2023年6月 プロジェクト・ライトスピード1年最新情報

- 2023年6月 DB SQLにおけるマテリアライズド・ビューとストリーミング・テーブル

- 2023年6月 デルタ・ライブテーブル + ユニティ・カタログ・インテグレーション

- 2023年6月 Google Pub/Sub コネクタ

- 2023年6月 Spark Structured Streamingにおける適応型クエリー実行

- 2023年5月 UIによるローコードの取り込み

- 2023年5月 スパーク構造化ストリーミングのサブ秒遅延

- 2023年4月 ワークフローの最新情報

- 2023年2月 Databricksワークフローによるdbtプロジェクトのオーケストレーション

- 2023年1月 新しいワークフロー通知

また、四半期ごとに開催されるロードマップウェビナーでは、データエンジニアリングポートフォリオの今後の展開についてご紹介します。 データエンジニア、アナリスト、MLエンジニア、アナリティクスエンジニア、その他多くの方々とパートナーシップを組み、組織内のデータとAIを民主化できることを嬉しく��思います!