Schnellere Entwicklung von KI-Apps mit den neuen Möglichkeiten der Foundation-Modelle

Zugriff, Steuerung und Überwachung aller Basismodelle mit Databricks Model Serving

Im Anschluss an die Ankündigungen, die wir letzte Woche zu Retrieval Augmented Generation (RAG) gemacht haben, freuen wir uns, wichtige Updates für Model Serving bekannt zu geben. Databricks Model Serving bietet jetzt eine einheitliche Benutzeroberfläche, die es einfacher macht, mit Foundation Models über alle Clouds und Anbieter hinweg zu experimentieren, sie anzupassen und in die Produktion zu bringen. Das bedeutet, dass Sie hochwertige GenAI-Apps erstellen können, indem Sie das für Ihren Anwendungsfall am besten geeignete Modell verwenden und gleichzeitig die einzigartigen Daten Ihres Unternehmens sicher nutzen.

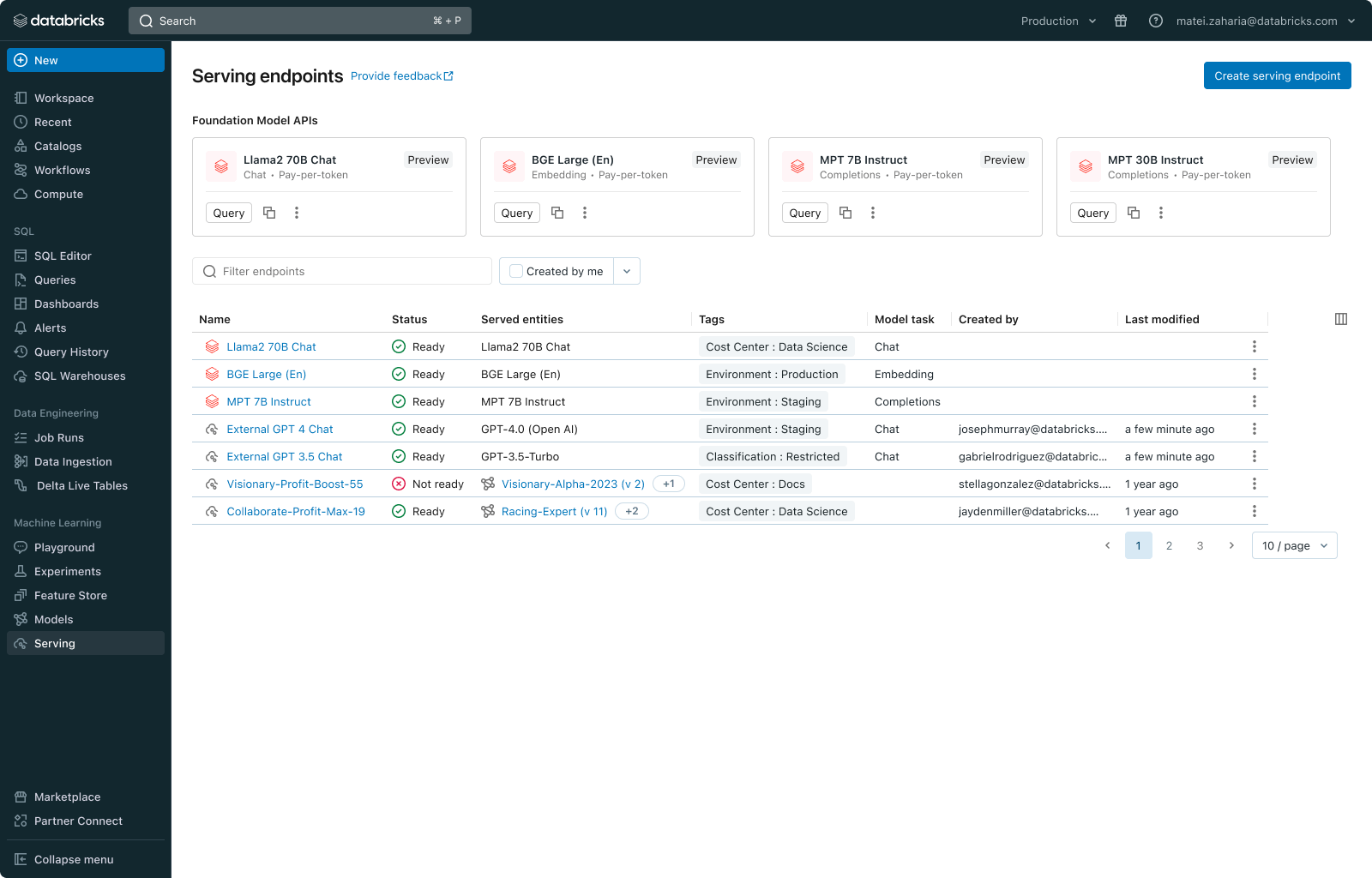

Mit der neuen einheitlichen Benutzeroberfläche können Sie alle Modelle an einem Ort verwalten und sie mit einer einzigen API abfragen, unabhängig davon, ob sie auf Databricks oder extern gehostet werden. Darüber hinaus veröffentlichen wir Foundation Model APIs, die Ihnen sofortigen Zugriff auf beliebte große Sprachmodelle (LLMs) wie Llama2- und MPT-Modelle direkt aus Databricks heraus bieten. Diese APIs bieten On-Demand-Preisoptionen wie Pay-per-Token oder bereitgestellten Durchsatz, was die Kosten senkt und die Flexibilität erhöht.

Entwickeln Sie noch heute GenAI-Apps! Besuchen Sie den Databricks AI Playground, um generative KI-Modelle schnell direkt in Ihrem workspace auszuprobieren.

Herausforderungen bei der Produktivsetzung von Grundlagenmodellen

Software hat jede Branche revolutioniert, und wir sind davon überzeugt, dass KI schon bald bestehende Software transformieren und intelligenter machen wird. Die Auswirkungen sind weitreichend und vielfältig und betreffen alles vom Kundensupport bis zum Gesundheits- und Bildungswesen. Obwohl viele unserer Kunden bereits begonnen haben, KI in ihre Produkte zu integrieren, steht der Übergang zur Produktion im vollen Scale immer noch vor mehreren Herausforderungen:

- Experimentieren mit verschiedenen Modellen: Jeder Anwendungsfall erfordert Experimente, um das beste Modell aus mehreren offenen und proprietären Optionen zu identifizieren. Unternehmen müssen schnell mit verschiedenen Modellen experimentieren, was die Verwaltung von Anmeldeinformationen, Ratenbegrenzungen, Berechtigungen und Abfragesyntaxen von verschiedenen Modellanbietern umfasst.

- Fehlender Unternehmenskontext: Foundation-Modelle verfügen über ein breites Allgemeinwissen, es fehlt ihnen jedoch an internem Wissen und spezifischer Domänenexpertise. So wie sie sind, erfüllen sie die besonderen Geschäftsanforderungen nicht vollständig.

- Operationalisierung von Modellen: Anfragen und Modellantworten müssen kontinuierlich überwacht werden – etwa im Hinblick auf Qualität, Fehlerbehebung und Sicherheit. Unterschiedliche Schnittstellen zwischen Modellen erschweren dabei Steuerung und Integration.

Databricks Model Serving: Einheitliches Serving für alle Foundation Models

Databricks Model Serving wird bereits von hunderten Unternehmen für eine Vielzahl von Anwendungsfällen produktiv eingesetzt, einschließlich großer Sprachmodelle und Bildverarbeitungsanwendungen. Mit dem neuesten Update machen wir es wesentlich einfacher, Foundation Models abzufragen, zu verwalten und zu überwachen.

„Mit der Modellbereitstellung von Databricks sind wir in der Lage, generative KI in unsere Prozesse zu integrieren, um das Kundenerlebnis zu verbessern und die betriebliche Effizienz zu steigern. Die Modellbereitstellung ermöglicht es uns, LLMs anzuwenden und gleichzeitig die vollständige Kontrolle über unsere Daten und Modelle zu behalten.“ – Ben Dias, Director of Data Science and Analytics bei easyJet

Greifen Sie auf jedes beliebige Foundation Model zu

Databricks Model Serving unterstützt jedes Basismodell, sei es ein vollständig benutzerdefiniertes Modell, ein von Databricks verwaltetes Modell oder ein Basismodell eines Drittanbieters. Diese Flexibilität ermöglicht es Ihnen, das richtige Modell für die jeweilige Aufgabe auszuwählen, sodass Sie bei zukünftigen Fortschritten im Bereich der verfügbaren Modelle immer einen Schritt voraus sind. Um diese Vision zu verwirklichen, stellen wir heute zwei neue Funktionen vor:

- Basismodell-APIs: Basismodell-APIs bieten sofortigen Zugriff auf beliebte Basismodelle auf Databricks. Diese APIs machen den Aufwand für das Hosten und Bereitstellen von Basismodellen überflüssig und stellen gleichzeitig sicher, dass Ihre Daten innerhalb des Sicherheitsbereichs von Databricks geschützt bleiben. Sie können mit den Basismodell-APIs auf Pay-per-Token-Basis beginnen, was die Betriebskosten erheblich reduziert. Alternativ können Sie für Workloads, die feinabgestimmte Modelle oder Leistungsgarantien erfordern, zu Provisioned Throughput (früher bekannt als Optimized LLM Serving) wechseln. Die APIs unterstützen derzeit verschiedene Modelle, darunter Chat- (llama-2-70b-chat), Vervollständigungs- (mpt-30B-instruct & mpt-7B-instruct) und Einbettungsmodelle (bge-large-en-v1.5). Wir werden das Modellangebot im Laufe der Zeit erweitern.

- Externe Modelle: Externe Modelle (früher KI Gateway) ermöglichen es Ihnen, Endpunkte für den Zugriff auf Modelle hinzuzufügen, die außerhalb von Databricks gehostet werden, wie z. B. Azure OpenAI GPT-Modelle, Anthropic Claude-Modelle oder AWS Bedrock-Modelle. Sobald sie hinzugefügt wurden, können diese Modelle von Databricks aus verwaltet werden.

Zusätzlich haben wir eine Liste kuratierter Basismodelle zum Databricks Marketplace hinzugefügt, einem offenen Marktplatz für Daten- und KI-Assets, die feinabgestimmt und auf Model Serving bereitgestellt werden können.

„Mit den Foudation-Modell-APIs von Databricks können wir hochmoderne offene Modelle per Mausklick abfragen, sodass wir uns auf unsere Kunden konzentrieren können, anstatt uns mit Compute herumzuschlagen. Wir haben auf der Plattform mehrere Modelle verwendet und sind von der Stabilität und Zuverlässigkeit, die wir bisher gesehen haben, sowie von dem Support, den wir bei jedem Problem erhalten haben, beeindruckt.“ — Sidd Seethepalli, CTO und Gründer, Vellum

Erste Schritte mit ETL

"Das Produkt „Foundation Model APIs“ von Databricks war extrem einfach einzurichten und sofort einsatzbereit, was unsere RAG-Workflows zum Kinderspiel machte. Wir sind von der Leistung, dem Durchsatz und den Preisen dieses Produkts begeistert und finden es toll, wie viel Zeit wir dadurch einsparen konnten!“ – Ben Hills, CEO, HeyIris.AI"

Modelle über eine einheitliche Schnittstelle abfragen

Databricks Model Serving bietet jetzt eine einheitliche, OpenAI-kompatible API und ein SDK für die einfache Abfrage von Foundation Models. Sie können Modelle auch direkt aus SQL über KI-Funktionen abfragen und so die KI-Integration in Ihre Analyse-Workflows vereinfachen. Eine Standardschnittstelle ermöglicht einfaches Experimentieren und Vergleichen. Sie könnten beispielsweise mit einem proprietären Modell beginnen und dann zu einem feinabgestimmten offenen Modell wechseln, um Latenz und Kosten zu senken, wie die KI-generierte Dokumentation von Databricks zeigt.

Alle Modelle steuern und überwachen

Die neue Benutzeroberfläche und Architektur von Databricks Model Serving ermöglichen die Verwaltung aller Modell-Endpunkte, einschließlich extern gehosteter, an einem einzigen Ort. Dies beinhaltet die Möglichkeit, Berechtigungen zu verwalten, Nutzungslimits zu verfolgen und die Qualität aller Arten von Modellen zu überwachen. Beispielsweise können Administratoren externe Modelle einrichten und Teams und Anwendungen Zugriff gewähren, sodass diese Modelle über eine Standardschnittstelle abfragen können, ohne Anmeldeinformationen preiszugeben. Dieser Ansatz demokratisiert den Zugang zu leistungsstarken SaaS- und offenen LLMs innerhalb einer Organisation und bietet gleichzeitig die notwendigen Leitplanken.

„Databricks Model Serving beschleunigt unsere KI-gestützten Projekte, da dieser Dienst den sicheren Zugriff und die Verwaltung mehrerer SaaS- und offener Modelle erleichtert, einschließlich solcher, die auf oder außerhalb von Databricks gehostet werden. Der zentralisierte Ansatz vereinfacht die Sicherheits- und Kostenverwaltung, sodass sich unsere Datenteams dank geringerem Verwaltungsaufwand verstärkt auf Innovationen konzentrieren können.“ — Greg Rokita, AVP, Technology bei Edmunds.com

Modelle mit Ihren privaten Daten sicher anpassen

Databricks Model Serving basiert auf einer Data Intelligence Platform und erleichtert die Erweiterung der Leistungsfähigkeit von Foundation Models durch Techniken wie Retrieval Augmented Generation (RAG), Parameter-Efficient Fine-Tuning (PEFT) oder Standard-Fine-Tuning. Sie können Basismodelle mit proprietären Daten feinabstimmen und sie mühelos auf Model Serving bereitstellen. Die neu veröffentlichte Databricks Vector Search lässt sich nahtlos in Model Serving integrieren und ermöglicht es Ihnen, aktuelle und kontextrelevante Antworten zu generieren.

„Mit Databricks Model Serving haben wir schnell ein feinabgestimmtes GenAI-Modell für Stardog Voicebox angewendet, ein Tool für Question-Answering und Datenmodellierung, das die Unternehmens-Analytics demokratisiert und die Kosten für Knowledge Graphen reduziert. Die Benutzerfreundlichkeit, die flexiblen Bereitstellungsoptionen und die LLM-Optimierung, die Databricks Model Serving bietet, haben unseren Bereitstellungsprozess beschleunigt, sodass sich unser Team auf Innovationen konzentrieren kann, anstatt die Infrastruktur zu verwalten.“ – Evren Sirin, CTO und Mitbegründer von Stardog

Jetzt mit dem Databricks AI Playground loslegen

Besuchen Sie jetzt den AI Playground und interagieren Sie sofort mit leistungsstarken Foundation Models. Mit dem AI Playground können Sie Prompts eingeben, vergleichen und Einstellungen wie den System-Prompt und Inferenzparameter anpassen – und das alles ohne Programmierkenntnisse.

Weitere Informationen

- Erkunden Sie die Dokumentation zur Foundation Model API und zu den externen Modellen.

- Entdecken Sie Foundation Models im Databricks Marketplace.

- Melden Sie sich für ein Databricks Generative KI Webinaran

- Möchten Sie Anwendungsfälle für Generative KI lösen? Nehmen Sie am Databricks & AWS Generative KI Hackathon teil! Registrieren Sie sich hier

- Gehen Sie zur Webseite von Databricks Model Serving

Verpassen Sie keinen Beitrag von Databricks

Was kommt als Nächstes?

Engenharia

21. Januar 2026/14 min Lesezeit