Framework Mosaic AI Agent

Créez des applications de génération augmentée par récupération (RAG) de haute qualité

La génération augmentée par récupération (RAG) est un modèle d'application d'IA générative qui recherche des données et des documents utiles afin de répondre à une question ou d'accomplir une tâche, puis de les fournir à des LLM en tant que contexte pour améliorer la pertinence des réponses.

Le framework Mosaic AI Agent est une suite d'outils conçue pour aider les développeurs à créer et déployer des applications d'IA générative de haute qualité grâce à la RAG. Cette approche produit en effet des résultats soumis à une gouvernance étroite, et dont la précision et la sécurité sont systématiquement confirmées par des mesures et des évaluations. Le framework Mosaic AI Agent facilite l'évaluation de la qualité des applications de RAG. Il accélère les itérations en donnant aux développeurs la possibilité de tester leurs hypothèses et de redéployer leur application sans effort, tout en appliquant les principes de gouvernance et les mesures de protection nécessaires pour garantir une qualité constante.

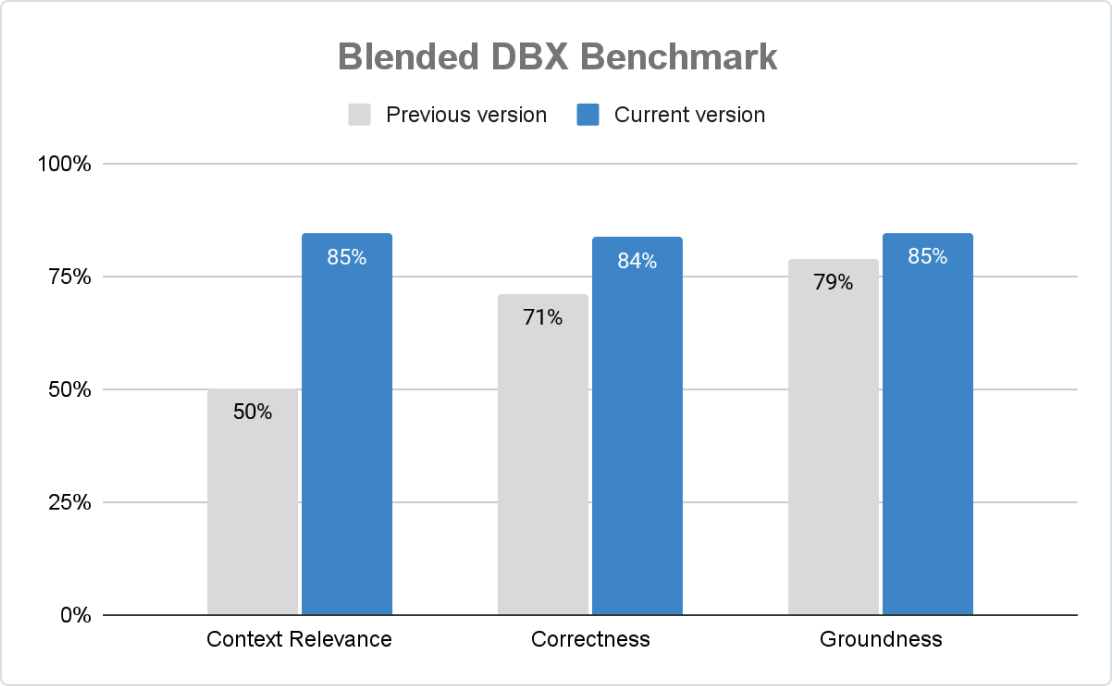

Une qualité optimale

Agent Framework assure la précision, la sécurité et la gouvernance des applications d'IA générative à grande échelle. Avec Mosaic AI Agent Evaluation, les organisations personnalisent la notation à l'aide de contrôles basés sur des règles, de juges LLM et de feedback humain. L'évaluation assistée par IA intégrée et son interface utilisateur intuitive facilitent les efforts d'amélioration continue.

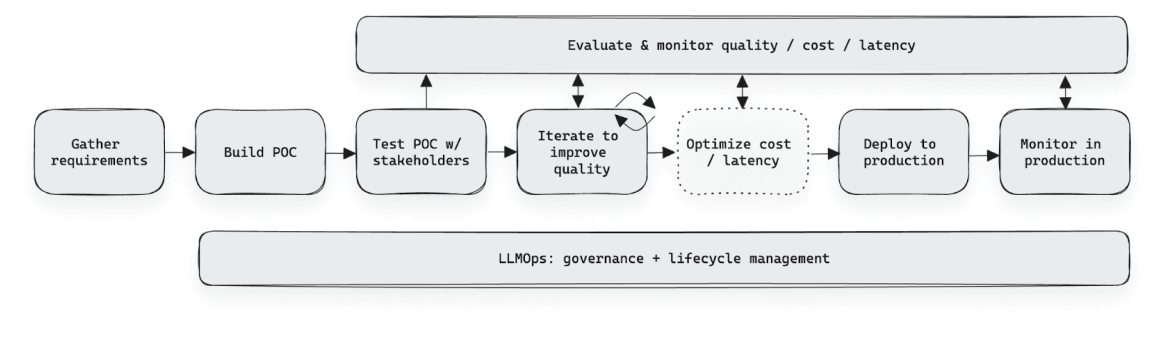

Itérations rapides en développement

Agent Framework accélère le développement de l'IA générative en rationalisant la collecte et l'évaluation du feedback. L'application Agent Evaluation Review permet aux experts d'évaluer, d'étiqueter, et de définir des critères, sans feuilles de calcul ni outils personnalisés. Quant au feedback structuré, il aide les équipes à affiner les performances, gagner en précision et redéployer sans modifier le code ni compromettre la gouvernance et la sécurité.

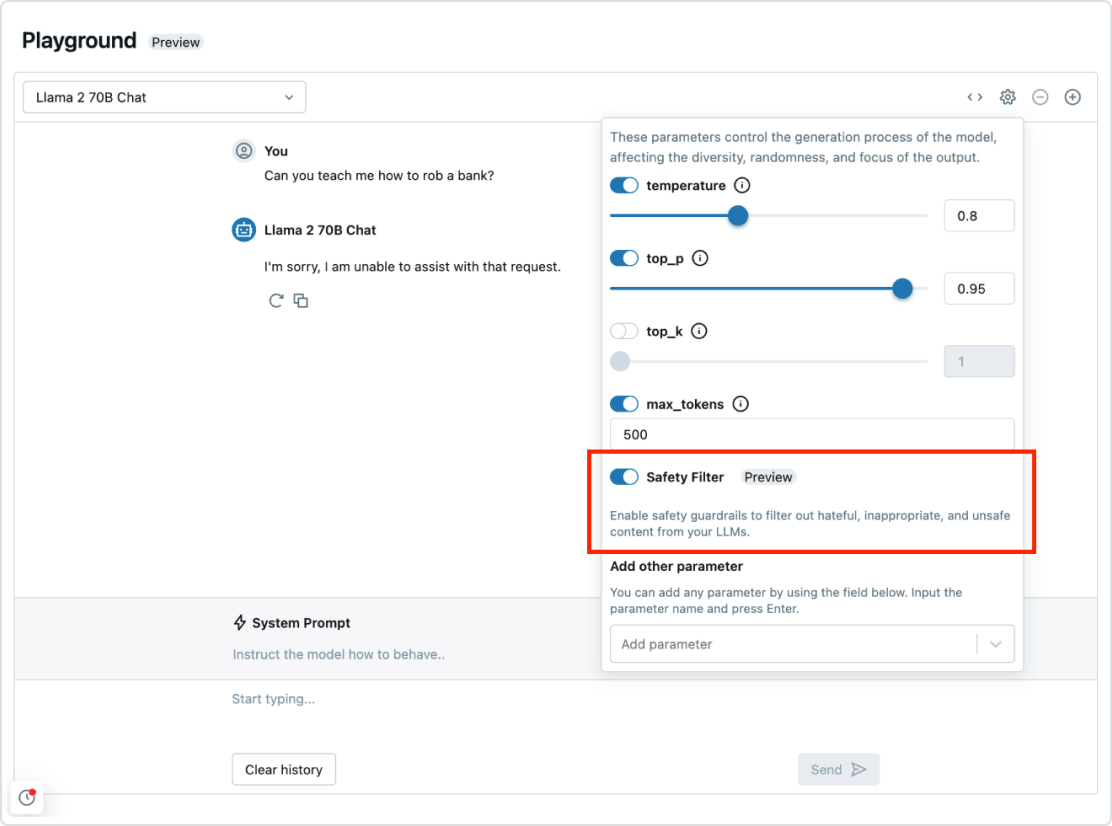

Gouvernance et mesures de protection

Le framework Mosaic AI Agent s'intègre parfaitement au reste de la Databricks Data Intelligence Platform. Autrement dit, vous avez tout ce qu'il vous faut pour déployer un système RAG de bout en bout : sécurité et gouvernance, intégration des données, bases de données vectorielles, évaluation de la qualité et déploiement optimisé en un clic. Les dispositifs de gouvernance et de protection en place vous prémunissent contre les réponses toxiques tout en assurant la conformité de votre application aux politiques de votre organisation.

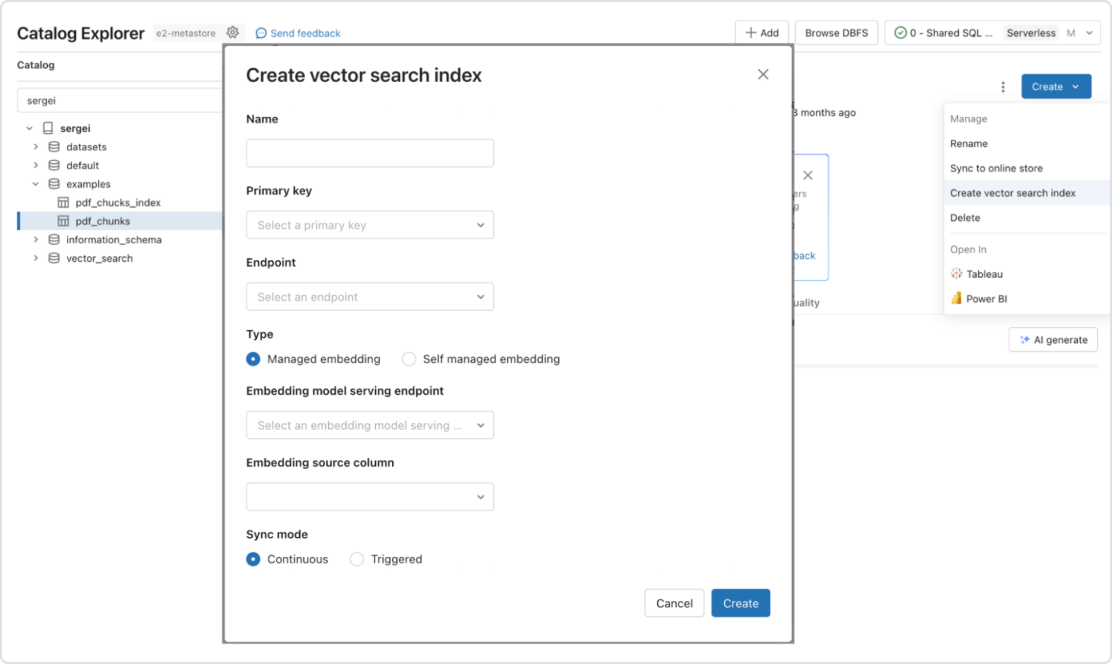

Pipelines temps réel automatisés pour tous les types de données

Mosaic AI prend nativement en charge le service et l'indexation de vos données en vue de leur récupération en ligne. Dans le cas de données non structurées (texte, images et vidéo), Vector Search indexe et sert automatiquement les données, les rendant disponibles pour des applications RAG sans qu'il faille créer de pipelines de données distincts. En coulisses, Vector Search gère les échecs et les nouvelles tentatives, ajustant automatiquement la taille des batches afin de trouver le meilleur compromis entre performance, débit et coût. Pour les données structurées, le service de fonctionnalités et de fonctions permet d'obtenir en quelques millisecondes les données contextuelles (données sur les utilisateurs et les comptes, notamment) que les entreprises veulent souvent injecter dans des prompts pour les personnaliser.