LakeFlow

Acquisisci, trasforma e orchestra i dati con una soluzione unificata per il data engineering

LE PRINCIPALI AZIENDE CHE UTILIZZANO LAKEFLOWLa soluzione end-to-end per fornire dati di alta qualità.

Strumenti che facilitano la creazione di pipeline di dati affidabili per l'analisi e l'AI.85% di velocità di sviluppo in più

50% di riduzione dei costi

99% di riduzione nella latenza delle pipeline

2,500 esecuzioni di job al giorno

Corning utilizza Lakeflow per semplificare l'orchestrazione dei dati, creando un processo automatizzato e ripetibile per più team all'interno dell'organizzazione. Questi flussi di lavoro automatizzati spostano enormi quantità di dati attraverso un'architettura a medaglione, dalle tabelle Bronze a quelle Gold.

Strumenti unificati per i data engineer

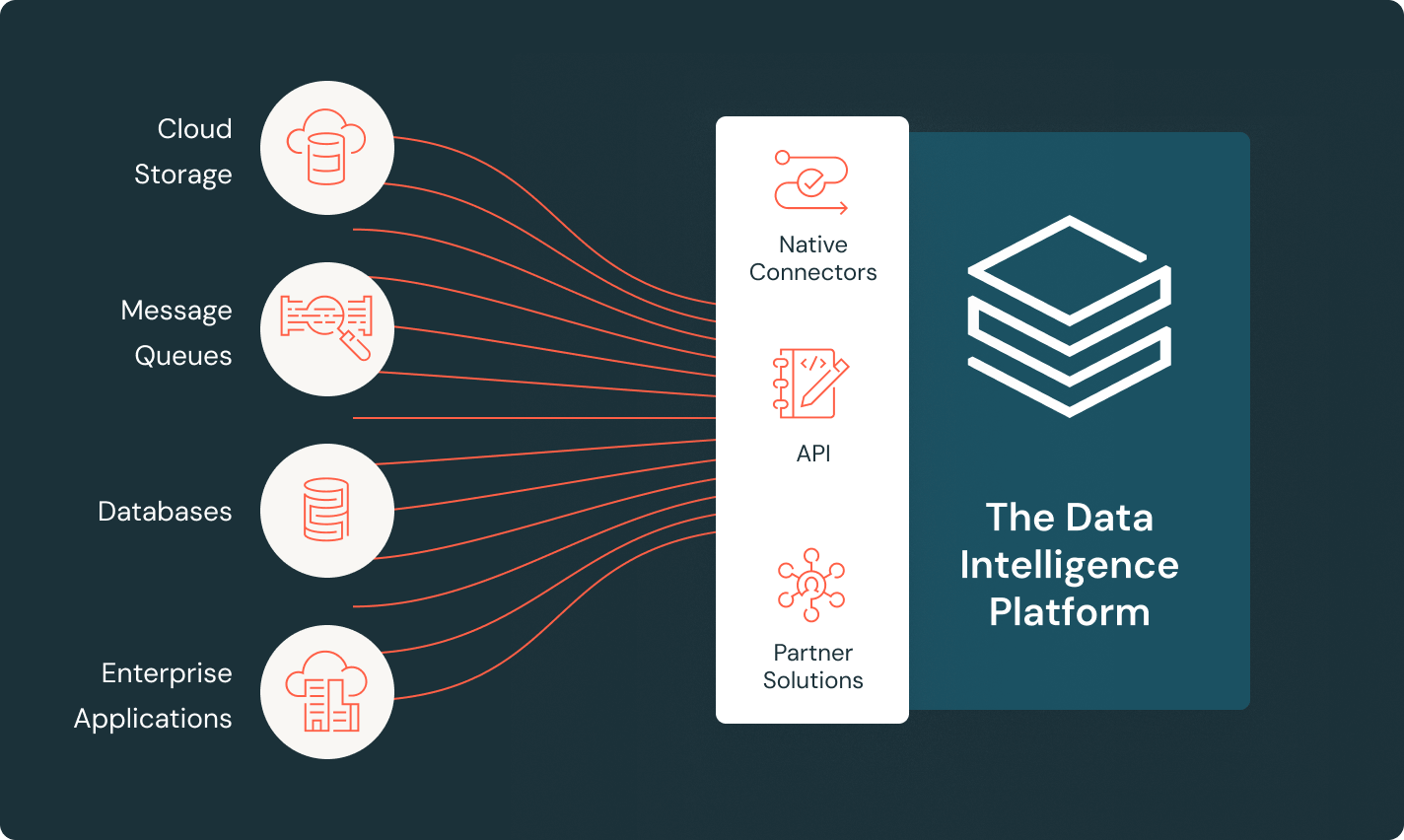

LakeFlow Connect

Connettori efficienti per l'acquisizione di dati e integrazione nativa con la Data Intelligence Platform facilitano l'accesso all'analisi e all'AI, con una governance unificata.

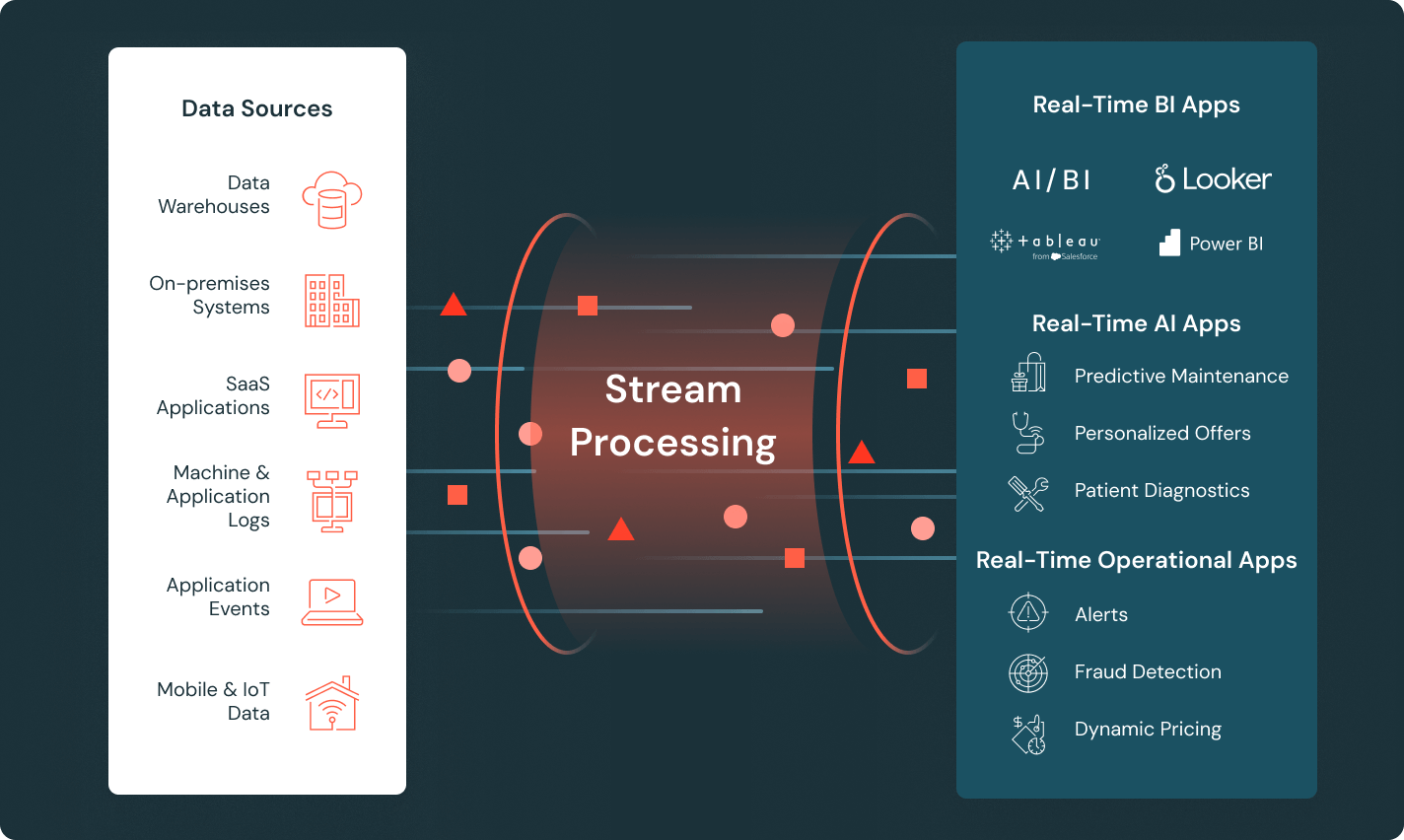

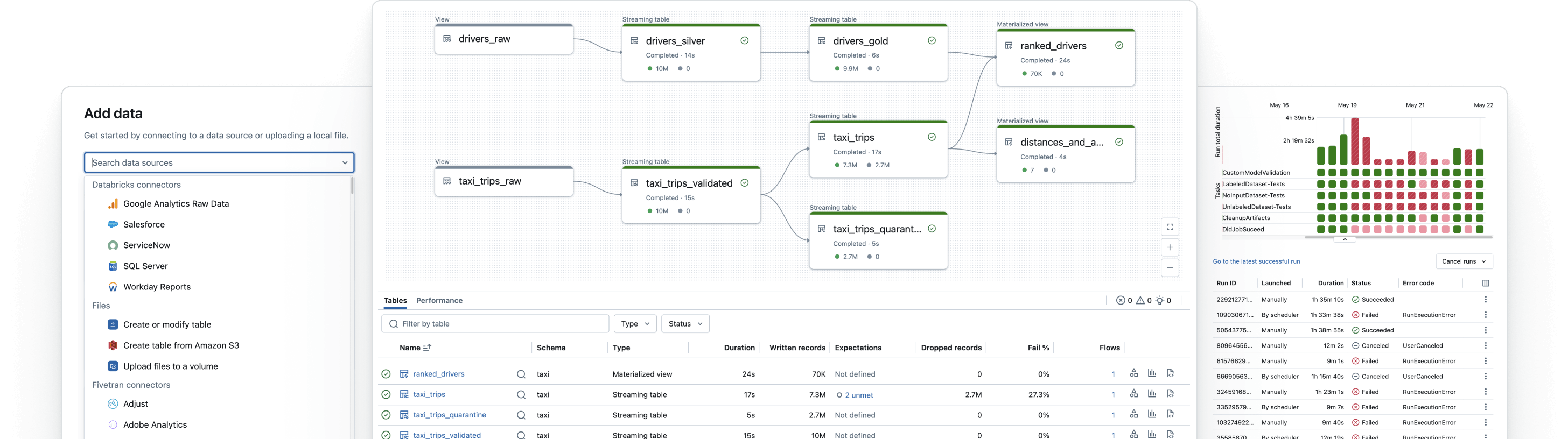

Spark Declarative Pipelines

Semplifica l’ETL batch e in streaming grazie a funzionalità automatizzate per la qualità dei dati, il Change Data Capture (CDC), l’ingestione, la trasformazione e la governance centralizzata.

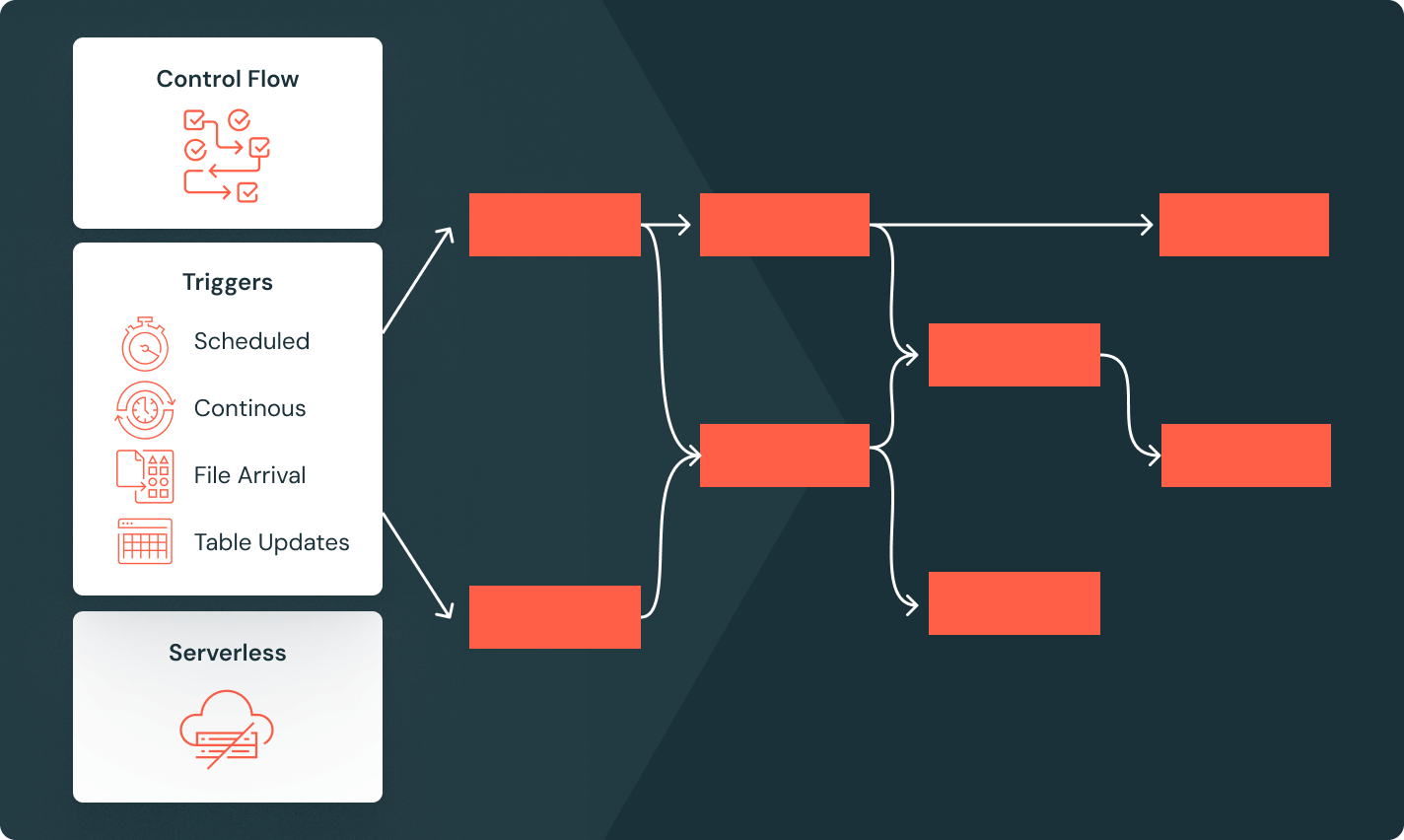

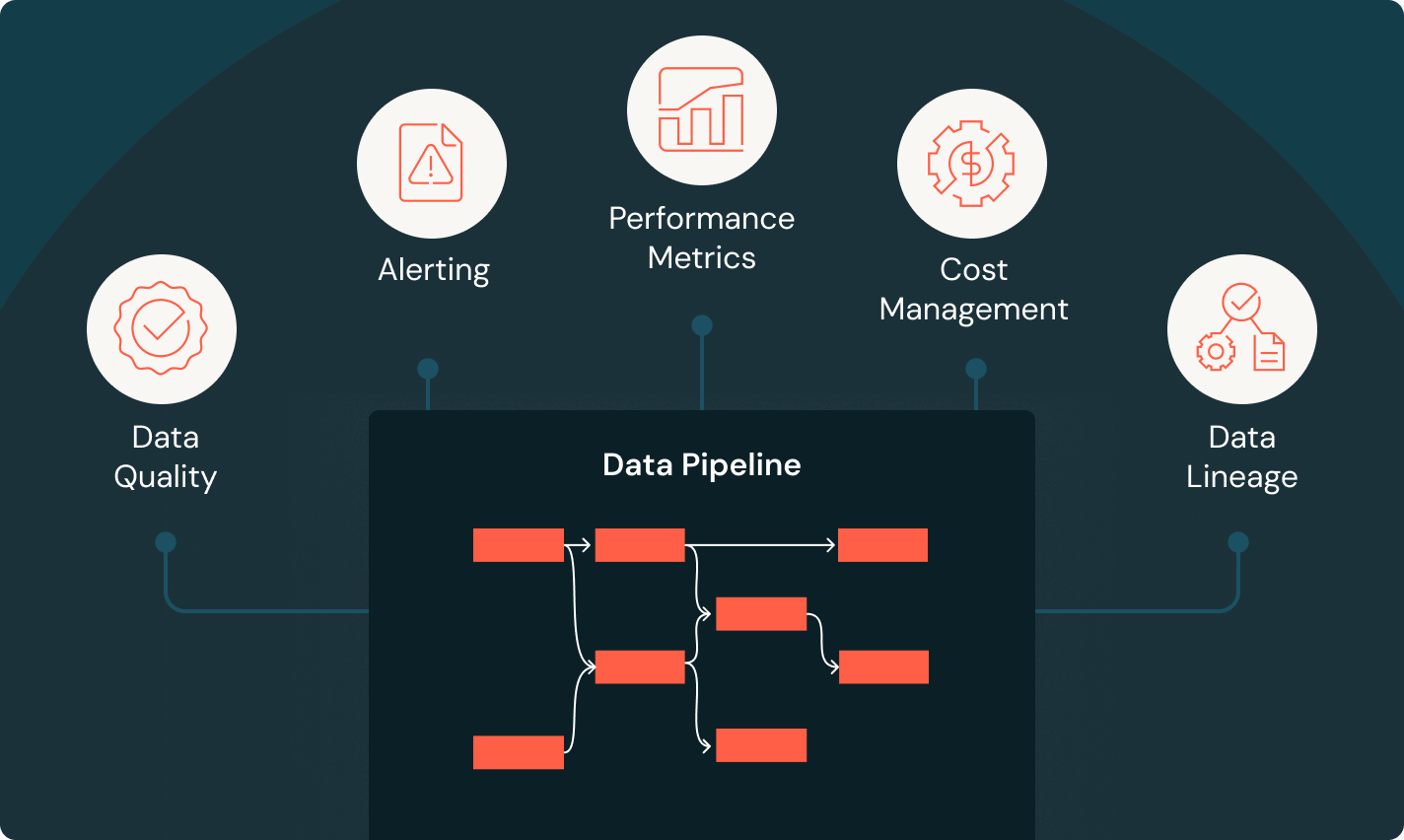

Job di Lakeflow

Fornisci ai team gli strumenti per automatizzare e orchestrare al meglio qualsiasi flusso di lavoro ETL, di analisi o AI, con osservabilità avanzata, alta affidabilità e supporto per una vasta gamma di attività.

Unity Catalog

Gestisci tutti i tuoi asset di dati con l'unica soluzione di governance unificata e aperta del settore per dati e AI, integrata nella Databricks Data Intelligence Platform.

Archiviazione nel lakehouse

Unifica i dati nel tuo lakehouse, di qualunque formato e tipo, per tutti i tuoi carichi di lavoro di analisi e AI.

Data Intelligence Platform

Esplora l'intera gamma di strumenti disponibili sulla Databricks Data Intelligence Platform per integrare perfettamente dati e AI in tutta l'organizzazione.

Crea pipeline di dati affidabili

Trasforma i dati grezzi in tabelle Gold di alta qualità

Implementa pipeline ETL per filtrare, arricchire, ripulire e aggregare i dati in modo che siano pronti per analisi, AI e BI. Segui l'architettura a medaglione per elaborare i dati dai livelli Bronze Silver fino a Gold.

Fai il passo successivo

Contenuti associati

FAQ sul data engineering

Sei pronto a mettere dati e AI alla base della tua azienda?

Inizia il tuo percorso di trasformazione dei dati