Zuverlässige Datenpipelines leicht gemacht

Vereinfachen Sie Batch- und Streaming-ETL mit automatisierter Zuverlässigkeit und integrierter D

SPITZENTEAMS SETZEN AUF INTELLIGENTE DATENPIPELINESFestgeschriebene Best Practices für Datenpipelines

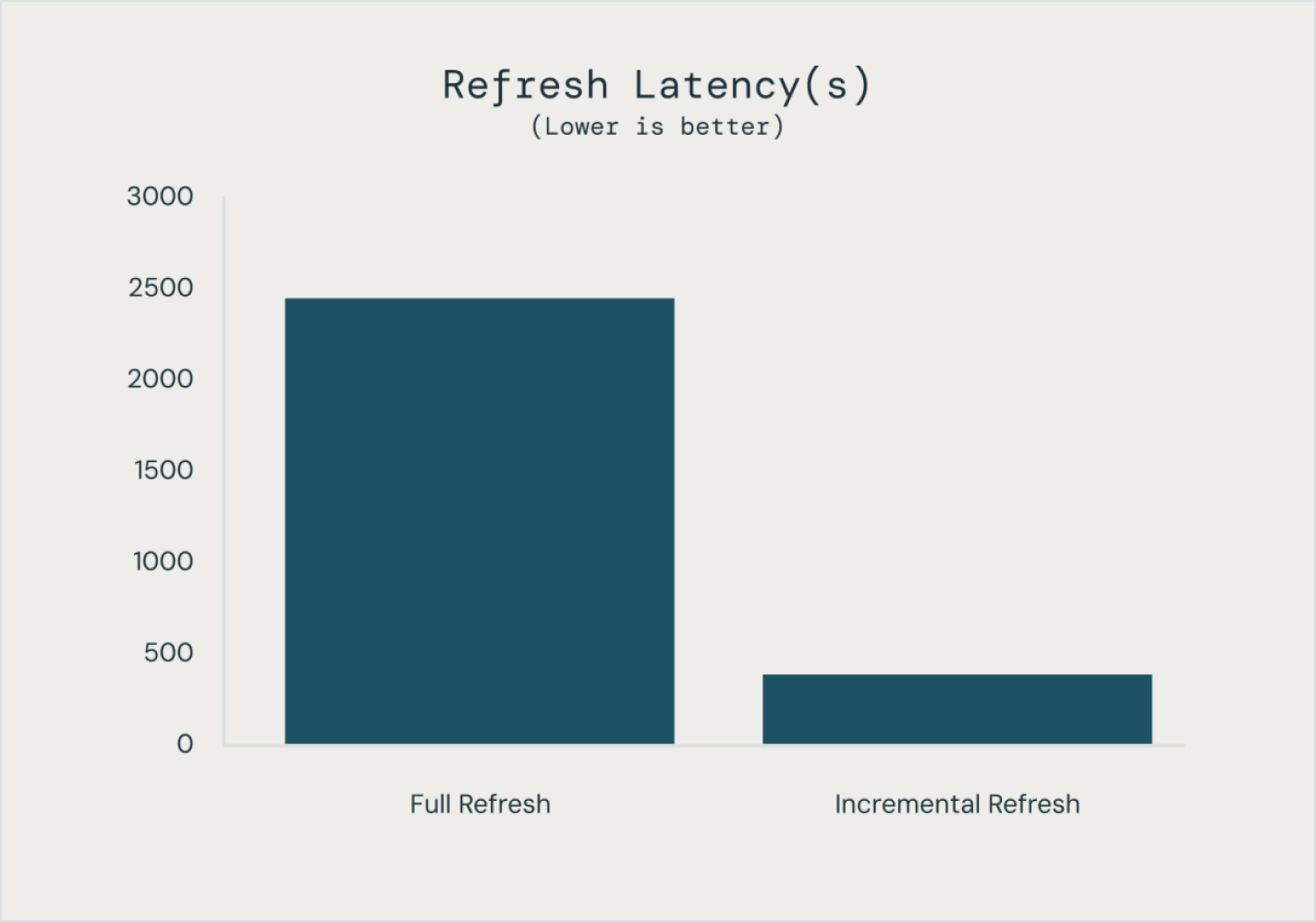

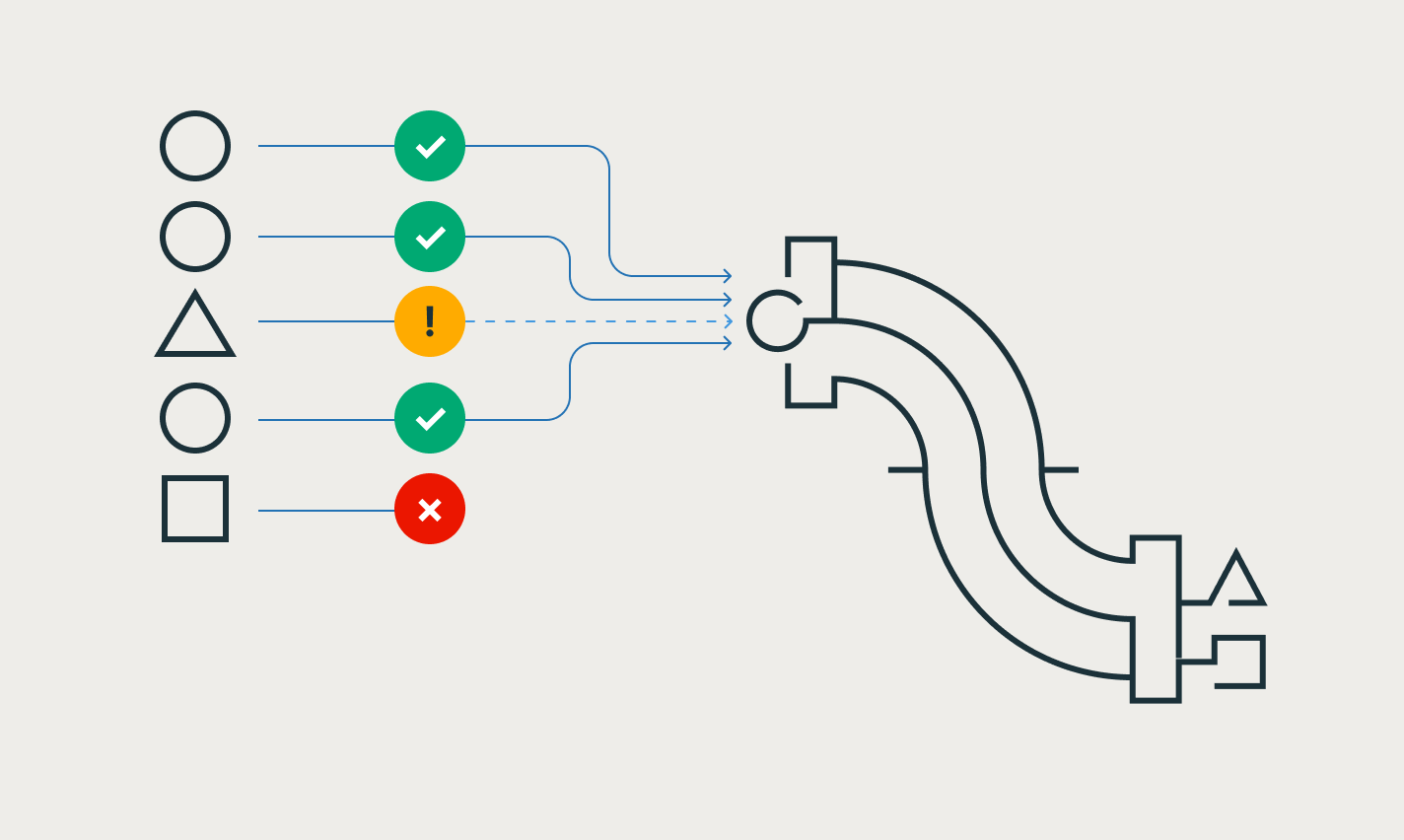

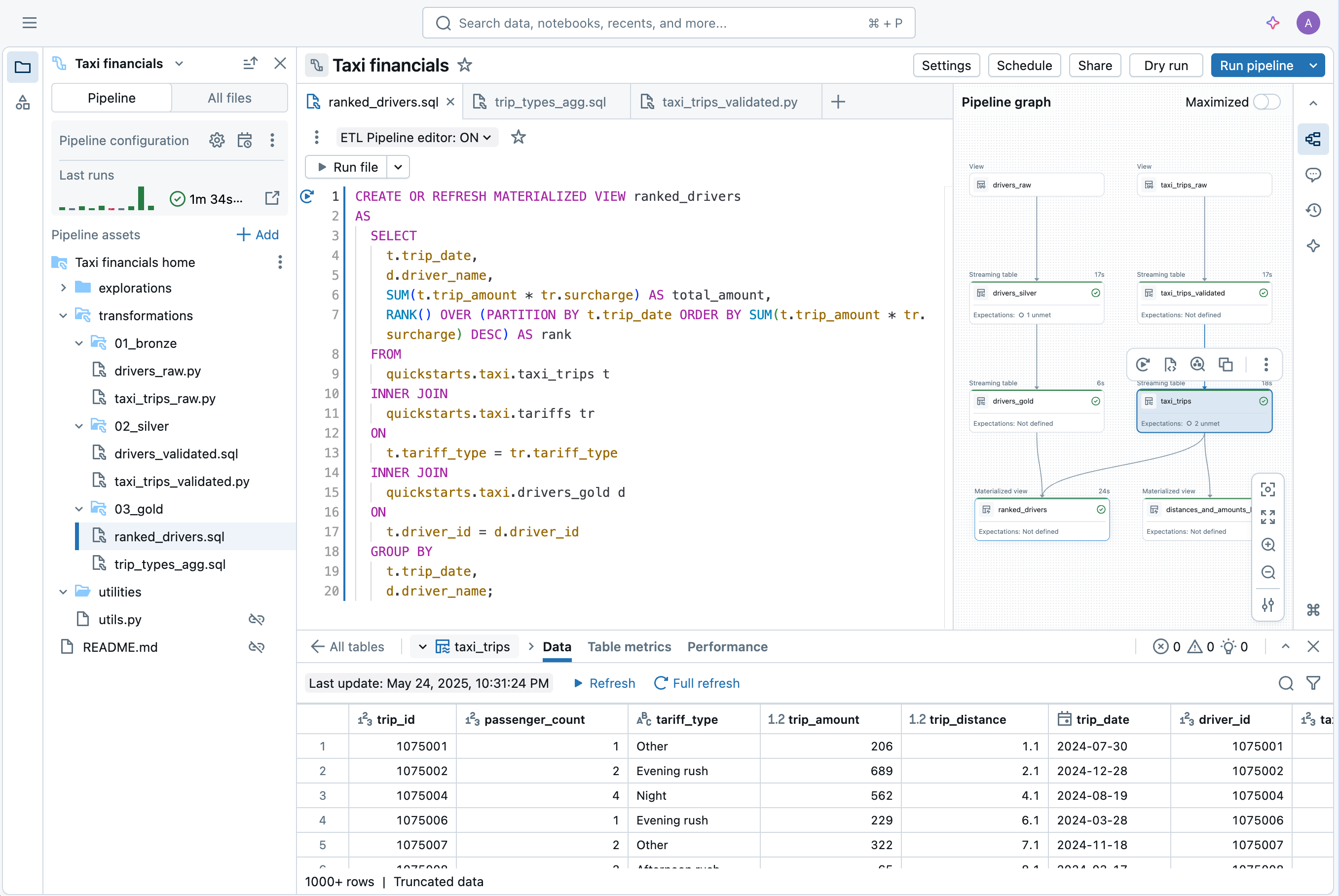

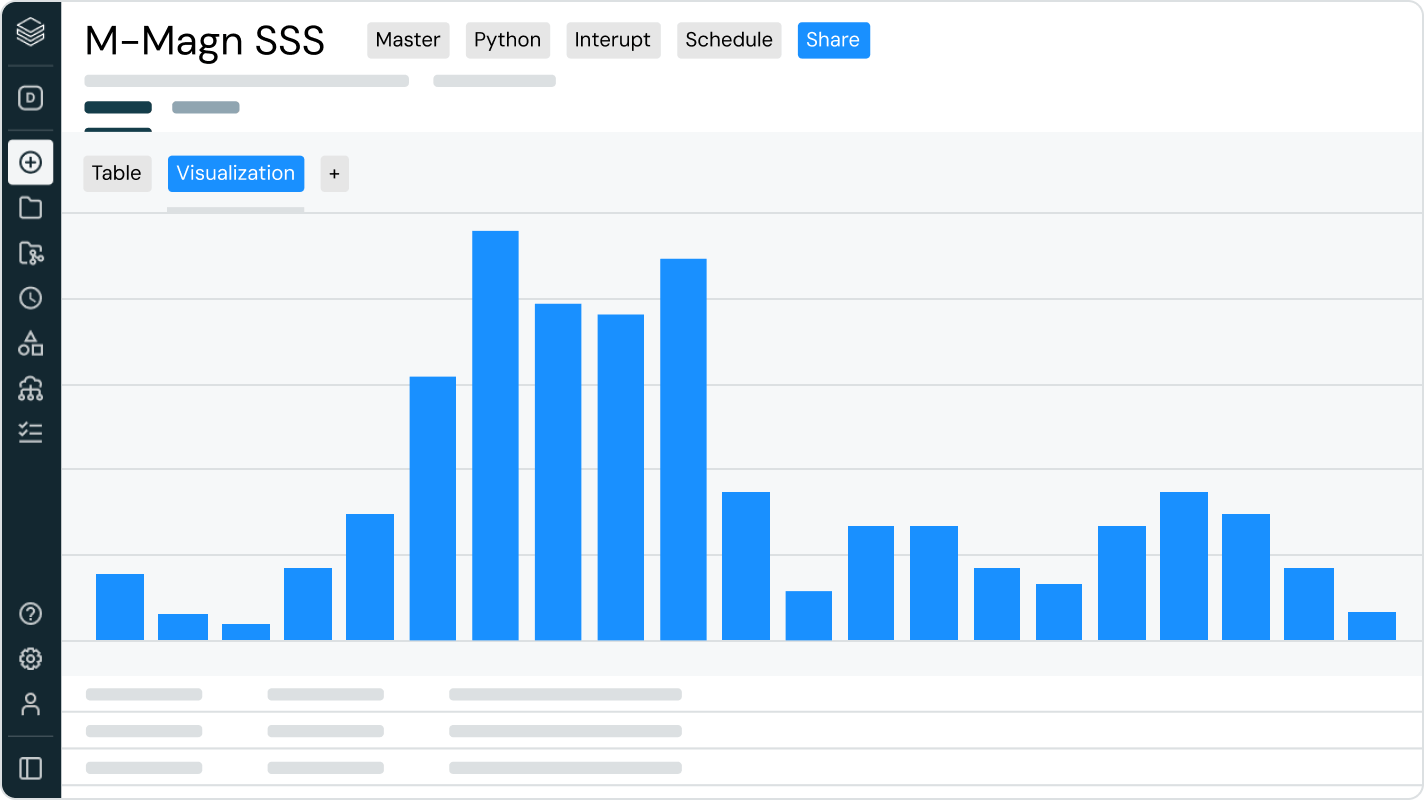

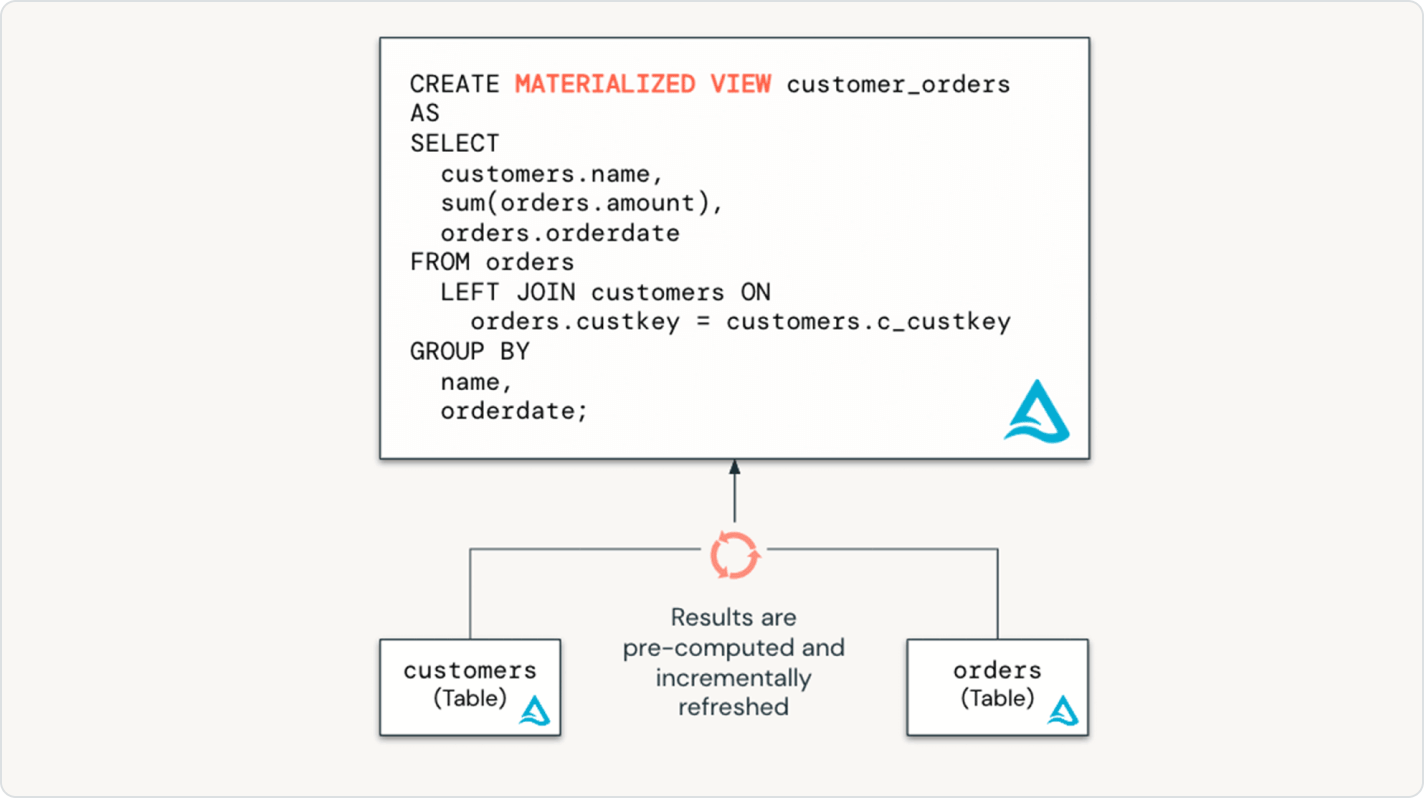

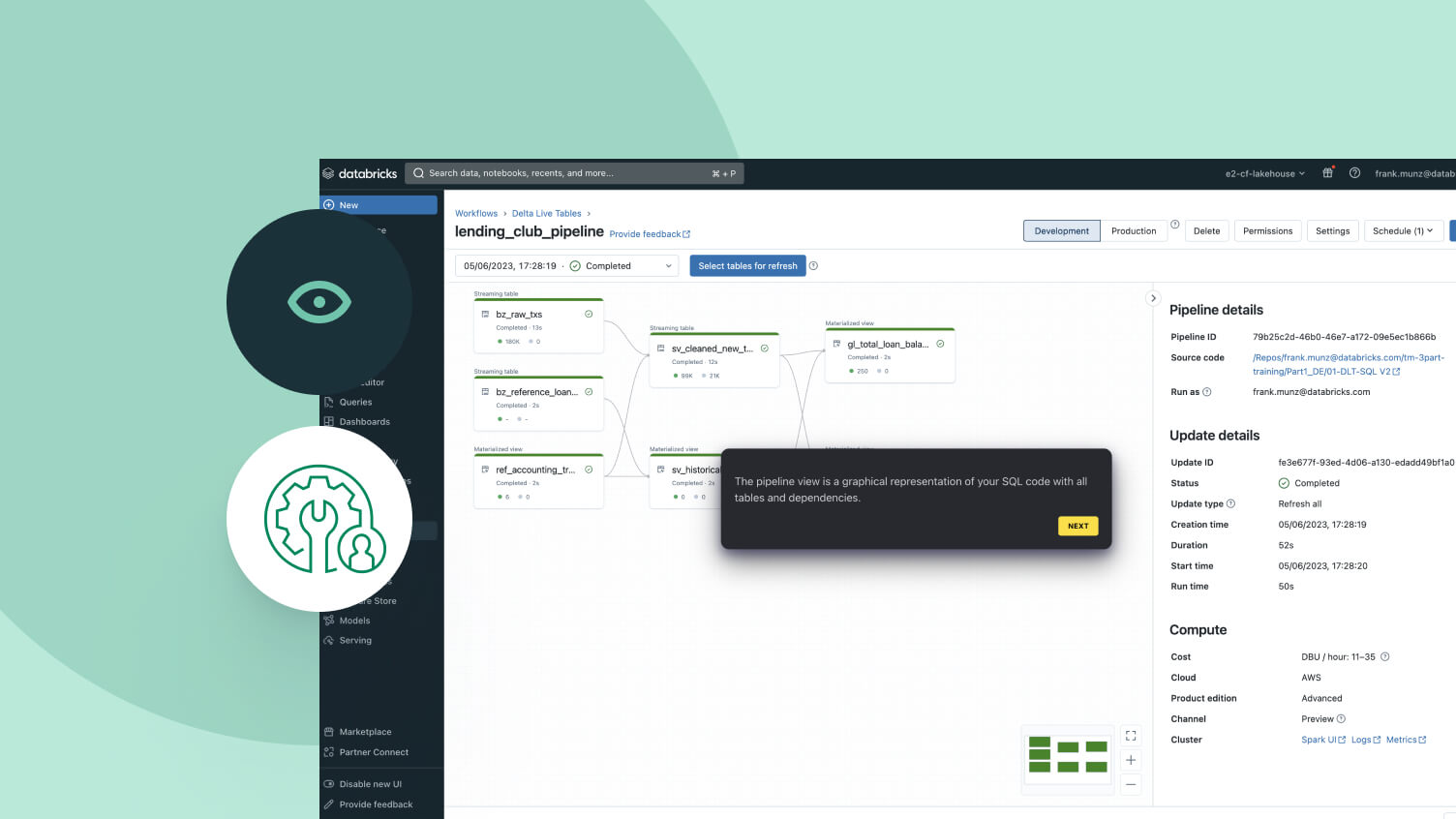

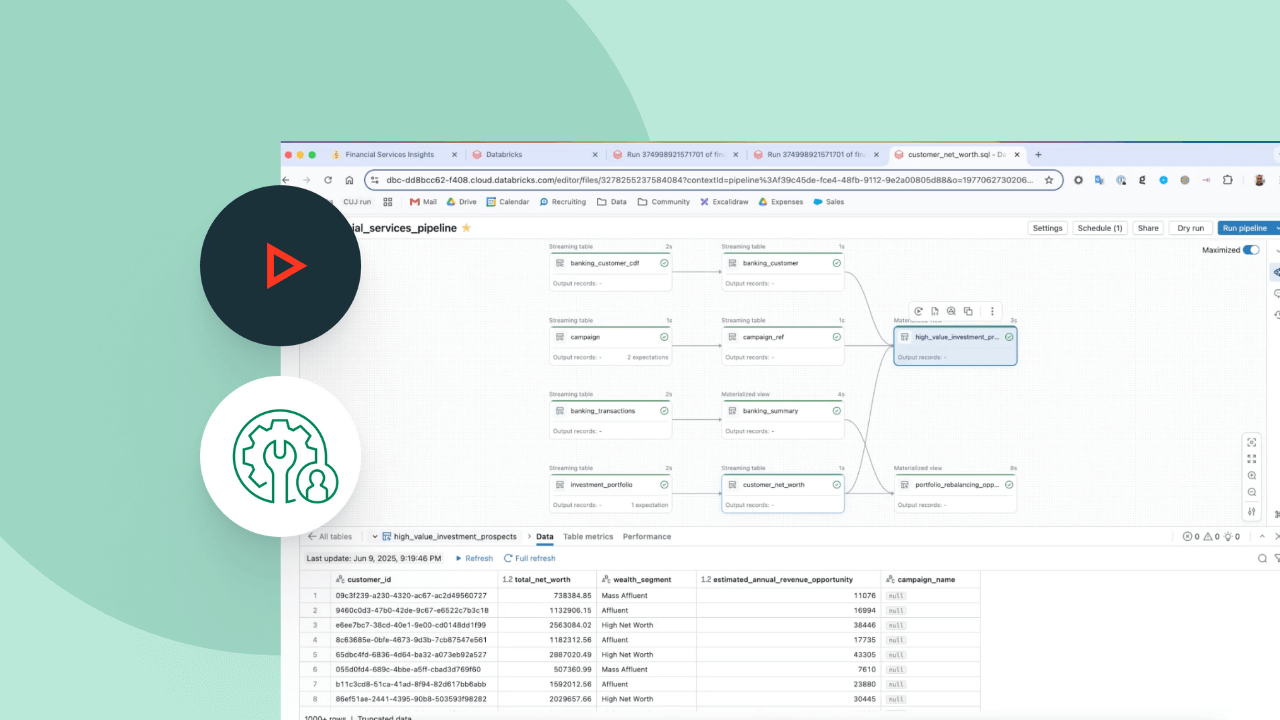

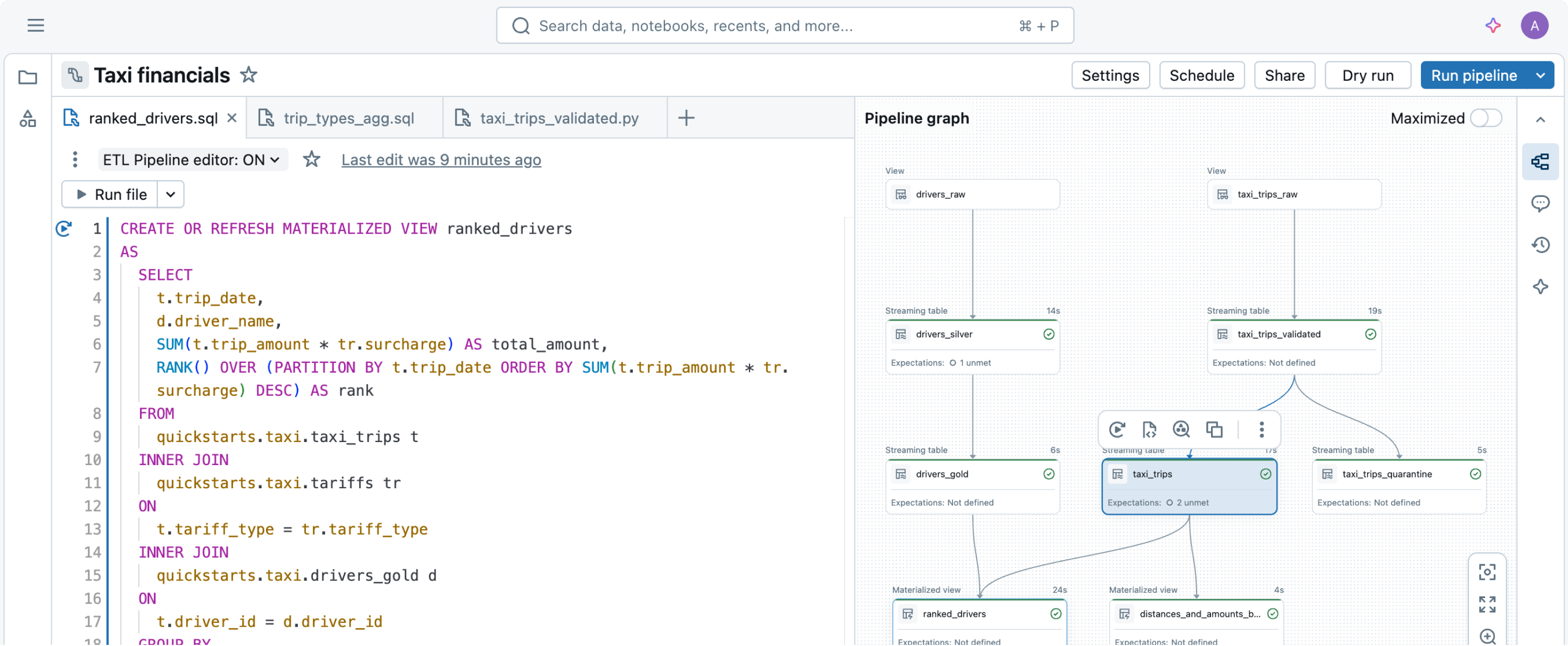

Definieren Sie einfach die gewünschten Datentransformationen – Spark Declarative Pipelines kümmert sich um den Rest.Für die einfachere Erstellung von Datenpipelines entwickelt

Das Erstellen und Betreiben von Datenpipelines kann komplex sein, muss es aber nicht. Spark Declarative Pipelines kombiniert Performance mit Einfachheit. So können Sie robustes ETL mit nur wenigen Codezeilen umsetzen.Durch die Nutzung der vereinheitlichten API von Spark für die Batch- und Stream-Verarbeitung ermöglichen Spark Declarative Pipelines das einfache Umschalten zwischen den Verarbeitungsmodi.

Weitere Funktionen

Datenpipelines rationalisieren

Quellen, Transformationen und Ziele vereinfachen

Deklarative Programmierung bedeutet, dass Sie die Leistungsfähigkeit von ETL mit nur wenigen Codezeilen auf der Data Intelligence Plattform umsetzen können.

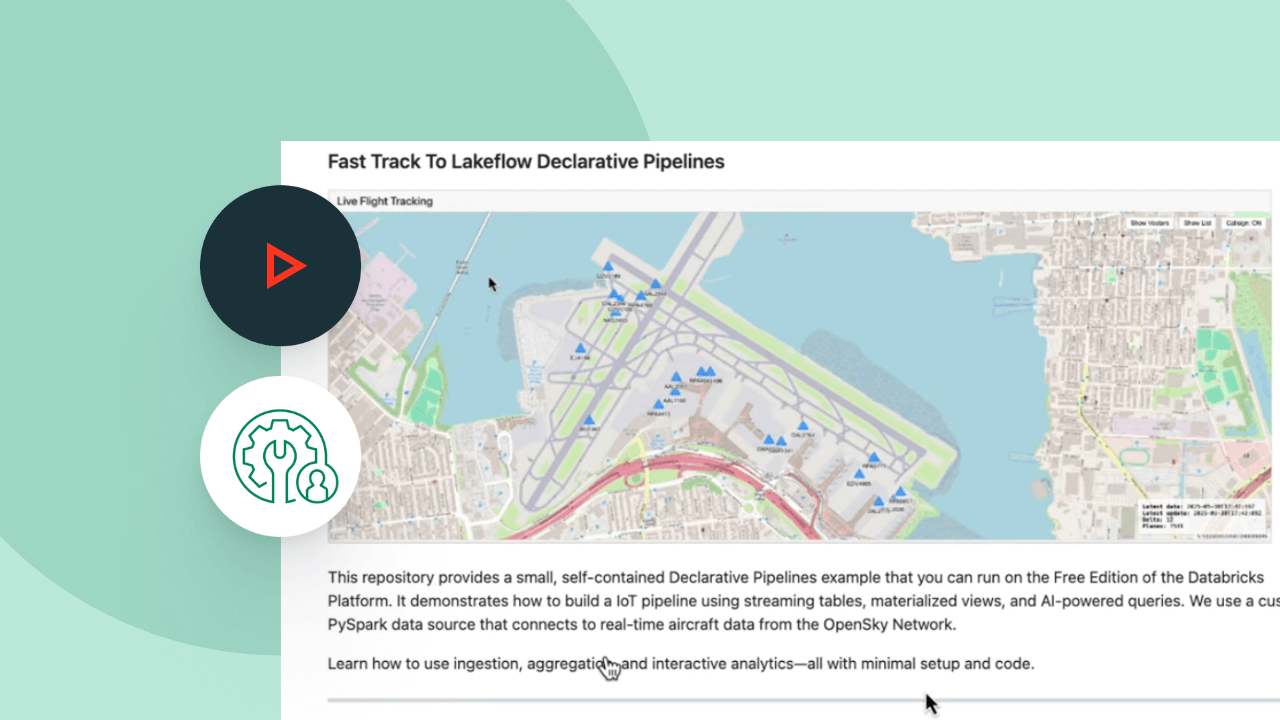

Erkunden Sie die Demos zu Spark Declarative Pipelines

Ausgaben im Griff dank nutzungsbasierter Abrechnung

Sie zahlen nur für die Produkte, die Sie tatsächlich nutzen – und das sekundengenau.Mehr entdecken

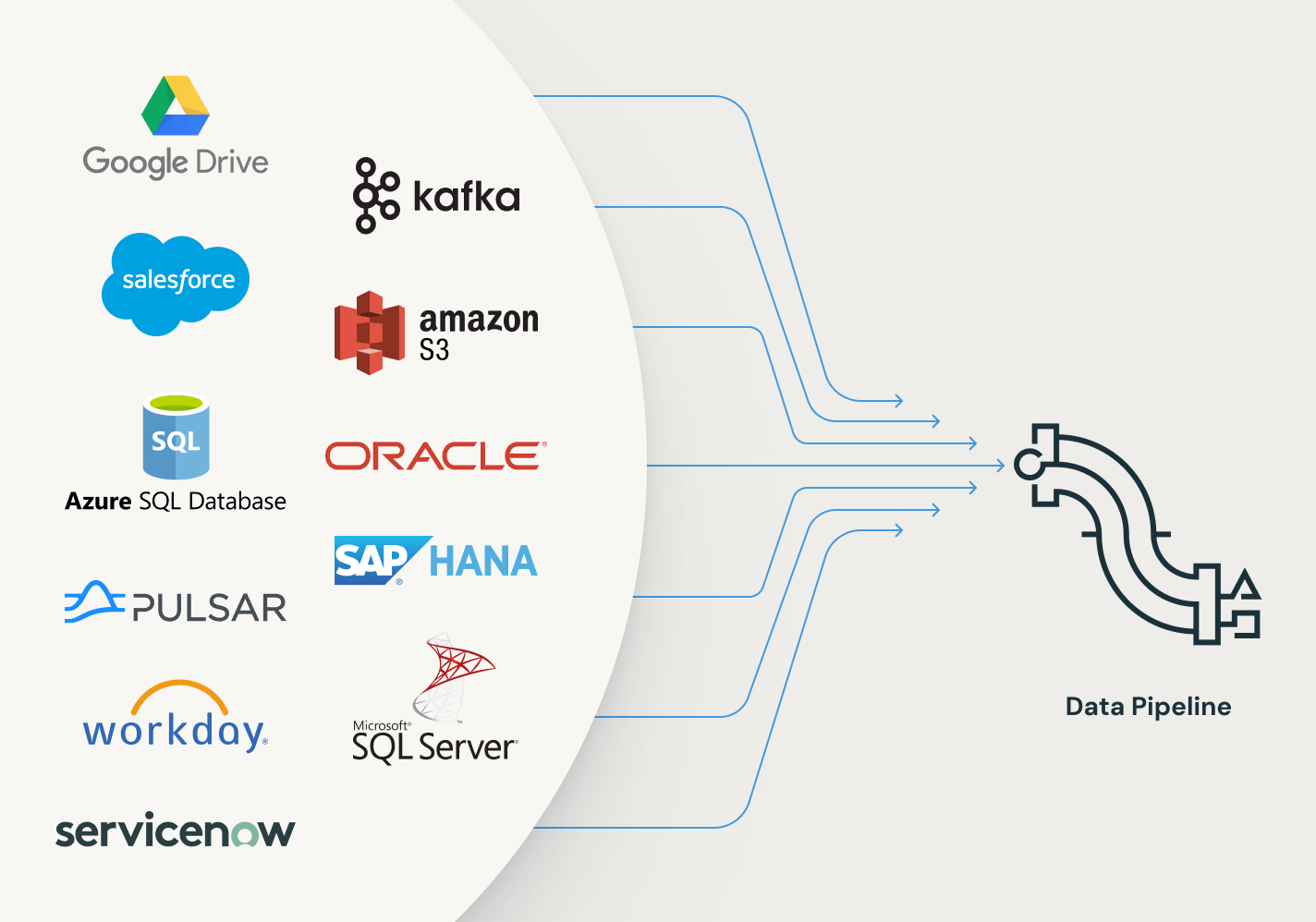

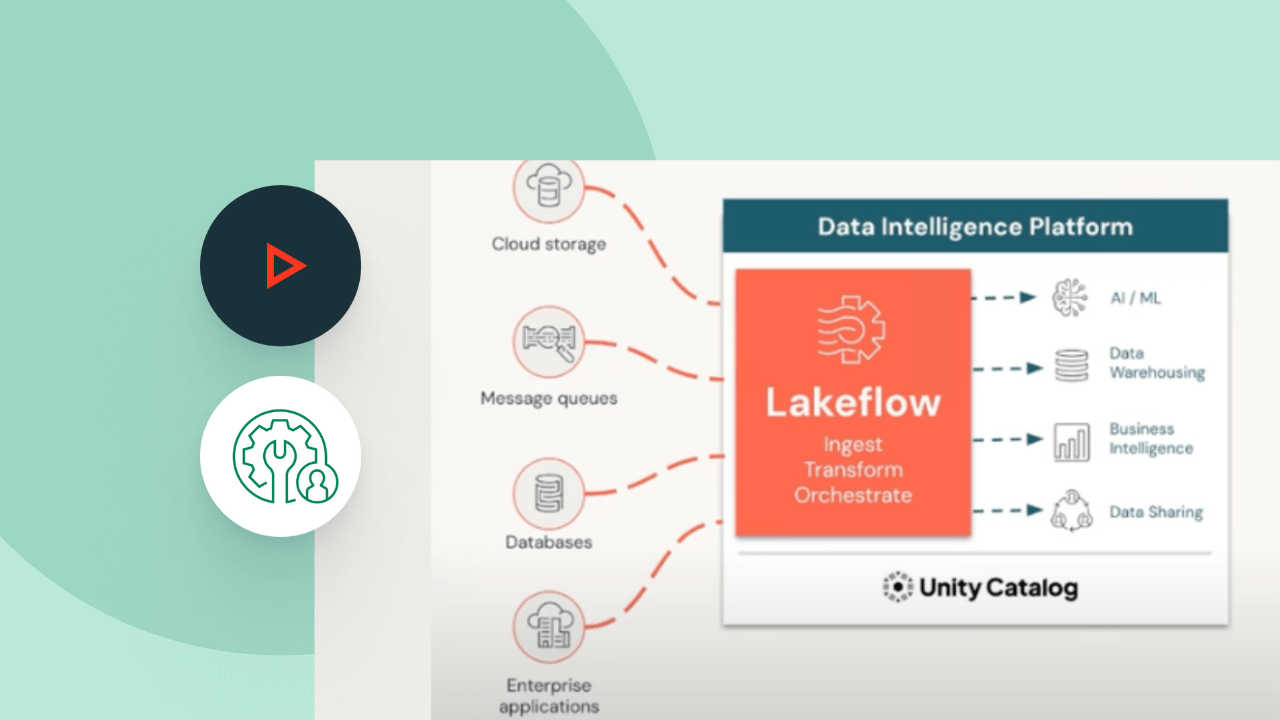

Entdecken Sie weitere integrierte, intelligente Angebote auf der Data Intelligence Platform.LakeFlow Connect

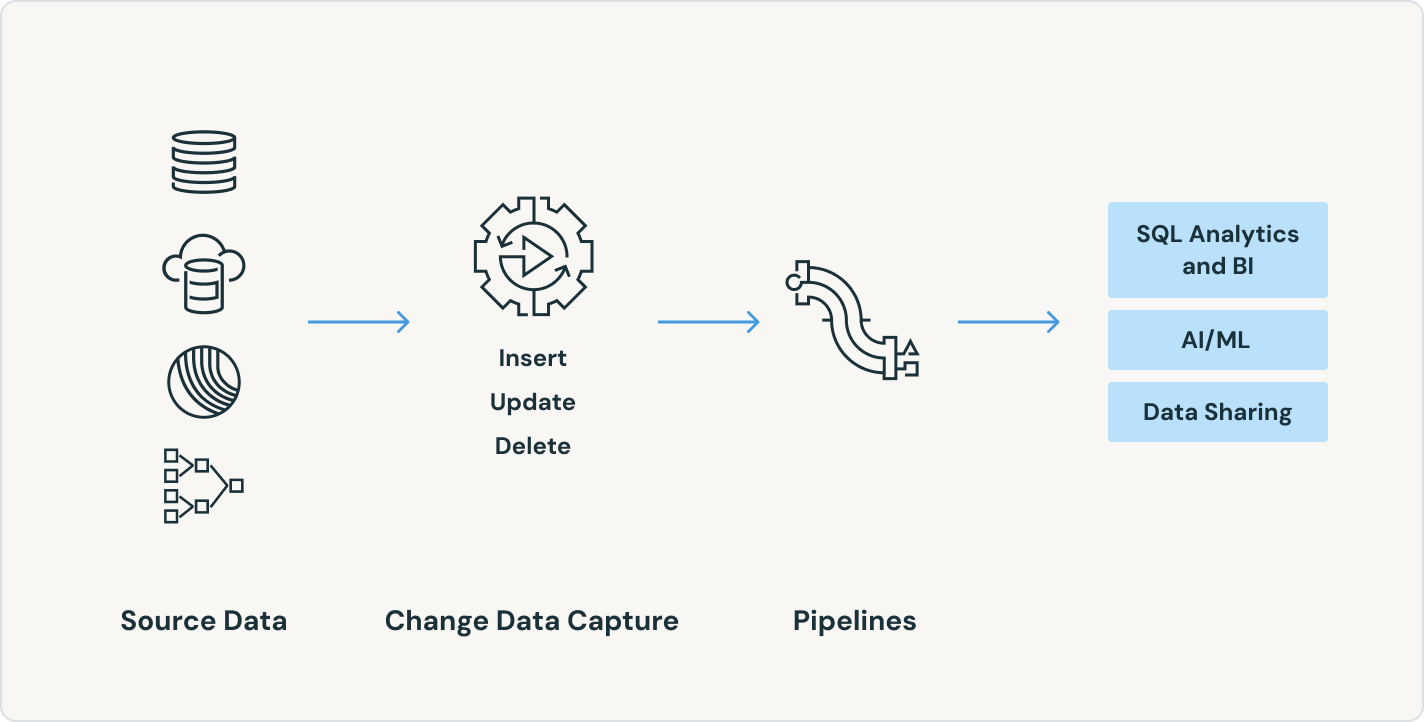

Effiziente Konnektoren für die Datenaufnahme aus beliebigen Quellen und native Integration mit der Data Intelligence Platform erschließen einen einfachen Zugang zu Analytik und KI mit einheitlicher Governance.

Lakeflow Jobs

Sie können Workflows mit mehreren Tasks für ETL-, Analytics- und ML-Pipelines unkompliziert definieren, verwalten und überwachen. Mit einer breiten Palette unterstützter Task-Typen, umfassenden Beobachtbarkeitsfunktionen und hoher Zuverlässigkeit sind Ihre Datenteams in der Lage, jede Pipeline besser zu automatisieren und zu orchestrieren sowie produktiver zu werden.

Lakehouse-Speicherung

Vereinheitlichen Sie die Daten in Ihrem Lakehouse format- und typenübergreifend für alle Ihre Analytics- und KI-Workloads.

Unity Catalog

Regulieren Sie alle Ihre Datenressourcen nahtlos mit der branchenweit einzigen einheitlichen und offenen Governance-Lösung für Daten und KI, die in die Data Intelligence Platform von Databricks integriert ist.

Die Data Intelligence Platform

Erfahren Sie mehr darüber, wie die Databricks Data Intelligence Platform Ihre Daten- und KI-Workloads unterstützt.

Wagen Sie den nächsten Schritt

Ähnliche Inhalte

Spark Declarative Pipelines – FAQ

Möchten Sie ein Daten- und KI-Unternehmen werden?

Machen Sie die ersten Schritte Ihrer Transformation