Mosaic AI Agent Framework

Crea app di generazione potenziata dal recupero (RAG) di qualità da produzione

La Retrieval augmented generation (Generazione potenziata dal recupero, RAG) è un modello applicativo di AI generativa che trova dati e/o documenti rilevanti per una domanda o un task e li fornisce come contesto al modello linguistico di grandi dimensioni (LLM), così che questo possa restituire risposte più accurate.

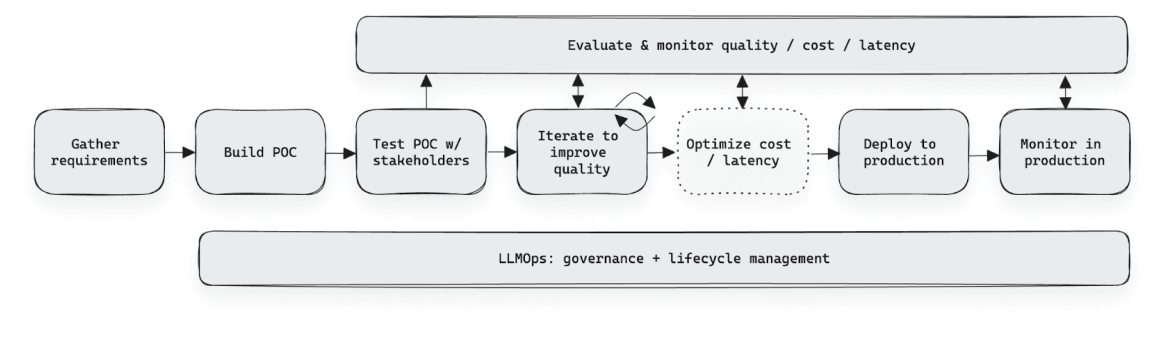

Mosaic AI Agent Framework è una suite di strumenti progettata per aiutare gli sviluppatori a creare e distribuire applicazioni di AI generativa di alta qualità utilizzando la RAG per ottenere un output sistematicamente misurato e valutato in modo da essere accurato, sicuro e gestito. Mosaic AI Agent Framework consente agli sviluppatori di valutare facilmente la qualità delle applicazioni RAG, di iterare rapidamente grazie alla possibilità di testare le ipotesi, di ridistribuire facilmente le applicazioni e di disporre della governance e delle misure di sicurezza appropriate per garantire una qualità costante.

Massima qualità di produzione

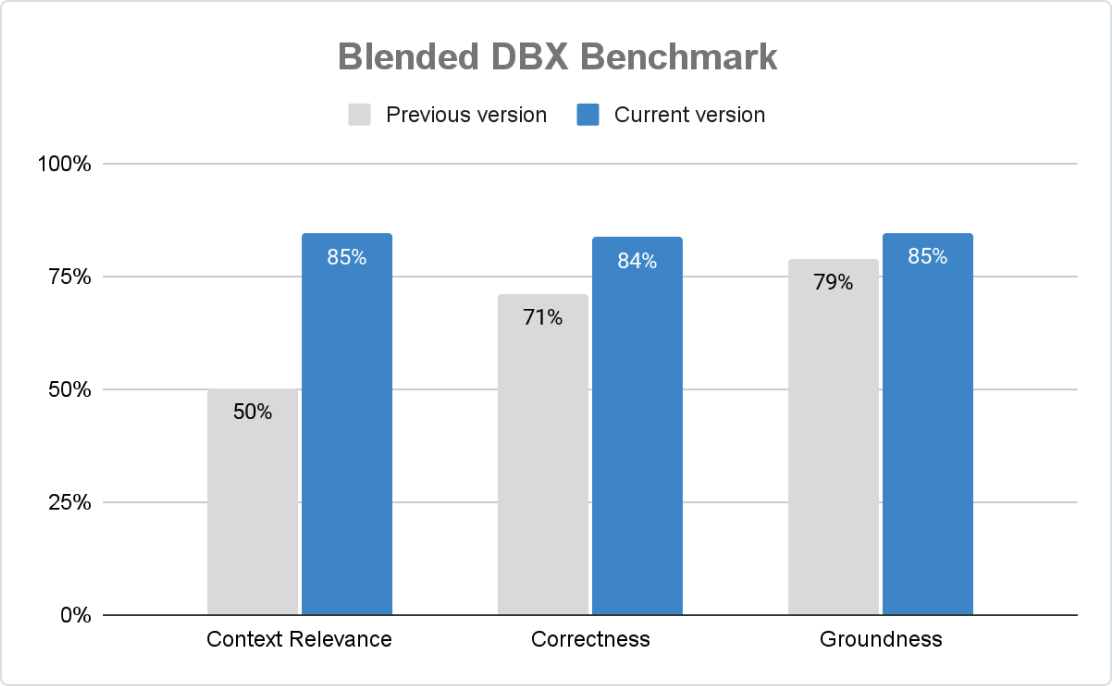

Agent garantisce applicazioni di GenAI accurate, sicure e governate su larga scala. Con Mosaic AI Agent Evaluation, le organizzazioni possono personalizzare i criteri di valutazione tramite controlli basati su regole, giudici LLM e feedback umano, mentre la valutazione assistita dall'AI integrata e un'interfaccia utente intuitiva stimolano un miglioramento continuo.

Iterazione rapida dello sviluppo

Agent Framework accelera lo sviluppo di GenAI semplificando la raccolta e la valutazione dei feedback. L'Agent Evaluation Review App consente agli esperti di dominio di valutare, etichettare e definire i criteri—senza bisogno di fogli di calcolo o strumenti personalizzati. Il feedback strutturato aiuta i team a perfezionare le prestazioni, aumentare la precisione e ridistribuire i modelli in modo fluido, senza modifiche al codice, garantendo al contempo governance e sicurezza.

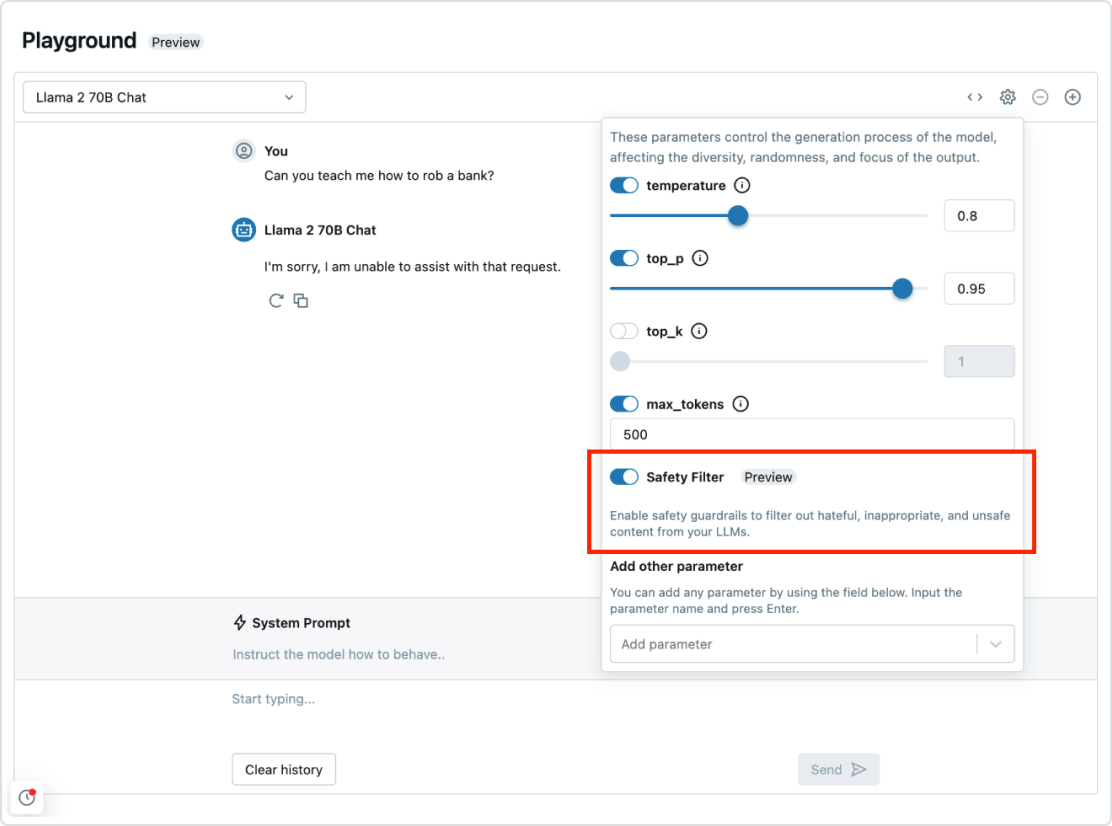

Governance e barriere

Mosaic AI Agent Framework è perfettamente integrato con gli altri componenti della Databricks Data Intelligence Platform. Ciò significa che hai tutto ciò che ti serve per implementare un sistema RAG end-to-end: sicurezza e governance, integrazione dei dati, database vettoriali, valutazione della qualità e implementazione ottimizzata con un clic. L'integrazione di funzionalità di governance e sicurezza ti consente inoltre di prevenire risposte fuorvianti e di assicurarti che l'applicazione sia conforme alle policy della tua organizzazione.

Pipeline automatizzata in tempo reale per qualsiasi tipo di dati

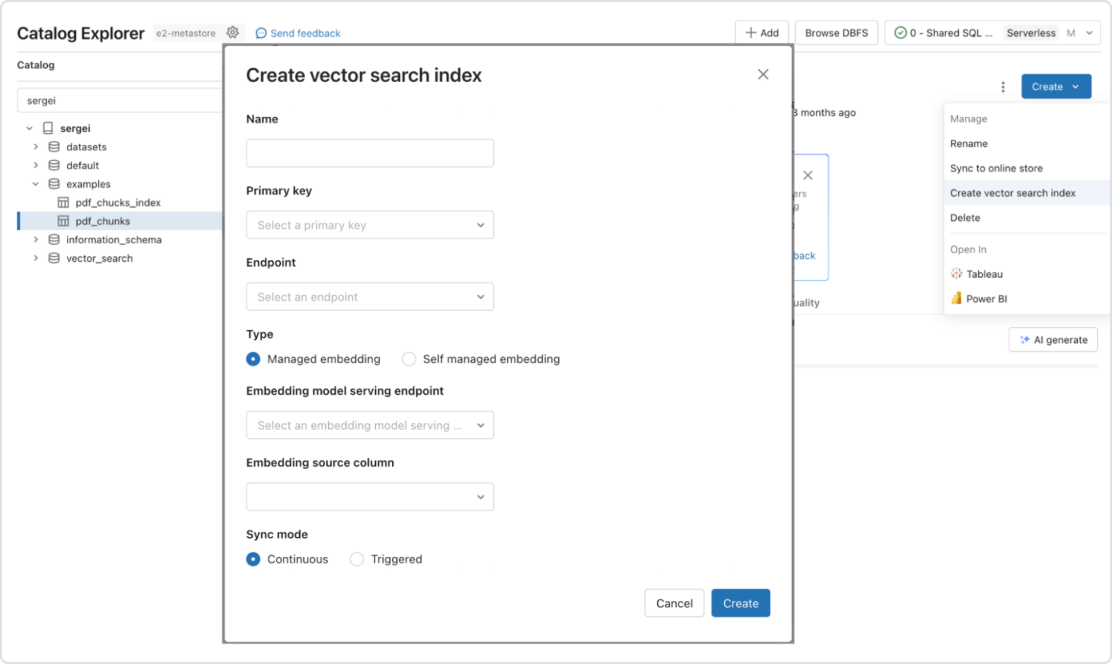

Mosaic AI supporta nativamente il serving e l'indicizzazione dei dati per il recupero online. Nel caso di dati non strutturati (testo, immagini e video), Vector Search indicizza e serve automaticamente i dati, rendendoli accessibili alle applicazioni RAG senza dover creare pipeline di dati separate. Dietro le quinte, Vector Search gestisce errori e nuovi tentativi e ottimizza le dimensioni dei batch per offrirti il meglio in termini di prestazioni, produttività e costi. Per i dati strutturati, Feature and Function Serving fornisce con tempi di risposta nell'ordine dei millisecondi query su quei dati contestuali, ad esempio dati dell'utente o dell'account, che le aziende spesso vogliono inserire nei prompt per personalizzarli in base alle informazioni dell'utente.