Hochwertige KI-Agent-Systeme entwickeln und implementieren

Verbinden Sie Ihre Daten sicher mit beliebigen KI-Modellen, um zielgenau fachspezifische Anwendu

ERFOLGREICHE SPITZENTEAMS DANK MOSAIC AI

Die einzige Unified Platform für Agent-Systeme

Schluss jetzt mit generischen KI-Modellen. Databricks bietet alle Tools, die Ihnen den Aufbau von Agent-Systemen ermöglichen, um korrekte datengestützte Ergebnisse zu erhalten.44 % Steigerung bei der Genauigkeit

10 Mio. $ Produktivitätssteigerung

96 % Treffsicherheit bei den Antworten

Tools für umfassende KI-Agent-Systeme

Agent Bricks

Bauen Sie KI-Agents, die auf Ihren Unternehmensdaten basieren. Databricks Agent Bricks ermöglicht es Ihnen, Qualität und Kosten zu optimieren – mit synthetischen Daten, individueller Evaluierung und automatischem Tuning.

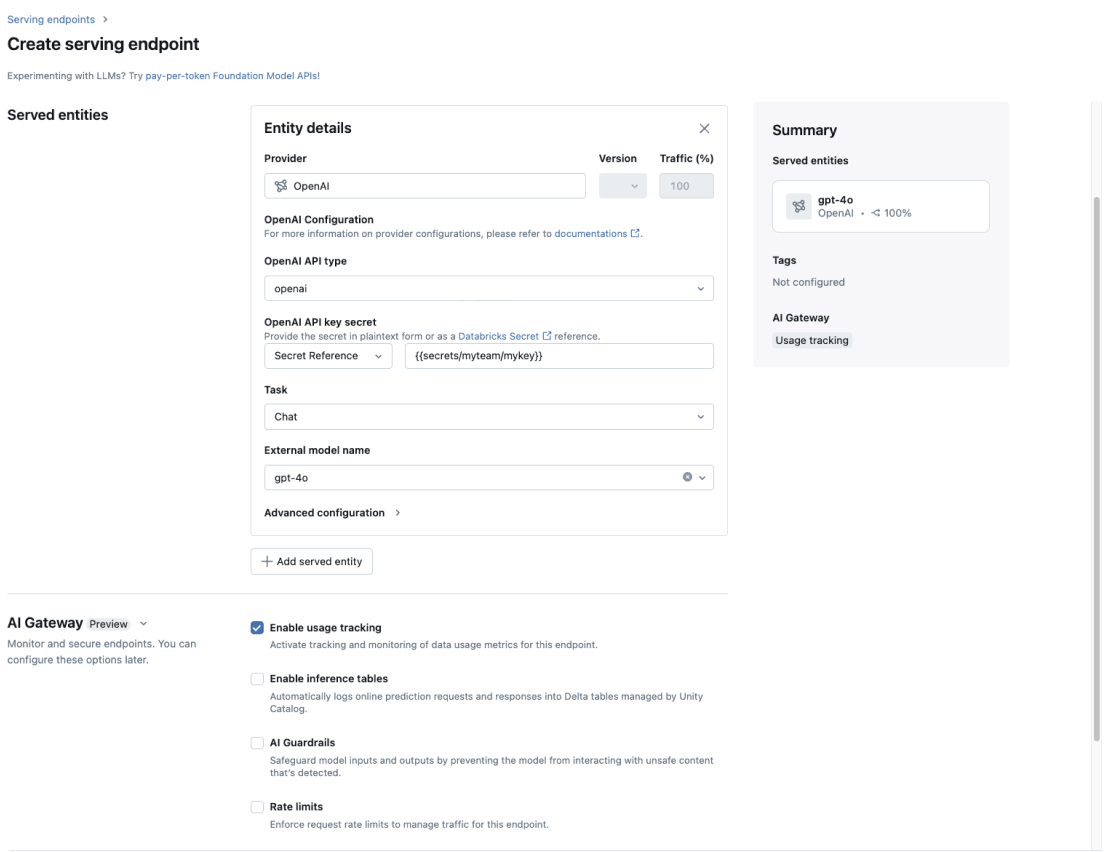

KI-Gateway

Wenden Sie die Daten-Governance konsequent auf jedes GenAI-Modell in Ihrem Unternehmen an.

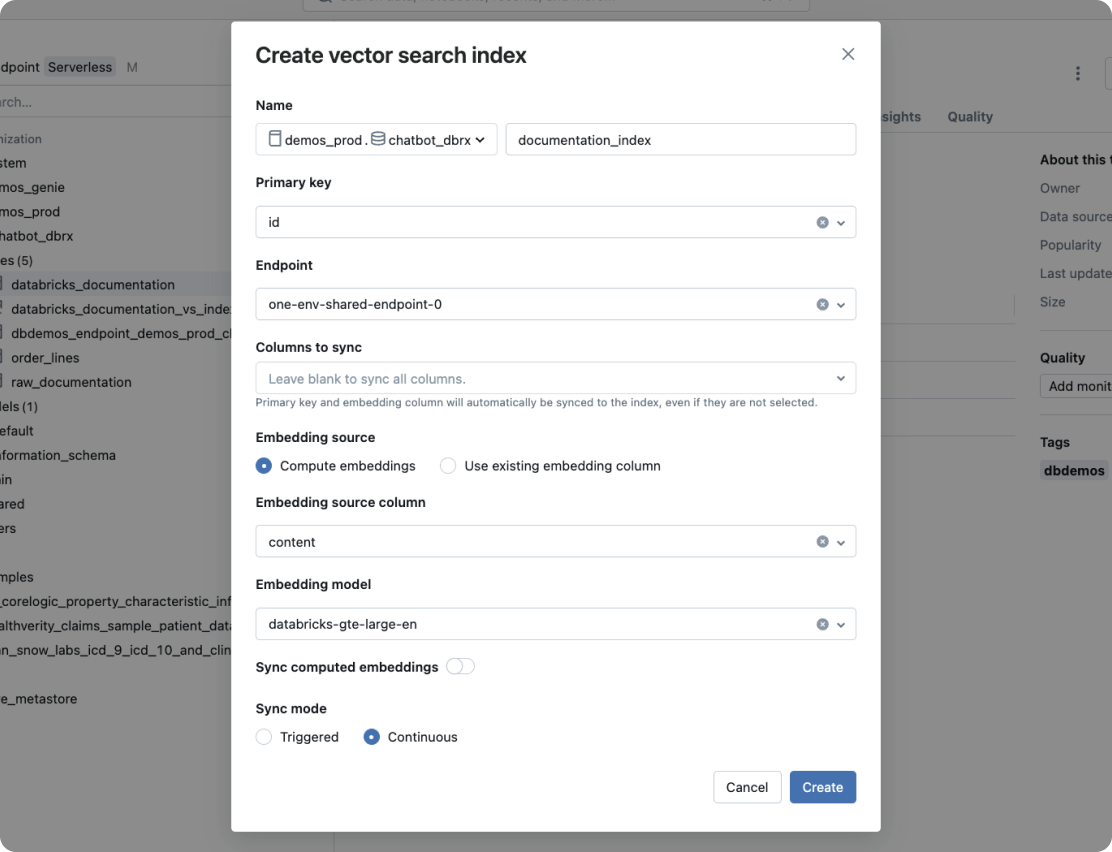

Vector Search

Leistungsstarke Vektordatenbank mit Echtzeitsynchronisierung der Quelldaten.

Agent Framework und Agent Evaluation

Entwickeln Sie mit Agent Framework KI-Agenten in Produktionsqualität. Als integraler Bestandteil des Frameworks stellt Agent Evaluation die Qualität der von Agents generierten Inhalte mittels KI-gestützter Evaluierungen sicher und bietet außerdem eine intuitive Benutzeroberfläche für Feedback durch reale Personen.

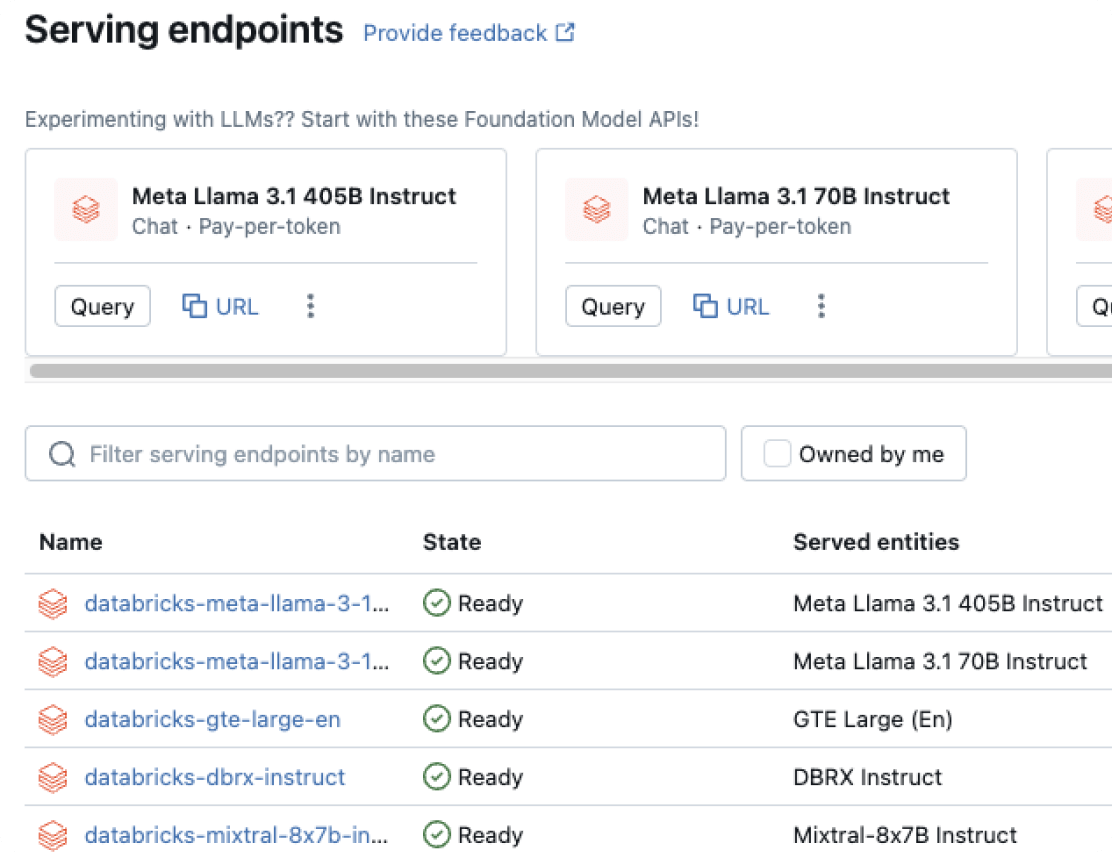

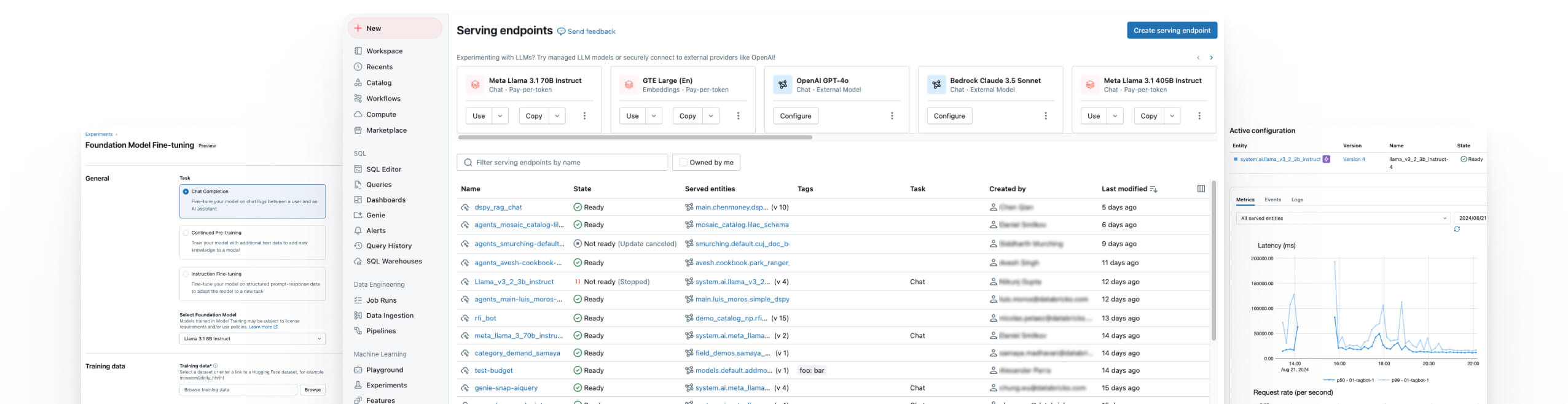

Modellbereitstellung

Einheitliche Implementierung für Agents, GenAI und klassische ML-Modelle.

Model Training

Optimierung von Open-Source-LLMs, Pretraining maßgeschneiderter LLMs und Erstellung klassischer ML-Modelle.

Databricks Notebooks

Steigern Sie die Teamproduktivität mit Databricks Collaborative Notebooks und ermöglichen Sie Echtzeit-Zusammenarbeit und optimierte Data-Science-Workflows.

Managed MLflow

Ergänzt MLflow, eine einheitliche MLOps-Open-Source-Plattform zum Erstellen besserer Modelle und GenAI-Apps, um Zuverlässigkeit, Sicherheit und Skalierbarkeit auf Unternehmensniveau.

Überwachung der Datenqualität

Einfaches, skalierbares Monitoring, das Anomalien erkennt, die Aktualität nachverfolgt und konsistente Qualitätssignale für alle Daten- und KI-Assets liefert.

Die Databricks Data Intelligence-Plattform

Entdecken Sie die gesamte Bandbreite der auf der Databricks Data Intelligence Platform verfügbaren Tools zur nahtlosen Integration von Daten und KI in Ihrem Unternehmen.

Hochwertige Agent-Systeme erstellen

Daten mühelos transformieren

Datenaufbereitung mit nahtloser Integration für GenAI- und ML-Workflows

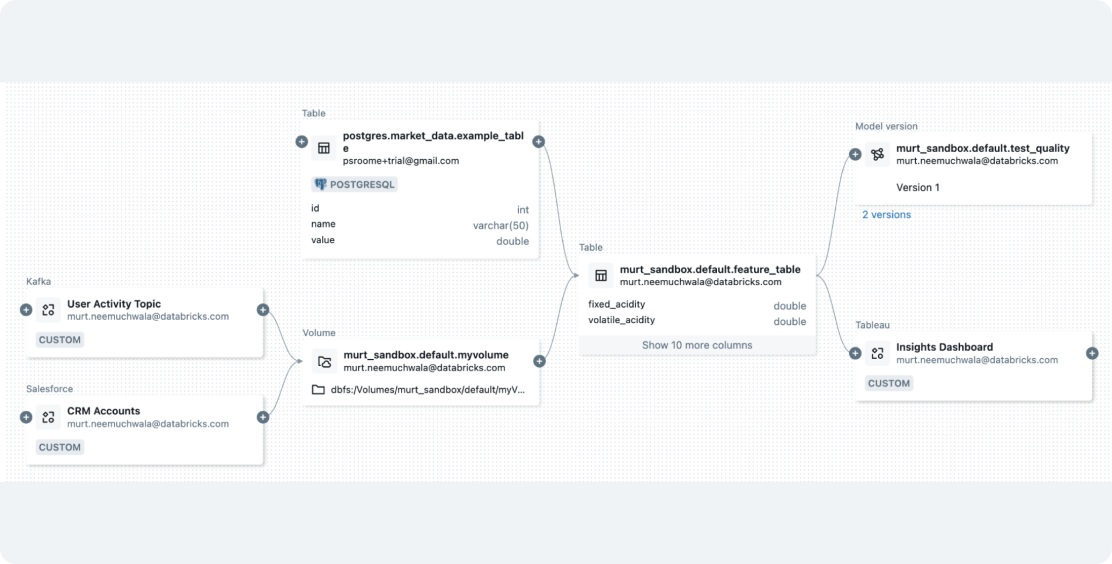

Mit Databricks können Sie beliebige Datentypen erfassen und Jobs orchestrieren, um sie für Ihre GenAI- oder ML-Anwendungen vorzubereiten. Dank integrierter Governance wird die Datenauswertung vereinfacht und es werden Vektorindizes für RAG mithilfe von Mosaic AI Vector Search erstellt. Dies trägt zur Vereinheitlichung von Daten- und Modellpipelines bei, um Workflows zu optimieren und Kosten zu senken.

Wagen Sie den nächsten Schritt

Kostenlose GenAI-Schulung

Vertiefen Sie Ihre GenAI-Kenntnisse mit diesem Kurs zum Selbststudium – und erwerben Sie ein branchenweit anerkanntes Abschlusszertifikat von Databricks.

Einstiegshandbuch

Dieses Tutorial zu KI-Agents begleitet Sie vom Proof-of-Concept (POC) bis hin zu einer hochwertigen, produktionsreifen Anwendung mit Mosaic AI.

Häufig gestellte Fragen zu Mosaic AI

Möchten Sie ein Daten- und KI-Unternehmen werden?

Machen Sie die ersten Schritte Ihrer Transformation